Hacia una Inteligencia Artificial Responsable

El pasado jueves 7 de febrero organizamos el primer encuentro meetup con las comunidades técnicas Data Science Spain & IoT Analytics Spain. Las comunidades surgen como punto de encuentro para perfiles técnicos interesados en hablar sobre materias como Big Data, Inteligencia Artificial, Deep Learning u otras disciplinas técnicas dónde queremos presentar proyectos o generar debates.

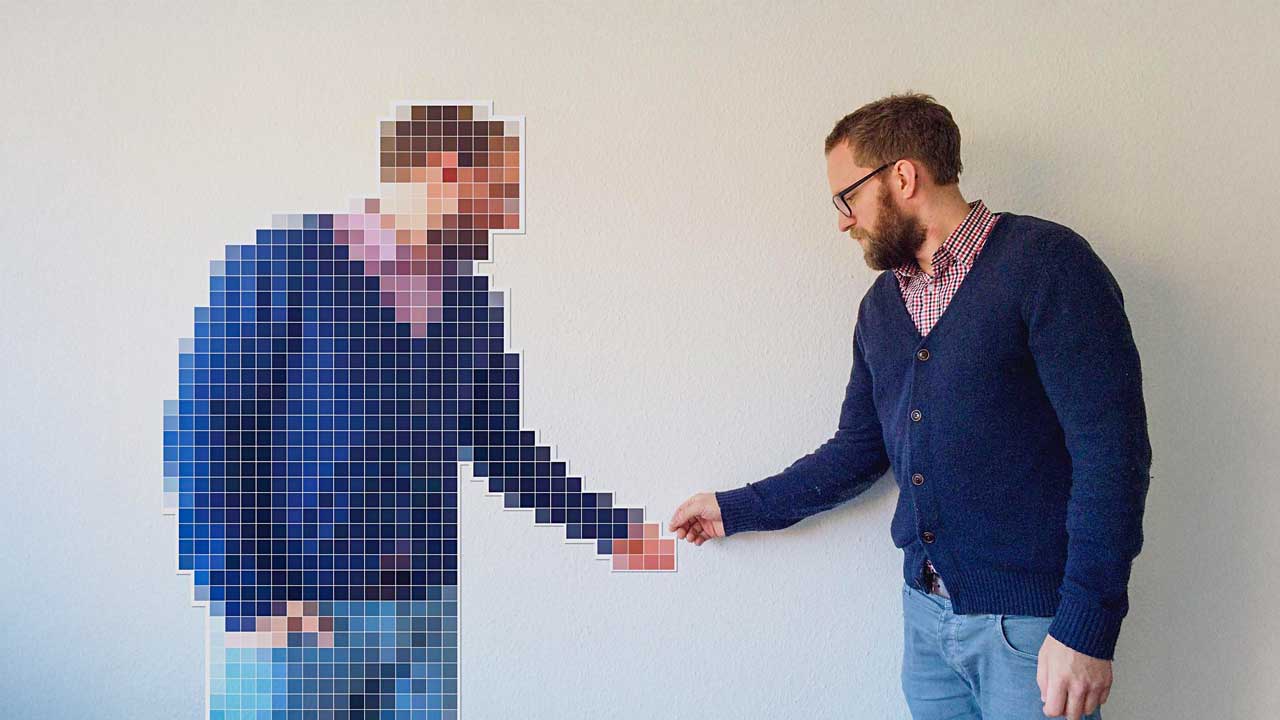

“Hacia una Inteligencia Artificial Responsable” fue la temática del primer encuentro del año que celebramos en las oficinas de nuestro partner KSchool, para debatir sobre cómo son de justos los algoritmos que empezamos a ver aplicados en herramientas que se valen de IA para tomar decisiones por nosotros. El encuentro comenzó con la bienvenida de Richard Benjamins que explicó como la IA está cada vez más presente en nuestra sociedad y cómo su crecimiento exponencial pone en duda consecuencias no deseadas de su aplicación.

Richard nos mostró varios ejemplos actuales de discriminación, como la creación de un algoritmo de reclutamiento de una empresa que discriminaba a las mujeres, o el sesgo racial que se había experimentado en la aplicación de reconocimiento de imágenes. Resaltó la actuación de grandes empresas y organizaciones gubernamentales que empiezan a regular este tipo de aplicaciones y presentó el LUCA Challenge organizado en noviembre, que premiaba herramientas que detectaran si un algoritmo estaba tomando decisiones sesgadas.

Tras su intervención, se procedió a la entrega de los premios de la primera edición de este concurso y se dio la oportunidad a los dos primeros ganadores de presentar su proyecto. El primero en hablar fue Guido García, representando al equipo ganador con el proyecto “Detección de sesgos en el algoritmo de búsqueda de Google y medición de sus efectos en la polarización política”. Guido nos demostró como a través de registrar nuestra actividad diaria y nuestras búsquedas de información, recibimos recomendaciones o publicidad sesgada que afecta a nuestro juicio y toma de decisiones, como puede ser un voto a favor de un partido político determinado.

El segundo proyecto “Análisis y mitigación de sesgos en el aprendizaje automático” fue presentado por Alexander Benítez y Antón Makarov en representación de su grupo de trabajo, que comenzaron explicando el concepto de ‘Fair Machine Learning’ Esta disciplina busca saber si las máquinas toman decisiones discriminatorias, para explicar como se detecta este problema. A través de un ejemplo real, señalaron cómo identificar el sesgo en el resultado de un análisis y explicaron los pasos a seguir a nivel técnico para mitigar este sesgo y así ayudar a diseñar algoritmos justos.

Depués de la presentación de ambos proyectos, concluimos el evento abriendo el debate a todo el público, dónde, en líneas generales, todos compartimos la preocupación por diseñar algoritmos justos y requerimos el apoyo de que organizaciones gubernamentales impulsen leyes como la reciente aplicación de la GDPR que vela por la protección de datos.

Si quieres participar en próximos encuentros o unirte a nuestro grupo meetup, apúntate a las comunidades Data Science Spain & IoT Analytics Spain.

Cloud Híbrida

Cloud Híbrida Ciberseguridad & NaaS

Ciberseguridad & NaaS AI & Data

AI & Data IoT y Conectividad

IoT y Conectividad Business Applications

Business Applications Intelligent Workplace

Intelligent Workplace Consultoría y Servicios Profesionales

Consultoría y Servicios Profesionales Pequeña y Mediana Empresa

Pequeña y Mediana Empresa Sanidad y Social

Sanidad y Social Industria

Industria Retail

Retail Turismo y Ocio

Turismo y Ocio Transporte y Logística

Transporte y Logística Energía y Utilities

Energía y Utilities