Juan Carlos Estévez

Ciberseguridad

En qué consiste el convenio de Budapest y cómo regula la ciberdelincuencia

La penetración de las redes informáticas trajo consigo los ciberataques que hoy, de acuerdo con el Informe de Riesgos Mundiales 2019, se encuentran entre las amenazas globales más graves del planeta, junto a los fenómenos meteorológicos extremos, el fracaso de la protección climática y los desastres naturales. De ahí que el concepto de ciberdelincuencia se convirtiera en una preocupación para los gobiernos de todo el mundo y se firmara el Convenio de Budapest sobre ciberdelincuencia para hacerle frente de forma eficaz. ¿En qué consiste específicamente el convenio de Budapest sobre ciberdelincuencia? De acuerdo con la definición oficial, el Convenio de Budapest (CETS No.185), sancionado el 23 de noviembre de 2001 por el Comité de Ministros del Consejo de Europa, es: “ El primer tratado internacional sobre delitos cometidos a través de Internet y otras redes informáticas, que se ocupa especialmente de las infracciones de los derechos de autor, el fraude informático, la pornografía infantil y las violaciones de la seguridad de la red. También contiene una serie de poderes y procedimientos, como la búsqueda de redes informáticas y la intercepción”. El objetivo principal de este instrumento, definido en el preámbulo, es establecer una política penal común y alineada entre países, orientada a la protección de la sociedad contra la ciberdelincuencia, Esto se alcanza tipificando los delitos informáticos de forma similar en todas las naciones, unificando normas procesales y a través de una cooperación internacional armónica. En la práctica, es el único instrumento internacional vinculante sobre este tema. Y pretende ser una guía para que los países desarrollen legislaciones nacionales integrales y alineadas contra el Cibercrimen. Además, facilita la adopción de medidas para detectar y perseguir, nacional e internacionalmente, a los ciberdelincuentes. Ejemplo de ello es la creación de una red 24/ 7 para garantizar una rápida cooperación internacional que reaccione frente a cualquier incidente y facilite la extradición de criminales cibernéticos (artículo 24). Esto es clave en la lucha global contra la ciberdelincuencia, dado el carácter transfronterizo que esta puede llegar a tener (por ejemplo, la víctima del cibercrimen se halla en España, pero fue engañada por un delincuente ubicado en USA a través de un portal hosteado en México). Cabe señalar que el tratado no define explícitamente el concepto de ciberdelincuencia, pero sí establece los tipos de cibercrimen que los países deben tipificar en sus legislaciones. Entre estos, son de gran importancia por su impacto y frecuencia, los delitos informáticos reseñados en el Titulo II: Falsificación informática: hace referencia a la introducción, alteración, borrado o supresión, deliberada y de forma ilegítima, de datos informáticos que dé lugar a datos no auténticos, “ con la intención de que sean tenidos en cuenta o utilizados a efectos legales como si se tratara de datos auténticos”. Fraude informático: son los actos deliberados e ilegítimos que causen perjuicio patrimonial a otro mediante la introducción, alteración, borrado o supresión de datos; o causándole interferencias en el funcionamiento de sus sistemas informáticos. El artículo 37 establece que los Estados no miembros del Consejo de Europa y que no hayan participado en la elaboración del tratado, pueden adherirse por invitación del Comité de Ministros del COE. A la fecha ya son más de 50 países a nivel global los que se han adherido al tratado, ¿Cómo rige en España? España firmó el tratado el 23 de noviembre de 2001 y lo ratificó mediante el instrumento de ratificación del convenio el 1 de octubre de 2010 en el que el país se compromete a observarlo y cumplirlo en todas sus partes. Sin embargo, las reformas al ordenamiento penal –derivadas de la ratificación- solo se hicieron realidad hasta el 24 de diciembre de 2010 cuando entró en vigencia la LO 5/2010 de 22 de junio. Esta reforma fue inspirada en la Decisión Marco 2005/222/J AI, sustituida por la Directiva 2013/40UE que, en cierta forma, impulsó la Reforma al Código Penal Español de 2015 que introdujo artículos importantes para la tipificación de los diferentes tipos de cibercrimen, como el artículo 197 bis que castiga el acceso no autorizado a sistemas informáticos, o el 197 ter que penaliza la producción, adquisición, importación o entrega a terceros de datos de acceso o software desarrollado o adaptado con el fin de cometer delitos. Ya en 2019, España aprobó la Estrategia Nacional de Ciberseguridad, la cual busca "garantizar el uso fiable y seguro del ciberespacio, protegiendo los derechos y libertades de los ciudadanos, y promoviendo el progreso económico". La lucha del Estado contra la ciberdelincuencia es frontal. Aun así, solo en 2018 se registraron 110.613 ciberdélitos que costaron millones de euros a las víctimas, según cifras del Observatorio Español de Delitos Informáticos.

6 de enero de 2020

AI & Data

Modelos predictivos: ¿cómo prevenir catástrofes naturales?

A nivel global, los desastres naturales (terremotos, huracanes, tsunamis, erupciones volcánicas, tornados e inundaciones) cuestan a la economía aproximadamente 520 mil millones de dólares, desplazan a millones de personas, empujan a muchos de ellos a la pobreza y cobran la vida de miles. Solo en 2018, ocurrieron 850 catástrofes y este año ya se han registrado centenares. Grave panorama, que a futuro podría ser mucho más calamitosos producto del cambio climático. Por fortuna, las tecnologías Big Data y los modelos predictivos han evolucionado significativamente y pueden ayudar a la prevención y gestión de desastres naturales. ¿Cómo podemos prevenir los desastres naturales con modelos predictivos? Antaño, la predicción de desastres naturales se basaba principalmente en análisis de regresión lineal empleando factores climáticos como la velocidad del viento, la intensidad de la lluvia, la presión central del huracán y la precipitación. Sin embargo, estos métodos no eran capaces de pronosticar con precisión la extensión de los daños. Ahora, con Big Data y los modelos predictivos del clima es posible alcanzar una mayor presión en las proyecciones de los eventos y así estar más preparados. Para empezar, cada desastre proporciona una enorme cantidad de datos. Esta puede ser recopilada, procesada y analizada para definir qué características (por ejemplo climáticas) pueden contribuir o qué eventos específicos suceden antes de un determinado desastre. Adicionalmente, es posible combinar ese análisis con los datos actuales captados por sensores e imágenes satelitales de áreas críticas, que permitan desarrollar modelos predictivos basados en algoritmos de última generación y que permitan tomar medidas de prevención y contingencia adecuadas. Así es cómo podemos prevenir los desastres naturales. Sabiendo, por ejemplo, que determinada zona se inundó y bajo qué condiciones, se obtienen puntos de referencia muy útiles para mapear áreas propensas a nuevas catástrofes, así como para planificar obras de prevención y el almacenamiento de recursos clave de rescate. Mediante Inteligencia Artificial y análisis de grandes volúmenes de datos, Google, por ejemplo, predice patrones de inundación en India y, en base a ello, aporta al desarrollo de respuestas más precisas y eficaces en caso de emergencia. Bee2FireDetection, apoyado en la inteligencia artificial de Watson de IBM, puede recopilar miles de datos meteorológicos y ambientales en terreno, como la humedad relativa, la dirección del viento o la temperatura y, comparándolos con data de incidentes anteriores, pronosticar de forma muy precisa la probabilidad de que ocurra un incendio. También son ejemplos de aplicación de Big Data y modelos predictivos del clima en predicción, prevención y gestión de desastres naturales, el modelo de computadora que simula la interacción del clima y los incendios, desarrollado por el Centro Nacional de Investigación Atmosférica (NCAS) en respuesta a la creciente prevalencia de incendios forestales graves. La importancia de la tecnología Big Data y la inteligencia artificial en este campo, radica en la posibilidad de clasificar grandes volúmenes de datos y encontrar de manera rápida correlaciones entre ellos. Tarea imposible de desarrollar por humanos o por los sistemas tradicionales de advertencia de desastres naturales. También se pueden trabajar en tiempo real los datos de los sobrevivientes En ese sentido queda claro cómo prevenir catástrofes naturales y hasta predecirlas. Pero como es bien sabido, muchas de ellas son inevitables, y lo único que queda por hacer cuando suceden es enfrentarlas de la manera más eficaz e inteligente posible. En ello la tecnología Big Data, al permitir el análisis de datos en tiempo real, también permite una excelente gestión de las emergencias. La información transferida desde aplicaciones de teléfonos móviles, relojes inteligentes, dispositivos médicos conectados y wearables puede ser captada y analizada para priorizar la respuesta y los rescates. Así, por ejemplo, durante un desastre es posible procesar toda la data de las llamadas de S.O.S para identificar a las personas que llaman y, en base a variables como edad y enfermedades que padecen, tomar decisiones sobre la urgencia de cada caso. El servicio de geolocalización de estos dispositivos también puede ayudar a los servicios de emergencia a ubicar las víctimas para el rescate, diciéndoles exactamente cuáles son las condiciones de acceso al terreno. Y más allá de eso, es muy útil para advertir a los ciudadanos de los peligros en zonas específicas, así como para informarles qué rutas tomar, puntos de encuentro, hospitales activos y demás información crítica durante una catástrofe natural. Tal vez falte mucho por aprender sobre cómo prevenir catástrofes naturales, pero los pasos dados hasta el momento son realmente significativos y esperanzadores. Es de esperar que, en un futuro no muy lejano, las consecuencias de estos eventos sean menos nefastas que ahora.

7 de diciembre de 2019

AI & Data

En qué consiste el Data Driven Learning (DDL)

Mucho se ha hablado de la transformación data driven en las compañías durante los últimos años, y no por nada: los datos son cada vez más necesarios en un mundo en el que la toma de decisiones, especialmente a gran escala, no puede basarse en conceptos difusos o imprecisos. En este escenario, el data driven learning se configura como un ejemplo tan interesante como peculiar y cuyo análisis puede enseñar mucho a las empresas acerca del poder de la comunicación. ¿Qué significa todo esto? Vamos por partes. ¿Qué es data driven? Data driven significa literalmente "guiado por datos" y actualmente la expresión se emplea para referirse a procesos y actividades cuyo progreso depende del análisis de datos más que de la experiencia personal o la intuición. Son muchas las compañías que han adoptado este tipo de estrategias en sus departamentos, sin embargo, esta transformación data driven en las organizaciones requiere de una hoja de ruta para una correcta implementación, siendo tres los pilares fundamentales: Tecnología, lo que implica más que todo conocer las herramientas tecnológicas disponibles en el mercado, tanto software como hardware, y que permitan hacer un uso óptimo de los datos. Es fundamental estar al día con estos conocimientos, ya que la tecnología está quedando obsoleta muy pronto. Talento, el cual hace alusión a profesionales capaces de extraer información a partir de datos usando las tecnologías necesarias. Para ello, es necesario concentrarse en distintas áreas de experiencia: análisis estadístico, procesamiento de datos, captura de información, inteligencia artificial, etc. Organización y cultura, pilar que se refiere a la necesidad de que la organización facilite a cada una de las áreas la extracción de datos. Para ello es esencial implementar una política a nivel organizacional de data literacy, esto es, alfabetización de datos (capacidad leer, interpretar y comentar los datos de una empresa). Este último concepto permite aproximarnos un poco más al data driven learning, pues se relaciona precisamente con el lenguaje. ¿Qué es data driven learning? El término data driven learning (DDL) fue acuñado por Tim Johns en la década de los ochenta y en principio consiste en una especie de método o acercamiento para aprender idiomas extranjeros. Para poder emplear el DDL se necesitan dos elementos fundamentales: Un corpus lingüístico, que en el argot contemporáneo se entiende como un conjunto lo suficientemente amplio y estructurado que contiene ejemplos reales de cómo se utiliza una determinada lengua. Este corpus es, en simple, una base de datos con texto. Una interfaz de búsqueda o software a partir del cual se pueden recopilar los datos del corpus lingüístico y desde el que el lingüista o investigador puede analizarlos. Algunos términos fundamentales que pueden ayudar a entender mejor las implicancias del data driven learning son la ingeniería lingüística (fundamental en el procesamiento del lenguaje natural, el cual estudia la interacción entre el lenguaje humano y las computadoras) y la lingüística de corpus, disciplina que estudia los lenguajes desde textos reales que hoy se obtienen en su mayoría mediante procesos automatizados. Big data y DDL El big data se vuelve esencial a la hora de implementar el análisis del data driven learning, ya que contar con una mayor cantidad de datos es indispensable para que la muestra tienda a ser más representativa. En términos simples: a más data, mayor probabilidad de encontrar correlaciones. Es fascinante cómo el aprendizaje de lenguas a partir de big data ha revolucionado la forma en que se entiende el lenguaje en la actualidad, al punto de que se han puesto en duda muchas de las teorías más tradicionales de este campo del conocimiento. En resumen, gracias al empleo de big data se han logrado métodos de investigación que han devenido en correlaciones en las lenguas de estudio que antes habían sido imposibles de prever, llegando incluso a proponerse nuevas "unidades de significado". Todo esto, gracias al uso de métodos de análisis cualitativos en patrones lingüísticos. Al parecer, hoy más que nunca adquiere sentido la evidencia neurológica que relaciona la lógica matemática con el lenguaje, ambas habilidades predominantes en el hemisferio izquierdo. Es mucho lo que se puede inferir del data driven learning y quizás son muchas las puertas potenciales que puede abrir al mundo digital y empresarial, especialmente en lo que se refiere a las nuevas formas de abordar la comunicación.

3 de diciembre de 2019

Conectividad e IoT

¿Qué es el Internet Industrial de las Cosas (IIoT)?

El Internet Industrial de las Cosas (IIoT), es una tecnología que podría convertirse en el mayor impulsor de productividad e innovación de los próximos años, impactando significativamente la economía global pues, según datos de Oxford Economics, abarca industrias que representan 62% del PIB entre los países del G20, como manufactura, minería, agricultura, petróleo y servicios públicos. Pero ¿qué es el Internet Industrial de las Cosas? A grandes rasgos, el Internet de las cosas en las empresas industriales hace referencia al uso de sensores y actuadores inteligentes en maquinarias y procesos industriales, con el fin de captar información relativa a su funcionamiento y transmitirla mediante la web para la respectiva gestión y supervisión de los flujos de trabajo. Al respecto, es importante conocer las capas de la tecnología IoT: Dispositivos (o sensores) encargados de registrar los datos, conectarse a una red y enviarlos. Dispositivos de puerta de enlace IoT, encargados de conectar los primeros sensores a la red. En definitiva, es el mecanismo que transmite los datos a la nube. Nube. Los datos recabados por las capas anteriores son enviados a servidores remotos en donde se almacenan y procesan. Analítica. En la última de las capas de la tecnología IoT es en donde los datos brutos se convierten en información procesable, gracia a la cual es posible sustentar la toma de decisiones e identificar patrones o tendencias que evidencien nuevas oportunidades o den pie a la innovación. Esencialmente, el Internet de las cosas en las empresas industriales sirve para impulsar las decisiones comerciales de manera más rápida. Pero tiene prestaciones mucho más específicas: 1. Visibilidad La tecnología IIoT permite a las empresas tener mayor visibilidad de todos sus procesos, pudiendo identificar fallas en cualquier etapa de los flujos productivos. Así, es posible actuar de manera oportuna y realizar los ajustes pertinentes en cualquier etapa de la cadena de producción. 2. Mayor productividad del personal Usando herramientas habilitadas para IIoT, los operadores pueden ejecutar los flujos de trabajo más rápido sin comprometer la calidad del producto final. 3. Ciclos de mejora más rápidos Con esta tecnología, el personal encargado de determinadas áreas (procesos, de fabricación, de calidad, etc.) tienen la posibilidad de automatizar la recopilación de datos, obteniendo así mayor tiempo para el análisis y la búsqueda de soluciones orientadas a mejorar los procesos. 4. Mantenciones preventivas Una de las grandes ventajas de la adopción del Internet industrial de las cosas es que permite anticipar eventualidades como fallas de sistemas o de los equipos de producción. Al contar con sensores inteligentes que transmiten datos, es posible realizar cambios de piezas o mantenciones antes de que una falla impacte a toda la cadena de producción. 5. Incremento de la calidad Los sensores pueden lanzar alertas cuando se desestabilizan factores críticos de calidad en las líneas de producción. Por ejemplo, en la producción de alimentos, la temperatura y la humedad son determinantes en el resultado final y, al contar con sensores IoT, es posible advertir a tiempo cambios en dichas variables. 6. Optimización de la cadena de suministro A través de etiquetas RFID y otros sensores es posible rastrear el inventario mientras se mueve por la cadena de suministro, permitiendo identificar con mayor precisión interdependencias, mapear el flujo de material y rastrear los tiempos del ciclo de fabricación. Además, esto también sirve para conocer el estado de los productos y evitar pérdidas por daño o mermas no previstas. Conocer algunas de las prestaciones que brinda el IoT el campo industrial evidencia la necesidad de implementarlo como herramienta estratégica para mejorar el negocio. Cifras de Oracle señalan que 96% de las organizaciones están listas para adoptar sistemas de IoT, pero 56,3% de los empresarios consultados aún no conoce bien las aplicaciones de esta tecnología. En ese sentido, las organizaciones que den el primer paso en la materia obtendrán bastante ventaja sobre la competencia. Al respecto, AWS IoT se alza como una solución de carácter estratégico. Pero ¿qué es AWS IoT? Acrónimo de Amazon Web Services, se trata de un conjunto de servicios que optimizan la implementación de soluciones IoT, en este caso, aplicadas al sector industrial. El servicio de Amazon ayuda a las empresas a mejorar el rendimiento y productividad de sus procesos al facilitar la captación, almacenamiento y análisis de datos de diversos equipos y procesos industriales. Además, permite escalar las aplicaciones de IoT a millones de dispositivos, ajustándose a las necesidades de cada organización. Ahora que sabes qué es AWS IoT y cómo puede ayudar el Internet de las cosas en las empresas, es momento de analizar de qué forma puedes implementar esta tecnología en tu negocio.

29 de noviembre de 2019

AI & Data

Así se aplica la inteligencia artificial en la medicina

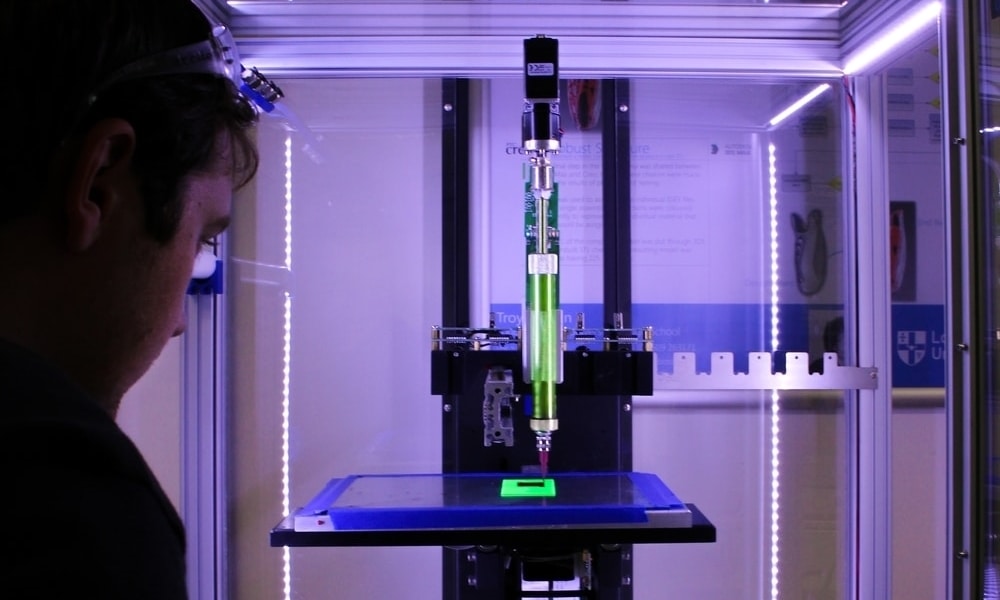

La emulación en tres dimensiones lleva varios años entregado soluciones a la humanidad. En efecto, los primeros prototipos de impresoras 3D, aunque muy básicas, datan de la década de los ochenta y construían modelos capa por capa, de forma muy similar a como funcionan en la actualidad. En el campo de la medicina, el gran salto se dio en la primera década de los 2000, en donde científicos de distintas organizaciones fueron capaces de lograr hitos como la impresión de un riñón funcional en miniatura, de piernas prostéticas complejas e incluso de vasos sanguíneos a partir de células humanas. Sin embargo, los últimos años el protagonismo del 3D en medicina se ha centrado en la inteligencia artificial, cuyas aplicaciones han permitido interpretar imágenes microscópicas entendidas como 2D en la forma de complejos modelos 3D, casi idénticos a la realidad. ¿Cómo es esto posible? ¿En qué consiste inteligencia artificial? Aunque en principio se dice que nació con las primeras computadoras creadas por el inglés Alan Turing, las primeras aplicaciones de la inteligencia artificial como una disciplina consagrada vieron la luz en los noventa, hito marcado por la victoria del Deep Blue de IBM sobre el entonces campeón del mundo de ajedrez, Gari Kaspárov. En esencia, la inteligencia artificial es la habilidad de las máquinas para aprender a partir de la experiencia, adaptarse a nuevas entradas de información y, en consecuencia, resolver problemas tal como lo haría un ser humano. Con el tiempo, se fueron incorporando distintas disciplinas dentro de la inteligencia artificial, emergiendo algunos conceptos claves tales como clustering (agrupamiento), machine learning (aprendizaje automático) y deep learning (aprendizaje profundo). Este último término es fundamental para entender las aplicaciones de la inteligencia artificial en medicina. Inteligencia artificial en la medicina: aprendizaje profundo El aprendizaje profundo, también conocido como redes neuronales profundas, es una rama de la inteligencia artificial cuyo propósito es el de encontrar maneras de emular la obtención del aprendizaje humano en ciertas áreas del conocimiento. El día 4 de noviembre de 2019, la revista Nature Methods publicó un artículo en el que un grupo de científicos demostraba haber corregido errores y aberraciones en imágenes médicas haciendo uso del deep learning, mostrando una imagen 3D "arreglada" cuando las muestras eran difíciles de leer. En concreto, el sistema que implementaron, al cual llamaron Deep-Z y que emplea inteligencia artificial, tomó imágenes 2D a partir de lo que captaba un microscopio y fue capaz de convertirlas en modelos 3D como si hubiesen sido obtenidos a partir de microscopios de última tecnología. Aydogan Ozcan, profesor de ingeniería eléctrica y computacional de la UCLA, además de director asociado del California NanoSystems Institute en la misma universidad, señaló que " este es un poderoso nuevo método potenciado por el aprendizaje profundo capaz de realizar imágenes 3D de especímenes en vivo, con un mínimo de exposición de luz, la cual puede ser tóxica para las imágenes". Yichen Wu, coautor de la publicación, agregó que " con esta técnica, puedes ver a través de curvaturas y otras topologías complejas que resultan muy difíciles de observar a través de imágenes simples". Este método promete tremendas aplicaciones en el futuro, pues ofrece a médicos, biólogos e investigadores una nueva herramienta que entrega modelos 3D que son más simples, rápidos y muchos menos costosos de obtener que las técnicas que se utilizan actualmente para corregir aberraciones en muestras médicas 2D, tanto impresas como las obtenidas en vivo con microscopios. ¿Medicina, inteligencia artificial e impresiones 3D? En resumen, las impresoras 3D logran construir objetos físicos en tres dimensiones a partir de modelos 3D computacionales, tales como los que se ven en la mayoría de las películas animadas modernas. Por eso, no dejó de sorprender cuando la compañía DeepMind, hoy perteneciente al grupo Google, fue capaz de renderizar objetos y escenarios 3D a partir de imágenes 2D, todo esto gracias a un algoritmo al que llamaron GQN o Generative Query Network (Red de Consulta Generativa en español). En resumen, los computadores fueron capaces de "imaginar" escenas completas desde cualquier ángul o sin ayuda humana, tomando como base una simple fotografía en 2D que mostraba los elementos más importantes del entorno. Por ejemplo, es como si hubiesen podido reconstruir toda una habitación en 3D solo mirando una fotografía tomada desde la puerta de entrada. Quizás en un futuro no muy lejano, métodos similares al Deep-Z o al GQN puedan emplearse para lograr aplicar la inteligencia artificial en la medicina de formas impensadas, imprimiendo tejidos humanos en tiempo real a partir de interpretaciones microscópicas o de muestras médicas incompletas o defectuosas, pudiendo salvar la vida de pacientes que requieran atenciones urgentes. Es mucho lo que se puede especular, pero algo está claro: también es mucho lo que queda por descubrir.

27 de noviembre de 2019

Descubre más sobre nosotros

-

🔒 En el #MW26 presentamos el ‘SOC del Futuro’, una evolución del modelo operativo de Ciberseguridad que integra IA, automatización avanzada y la experiencia de nuestros analistas para responder a un entorno cada vez más complejo.

4 DE MARZO, 2026

-

👣 ¡El #MWC26 también se mide en movimientos! Con #SmartSteps analizamos millones de datos anonimizados para entender cómo ha cambiado la movilidad en Barcelona antes y durante el congreso.

5 DE MARZO, 2026

-

💻 En #MWC26 mostramos nuestra propuesta para la transición a la criptografía poscuántica en el marco de #QuantumTelco. Con el Quantum-Safe Cryptographic Hub ayudamos a empresas y AAPP a avanzar hacia entornos preparados para la era cuántica. 🔐

3 DE MARZO, 2026

Cloud Híbrida

Cloud Híbrida Ciberseguridad & NaaS

Ciberseguridad & NaaS AI & Data

AI & Data IoT y Conectividad

IoT y Conectividad Business Applications

Business Applications Intelligent Workplace

Intelligent Workplace Consultoría y Servicios Profesionales

Consultoría y Servicios Profesionales Pequeña y Mediana Empresa

Pequeña y Mediana Empresa Sanidad y Social

Sanidad y Social Industria

Industria Retail

Retail Turismo y Ocio

Turismo y Ocio Transporte y Logística

Transporte y Logística Energía y Utilities

Energía y Utilities Banca y Finanzas

Banca y Finanzas Ciudades Inteligentes

Ciudades Inteligentes Sector Público

Sector Público