El futuro de la computación cuántica y la Inteligencia Artificial, explicado de manera sencilla

La computación cuántica se encuentra en un momento particular. Con la Inteligencia Artificial como uno de los campos más prometedores en la próxima década y compañías como IBM lanzando ya los primeros modelos comerciales basados en la nube, es interesante entender y explicar el futuro de la computación cuántica, así como sus poderosas implicaciones.

En el marco de EnlightED, la segunda edición del evento de educación digital que tuvo lugar en Madrid, el director de investigación en IBM Darío Gil desgranó cómo es el camino que hemos seguido hasta llegar al estado actual de la computación cuántica y, más importante, cómo es el futuro que le aguarda. Su ponencia profundizó también en cómo la computación cuántica se relaciona con la computación digital tradicional y con disciplinas como la física, las matemáticas y la biología.

Una visión holística que demuestra que nos encontramos, más que nunca, en una época fascinante para la computación. Una que recuerda a la segunda mitad del siglo XX, cuando aparecieron los primeros computadores, y fruto de esa revolución nacieron compañías como Intel, Apple, Microsoft o la propia IBM.

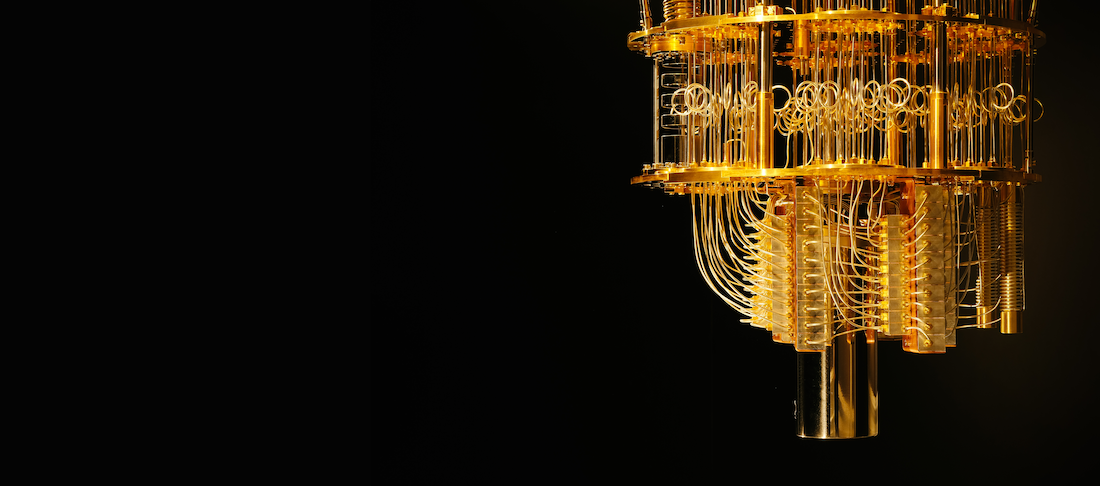

Cómo funciona un computador cuántico

Antes de proceder, es interesante entender cómo funciona un computador cuántico. Todos sabemos que la computación actual se basa en unos y ceros. Si lo equiparamos a una moneda, cada bit (1 o 0) implica que la moneda es cara o cruz. Con la computación cuántica, sin embargo, debido a las propiedades de superposición cuántica de la materia, los qubits (quantum bits) pueden ser 1 y un 0, a la vez. Si seguimos la analogía de la moneda, implicaría que pueden ser cara y cruz simultáneamente.

Partiendo de esa base, se utilizan microondas para modificar ligeramente ese estado de superposición y usarlo, en el sentido amplio de la palabra, para diversas tareas. Debido que a que un qubit puede ser un 1 y un 0 al mismo tiempo, este contiene mucha más información que un bit. Por su naturaleza, además, para una misma operación los qubits soportan simultáneamente un número de resultados posibles increíblemente amplio. En computación cuántica, es frecuente tener que repetir una operación varias veces para asegurarse de que se ha realizado correctamente.

Debido a las propiedades de superposición cuántica de la materia, los qubits (quantum bits) pueden ser 1 y un 0, a la vez.

Por si fuera poco, existe lo que se determina como entrelazamiento cuántico. Aplicar esos pulsos de microondas entre pares de qubits puede entrelazarlos de modo que existen en el mismo estado cuántico. Esto permite, multiplicando la complejidad del sistema de manera exponencial, manipular a la vez qubits entrelazados simplemente cambiando el estado de uno de ellos.

Para hacerse una idea de la complejidad absurda que puede adquirir un sistema cuántico, para representar con bits tradicionales un sistema cuántico de 100 qubits (los últimos modelos de IBM tienen ya 50) necesitaríamos en 1 y 0s el equivalente a todos los átomos del planeta Tierra. Para uno de 208 qubits, el número de átomos de todo el universo. Las implicaciones de esto, como se detalla a continuación, desafían por completo nuestro concepto actual de computación y redefinen los retos a los que se enfrente la humanidad.

El camino a la Inteligencia Artificial: Bits, Neuronas y Qubits

La charla de Darío Gil parte de una premisa muy interesante: para explicar el futuro de la computación cuántica divide su aproximación en tres: los bits (matemáticas), las neuronas (biología) y los qubits (física).

Bits

Los bits forman parte de la computación digital que todos conocemos. Representan la unidad esencial del mundo digital. Más allá de la teoría, sin embargo, la clave radica en la transición ¿cómo es el futuro? ¿es el futuro únicamente digital? Gil sostiene que, aunque indudablemente lo será en buena parte, la respuesta a esa pregunta va mucho más allá.

Para responderla es quizá ir necesario hasta los principios mismos de la informática, hasta Claude Shannon, pionero y fundador de la teoría de la información, que logró gracias a ella unir matemáticas e información. Para el futuro, sin embargo, vamos a vamos a tener que coger esa misma formación y darle un carácter biológico y un carácter físico, combinar ambos conceptos para dar el paso al siguiente nivel.

Neuronas

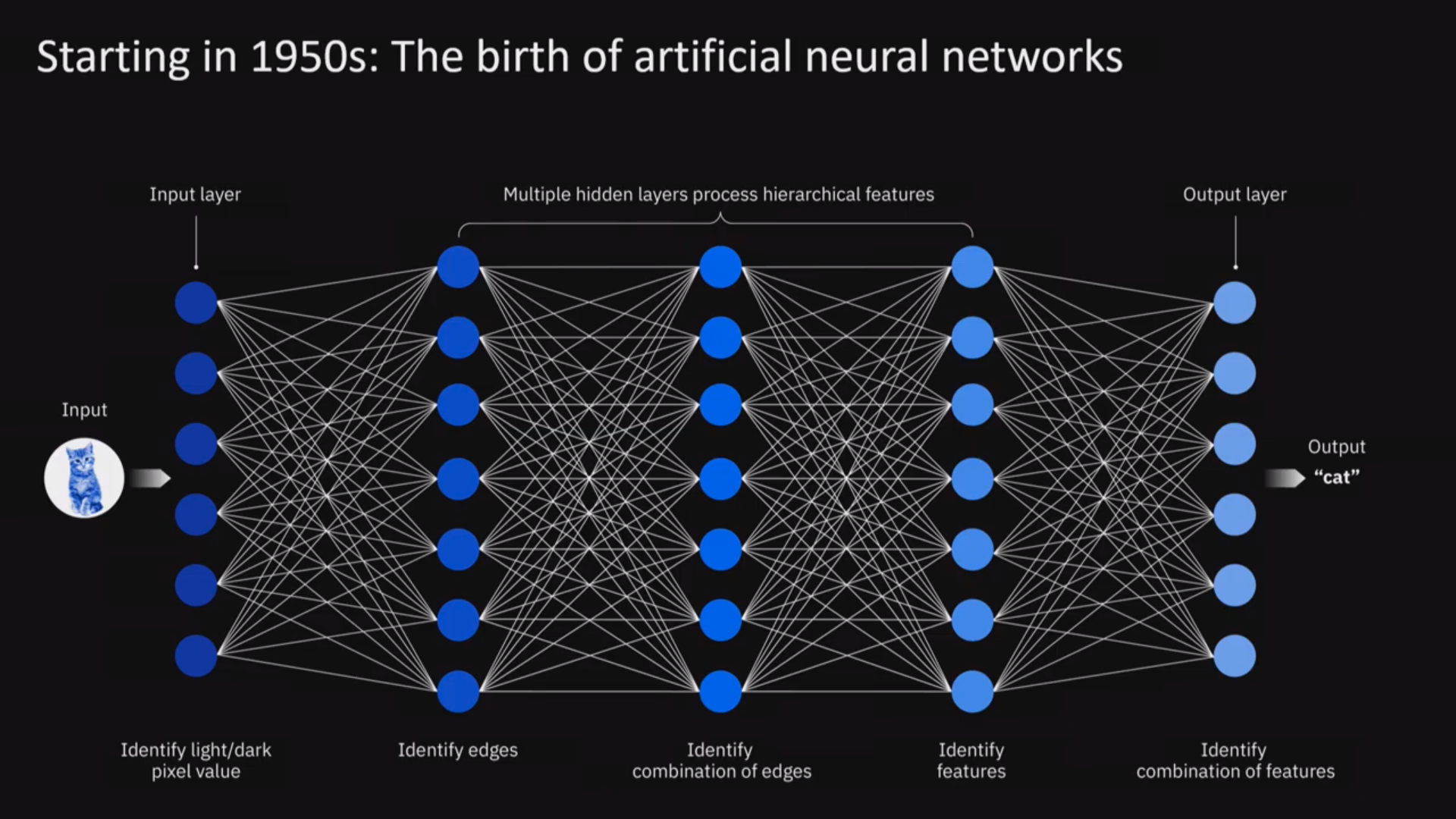

En los años 50 del siglo anterior, tras los avances en neurociencia y exploración anatómica, comenzaron las primeras redes neuronales (las mismas que tanta fama han adquirido recientemente), representadas de manera esquemática son algo parecido a esto:

Una red neuronal puede entenderse como una serie de puntos (que representan a las neuronas) conectados por varías líneas en una serie de capas. Cuando hablamos de "entrenar" una red neuronal, lo que medimos es la fuerza de la conexión entre las líneas que unen las neuronas.

Esto supone una aproximación diferente al modelo. Si yo quiero determinar si algo es o no un gato puedo intentar crear reglas que lo describan: mamífero, tiene pelo, patas, dos orejas. Eso genera un problema inmediato: si al gato le falta una oreja ¿deja de ser un gato? La cantidad de reglas y excepciones necesarias para definirlo a nivel computacional es tan grande que se hace inviable.

Una red neuronal en cambio toma una aproximación diferente, una red neuronal "aprende" entrenándola, aprende con el ejemplo. Así, ha sido posible generar inteligencias artificiales que detectan cáncer con mejor precisión que muchos oncólogos. El mecanismo para conseguirlo se basa en alimentarlas con multitud de imágenes (en este caso radiografías, ecografías y TACs) de multitud de muestras de cáncer tomadas a lo largo de los años. Con el tiempo, la inteligencia artificial es capaz de reconocer patrones específicos de cáncer a niveles sobrehumanos.

Este enfoque, sin embargo, no está exento de problemas. Hay un ejemplo famoso: en uno de los estudios que se están realizando para detectar cáncer utilizando Inteligencia Artificial, varios dermatólogos detectaron un alarmante número de falsos positivos para unas muestras concretas de pacientes sanos. Tras una investigación, se consiguió determinar el origen del problema.

En la oncología dermatológica, es frecuente acompañar las imágenes de tumores con una pequeña regla de medir al lado para que la fotografía proporcione una referencia precisa del tamaño del mismo. En la inmensa base de datos de imágenes que alimentaba dicha red neuronal, las reglas aparecían tanto en imágenes pertenecientes a tumores como en imágenes que no. Con el tiempo, y tras ser alimentada con múltiples imágenes, la red neuronal acabó por determinar que la presencia de una regla era indicativo de cáncer y devolvía falsos positivos para imágenes de pacientes sanos a las que únicamente se había añadido una como referencia. Dicho de otro modo: la red neuronal era tan inteligente como el sistema encargado de alimentarla, cualquier desvío o descuido en las variables podía dar resultados totalmente erróneos.

No es el único problema, para entrenar una red neuronal correctamente hacen falta cientos de miles de ejemplos, millones incluso, tantos que puede hacerse inviable. Para procesar todas esas imágenes, además, hace tanto poder de computación que pese a los primeros diseños en los años 50 no ha sido posible aplicarlas hasta hace relativamente poco.

Qubits, Neuronas y Deep Neural Networks

La Inteligencia Artificial, como término, parte de un interesante problema de base: disuade a mucha gente. Se percibe como amenazadora, intrusiva. Es también una designación increíblemente amplia: la inteligencia artifiical que encuentra rostros en una imagen y los reconoce es radicalmente diferente de la inteligencia artificial "distópica" y futurista que a menudo se plantea. Gil propone hablar de 3 términos, que además se correlacionan con cómo va a ir evolucionando en los próximos años:

- Inteligencia Artificial Estrecha: es la que está en la cresta de la ola ahora mismo, la responsable de que haya mejorado tanto el reconocimiento de lenguaje en muchos smartphones y altavoces inteligentes, por ejemplo. Es capaz de comprobar qué tiempo hace, jugar al ajedrez o escribir un texto simple a partir de datos en bruto. No es consciente, ni dirigida por emociones del modo en el que lo somos los humanos. Opera en un rango predeterminado y predefinido y coge su información de una base de datos específica. Como resultado, no pueden realizar tareas más allá de la que les ha sido designada, aunque sea muy compleja. Alexa, Siri, Google Assistant y casi cualquier ejemplo de Inteligencia Artificial "comercial" que se te ocurra entra hoy en día dentro de este campo.

- Inteligencia Artificial Amplia: el siguiente paso. Hace referencia a sistemas capaces de mostrar un comportamiento inteligente en un rango amplio de tareas, desde conducir un coche a decirte el tiempo. Lo percibiremos probablemente como la "evolución" de los sistemas de IA actuales. Va a poder expandir esas tareas para convertirse en multitarea y expandirse por varios dominios, con muchas señales diferentes (tiempo, idioma) en una combinación de aprendizaje, razonamiento y representación de conocimiento.

- Inteligencia Artificial General: es la tecnología futurista y revolucionaria que vemos en el cine de ciencia ficción. La misma que algunos dibujan en un futuro distópico y otros en un futuro completamente utópico. No va a llegar, como mínimo, hasta después de 2050.

Ahora mismo nos encontramos a medio camino entre la Inteligencia Artificial Estrecha y la Inteligencia Artificial Amplia.

Viendo entonces el universo de posibilidades que plantea la Inteligencia Artificial, se hace necesaria una pregunta: ¿dónde va a estar la Inteligencia Artificial? ¿Qué campos va a afectar? En su charla, Darío Gil da un criterio interesante. La IA es software y, como tal, va a estar en cualquier lugar donde haya software. Asumir que la Inteligencia Artificial es software ayuda también a desmitificarla y a hacerla menos intimidante. Cuando nos encontramos con un mal programa o una mala aplicación no le echamos la culpa al código, se la echamos al desarrollador o a la empresa desarrolladora. Ese paralelismo puede aplicarse con la Inteligencia Artificial, no es "mala" ni "buena", la clave está en cómo se aplique y en quién la aplique. El único enfoque correcto, amplía Gil es aquel que no es determinista, que no categoriza a la IA bien como utópica o bien como distópica.

Las implicaciones de un futuro cuántico

Dibujar un futuro en el que la computación cuántica es una realidad habitual es complejo, pero algunas de sus características intrínsecas, como los qubits, sí hacen posible determinar una serie de cambios importantes.

El primero es el tipo de problemas que pueden resolver. La computación actual digital puede resolver los que se conocen como "easy problems" (problemas fáciles), es decir, problemas en el que el número de variables no crece exponencialmente. El problema es que en la naturaleza hay muchos casos donde esto no ocurre: en la capacidad para simular la naturaleza, o la capacidad para "crear" teóricamente un nuevo elemento o un nuevo material (una nueva batería revolucionaria, por ejemplo).

Otro ejemplo interesante es la factorización: toda la encriptación moderna se apoya casi por completo en el hecho de que a los computadores actuales les es muy difícil factorizar números muy grandes. Los computadores cuánticos son la única tecnología que conocemos que alterará la ecuación entre lo que es posible y lo que no. Gil precisa: no es que los computadores cuánticos resolverán todos los problemas imposible, sino que es lo único que de momento es lo único que conocemos que puede cambiar ese paradigma.

El volumen cuántico es una forma de valorar la potencia de un computador cuántico. La potencia, en computación cuántica, no es solo que tenga más qubits, es que tenga menos errores. En lo que se equipara a una nueva Ley de Moore, el volumen cuántico se dobla cada año, si ese ritmo continúa las implicaciones van a ser increíbles. Gil concluyó su ponencia con cuatro claves:

- El futuro no es solo digital: La combinación de bits + neuronas + qubits revolucionará la computación, con implicaciones importantes para toda la humanidad.

- Las implicaciones de esa tecnología serán demasiado importantes como para dejarlas solo a los que hacen tecnología: Necesitamos aproximarnos a esta nueva realidad con un enfoque multidisplinar, no solo tecnológico, necesitamos humanismo.

- Nuevos políticos y nuevas políticas: que entiendan que el futuro de la inteligencia artifical no puede ser ni utópico ni distópico, que será necesario adoptar políticas no deterministas para regularlo.

- Poner a los humanos en el centro: necesitamos un movimiento tecnológico que ponga a los humanos en el centro, basado en sus derechos y beneficioso para todos.

Para terminar, una sentencia demoledora: "Los mejores programadores cuánticos probablemente no han nacido aún".

Imagen: Graham Carlow

Cloud Híbrida

Cloud Híbrida Ciberseguridad & NaaS

Ciberseguridad & NaaS AI & Data

AI & Data IoT y Conectividad

IoT y Conectividad Business Applications

Business Applications Intelligent Workplace

Intelligent Workplace Consultoría y Servicios Profesionales

Consultoría y Servicios Profesionales Pequeña y Mediana Empresa

Pequeña y Mediana Empresa Sanidad y Social

Sanidad y Social Industria

Industria Retail

Retail Turismo y Ocio

Turismo y Ocio Transporte y Logística

Transporte y Logística Energía y Utilities

Energía y Utilities Banca y Finanzas

Banca y Finanzas Ciudades Inteligentes

Ciudades Inteligentes Sector Público

Sector Público