Ciberseguridad

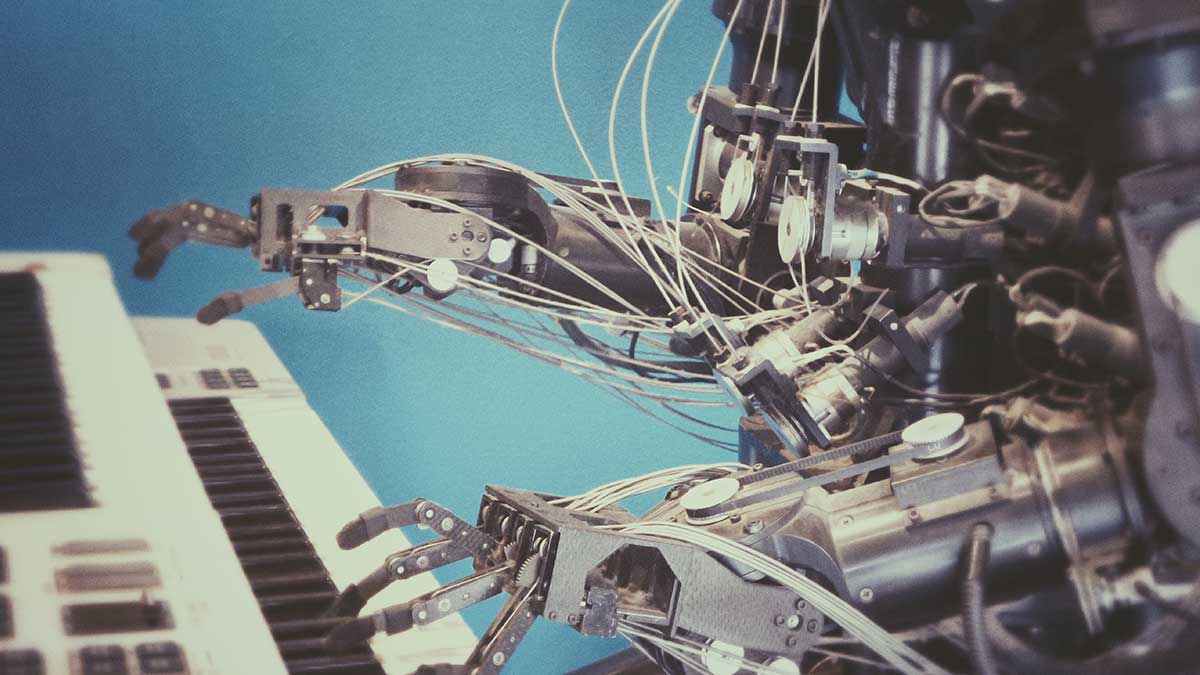

Criptografía, una herramienta para proteger los datos compartidos en la red

Actualmente, la Ciberseguridad representa un aspecto primordial en las empresas. No obstante, cada día surgen nuevos modos de atentar contra ella. Muchos se han preguntado: ¿de qué manera las empresas pueden almacenar de forma segura sus datos?, ¿cómo se resguarda la información de la tarjeta de crédito al realizar compras en línea? Pues la respuesta a estas interrogantes es la criptografía. La criptografía se hace vital, especialmente cuando existen tantos riesgos de seguridad informática, como el spyware o la ingeniería social. Es por ello que la gran mayoría de los sitios web la emplea para asegurar la privacidad de sus usuarios. De hecho, según proyecciones de Grand View Research (2019), se espera que del 2019 al 2025 el mercado global del software de cifrado tenga un crecimiento anual del 16,8 %. ¿Cómo se puede definir la criptografía? Este término se define como el arte de convertir datos a un formato que no se puede leer. En otras palabras, se cifran mensajes con información confidencial. Todo ello evita que personas inescrupulosas accedan a datos que puedan ser vulnerados. Dicha data cifrada se diseña mediante una clave que posibilita el acceso (Onwutalobi, 2011). Para cifrar un mensaje, el remitente debe manipular el contenido utilizando algún método sistemático, conocido como algoritmo. El mensaje original, llamado texto sin formato, puede codificarse de manera que sus letras se alineen en un orden ininteligible o cada letra puede reemplazarse por otra. Todo ello se conoce como texto cifrado. ¿Por qué deben emplearse sistemas criptográficos? 1. Pueden emplearse en diversos dispositivos tecnológicos Por ejemplo, tanto un IPhone como un Android pueden tener sus métodos de cifrado según las necesidades de las empresas. Asimismo, se puede cifrar contenido en una tarjeta SD o memoria USB. Existen variadas posibilidades, solo debe encontrarse el método más adecuado. 2. Se puede trabajar más seguro de forma remota En la actualidad, las organizaciones requieren con frecuencia trabajar de forma segura cuando sus empleados se comunican remotamente. Un Informe norteamericano de 2018 publicado por Shred-It reveló que los riesgos de vulnerabilidad son mayores al trabajar de esta manera. Por consiguiente, trabajar colaborativamente mediante el cifrado de datos evitará que la información caiga en manos equivocadas. 3. La criptografía protege la privacidad Resulta aterrador pensar lo expuestos que pueden estar los datos en las empresas. Según un artículo de Hern (2019) publicado en el diario The Guardian, en el 2018 más de 770 millones de emails y contraseñas fueron expuestos. Todo ello producto de vulnerabilidades en el acceso a datos individuales. Por lo tanto, el cifrado de datos puede evitar que los detalles confidenciales se publiquen sin saberlo en Internet. 4. Proporciona una ventaja competitiva Si las empresas respaldan sus diversas fuentes de información y datos mediante la criptografía, se les brindará mayor tranquilidad a los clientes. Las organizaciones son conscientes de lo esencial de este procedimiento. Un estudio del Instituto Ponemon (2019) reveló que el 45 % de los negocios tiene estrategias de criptografía. Menos del 42 % posee estrategias limitadas en el cifrado de datos para determinadas aplicaciones o tipos de datos. Ciberseguridad Ciberseguridad: eventos “cisne negro” en un mundo conectado 21 de marzo de 2023 Tipos de cifrado Las dos maneras más populares para aplicar la criptografía son: cifrado de clave secreta compartida y cifrado de clave pública, también conocidos como sistemas de cifrado simétrico y asimétrico, respectivamente (Vásquez, 2015). Cifrado de clave compartida También conocido como simétrico. Consiste en emplear la misma clave para cifrado y descifrado. Cualquier usuario que tenga dicha clave podrá recibir el mensaje. Este método es rápido y puede emplearse para un gran volumen de datos. Igualmente, es utilizado con el encadenamiento de bloques de cifrado que está sujeto a una clave y un vector de inicialización. Todo ello para formar un cifrado a partir de una serie de bloque de datos. El usuario que desea descifrar el mensaje tendrá que poseer la clave y el vector de inicialización. Frecuentemente, se usa con el cifrado de clave pública por su vulnerabilidad. Cifrado de clave pública Llamado también cifrado asimétrico, emplea dos claves diferentes que comparten un enlace matemático. En otras palabras, se emplea una clave para encriptar (clave privada) y otra para desencriptar (clave pública). La clave pública puede ser compartida entre los destinatarios. La otra clave es mantenida solo por el creador del mensaje. Su costo computacional es alto. Finalmente, la criptografía abre la oportunidad para que las empresas refuercen la seguridad de sus clientes. Esto consolidará su reputación y el mayor compromiso hacia innovaciones en torno a las más recientes tecnologías. Foto princiapl: Christian Lendl en Unsplash.

31 de mayo de 2023

.jpg)

Cloud

Qué es Edge Computing, explicado de manera sencilla

Edge Computing es una de las tecnologías que definirá y revolucionará la manera en la que humanos y dispositivos se conectan a internet. Afectará a industrias y sectores como la del coche conectado, los videojuegos, la Industria 4.0, la inteligencia artificial o el machine learning. Conseguirá que otras tecnologías como la nube o el internet de las cosas sean aún mejores de lo que son ahora. Como es probable que oigas el término a menudo en los próximos años, vamos a detallar qué es el Edge Computing, explicado en términos sencillos. Para entender bien qué es el Edge Computing es necesario comprender antes cómo funcionan algunas tecnologías como la nube (también conocida como cloud computing). ¿Qué es lo que ocurre cada vez que nuestro PC, nuestro smartphone o un dispositivo cualquiera se conecta a internet para almacenar o recuperar información de un centro de datos remoto? Qué es Cloud Computing La nube está tan presente en nuestras vidas que lo más probable es que la utilices sin darte cuenta. Cada vez que subes un archivo a un servicio como Dropbox, que consultas tu cuenta en la aplicación del banco, cada vez que accedes a tu correo o incluso cada vez que utilizas tu red social favorita estás haciendo uso de la nube. Simplificándolo mucho, podemos decir que utilizar la nube consiste en interaccionar con datos que se encuentran en un servidor remoto y al que accedemos gracias a internet. Cuando lo hacemos, el procedimiento es más o menos el siguiente: tu dispositivo se conecta a internet, ya sea a través de red fija o de red inalámbrica. Desde ahí, tu proveedor de internet, generalmente una operadora como Telefónica, se encarga de llevar los datos desde tu dispositivo hasta el servidor de destino, utilizando una dirección IP o una dirección web (por ejemplo dropbox.com o gmail.com), para identificar el sitio al que se debe enviar la información. El viaje de los datos hasta que se procesan en la nube El servidor en cuestión procesa tus datos (procesar es un término clave aquí, como vamos a ver), opera con la información y devuelve una respuesta. Por ejemplo: cuando te conectas a Gmail a través de tu dispositivo, pides al servidor de Google que te muestre el estado actual de tu bandeja de entrada, este procesa tu solicitud, consulta si tienes correo nuevo y te devuelve la respuesta que ves en tu pantalla. Como los datos están en la nube, da igual el dispositivo desde el que lo hagas. El viaje, de manera muy simplificada, que realizan los datos desde los dispositivos hasta los servidores en la nube. Esto es así para cada dispositivo que se conecta al servidor. Aunque parece simple, este “viaje” de la información es una maravilla de la tecnología que requiere toda una serie de protocolos y elementos dispuestos en el lugar correcto. Sin embargo, tiene también algunas desventajas. Pongamos por ejemplo que tú vives en España y el servidor de la nube en cuestión se encuentra en San Francisco. Cada vez que te conectas tus datos tienen que hacer el viaje de ida a través de la red de tu proveedor de acceso a Internet y de otros operadores esperar al procesamiento de datos en el procesador (o procesadores) del destino y luego hacer el camino de vuelta. Además de que no es habitual que los servidores estén tan lejos, para muchas de las cosas en las que utilizamos el cloud hoy en día esto es totalmente normal y válido, los tiempos son tan bajos (hablamos de milisegundos) que no nos damos ni cuenta. El problema llega en determinados casos de uso donde cada milisegundo que pasa es crucial y necesitamos que la latencia y el tiempo de respuesta del servidor, sea lo más bajo posible. Algunos de esos escenarios de uso frecuentes tienen que ver con el Internet de las Cosas. Por qué es importante el IoT El Internet de las Cosas, o IoT, es el sistema que conforman miles y miles de dispositivos, máquinas y objetos interconectados entre sí y a internet. Con tal cantidad, es lógico asumir que tanto el volumen de datos generado por cada uno de ellos como el número de conexiones a los servidores se dispare exponencialmente. Movistar Home Algunos de los objetos que hoy en día ya se conectan con asiduidad al internet de las cosas son por ejemplo bombillas, termostatos, sensores industriales en fábricas para controlar la producción, enchufes inteligentes, altavoces virtuales con asistentes de voz como Movistar Home, Alexa y Google Home o incluso coches como los de Tesla. La cuestión es que cada vez que uno de estos dispositivos se conecta a la nube realiza un viaje similar al que explicábamos arriba. Por el momento y en la mayoría de los casos eso es suficiente, pero en determinados casos ese viaje es demasiado largo para la rapidez e inmediatez que podríamos obtener si, simplemente, la nube estuviese más cerca. Dicho de otro modo: tenemos todavía mucho margen de mejora. Las posibilidades que pueden obtenerse si acercamos la nube a donde se generan los datos son simplemente incalculables. Ahí es, precisamente, donde entra en acción el Edge Computing. Las ventajas del Edge Computing La mejor definición para entender qué es el Edge Computing es la siguiente: consiste en acercar el poder de procesamiento lo más cerca posible de donde los datos están siendo generados. Es decir, consiste en acercar la nube hasta el usuario, hasta el borde mismo (edge, en inglés) de la red. Lo que importa cuando hablamos del borde de la red es que acercamos a los usuarios la capacidad de procesar y almacenar datos. Gracias a ello, con el Edge Computing podemos virtualizar las capacidades del servidor y habilitamos que el poder de procesamiento ocurra en esos dispositivos del borde. Eso permite mover capacidades que antes estaban "lejos", en un servidor en la nube, muchísimo más cerca de los dispositivos. Es un cambio de paradigma que lo cambia todo. Las funciones son similares, pero como el procesamiento sucede mucho más cerca, la velocidad se dispara, la latencia se reduce y las posibilidades se multiplican. Así, se puede disfrutar de lo mejor de dos mundos: la calidad, seguridad y reducida latencia de procesar en nuestro PC, junto con la flexibilidad, disponibilidad, escalabilidad y eficiencia que ofrece la nube. Edge Computing y las redes de nueva generación (5G y Fibra óptica) Ahí es donde entra en juego la segunda parte de la ecuación a la hora de entender qué es el Edge Computing: el 5G y la Fibra óptica. Entre sus muchas ventajas, el 5G y la Fibra ofrecen unas reducciones altísimas de latencia. La latencia es el tiempo en el que la información tarda en ir al servidor y volver a ti, la suma del tiempo que se emplea en viaje de ida y de vuelta que explicábamos antes. Actualmente, el 4G ofrece de media unas latencias de 50 milisegundos. Con el 5G y la Fibra esa cifra puede bajar hasta 1 milisegundo. Dicho de otro modo, no solo acercamos el servidor lo más cerca posible a donde hace falta, al borde, es que además reducimos incluso el tiempo que la información tarda en ir y volver del servidor. Para entender mejor las implicaciones tan importantes que esto tiene, vamos a plantear tres escenarios diferentes: un coche conectado, un algoritmo de machine learning en una fábrica y un sistema de videojuegos en la nube. Edge Computing y el coche conectado El coche conectado del futuro incluirá una serie de cámaras y sensores que capturarán información del entorno en tiempo real. Esa información puede ser empleada de maneras muy diversas. Podrá estar conectado a la red de tráfico de una ciudad inteligente, por ejemplo, para anticiparse a un semáforo en rojo. Podrá asimismo identificar vehículos o situaciones adversas en tiempo real o, incluso, saber en todo momento la posición relativa de los demás coches en torno a él. Este planteamiento transformará cómo nos desplazamos en coche y mejorará la seguridad de las carreteras, pero el camino hasta él no está exento de escollos. Uno de los más importantes es que toda esa información recogida por las diferentes cámaras y sensores acaba teniendo unas dimensiones considerables. Se calcula que un coche conectado generará unos 300 TB de datos por año (unos 25 GB a la hora). Esa información necesita procesarse, pero mover toda esa cantidad de datos rápidamente entre los servidores y el coche es inasumible, necesitamos que el procesamiento ocurra mucho más cerca de donde los datos están siendo generados, en el borde (edge) de la red. Un coche conectado recibiendo información de los sensores que tiene cerca. (Telefonica) A modo de ejemplo imaginemos una carretera del futuro por la que circulan 50 coches conectados y que además son completamente autónomos. Eso implica sensores que miden la velocidad de los coches del entorno, cámaras que identifican señales de tráfico u obstáculos en la calzada y toda una serie de datos adicionales. La velocidad a la que la comunicación debe producirse entre ellos y el servidor que controle esa información tiene que ser mínima. Es un escenario donde simplemente no podemos permitirnos que la información viaje hasta un servidor remoto en la nube, se procese, y vuelva. En lo que eso sucede puede haberse producido un accidente, un cambio brusco en las condiciones de circulación (un animal cruza la vía, por ejemplo) o cualquier otro tipo de imprevisto. Necesitamos que el procesador que opera con la información que producen los sensores de los coches esté lo más cerca posible de los mismos. Con el cloud, esta debería ir hasta la antena (el operador) de ahí viajar por internet hasta el servidor y luego volver, disparando la latencia. Con el Edge Computing, como parte de las capacidades del servidor están en el borde de la red, todo sucede ahí mismo. Edge Computing y Machine Learning Gracias a los modelos de aprendizaje automático que ofrece el Machine Learning, muchas fábricas e instalaciones industriales están implementando controles de calidad con Inteligencia y Visión Artificial. Esto, a menudo, consiste en una serie de máquinas y sensores que evalúan cada elemento que se produce en una cadena de montaje, por ejemplo, y determinan si está bien hecho o presenta algún defecto. Los algoritmos de Machine Learning a menudo funcionan "entrenando" a la inteligencia artificial con miles y miles de imágenes. Siguiendo con nuestro ejemplo, para cada imagen de un producto se le dice al algoritmo si pertenece a un elemento que ha sido fabricado correctamente o no. Mediante la repetición, y bases de datos gigantescas, la IA acaba aprendiendo cuáles son las características de los elementos que no presentan defectos y, si fallan en uno concreto, determina que no ha pasado el control de calidad. Una vez hemos generado el modelo, lo más habitual es que este se suba a un servidor en la nube al que los diferentes sensores de la cadena de montaje acuden para comprobar la información que recogen. Se repite el esquema que mencionábamos antes: los sensores recogen la información, desde ahí esta tiene que viajar al servidor, procesarse, cotejarse con el modelo de machine learning, obtener una respuesta y volver a la fábrica con el resultado. El Edge Computing mejora radicalmente ese proceso. En lugar de tener que acudir al servidor en la nube en cada caso, podemos generar una copia (virtualizada o reducida) del modelo de machine learning que se sitúa en el borde de la red. Es decir, prácticamente en el mismo sitio donde se están generando los datos. Así, los sensores no tienen que enviar la información a la nube lejana para cada elemento, sino que cotejan la información directamente con el modelo en el edge y, en caso de que este no concuerde porque el producto es defectuoso, entonces sí envían una petición al servidor. De esta manera, se mejoran las prestaciones, sin necesidad de aumentar la complejidad de los sensores, e incluso se permite simplificar los dispositivos, al poder usar las capacidades de procesamiento desplegadas en el borde de la red para alguna de sus funciones. Como es evidente, la velocidad de detección de fallos de fabricación se multiplica y se reduce muchísimo el tráfico y el ancho de banda necesario. Edge Computing y videojuegos Desde que la primera GameBoy de Nintendo arrasase allá por 1989, uno de los grandes retos de la industria del videojuego ha sido poder ofrecer maneras para jugar en cualquier parte. Se ha llegado lejos con compañías como Xbox, Google, Nvidia o PlayStation que ofrecen soluciones de videojuegos en la nube que permiten ejecutar juegos de última generación en cualquier pantalla. Stadia permite jugar videojuegos en cualquier parte gracias a la conectividad de fibra y al poder de la nube (Imagen: Google) ¿Cómo lo hacen? De nuevo, utilizando el poder de la nube. En lugar de procesar los gráficos del videojuego en el procesador de un PC o de una videoconsola, este se hace en grandes y potentísimos servidores en la nube que simplemente envían la imagen resultante por streaming hasta el dispositivo del usuario. Cada vez que este aprieta un botón (por ejemplo, para que Super Mario salte), la información de esa pulsación viaja hasta el servidor, se procesa, y vuelve. Hay un flujo continuo de imagen, como si fuese un streaming de vídeo como Netflix, hasta el usuario. A cambio, lo único que necesitas para jugar es una pantalla. Para que el jugador perciba que el proceso desde que aprieta el botón de saltar hasta que Super Mario salta en su pantalla sea instantáneo, los tiempos de latencia tienen que ser bajísimos. Si no, percibiría un incómodo retraso (también conocido como lag) que arruinaría toda la experiencia. Gracias al Edge Computing podemos acercar el poder de la nube (los servidores que procesan los gráficos de los videojuegos) hasta el borde mismo de la red, reduciendo enormemente el retardo (lag) que se produce cada vez que el usuario aprieta el botón y ofreciendo una experiencia prácticamente idéntica a la que se produciría si la consola estuviese al lado. Edge Computing: por qué ahora y por qué va a cambiar el futuro de la conectividad Aunque hemos explicado todo el proceso de manera muy simplificada, la realidad es que el Edge Computing requiere de una serie de tecnologías y protocolos de última generación para que funcione correctamente. Es posible que en algún momento te hayas preguntado por qué no se había hecho todo esto hasta ahora, es decir, por qué la nube no se diseñó desde un principio para estar lo más cerca posible de donde se generan los datos. La respuesta es que era imposible, para que el Edge Computing funcione correctamente necesitamos, entre otras cosas, una conectividad de última generación sustentada en fibra óptica y en 5G. Cuanto mejor sea el despliegue de red, mejor será el Edge Computing. Sin la velocidad ni latencia tan baja que ofrece la combinación de ambos, todos los esfuerzos en acercar el poder de la nube al borde a donde se procesan los datos, quedarían en vano. La red simplemente no estaría preparada. Gracias a sus extensos despliegues de fibra (en países como España hay más cobertura de fibra que en Alemania, Reino Unido, Francia e Italia juntas), compañías como Telefónica están especialmente preparadas para desplegar casos de uso sobre el Edge Computing. Edge Computing cambiará el mundo en los próximos años. Hará que los servicios en la nube de los que disfrutamos suban un nivel. Solo el tiempo y el potencial infinito de internet saben qué nuevas tecnologías y aplicaciones maravillosas nos aguardan tras él. Cloud Cloud Computing como factor clave para un futuro más sostenible 14 de diciembre de 2022 Foto principal: Alina Grubnyak

14 de abril de 2022

Ciberseguridad

Cómo configurar fácilmente una conexión VPN en Windows, Mac, iPhone y Android

Con el auge del teletrabajo, cada vez más empresas habilitan redes VPN para que sus empleados se conecten de manera remota con la mayor seguridad. Configurar una VPN en Windows, Mac, iPhone o Android es bastante simple. Solo hace falta tener los datos de acceso y seguir una serie de pasos. Qué es una VPN y cómo funciona VPN significa, en inglés, Virtual Private Network, y en esencia permite conectar a varios dispositivos en una red privada a través de internet. Dicho de otro modo, permite tener las bondades de una red local (la que genera el router wifi de cualquier casa) pero a través de internet y a miles de kilómetros de distancia si es necesario. Ventajas de una VPN Para las empresas, las redes VPN permiten conectarse a la red corporativa desde cualquier lugar y de manera segura. Son necesarios unos datos de acceso, usuario y contraseña, propios para cada empleado. Es habitual que las conexiones VPN vayan totalmente cifradas, aumentando el nivel de seguridad y manteniendo los datos confidenciales a salvo de cualquier intruso. De este modo, al configurar una VPN se facilita el acceso a recursos corporativos a los que, de otro modo, sería demasiado peligroso acceder desde fuera de la oficina. Cómo configurar una VPN La configuración de una VPN es generalmente bastante sencilla pero tiene algunas particularidades dependiendo del sistema operativo. Así se configura en Windows, Mac, iPhone y Android. Lo primero de todo: el equipo de IT y sistemas de tu empresa debe proporcionarte una serie de datos de acceso: el tipo de protocolo, la dirección del servidor, tu usuario y contraseña. Lo más habitual es que ya te hayan facilitado esa información, pero si no, antes de seguir asegúrate de tenerla a mano. Configurar una VPN en Windows Lo ideal es que te conectes utilizando la última versión del sistema, Windows 10: Accede a los ajustes del PC, puedes hacerlo fácilmente haciendo clic en el botón de inicio y luego en la tuerca de ajustes Ahí, abre Red e Internet Desde Red e Internet, selecciona VPN en la barra lateral. Clic Agregar una conexión VPN Utilizando los datos mencionados anteriormente, rellena la información de servidor, el tipo de VPN (o protocolo) y tus datos de usuario. Configurar una VPN en Mac Mac suele ser muy sencillo de utilizar y configurar una VPN no es una excepción. Acceder a las Preferencias del Sistema. Puedes hacerlo clicando la manzanita de la esquina superior izquierda. Desde ahí, abre "Red" Pulsa "Añadir (+)". Se abrirá un desplegable y selecciona "VPN". Rellena los datos y ajustes necesarios con la información proprcionada. Configurar una VPN en iPhone Ve a Ajustes. Desde ahí, a General. Selecciona VPN. Añadir configuración VPN. Elige el tipo de VPN (el protocolo) y rellena los datos proporcionados. Configurar una VPN en Android Por último, en Android es necesario prestar atención porque dependiento del fabricante la configuración puede variar. En general es como sigue: Dentro de Ajustes, ve a Redes inalámbricas y selecciona conexiones de Red (puede ser un término similar) Las redes VPN se encuentran en el apartado Otros (o término similar) Dentro de VPN podemos añadir (+) una nueva conexión. Una vez ahí ha de rellenarse el tipo de VPN, la dirección del servidor y los datos de acceso. Imagen principal: Micah Williams

12 de marzo de 2020

Ciberseguridad

5 medidas de seguridad muy simples para teletrabajar de manera segura

El teletrabajo ofrece un buen número de ventajas y oportunidades, pero hacerlo correctamente y con las mismas condiciones que en una oficina no es sencillo. Además de repasar algunos consejos para teletrabajar con éxito, es útil también recomendable conocer las medidas de ciberserguridad adecuadas para desempeñar tu trabajo lo más protegido posible. El primer paso, y fundamental, es estudiar y preguntar por la política o normativa de seguridad de tu empresa en lo respectivo al trabajo remoto. Los departamentos de IT y seguridad de muchas compañías tienen ya una serie de protocolos desarrollados para este tipo de situaciones. Ellos serán, probablemente, los que puedan aconsejar mejor para cada caso concreto así que antes de nada es muy aconsejable contactarlos y adoptar prácticas específicas. Dicho eso, y en paralelo, existen algunas medidas de seguridad de carácter general que conviene tener en cuenta. https://www.youtube.com/watch?v=Q3PgeZjBqUE&feature=youtu.be Todo comienza por la red wifi de tu casa En la oficina te conectas a internet a través de una red corporativa. Esta suele llevar incorporadas una serie de protecciones específicas de nivel empresarial para que todo el trabajo se desarrolle de la manera más segura posible. En casa, en cambio, esa red se sustituye por la red wifi doméstica que genera el router de tu operadora, así que hay algunos aspectos que conviene tener en cuenta: Que la contraseña sea WPA2: WPA2 es un estándar de seguridad para la contraseñas en redes wifi. La mayoría de routers modernos ya traen contraseñas WPA2, pero si es un poco más antiguo es posible que esta sea WPA o incluso WEP. Estas dos últimas tiene un problema de seguridad importante: hackearlas es un juego de niños, incluso para gente sin demasiados conocimientos técnicos. Muchas operadores, como Movistar con la app Mi Movistar (disponible para iOS y Android) permiten cambiar fácilmente la contraseña wifi desde el móvil. Si no estás seguro, además, de si tu contraseña sigue el protocolo WPA2, estas app suelen indicarlo. Cambia tu contraseña: incluso si es WPA2 no viene mal cambiar la contraseña de la red wifi de vez en cuando. El motivo es que con el tiempo acabamos dando permiso de acceso a muchos dispositivos, algunos de ellos no seguros, que luego olvidamos. Cambiarla puede ser una buena manera de empezar desde cero y otorgar acceso solo a los dispositivos esenciales. Hay varias herramientas en internet que permiten crear contraseñas wifi seguras. Si usas un VPN: siempre el de la empresa, nunca uno gratuito Explicándolo de manera simplificada, con una conexión VPN (red privada virtual, en español) se coloca un servidor intermedio para que se interponga entre tu dispositivo e internet. Todo el tráfico de tu dispositivo pasa por este servidor VPN que hace de "guardián" analizando los datos y protegiendo la conexión. Si tu empresa tiene un VPN: si no los tienes ya, contacta con tu equipo de IT y solicita los datos de conexión. Configurarlo es bastante sencillo en los principales sistemas operativos: Windows, Mac, iOS y Android. Si tu empresa no tiene VPN: en general, no es buena idea utilizar servicios VPN de terceros. Como hemos dicho, todo el tráfico de internet de tu dispositivo pasa por un servidor externo, así que no es recomendable que manejes información confidencial a través de uno. Si ya utilizas un VPN de pago, puedes consultar con los responsables de IT de tu empresa para ver si puedes usarlo, pero nunca, bajo ningún caso, te conectes a un VPN gratuito. Imagen: Philipp Katzenberger Cuidado con las cafeterías y espacios de coworking Las medidas expuestas hasta ahora aplican al que es el escenario ideal para teletrabajar en términos de seguridad: hacerlo desde tu propia casa. Si necesitas trabajar desde un espacio como una cafetería o un entorno de coworking, nunca te conectes a una red abierta gratuita, son el enemigo número 1 de la privacidad y la seguridad. Si tienes que hacerlo por motivos de fuerza mayor, es recomendable recurrir siempre al VPN de tu empresa. Otra posibilidad es utilizar tu smartphone para crear una red wifi y conectarte a ella. Es un buen momento para cambiar tus contraseñas y habilitar la doble autenticación Con una red wifi segura y un VPN nos aseguramos de que la red de conexión a internet sea lo más segura posible. Sin embargo, las medidas no acaban aquí. De nada sirve una conexión 100% protegida si tus contraseñas son débiles. Algunos consejos generales: Nunca utilices una misma contraseña dos veces: Esto aplica a internet en general, pero se hace especialmente válido en el caso del teletrabajo. Si algún hacker consigue una de tus contraseñas, lo mejor es que solo tenga acceso al servicio al que pertenece, en caso contrario con una sola contraseña podrá vulnerar el total de tus servicios. Utiliza un gestor de contraseñas: uno de los principales motivos por el que muchas personas utilizan una misma contraseña para todo es porque es un poco pesado recordarlas todas. Afortunadamente, existen gestores específicos para almacenarlas de manera segura. Si buscas uno gratuito y de código abierto, KeePass es una opción excelente. En el caso de los de pago, pocos superan a 1Password. Ambos están disponibles para Windows, Mac, iOS y Android. Utiliza la autenticación en dos pasos: la mayoría de servicios permiten utilizar ya la autenticación en dos pasos. Con ella, además de la contraseña es necesario un método adicional de verificación (normalmente, un SMS que se envía a tu móvil o un código generado por una app). Depende del servicio en el que habilites la autenticación en dos pasos, pero buenas apps que pueden ayudarte aquí son Microsoft Authenticator, Google Authenticator, Authy o Latch. Vigila tus dispositivos y cuidado con tu teléfono personal Algunas empresas proporcionan equipos a sus empleados. Si es el caso, al teletrabajar lo ideal es que lo hagas siempre desde el equipo proporcionado. Estos equipos suelen tener instalados entornos seguros y medidas de seguridad específicas de acuerdo al cumplimiento normativo en materia de seguridad de tu empresa. Si por el contrario tu compañía tiene una política de BYOD (Bring Your Own Device, Lleva tu propio equipo, en español) entonces lo que vas a necesitar es que este esté 100% actualizado con las últimas actualizaciones de software instaladas. Asegúrate de que tu licencia de Windows esté activa y, aunque el antivirus que ahora lleva el sistema por defecto (Windows Defender) es bastante bueno, quizá te interese comprar e instalar uno adicional, como BitDefender. Tu smartphone también puede suponer un problema. Algunas aplicaciones de Android se instalan en tu dispositivo y, sin que te des cuenta, adquieren permisos de administrador para acceder a todo el teléfono. Aunque a ese respecto hay muchas particularidades, en general eso quiere decir que un atacante podría acceder a los datos almacenados en el dispositivo. Cuando se trate de tu teléfono utiliza siempre las aplicaciones habilitadas por tu empresa, como Outlook para móviles, y nunca exportes datos o archivos a otras. Todo mejor en la nube, pero cuidado con la seguridad Es muy probable que tu empresa utilice algún tipo de servicio en la nube, como OneDrive, Dropbox o Google Drive. Aunque estas herramientas son muy útiles para compartir información fácilmente, sacar archivos de esos servicios puede no ser recomendable. Por ejemplo, nunca debería extraerse un archivo y almacenarlo en una memoria USB, por ejemplo, o enviarse utilizando un servicio de correo que no sea el de la compañía. Lo mejor es pensar en el servicio de almacenamiento en la nube corporativo como en un disco duro compartido con información confidencial, cuanto menos salga de ahí, mejor. Imagen principal: Anna Auza.

12 de marzo de 2020

Ciberseguridad

Aprende a protegerte de un ataque ransomware con estos 5 consejos

Los ataques de ransomware suelen ser perjudiciales y costosos para los negocios. La buena noticia es que las personas y las organizaciones en general ya son conscientes de la escala de los daños que pueden ocasionar estos ciberataques, por lo que han tomado medidas al respecto. De hecho, esta puede ser la razón por la que la tasa de éxito de este tipo de malware haya disminuido en un 30% entre abril de 2017 y marzo de 2018. Sin embargo, a pesar de la reducción de efectividad, la cantidad de ataques de ransomware están aumentando todos los años. ¿En qué consiste y cómo actúa el ransomware? El ransomware es un software malicioso que introduce el atacante en tu dispositivo. Una vez en él, el cibercriminal puede bloquearlo desde una ubicación remota y encriptar tus archivos para quitarte el control de todos los datos almacenados. Este virus se camufla dentro de un archivo de correo electrónico, en vídeos de algunos sitios web, en sistemas operativos, programas y aplicaciones móviles. Una vez dentro del dispositivo, el virus se activa y bloquea todo el sistema operativo. Al mismo tiempo, lanza un mensaje solicitando un rescate para recuperar la información. ¿Cuáles son los tipos de ransomware? Existen decenas de tipos de ataques de ransomware, pero ESET (2019) establece que los siguientes son los más comunes: Filecoder: cifra los archivos del equipo y pide un rescate en criptomonedas para dar acceso a los archivos. El virus Ryuk que atacó la Cadena Ser es un ejemplo de Filecoder. Según Rojas E. (2019), este virus bloqueo la red informática de la empresa y pidió un rescate de 1.5 millones de euros en Bitcoin. Lockscreen: en lugar de bloquear los archivos, Lockscreen bloquea todo el equipo. Wiper: es uno de los ataques más peligrosos ya que nunca devuelve el acceso a los archivos. Al contrario, los elimina, los corrompe o impide el acceso a la información. Hoax Raomsware: combina el secuestro con un engaño. En realidad, no cifra ningún archivo, sino que utiliza técnicas psicológicas para asustar a la víctima y provocar el pago del rescate. Un ejemplo de este tipo de ataque es el famoso “virus de la policía”. Panda Security (2018) explica que este virus envía un mensaje en la pantalla simulando ser la Policía Nacional. El atacante notifica a la víctima que, desde su equipo, se ha detectado algún tipo de actividad ilegal. Luego, exige el pago de un rescate por concepto de multa. 5 consejos para protegerse de un ataque ransomware No existe un grupo de reglas infalibles para evitar un ataque de ransomware. Sin embargo, los siguientes consejos te ayudarán a proteger tus equipos de este malware: 1. Actualiza el sistema operativo y las aplicaciones La mayoría de los proveedores, de las aplicaciones y sistemas operativos, incluyen parches de seguridad en sus actualizaciones. Si ignoras las actualizaciones, estarás poniendo en riesgo tu equipo. 2. Capacita a tu personal sobre el peligro de un ataque ransomware Un estudio de Verizon (2019) revela que la tasa de clic en simulaciones de phishing cayó de un 24% al 3% en los últimos siete años. Desafortunadamente, el cibercriminal solo necesitará que uno de los usuarios descargue el archivo para infectar a toda la red. Por esta razón, es vital que tu empresa cuente con un programa de capacitación en ciberseguridad. 3. ¿Cómo evitar pagar el rescate en un ataque ransomware? Realiza una copia de seguridad Hacer una copia de seguridad o back up puede evitarte pagar un rescate. Puedes hacer copias de seguridad periódicas en un disco duro o en una unidad NSA. También puedes aprovechar las ventajas de un servicio de almacenamiento en la nube como Azure de Microsoft o el Amazon Web Service. 4. Implementa un software de seguridad Un software de seguridad o firewall te ayuda a rastrear, bloquear y tratar el ransomware y otras formas de malware. Sin embargo, Drolet (2019) dice que este software también debe configurarse correctamente y mantenerse actualizado. 5. ¿Cómo evitar un ataque de ransomware? Mantente alerta ante las técnicas de manipulación social Si recibes un correo electrónico de un sitio web de origen dudoso, bórralo sin abrir el archivo adjunto. Asimismo, evita los mensajes que te inviten a hacer clic en vínculos que llevan a sitios web maliciosos. Además, Empey (2018) recomienda que cuando vayas a facilitar datos personales, debes asegurarte que la página tiene habilitado el protocolo HTTPS. Las actualizaciones de sistemas, la capacitación del personal, realizar back up’s y los software’s de seguridad no siempre te ayudarán. Por lo tanto, tu equipo de TI debe vigilar las brechas de seguridad de todo el sistema, en todo momento. Por último, ten en cuenta que proteger tus activos tecnológicos debe ser un trabajo constante. Foto de Michael Geiger en Unsplash

26 de febrero de 2020

Ciberseguridad

8 consejos para implementar una política de seguridad de la información

Según Allianz (2019), en la actualidad, los riesgos cibernéticos y la pérdida de beneficios son las principales preocupaciones de las empresas. Allianz encuestó a 2.415 expertos de 86 países y descubrió que el 37% de los participantes están preocupados por las crecientes vulnerabilidades de la seguridad de la información en sus empresas. La buena noticia es que vamos a compartir 8 consejos para que puedas implementar una buena política de seguridad de la información en tu empresa. Importancia de las políticas de seguridad de la información El principal objetivo de las políticas de seguridad es garantizar la continuidad del negocio. Estas políticas son las pautas que rigen el Sistema de Gestión de Seguridad de la Información (SGSI) de las empresas. Una buena política inspira confianza en los clientes y evita posibles demandas legales a causa de la pérdida de información sensible. 8 consejos para implementar una política de seguridad corporativa 1. Identifica lo que la empresa necesita proteger Este es el primer paso para la implementación de la política. Por eso, es aconsejable que busques respuestas a las siguientes preguntas: ¿Cuáles son los activos de información más valiosos? ¿Dónde se encuentran esos activos? ¿Quién tiene acceso a ellos y por qué? ¿Cuándo se accede a ellos? Las respuestas a estas preguntas te permitirán identificar qué partes de la infraestructura tecnológica son críticas para el negocio ante un ataque informático. Además, te ayudarán a establecer un protocolo de respuesta ante un posible ciberataque. 2. Estima los recursos disponibles para la implementación de las políticas de seguridad Es necesario estimar los recursos humanos, tecnológicos y financieros que serán indispensables para una buena implementación de las políticas. Especialmente si se implementa la norma ISO/IEC 27001. En este caso, Ebizlatam (2018) recomienda que el tiempo dedicado al sistema de gestión no sea mayor a un año debido a los continuos cambios en los riesgos de ciberseguridad. 3. Establece una frecuencia de evaluación de tu política de seguridad de la información Una evaluación de la ciberseguridad de tu empresa te permitirá descubrir vulnerabilidades. Por este motivo, Las medidas preventivas aseguran que se corrijan las vulnerabilidades del SGSI a tiempo. De este modo, se podrán disminuir los efectos de los ataques. Por ejemplo, los sistemas de seguridad de GitHub respondieron de forma ejemplar al mayor ataque Ddos de la historia. Según Mendiola J. (2018), durante 20 minutos, GitHub recibió 126,9 millones de paquetes, pero el servicio solo fue interrumpido por un lapso de 5 minutos. 4. Adopta un enfoque centrado en los datos Los datos son el activo más valioso de la empresa pues son imprescindibles para la toma de decisiones de las organizaciones. Esto los convierte en el principal objetivo de los cibercriminales. Ya que, una vez los capturan, pueden venderlos a terceras empresas o exponerlos públicamente. Para evitarlo, la nueva generación de soluciones centradas en datos, como Hyper FPE e Hyper SST de HPE SecureData aseguran datos confidenciales a través del cifrado y la tokenización. Además, una política de seguridad centrada en datos te ayuda a cumplir con el Reglamento General de Gestión de Datos en Europa (GDPR). 5. Asigna un agente de seguridad de acceso a la nube (CASB) Debido a los riesgos de seguridad que existen en la nube, cada vez más empresas invierten en soluciones para mantener segura su información. Una de esas soluciones es un agente de seguridad de acceso a la nube (CASB). Un agente CASB puede, por ejemplo, identificar malware entre las aplicaciones de la nube. 6. Desarrolla la estructura adecuada en las políticas de seguridad de la información Sin un equipo estructurado de TI tu empresa puede correr un grave peligro, como el que le ocurrió a Target. Esta cadena de almacenes fue víctima de un ataque que expuso los datos de las tarjetas de crédito y débito de 40 millones de clientes. Entre las causas del ataque, los analistas determinaron que Target no contaba con un director de seguridad que promoviera la inversión en ciberseguridad. 7. Realiza un análisis de impacto al negocio: vital en la seguridad de la información El análisis de impacto al negocio (BIA) busca estimar las consecuencias que podrían afectar las operaciones del negocio, en caso de presentarse un incidente de seguridad. El BIA sigue el criterio de cuanto mayor sea el impacto, mayor será la prioridad. 8. Protege la seguridad de la información de su empresa con la criptografía La criptografía es una excelente herramienta de protección de datos para las empresas. Un tipo de criptografía muy utilizado es la firma digital. Este mecanismo asegura que el contenido del mensaje sea legítimo. Además, evita la modificación del mensaje en el envío y la recepción de este. La implementación de una buena política de seguridad no evita que tu empresa sea el objetivo del próximo gran ciberataque, pero sí la prepara para enfrentarlo. Sin embargo, el Jurista (2019) revela que solo el 22% de las empresas españolas aseguran sus datos. Foto de Tirza van Dijk en Unsplash

25 de febrero de 2020

Ciberseguridad

Ciberataque: cuáles son los países que reciben más ataques y cuántos tipos hay

Muchos usuarios, empresas e instituciones gubernamentales son víctimas de algún tipo de ciberataque todos los años. Los ciberdelincuentes aprovechan los cambios tecnológicos, incluso más rápido que el mundo empresarial. Esta es la razón por la que la ciberseguridad lidera todas las demás categorías de inversión, según una investigación de TD Ameritrade (2019). Y no es para menos. Según datos en América Latina ocurrieron 746 mil ataques de malware, entre septiembre de 2017 y agosto de 2018. Es decir, 62.166 ciberataques al mes, nueve por segundo. ¿Cuáles son los países más afectados? El análisis revela que Venezuela recibe la mayor proporción de ataques informáticos (70%), con relación a su población. Sin embargo, en Brasil se alojan el 50% de los hosts de sitios maliciosos. A continuación, vamos a compartir los ataques cibernéticos que más afectan a los usuarios de Internet. 7 ciberataques más comunes en internet 1. Adware: el ciberataque de la publicidad maliciosa El adware ataca en forma de ventanas emergentes. Parece inofensivo, ¿verdad? Pero el problema es que las ventanas que abre el adware no se pueden cerrar. Al menos durante el tiempo que decida el atacante. 2. Spyware: el espía de internet Este tipo de ciberataque está diseñado para monitorear la actividad de los usuarios en Internet. Lo hace con el objetivo de vender esta información a un tercero o utilizarla para atacar al usuario con adware. Para lograrlo, este ciberataque utiliza funciones comunes de sus equipos. Por ejemplo, Chrysaor es un spyware que puede tomar capturas de pantallas o controlar la cámara de un smartphone. Panda Security (2017) dice que Chrysaor apunta hacia móviles Android. Cuando este potente spyware toma el control, es capaz de manipular WhatsApp, Facebook, Twitter, Skype y Gmail. 3. Troyano: ¡cuidado con los regalos en línea! Un troyano es un código malicioso que se hace pasar por algo útil con la finalidad de engañar a los usuarios para que lo descarguen. Una vez instalado en la computadora, el troyano se puede utilizar para robar datos, instalar otros malware’s o modificar archivos. El troyano Emotet es el malware más conocido en América Latina. Gómez (2019) dice que, con este troyano, la víctima recibe un correo con un archivo adjunto. Este archivo utiliza macros y código embebido en el documento para descargarse. Luego de instalarse, se propaga en la red para recopilar información sensible. El estudio ESET 2019, reseñado por ITSitio revela que México recibió el 31% de los ataques de este troyano, entre 2018 y 2019. 4. Virus y gusanos: ciberataques capaces de multiplicar sus efectos Los virus se propagan velozmente por los documentos, programas y archivos de script. Se utilizan para robar información o dañar a las computadoras de la red. Los gusanos, por su parte, son autónomos y se muestran por correo electrónico. Además de robar datos, también pueden eliminar archivos. 5. Ransomware: el cazarrecompensas de internet Este tipo de malware se caracteriza por bloquear las computadoras de los usuarios o los sistemas de las organizaciones. El ciberdelincuente impide acceder a los archivos, a menos que se pague un rescate. Sin embargo, Irwin (2018) explica que respaldar los sistemas con copias de seguridad hace innecesarios estos rescates. En este caso, los retrasos por restaurar los archivos son menos costosos que aceptar las demandas de los ciberdelincuentes. 6. Ataque DDos: el ciberataque que sobrecarga el sistema Un ciberataque tipo Distributed Denial of service (DDos) o “ataque de denegación de servicios” sobrecarga los servidores de una organización. Un ataque DDos envía miles o millones de solicitudes de acceso al sistema por minuto con el objetivo de saturar el sitio web de la organización hasta hacerlo inaccesible. Irwin (2018) señala que esto puede tener el propósito de distraer al personal para entrar al sistema de la organización. 7. Phishing: el ciberataque que se camufla Este tipo de ataques son muy comunes en los correos electrónicos y, en la actualidad, en las redes sociales. El phishing es un tipo de ciberataque conocido como robo de identidad. En este tipo de ataque, se envían e-mails fraudulentos provenientes de bancos, universidades u ofertas comerciales con mensajes urgentes e importantes. Tiene el objetivo de engañar a las personas para que entreguen información confidencial o descarguen malware en su dispositivo. Según Cisco (2017), el total de ataques informáticos aumentó casi cuatro veces entre enero 2016 y octubre 2017. Además, Cisco señala que el 53% de los ataques cibernéticos causaron daños valorados en $500 mil dólares o más. ¿Ahora entiendes lo peligroso que puede ser un ciberataque para tu empresa? Foto de Hack Capital en Unsplash

24 de febrero de 2020

Ciberseguridad

Seguridad informática: una garantía para el futuro de la organización

La seguridad informática es la tendencia que más valor ha cobrado en estos últimos años. La transformación digital en la que se ven envueltas las organizaciones obliga a poner más atención a las nuevas políticas. Debido a la globalización y los grandes avances tecnológicos, las organizaciones deben estar a la vanguardia en sus procesos. Ante esa realidad se aseguran su infraestructura computacional a través de todo el sistema de procesamiento y almacenamiento de datos. Todo con el objetivo de que se garantice la confidencialidad, integridad y disponibilidad de los mismos. Seguridad informática Cada vez más está siendo amenazada por el incremento en los delitos informáticos, los ataques Ddos y el terrorismo computacional. Es por eso que las organizaciones se deben encontrar preparadas para no dejar ninguna vulnerabilidad en sus sistemas. Además, utilizar la mayoría de los recursos a su alcance para proteger todos los requerimientos de información en su negocio. Las organizaciones se encuentran atravesando un periodo de cambios que las empujan a informatizar todos sus sistemas. Cada día son más y más los dispositivos electrónicos conectados entre sí. Los atacantes pueden vulnerar la seguridad informática de una organización desde cualquiera de estos dispositivos. La importancia de una organización es la información confiable, valedera y disponible, que corresponde ser protegida de forma adecuada. Medidas para preservar Protege tus cuentas de correo electrónico: para hacerlo es indispensable la creación de contraseñas seguras. Estas pueden pensarse a través de combinaciones de números, letras minúsculas y mayúsculas, así como signos de puntuación. Elige un antivirus: este programa se encarga de realizar una especie de escaneo monitoreando en tiempo real las actividades de los virus que pueden afectar tu seguridad informática. Realiza copias de seguridad: ejecuta backups que corresponden a las copias de seguridad. Actualiza tu sistema operativo: las actualizaciones realizan tareas de protección mejorando la seguridad del sistema operativo de cara a posibles fallas. Cierra y bloquea sesiones: que tengas el hábito de cerrar sesión cuando ingreses a tus cuentas como correo electrónico, redes sociales, cuentas bancarias online. Es oportuno señalar que la seguridad informática atiende sólo a la protección de la información en medios digitales, mientras la seguridad de la información integra toda la información independientemente del medio. Asimismo, la ciberseguridad es una de las principales preocupaciones que tienen las organizaciones hoy en día debido a los riesgos. Al mismo tiempo se exponen estando conectadas a la red y accesibles para hackers del mundo entero. Las amenazas se generan de manera inevitable. Y con la ciberseguridad se diseñan métodos para tener un sistema seguro, siendo necesarios y considerablemente oportunos. Otro elemento es la criptografía en la seguridad informática. Esta se ha convertido en la única arma con la que podemos defender nuestro derecho a la privacidad. Igualmente, es una de las formas de tener segura la información. La utilización de la criptografía y de los diferentes métodos de cifrado nos permite proteger datos y nuestra privacidad. Toda organización debe tomar medidas preventivas de su infraestructura computacional, al ser la información uno de sus activos empresariales principales. Política de seguridad informática Por lo antes expuesto, es importante el establecimiento de una política de seguridad informática, una necesidad para las organizaciones que utilizan las redes como una forma de mejora en procesos. Las políticas vienen a representar una forma consensuada de hacer y manejar todos los aspectos tecnológicos de la organización, ya que de no hacerlo así podrían ocasionar serios problemas a la entidad. El establecimiento de dichas políticas de seguridad debe ser de arriba hacia abajo en la organización, pues requiere de un apoyo económico, pero también de dirección muy importante para hacer que esto tenga éxito y no sea considerado como algo superficial sin impacto. Es fundamental para una organización tener el conocimiento de los elementos que pueden afectar su seguridad. Es decir, deberá tomar en cuenta tanto los aspectos físicos como lógicos. De esta manera se deben conocer los delitos, para establecer políticas de protección adecuada en la organización. Si una organización quiere ser competitiva en los tiempos que corren debe contar con sistemas, recursos y plataformas TIC ágiles. Sobre todo, una gestión planificada en materia de ciberseguridad, con un alto nivel de disponibilidad, lo que exige una gestión efectiva y un amplio proceso de transformación digital. Foto de Hack Capital en Unsplash

22 de febrero de 2020

Ciberseguridad

Ingeniería social, el ciberataque más común en la red

La seguridad tecnológica cada día se encuentra más en riesgo. Los ataques más comunes se producen a través de ransomware, spyware, entre otros. Los cibercriminales siempre buscan nuevas formas de incorporar tácticas para engañar a la víctima. Una de estas estrategias es la llamada ingeniería social. ¿Qué es la ingeniería social? En el entorno de los ataques cibernéticos, la ingeniería social puede definirse como el arte de hackear la psicología humana con el fin de obtener acceso a datos no autorizados (Rodríguez, 2018). Frecuentemente, pueden actuar mediante canales de comunicación: Mensajes de texto Correo electrónico Chat Redes sociales. A través de estos medios, se extrae información de interés y confidencial para forzar a las personas a hacer acciones perjudiciales. En este caso, los delincuentes se enfocan en el comportamiento irracional, sesgos cognitivos, distracción y emociones de los usuarios. Por ejemplo, en el 2018, la Condusef (Comisión Nacional para la Protección y Defensa de los Usuarios de Servicios Financieros del gobierno mexicano) detectó un nuevo ataque de ingeniería social contra los usuarios de la banca por Internet. En esta experiencia, mediante un mensaje de texto, los ciberdelincuentes notificaron de una falsa desactivación de la tarjeta bancaria y solicitaron la validación de la identidad del usuario. El fin de esta acción era la obtención de datos personales y bancarios para, posteriormente, realizar consumos cargados a la tarjeta o vaciar la cuenta. Principales tipos de ataques de ingeniería social Frecuentemente, los hackers desarrollan nuevas estrategias para engañar a los usuarios. Por tal motivo, es esencial familiarizarse con los tipos de técnicas y así mantenerse prevenidos. Entre algunos de ellos, se encuentran: 1. Suplantación de identidad Resulta uno de los principales ataques de piratería social en general. Las fuentes de ataque empleadas son el correo electrónico, SMS, redes sociales, entre otros. Por ejemplo, el atacante se hace pasar por una compañía legítima, como un banco o una gran empresa. La trampa principal será un correo que parecerá confiable e incluirá un llamado de acción. Es así como se pueden solicitar contraseñas o información privada debido al engaño. 2. Spear phishing Este tipo de ataque se diferencia de los tradicionales debido a que se orienta a una organización específica, un área de la empresa o solo a un empleado. En este caso, se necesita una detallada investigación por parte del cibercriminal en torno a las víctimas. Se hace muy difícil distinguir el email ilegítimo y, por lo tanto, se incrementan las posibilidades de éxito del ataque de ingeniería social. 3. Whaling Es una subcategoría del phishing y, en otras palabras, significa que los cibercriminales van por los “peces más grandes”. Este tipo de ataque va dirigido a quienes tienen un rango más alto en empresas: los CEO y otros puestos ejecutivos. Sus tácticas son similares al spear phishing para el robo de información confidencial y acceso a sistemas restringidos. 4. Vishing Si el phishing se hace a través del correo electrónico, el vishing se realiza mediante llamadas telefónicas para ejecutar el fraude. El atacante crea un número falso, llama a la víctima y finge ser representante de un banco o proveedor de servicios. Luego solicita las credenciales o detalles de las cuentas bancarias. ¿Cómo protegerse de los ataques de ingeniería social? La ingeniería social está directamente relacionada con el comportamiento humano básico. Esto implica que es difícil dar consejos infalibles para evitar estos riesgos. Al respecto, Antokoletz (2018), docente e investigador de inteligencia artificial y algoritmos genéticos, explica que la prevención es un elemento totalmente cultural en la ciberseguridad. En otras palabras: educación y protocolos de seguridad. Algunas recomendaciones al respecto son: Ser escéptico. En otras palabras, no creer todo lo que digan y quizá hacer algunas preguntas básicas antes de dar información confidencial. Hay que asegurarse de que la persona que llama o envía correo electrónico sea de confianza. Educación. Tal y como se mencionó, la formación ante estos tipos de peligros es vital. Capacitar y familiarizar al personal en torno a las diversas tácticas es fundamental. Debe comprenderse la ingeniería social en sus variadas formas. Actualización. Los ciberdelincuentes siempre buscan la manera de localizar brechas de seguridad en los sistemas informáticos. Todo ello implica que se deban actualizar los dispositivos, mantenerse al tanto de parches de seguridad que ayuden a mitigar ataques, entre otras medidas. Es importante documentar todas las contingencias presentadas para que los miembros de la empresa estén siempre atentos. Es así como la ingeniería social emplea la emoción humana como punto de contacto. Todas las personas son vulnerables a estas amenazas. Por consiguiente, es importante mantener siempre la guardia alta: nunca se sabe cuándo pueden venir los ataques. Photo by Joseph Gruenthal on Unsplash

20 de febrero de 2020

Ciberseguridad

¿Cómo protegerse de un ataque DDoS?

Los ataques por Ddos (Denegación de servicio distribuido) son, básicamente, intentos maliciosos para interrumpir el tráfico normal de un servidor, servicio o red. Y ello, con el objetivo inicial de que estos no estén disponibles para los usuarios finales. Una vez que estos intentos logren impactar la ciberseguridad de una organización, por lo general estos recursos afectados son luego usados para distribuir masivamente malware a otros dispositivos. Cuando un atacante logra obtener el control de una red donde están conectados varios dispositivos, comienza a distribuir malware a través de ellos. Con esto logra crear una especie de red zombie, la cual es comúnmente conocida como botnet. Una vez que se haya establecido la botnet, el atacante podrá enviar peticiones maliciosas a otras redes o IP’s objetivos. Ello causa una denegación de servicio en dicho tráfico normal. Generalmente es difícil identificar un bot, ya que el mismo proviene de un dispositivo existente. Tipos de ataques de Ddos Los ataques de denegación de servicio consisten en atacar de manera constante los recursos de red, usando una o más categorías. Algunos suelen combinar técnicas sofisticadas empleando diferentes vectores. Las categorías que son utilizadas para realizar estos ataques son: Ataques basados por volúmenes - Se envían cantidades masivas de tráfico hasta colapsar el ancho de banda. Ataques por protocolos - Se enfocan en buscar vulnerabilidades en los recursos de los servidores y eventualmente los explotan. Ataques por aplicaciones web - Son los ataques más sofisticados, ya que se enfocan en ciertas aplicaciones webs. Ataques por conexiones TCP - Encuentran vulnerabilidades en conexiones TCP y posteriormente inundan de tráfico el servidor web. Ataques por fragmentación - Se da cuando se logra explotar el proceso de fragmentación de datagramas, en el cual una IP es dividida en paquetes más pequeños. Durante el ataque se inyectan paquetes falsos maliciosos que colapsarán eventualmente el servidor. Algunos consejos para prevenir ataques Ddos Debido a que la detección de ataques de denegación de servicio distribuido es más compleja de identificar en comparación con un virus, para prevenirlos se debe aplicar una variedad de estrategias: Limita la tasa de peticiones Limitar el número de peticiones que un servidor aceptará durante un tiempo determinado es una buena manera de mitigar ataques de denegación de servicio. Hay que tener claro que limitar la velocidad de peticiones ralentiza los trabajos de raspadores webs. También reduce los intentos de fuerza bruta para iniciar sesión. Aplicarlo como única solución será insuficiente para prevenir un ataque Ddos. Implementar un Firewall de aplicaciones webs Un Firewall de aplicaciones web es una herramienta que puede ser útil para mitigar ataques de Ddos en capa 7. Implementando el WAF (Web Application Firewall) entre internet y el servidor de origen, puede servir como un proxi de reversa. Protege así el servidor objetivo de numerosos tipos de tráfico malicioso. Al filtrar las peticiones usando como base una serie de reglas para identificar herramientas empleadas en ataques Ddos, los ataques en capa 7 pueden ser impedidos. Una de las principales características que tiene el WAF es su capacidad para implementar rápidamente reglas personalizadas ante un ataque. Aplica redes de difusión Anycast Al aplicar una red de difusión Anycast se mitigan ataques de denegación de servicio ya que, al dispersar el tráfico malicioso, se puede enviar a través de una red de servidores hasta una red externa. Esto es algo muy similar a como cuando se canaliza un río a través de canales más pequeños y separados. Este tráfico se vuelve manejable y se puede llevar hasta una desembocadura sin que afecte el entorno. Es importante señalar que la efectividad de una red de difusión Anycast dependerá del tamaño del ataque y la eficiencia de la red interna. ¿Qué hacer en caso de haber sido víctima de un ataque Ddos? Si tu organización ha sido víctima de un ataque de denegación de servicio y, por ende, la ciberseguridad está comprometida, hay varias medidas que se pueden tomar. Algunas de ellas son: Eliminar las infecciones en los dispositivos comprometidos de manera individual con un software de seguridad. Aislar y asegurar el tráfico usando subredes, reglas de firewall y administrar minuciosamente los accesos e identificaciones en la red. Aplicar un filtrado/enrutamiento de red de tipo blackhole. Desplegar instancias sin IP’s públicas. Habilitar el balanceador de carga basado en proxis. Afortunadamente existen en el mercado numerosas empresas que ofrecen servicios de protección contra ataques DDoScomo en nuestro caso, en Telefónica Tech. Ya sea desde la nube o por medio de soluciones de seguridad. En cualquier caso, se debe aplicar una combinación de técnicas para mitigar, en lo posible, ataques a la red. Foto de Mika Baumeister en Unsplash

20 de febrero de 2020

Ciberseguridad

Qué es y cómo se implementa el ethical hacking

La seguridad informática y el ethical hacking son las tendencias que más valor han cobrado en estos últimos años. La transformación digital en la que se ven envueltas las empresas obliga a poner más atención a las nuevas políticas. Ciberseguridad La ciberseguridad es una de las principales preocupaciones que tienen las empresas de hoy en día. Esto ocurre debido las vulnerabilidades y los riesgos a los que se exponen al estar conectadas a la red y accesibles para los hackers. A cualquier negocio le preocupa tener unas férreas defensas que le permitan superar cualquier tipo de ataque con el que se encuentre. Debido a la seguridad informática, se busca proteger la información no solo de clientes, sino también de registros, información de empresas, proyectos, personas y gobiernos que utilizan a diario la red. Uno de los grandes desafíos que enfrenta la seguridad informática es la velocidad con la que aparecen las nuevas plataformas. Otro elemento es la criptografía, que se ha convertido en la única arma con la que podemos defender nuestro derecho a la privacidad. Ataques cibernéticos Una encuesta mundial referida a los ataques cibernéticos reveló lo siguiente: “… de 30 países, el 30 % de las organizaciones no poseen los suficientes métodos ni cuentan con los protocolos necesarios para dar un respuesta pronta e inmediata a ataques cibernéticos avanzados. Asimismo, de aquellos que cuentan con un plan, el 57 % admite que nunca lo actualizó o no lo revisó” (ITNOW, 2015). Los cibercriminales han estado presentes desde que las primeras empresas comenzaron a usar Internet para el comercio. La tasa de delitos informáticos y su costo para las empresas han aumentado dramáticamente con el tiempo, así como la constante transformación de los delitos cibernéticos Tomando en cuenta este ambiente de debilidad, los expertos han planteado una solución que ha logrado situar el hackeo al servicio de la detección de ataques. También existen diferentes herramientas o suites de aplicaciones desarrolladas para llevar a cabo prácticas de ethical hacking. Sin embargo, recopilar las aplicaciones una a una es una tarea bastante larga y molesta. Debido a esto, en muchas ocasiones la mejor opción es optar por una distribución con fines de ethical hacking. H2: El ethical hacking El ethical hacking o hackeo ético consiste en utilizar los propios métodos y herramientas de un atacante con la finalidad de mejorar el estado de seguridad de la organización. Mediante este procedimiento, se busca reducir el riesgo de un ataque exitoso. Luego de realizado el proceso, se entrega un informe exacto para implementar las acciones que permitan remediar las debilidades. La ejecución de estas tareas es realizada por un equipo de expertos certificados en auditorías, perímetros y plataformas digitales. Hoy en día las empresas tienen conocimiento de las consecuencias que puede tener un ataque de ransomware. En este tipo de ataque, los cibercriminales bloquean el acceso a los datos y documentos, y luego piden una cantidad de dinero para recuperar la información. Definitivamente, el ethical hacking nace como un mecanismo de control para combatir la ciberdelincuencia. Mediante su aplicación, se garantiza el buen flujo de lo más preciado: la información. Las empresas pactan con estos expertos porque necesitan ensayar y fortalecer la seguridad de sus datos. En resumen, el ethical hackingexhibe un informe bien pulcro que marca los rendimientos y las acciones asociadas. Photo by David Rangel on Unsplash

19 de febrero de 2020

Ciberseguridad

Tipos de malware que existen y cómo proteger sus datos y dispositivos

El malware es cualquier tipo de código malicioso que busca infectar un sistema operativo, un computador o un artefacto que utiliza software. El objetivo del malware es incorporar un virus informático para acceder a información valiosa, los servicios del dispositivo o sus capacidades de procesamiento. Inicios y evolución del malware Los inicios del código malicioso se ubican en 1972 con la creación, por parte de Bob Thomas Morris de Creeper (enredadera), de un virus que se autoejecutaba infectando máquinas DEC PDP-10 e IBM Serie 360. Ese mismo año fue creado Reaper (segadora), un programa diseñado para ubicar el virus Creeper y eliminarlo. No está clara su autoría, pero es considerado el primer antivirus. El término “virus” comienza a utilizarse en 1984, aunque ya existían antes códigos maliciosos. El juego informático Darwin es notable por ser el primero con capacidad de tomar control de los recursos del computador. En este caso, el software creaba una serie de programas que capturaban memoria y eliminaban a programas competidores. Brain en 1986, también conocido como Pakistani Brain, fue el primer virus informático con mecanismo de ocultamiento. Infectaba el sector de arranque de los disquetes, lo cual facilitó su propagación. Es un ejemplo del inicio de los virus troyanos y gusanos. El desarrollo de código malicioso ha seguido evolucionando, incorporando tecnologías, algoritmos y mecanismos cada vez avanzados, como la inteligencia artificial, la computación móvil y el cloud computing. Principales usos y daños ocasionados por el malware El código malicioso es cada vez más sofisticado y en la actualidad se utiliza, entre otros fines, para: Campañas de espionaje. Ataques entre países o corporaciones. Extorsión y estafa. Ciberataques a infraestructura de servicios. Secuestro de datos, recursos y sistemas informáticos. Difusión de mensajes y de publicidad invasiva mediante ingeniería social. Los daños ocasionadas por malware incluyen: Pérdida de información personal y de contraseñas. Negación de acceso a servicios mediante ataques de tipo DDoS. Bloqueo, encriptación o secuestro de datos, archivos o equipos, a través de virus de tipo ransomware. Ejecución de código malicioso en computadores de terceros sin su autorización. Robo de datos, de identidades o estafa. Tipos de malware y virus informáticos Phishing y Spyware El phishing (“pescar”) se vale del uso de un correo electrónico o de una dirección falsa para dirigir a la víctima a un sitio web que simula al verdadero. Este tipo de malware se enfoca en la suplantación de identidad, ya que el cibercriminal se hace pasar por una persona o empresa de confianza. El spyware se utiliza para recopilar y robar nombres o información de los hábitos del usuario del equipo contaminado. También para obtener datos de acceso a aplicaciones o cuentas bancarias. Ambos tienen una característica en común: ser utilizados para obtener información confidencial y estafar aplicando técnicas de ingeniería social. Ransomware El ransomwarees un virus informático con el efecto de restringir el acceso al sistema operativo, archivos, servicios o bloquear el equipo contaminado. El término deriva de la combinación de las palabras ransom (rescate) y ware (software), por lo que se entienden también como software de secuestro. Una vez se activa el virus, se provoca el secuestro de la información o del equipo mediante el control del sistema operativo. Para desbloquear la información o dispositivo se solicita el pago de un rescate. Ciberextorsión Hace uso de violencia o intimidación por medios digitales para que la víctima realice una acción en su perjuicio o afectando a terceros. Generalmente no hay contacto directo entre la víctima y quien perpetra el ataque (pirata informático). La ciberextorsión está muy relacionada con el acoso informático y con el ransomware. Se utiliza para: Amenazar con la publicación de información confidencial o sensible. Envío de correos electrónicos, llamadas o mensajes solicitando información o dinero. Encriptación de archivos o bloqueo de equipos y solicitud de rescate para liberarlos. Adwareo malware móvil Son programas que se ejecutan sin autorización, mostrando anuncios publicitarios y redirigiendo al usuario hacia otros sitios web. Mediante ventanas emergentes se muestra publicidad. También se busca recopilar información sobre hábitos de uso o preferencias del usuario. Es diseñado, generalmente, para no hacer daño y se ejecuta sin dejar rastro en la lista de programas o apps del equipo. Se les considera malware o código malicioso cuando recopila información sin nuestra autorización. Una forma de evitar la contaminación con adware es no descargar desde sitios web no confiables programas freeware o shareware. Troyanos y gusanos informáticos Ambos son códigos maliciosos que infectan el dispositivo móvil a través de un programa en apariencia inofensivo o legítimo. Los virus informáticos troyanos pueden infectar incluso el sistema operativo de los equipos. Permite a los cibercriminales robar información, espiar o tener acceso al equipo, sus servicios o sus puertos de comunicación. Los gusanos informáticos o worms son programas maliciosos que crean copias de sí mismos en forma imperceptible para el usuario. Su objetivo es colapsar el equipo o las redes informáticas a las cuales está conectado. El propósito de un virus de tipo gusano es propagarse e infectar la mayor cantidad posible de equipos. Las formas de contaminación más comunes para los troyanos y gusanos son: programas, apps o correos electrónicos infectados. 5 ciberataques comunes en Latinoamérica La empresa especializada en tecnologías de seguridad ESET ha informado en sus reportes que los virus informáticos más comunes en Latinoamérica son: Phishing. Ciberextorsión. Explotación de vulnerabilidades en equipos, sistemas informáticos y redes. Minería de criptomonedas ejecutando códigos sin autorización del usuario (cryptojacking). Ataques por denegación de servicio o ataques DDoS. Entre los códigos maliciosos reportados a nivel mundial destacan por sus efectos: UFO:Bloked.Adware. RiskTool.Win64. BadRabbit. WannaCry. Petya. Troja.Script.Miner.gen. CryptoLocker. JS/CoinMiner. KeRanger. Mamba. Se reportó para el período de julio de 2018 a julio de 2019 en Latinoamérica más de 45 bloqueos de intentos de infección por segundo. En este mismo año, se bloquearon más de 92 millones de accesos a sitios falsos con amenaza de phishing. La piratería de software y el adware también están entre las principales amenazas a la ciberseguridad. 5 acciones básicas para protegerse del malware Usar tecnologías de protección, encriptación y antivirus actualizados. No suministrar datos en sitios web no confiables o por correo electrónico. Identificar vulnerabilidades en los equipos o sistemas informáticos de la organización. Aplicar buenas prácticas de seguridad informática. Mantenerse actualizado sobre las nuevas amenazas. Photo by Taskin Ashiq on Unsplash

18 de febrero de 2020

AI & Data

ehealth: aplicación de las tecnologías para la transformación digital de los servicios de salud

El ehealth o eSalud es el apoyo que las tecnologías de la información y la comunicación (TIC) ofrecen a la salud y ámbitos relacionados. Najeeb Al-Shorbaji (s.f.), de la Organización Mundial de la Salud (OMS), define eSalud como “el uso de las tecnologías de la información y las comunicaciones aplicadas a la salud”. Como director del Departamento de Gestión e Intercambio de Conocimiento en la OMS, Al-Shorbaji destaca que la evolución en el área ha generado una terminología variada: Telemedicina TeleSalud mSalud o mHealth Cibersalud Salud digital Salud 4.0 El ehealth engloba toda esta terminología y sus aplicaciones en servicios de atención de salud: documentación, vigilancia, asistencia, predicción y diagnóstico sanitario. También incluye la investigación, la educación y el conocimiento que se desarrolla gracias al uso de las tecnologías en el sector salud. e-Health: innovación al servicio de los pacientes, médicos y otros profesionales de la salud Los avances tecnológicos logrados mediante el ehealth han mejorado diversos procesos, entre otros: Registro electrónico de servicios de salud (EHR). Registros médicos electrónicos (EMR). Asistencia sanitaria virtual y móvil (mHealth). Mejora en el tiempo de atención de los servicios de seguros. Seguimiento de pacientes y sus tratamientos. Control de inventarios y aparatos médicos. La medicina avanza apoyándose en tecnologías de áreas disruptivas como la inteligencia artificial, las redes neuronales y el machine learning. Otros avances se reflejan en la automatización de los diagnósticos médicos y en la predicción de enfermedades. Como parte de los beneficios de la transformación digital, han mejorado significativamente los siguientes procesos: Registro digital de datos. Acceso a la información. Procesamiento y visualización de imágenes médicas. Conexión entre dispositivos, sistemas de información, la plataforma hospitalaria y de asistencia. Desafíos en ehealth Los pacientes, los médicos y los prestadores del servicio de salud exigen procesos en los que se agilice la atención, se reduzcan los costos y se mejore la calidad. Incorporar tecnologías existentes o desarrollar otras nuevas ayuda a responder a estas necesidades. Sin embargo, transformar el ecosistema de salud mediante el avance tecnológico también presenta un conjunto de desafíos: Lograr la interoperabilidad en los sistemas de información utilizados en los servicios de atención, de seguros y médicos. Actualizar el marco legal y regulatorio. Formar recursos humanos para el uso eficiente de las TIC en favor de la eSalud. Ampliar el alcance de la telemedicina y las teleconsultas. Monitorear, controlar y medir el impacto en los servicios prestados. Utilizar big data e inteligencia artificial para analizar datos del sistema de salud y mejorar atributos clave del servicio. eSalud: casos de éxito y nuevas tendencias A continuación, se muestran algunas experiencias exitosas en servicios de salud ehealth y cómo mejoran nuestro bienestar. IoMT o el Internet de las cosas médicas Esta innovación es la aplicación del Internet de las cosas (IoT), especialmente adaptada al servicio de la atención sanitaria. El IoMT o Internet of Medical Things es la conexión de dispositivos y aplicaciones médicas mediante redes informáticas. En el IoMT los dispositivos se conectan a plataformas en la nube y se comunican entre sí en forma directa (comunicación machine to machine). En estos sistemas se utilizan diversas tecnologías de conexión para los dispositivos médicos: Inalámbrica mediante WiFi. Conexión por campo cercano (NFC). Etiquetas de identificación de radiofrecuencia (RDIF). RoboCoach y Robear Con una población que tiende a envejecer en muchas regiones del planeta, la atención en casa, la atención móvil y el apoyo emocional son factores importantes. El RoboCoach fue desarrollado en Singapur por el Ngee Ann Polytechnic con el objetivo de mantener animadas a las personas mayores. Estos instructores robóticos animan a las personas mediante la simulación de gestos humanos, el procesamiento automático del habla y la demostración de ejercicios. Japón no se ha quedado atrás y ha desarrollado a Robear. Este robot gigante se utiliza para cuidar a personas en edad avanzada o con alguna discapacidad. RoboCoach y Robear, al igual que otros robots, como Paro, Pharos y Babyloid, aprovechan la inteligencia artificial para ejecutar algoritmos avanzados de aprendizaje automático, predicción, identificación, evaluación o recomendación. Otras aplicaciones exitosas de la medicina digital: Entrenamiento mediante realidad virtual. Disminución de riesgos mediante motores de inteligencia artificial. Predicción de enfermedades mediante aplicaciones que combinan IoT y machine learning. Caso Insulclock, TIC al servicio de diabéticos. El ehealth ha evolucionado hasta abarcar no solo aspectos directamente relacionados con la atención de la salud. En la actualidad, implica el uso de nuevas tecnologías para adaptarnos a diversos desafíos que pueden afectar nuestra calidad de vida. Tecnologías como el big data, la inteligencia artificial, el machine learning y el IoMT se combinan en los sistemas de salud para que, además de estar sanos, también seamos más felices. Photo by CDC on Unsplash

17 de febrero de 2020

AI & Data

Domótica e Inteligencia Artificial: del hogar inteligente a las Smart Cities