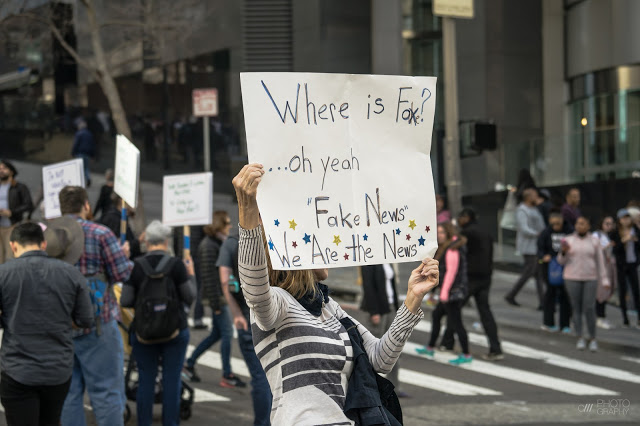

Las “fake news” son uno de los últimos términos incorporados a nuestro vocabulario habitual en forma de anglicismo. Pero, ¿qué son las “fake news”? ¿Son realmente algo nuevo? Y ¿por qué han despertado tanto interés ultimamente? ¿Por qué parece que ahora todo el mundo habla de ellas?

¿Qué son las “fake news”?

En realidad, las

“fake news” son las noticias falsas de toda la vida. Es la manipulación de la información, la propaganda. Obras dedicadas a la historia de la propaganda, como

“Munición para la mente: Historia de la propaganda desde el mundo antiguo a nuestros días” de Philip M. Taylor, nos dan las claves del porqué de su existencia y quiénes están detrás de ellas. Normalmente, los principales creadores de noticias falsas, o bulos,

son los estados, los mismos que siempre han intentado acallar esas otras fuentes de información que revelan aspectos sobre los cuales los dirigentes preferirían correr un tupido velo. Y aunque parezca un fenómeno más identificable con gobiernos dictatoriales, las estrategias para intentar

controlar el pensamiento de los ciudadanos a través los mensajes emitidos por sus dirigentes culturales o artísticos, reescribiendo la historia con enfoques poco o nada objetivos o incitándoles a adoptar determinados comportamientos o cambios en su modo de vida, en definitiva, la propaganda, es un fenómeno histórico y global que está de plena actualidad.

Las

“fake news” cobran especial relevancia cuando hay elecciones a la vista (propaganda política), o cuando hay una guerra de por medio (propaganda militar). Se trata, claramente, de situaciones donde alterar el resultado en una u otra dirección se traduce en prerrogativas económicas y de influencia o poder en los que determinados grupos pueden salir claramente beneficiados. No cuesta mucho trabajo encontrar ejemplos. El equipo de la UE especializado en la detección de noticias falsas,

East Stratcom Task Force, detectó un gran

incremento de noticias falsas destinadas a

agravar la crisis en Cataluña. De hecho, confirmó la existencia de una auténtica maquinaria de noticias falsas que, desde Rusia, intenta

debilitar a EEUU y la UE. También fue notoria la injerencia rusa en la campaña electoral que llevó a Donald Trump a la presidencia de EEUU. Tanto, que el

Congreso y Senado americanos han abierto varias investigaciones sobre el impacto de estas campañas de desinformación y el papel de Rusia en ellas. Por su parte, el

Parlamento Británico ha exigido a Facebook una investigación sobre el impacto de los bulos difundidos a través de esta red social en el referéndum del

Brexit.

Está claro que las distintas innovaciones tecnológicas que tanto han favorecido la comunicación, también han traído de la mano una mayor facilidad para la difusión de noticias falsas que hoy día

“se benefician de instrumentos realmente masivos y de uso muy fácil”,como explica Pablo Sapag, profesor de Historia de la Propaganda en la UCM, en un artículo para

EL PAÍS Retina. Sin embargo, matiza, aunque “hay una cierta sensación de descentralización, la propaganda sigue estando en manos de quien realmente puede hacerla, ya sean Estados, gobiernos, grupos de poder. (…)” La propaganda solo es efectiva si se hace de forma profesional y quienes tienen capacidad de hacer propaganda no son los individuos, son las

organizaciones, ya sean estatales o de otro tipo.

¿Por qué son preocupantes?

Son preocupantes porque numerosos estudios reflejan que, aunque creamos lo contrario, muchas veces no somos capaces de distinguir las noticias reales de las falsas. Un estudio

publicado por la Universidad de Stanford en Noviembre de 2016 sobre 7804 estudiantes mostró cómo en torno al

82% de los adolescentes no eran capaces de distinguir entre contenido real y contenido manipulado. Otro estudio, diseñado por Sophie Nightingale, investigadora en psicología cognitiva y publicado en Julio de 2017 por el

Cognitive Research ponía de relieve nuestras pobres habilidades para distinguir entre imágenes retocadas y reales. De hecho, de los 700 participantes de la muestra, tan sólo un 60% fue capaz de detectar las imágenes modificadas, resultado poco mejor que si se hubieran elegido al azar. Incluso cuando eran advertidos de que ha imagen había sido retocada, tan sólo un 45% de los individuos eran capaces de detectar qué había cambiado en la foto. (Puedes probar tú mismo el

test de la Universidad de Warwik).

En la web del

Bronx Documentary Center se pueden encontrar numerosos ejemplos de fotoperiodismo o fotografía documental en la que las imágenes han sido manipuladas. En esta galería se analizan los casos más importantes y sus implicaciones éticas.

Esta dificultad para detectar imágenes manipuladas resulta preocupante porque las imágenes nos dan la sensación de agregar un plus de credibilidad a lo que leemos (“Lo he visto con mis propios ojos”) y tienen un gran impacto en nuestros recuerdos. Por tanto, influyen mucho en las decisiones que tomamos, no sólo nosotros mismos, sino también las propias autoridades, cuando, por ejemplo, se usan imágenes como prueba ante un tribunal.

¿Qué podemos hacer para luchar contra ellas?

Lo principal es desarrollar habilidades de alfabetización mediática (“media literacy”), es decir, ser capaces de hacer una lectura consciente y crítica de los contenidos que recibimos a través de las redes sociales y otros medios. De hecho, la Universidad de Stanford ha diseñado

contenidos específicos para ayudar a sus estudiantes a discriminar las noticias falsas de las reales.

Sin embargo, también nos sería de gran ayuda poder hacer un cribado previo de forma automatizada y es ahí donde entra en juego la inteligencia artificial y, en particular, los algoritmos de Machine Learning.

¿Cómo nos puede ayudar el Machine Learning a detectar noticias falsas?

Al igual que la ciencia y los avances tecnológicos no son buenos ni malos, sino que dependerá del uso que hacemos de ellos, hay algoritmos que contribuyen a crear el problema, pero son también algoritmos los que nos pueden dar la clave para solucionarlo.

El objetivo de empresas como Facebook, Twitter o Google es controlar la publicidad. De hecho, entre ellos controlan el 95% de la publicidad online. Sus ingenieros diseñan algoritmos que captan nuestra atención y nos mantienen“enganchados” a sus redes el mayor tiempo posible. Estos algoritmos de Machine Learning “aprenden” sobre nuestros intereses y se adaptan a ellos. Esto puede ser bueno, cuando recibimos información personalizada y real sobre aquellos temas que más nos importan, pero tiene la contrapartida de facilitar también la difusión de noticias falsas. Si el algoritmo detecta que hemos leído una historia rara, conspiratoria, sobre ovnis… lo que sea, empezará a sugerirnos más y más noticias de este tipo, ya que su objetivo es la viralidad, es decir, maximizar el impacto. Y ofrecernos publicidad en aquellas páginas que reciban más atención.

Pero, aunque las principales redes sociales se centraron en la

publicidad pagada (anuncios falsos) a la hora de responder a las preocupaciones de los gobiernos y otras instituciones, su responsabilidad va mucho más allá ya que, aunque la difusión de noticias falsas no sea el objetivo de su estrategia empresarial, sí que es una clara consecuencia.

Por poner un ejemplo, según un estudio realizado por Media Insight Project en 2015 sobre individuos entre 18 y 34 años (

“How Millenials get news”) para el 18.88% de los jóvenes la principal fuente de noticias de actualidad es Facebook u otra red social. Si a esto le sumamos que la estrategia de estas redes de ofrecerte el tipo de noticia que “te gusta”, lo que se obtiene es una visión muy parcial y sesgada de la realidad.

Construyendo un detector de “fake news”

Aaron nos cuenta que, como en cualquier problema de Machine Learning, el trabajo principal es conseguir un conjunto adecuado (en cuanto a volumen y calidad) de

datos de entrenamiento. Es decir, una gran cantidad de “fake news” con las que alimentar el algoritmo. Le presentamos una noticia falsa tras otra, y poco a poco va detectando rasgos comunes, patrones, que le ayudarán a identificarlas.

Parece fácil, pero no lo es porque ¿Cómo seleccionar estas noticias? Cuando empiezas a investigar sobre el tema, encuentras una gran variedad de noticias. Desde las flagrantemente falsas, hasta las medias verdades, artículos pseudocientíficos, o de opinión. Así que decidió empezar a buscar en los

sites de fake news más conocidos. Viendo la magnitud de la empresa, se le ocurrió probar con una herramienta de análisis de sentimiento,

Textbox que interpretara los fragmentos de texto como

“positivos” o

“negativos”, y luego los combinara con un sencillo algoritmo “casero” que asignara distintos pesos según el tipo de texto (título, contenido, autor…) para obtener una valoración global. Pero aunque las pruebas iniciales parecían prometedoras, no funcionó.

Un amigo le recomendó no tratar de buscar patrones en el texto para los distintos tipos de noticias, sino analizarlas por separado. Crear distintos conjuntos de datos de entrenamiento de noticias falsas, noticias satíricas, noticias reales etc. obtenidos de sites claramente reconocidos como fuentes de cada tipo de ellas. Sin embargo, tampoco funcionó porque ningún grupo de noticias era 100% puro. No servía.

Fue en ese momento cuando decidió ponerse a leer noticia por noticia para clasificarlas correctamente y copiar/pegar cada una de ellas en una gigantesca hoja de Excel. Haciendo un considerable ejercicio de paciencia no exento de ciertos riesgos para su salud mental (por el cariz de los contenidos que tuvo que leer), llegó a recopilar un volumen adecuado de datos de entrenamiento. Sin embargo, al aplicar el algoritmo con estos datos, la precisión que obtuvo no pasaba del 70%. Tampoco servía.

Nuevamente tocó volver al punto de partida. ¿Qué estaba fallando?. Su amigo experto opinaba que la mejora de la precisión quizás debería pasar por la simplificación del problema, así que se replanteó cuál era realmente el problema que quería resolver. Y ¡eureka!, dio con la respuesta.

Detectar noticias falsas resultaba una tarea mucho más compleja que detectar noticias auténticas. Éstas últimas resultaban mucho más fáciles de categorizar. Así, empezó a recopilar noticias y clasificarlas como “no ciertas” (sátira, opinión, bulos etc) y “noticias ciertas” hasta llegar a un volumen adecuado. Y al probar nuevamente el algoritmo la precisión llegó a un ¡95%!. Eso era otra cosa. Habían encontrado un patrón en la forma en que estaban escritas las noticias que permitía detectar la diferencia entre las reales y las falsas.

Así, crearon un

modelo basado en Machine Learning, al que llamaron

Fakebox, capaz de decir si un artículo

está escrito de forma similar a como lo están las noticias reales o no. Con tan solo cortar y pegar el texto en la ventana de Fakebox, el modelo devuelve una puntuación. Si esta puntuación es baja, significará una alta probabilidad de encontrarnos con una sátira, un artículo de opinión o una noticia falsa.

Aunque hoy por hoy no existe una solución perfecta que detecte automáticamente las noticias falsas, es interesante comprobar cómo, al igual que son algoritmos los que permiten la rápida difusión de las fake news, la mejor manera de contrarrestarlas es recurrir a otros algoritmos. Pero, como hemos visto en el ejemplo que nos contaba Aaron Edell, en el trabajo del Data Scientist, hay una parte muy importante de definición de objetivos, de preparación y tratamiento de datos, de ensayos, de errores, de consultar con otras personas expertas en la materia, de luchar contra el desaliento cuando los resultados no son los esperados, y de volver al punto de partida, cuando es necesario afrontar el problema desde un punto de vista completamente diferente.

Y en la línea de "recurrir a otros algoritmos", os dejamos el enlace a este post ("Una IA capaz de detectar noticias falsas") de Think Big donde nos hablan de una startup, AdVerif.ai, que ha desarrollado un nuevo algoritmo de inteligencia artificial (IA) diseñado para detectar noticias falsas, malware y otro tipo de contenidos engañosos o problemáticos.

¿Y tú?¿Sabrías distinguir una “fake news”?

Cloud Híbrida

Cloud Híbrida Ciberseguridad & NaaS

Ciberseguridad & NaaS AI & Data

AI & Data IoT y Conectividad

IoT y Conectividad Business Applications

Business Applications Intelligent Workplace

Intelligent Workplace Consultoría y Servicios Profesionales

Consultoría y Servicios Profesionales Pequeña y Mediana Empresa

Pequeña y Mediana Empresa Sanidad y Social

Sanidad y Social Industria

Industria Retail

Retail Turismo y Ocio

Turismo y Ocio Transporte y Logística

Transporte y Logística Energía y Utilities

Energía y Utilities Banca y Finanzas

Banca y Finanzas Ciudades Inteligentes

Ciudades Inteligentes Sector Público

Sector Público