Paloma Recuero de los Santos

Especialista en generación de contenidos tecnológicos para los canales digitales de Telefónica Tech AI of Things. Licenciada en Ciencias Físicas y Máster en Tecnología Educativa. Apasionada por las “tecnologías para la vida”, las que nos hacen la vida más fácil (que no son todas) y por la pedagogía.

AI & Data

¿Cómo hablar a los niños sobre la Inteligencia Artificial?

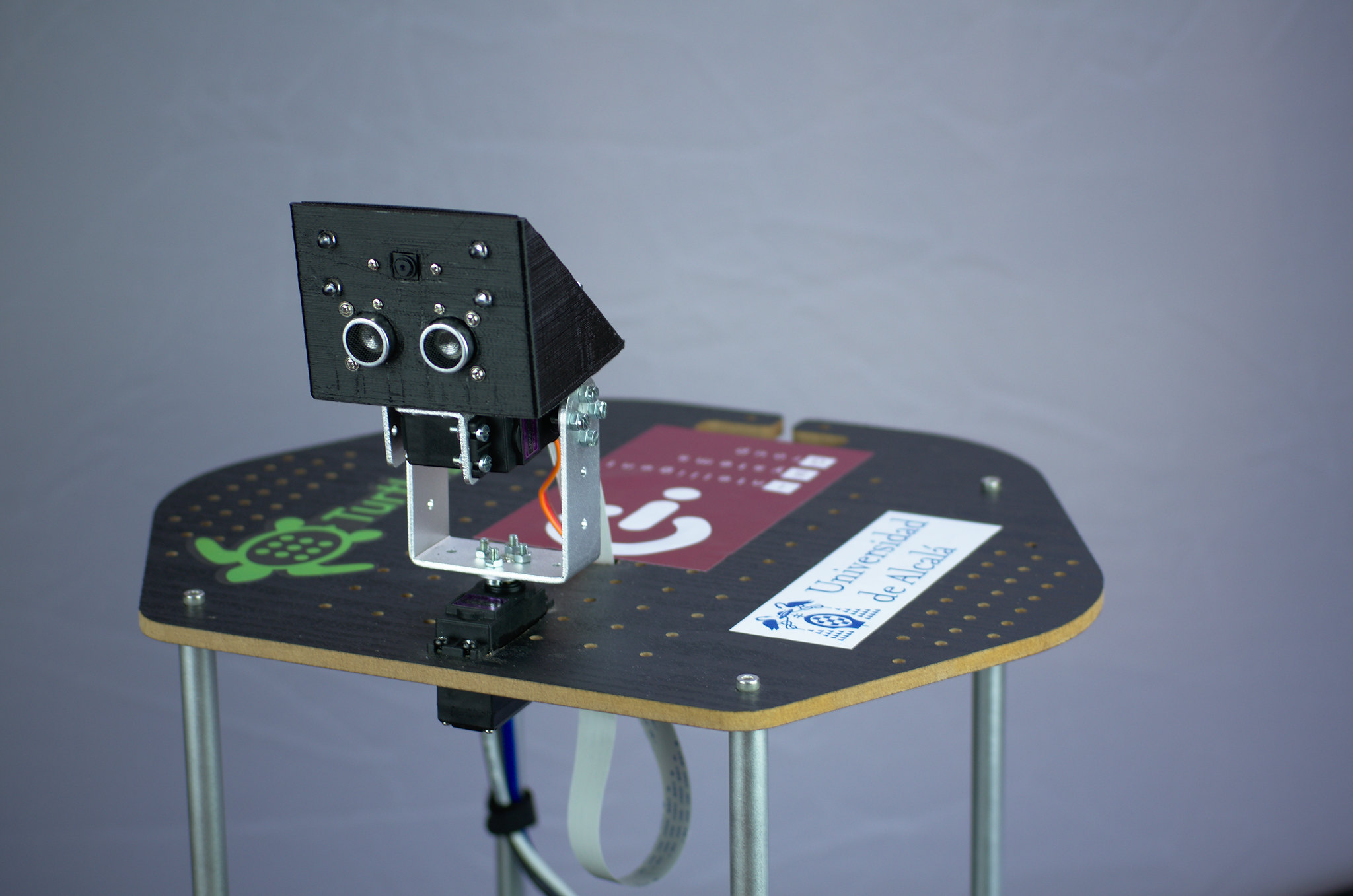

Desde la conocida como “generación de los constructores”, los nacidos entre 1925 y 1944, a los pequeños “alfa”, los hijos de los “millenials”, la tecnología ha ido ganando terreno e influencia sobre la vida de las personas. Ya no se trata de una herramienta de investigación o de producción. La "generación alfa”, los nacidos a partir de 2011, y antes que ellos, la “generación Z” (primera década del 2000), son ya auténticos nativos digitales. La Inteligencia Artificial, la realidad aumentada, los juegos de realidad virtual etc crean un contexto nuevo que, indudablemente, influirá en sus actitudes, hábitos y habilidades cognitivas. Pero este nuevo contexto implica también nuevos riesgos para los cuales los adultos podemos y debemos prepararles. En este post daremos algunas claves para hablar a los niños sobre la inteligencia artificial de forma que aprendan a disfrutar de sus ventajas, minimizando o al menos siendo conscientes de sus riesgos. Figura 1: Tabla de generaciones digitales La inteligencia artificial y los niños: el problema En épocas anteriores, la relación de las personas con la tecnología en general, y con la inteligencia artificial en particular, estaba basada en “texto”, normalmente usando lenguajes de programación especializados. Sin embargo, hoy, la inteligencia artificial ha aprendido a hablar e interpretar el lenguaje humano. Así, aunque hablemos con un asistente como si fuera una persona, y le digamos, “Siri, quiero un vídeo de Pepa Pig”, en ningún momento vamos a dudar de que Siri no es una persona. Sin embargo, se está viendo, que, para los pequeños de la generación alfa, los límites entre ellos mismos y la tecnología que les ha rodeado desde siempre, no están tan claros. Figura 2: “Siri, quiero un vídeo de Pepa Pig”, Sue Shellenbarger, columnista del Wall Street Journal, advierte que "muchos niños piensan que los robots son más inteligentes que los humanos o les otorgan poderes mágicos". Un estudio llevado a cabo en 2018 sobre el juguete-robot Cozmo, un juguete diseñado para aparentar “tener alma”, mostraba cómo niños entre 4 y 10 años, pensaban que el juguete era “más inteligente” que ellos, e incluso que era capaz de tener sentimientos. Figura 3: Robot Cozmo (fuente: amazon.com) En la promoción del juguete, Boris Sofman, uno de los fundadores de Anki, la compañía que los fabrica, afirmaba: “Si no juegas con Cozmo por una semana, te sentirás como si no hubieras jugado con tu perrito por una semana” ¿Cómo no se van a sentir confundidos los pequeños, cuando sus juguetes están diseñados de esta forma? Otros estudios muestran cómo niños entre 9 y 15 años se sentían emocionalmente vinculados a robots de aspecto humano, y pensaban que “podían ser sus amigos”; o bien, cambiaban sus respuestas a preguntas tipo ”¿está bien pegar a otros niños?” según “la opinión” de su muñeca. “Mi muñeca dice que “está bien”. La solución Como para casi todas las cosas, la mejor forma de ayudar a los pequeños a definir límites entre la tecnología y la realidad pasa por la educación. Investigadores del MIT están trabajando con niños de distintas edades para ver cómo podemos los adultos ayudarles a percibir la inteligencia artificial de forma correcta. Aunque parezca precipitado, y ciertamente lo es, cuatro años, son muy pocos, niños de esta edad ya eran capaces de comprender que, aunque el juguete les gane a un juego, no es más inteligente que ellos. El curso de ética de la IA del MIT Entre los 10 y 14 años, los niños empiezan a desarrollar pensamientos de alto nivel y lidiar con razonamientos morales complejos. Y también a esa edad, la mayoría disponen de telefónos inteligentes con todo tipo de aplicaciones basadas en IA. El MIT ha desarrollado un curso de ética de la IA para niños, en el que les enseña cómo funcionan los algoritmos basados en IA, y cómo puede haber intenciones determinadas tras las respuestas. Por ejemplo, aprenden por qué Instagram les muestra determinado anuncio, o por qué reciben una información y no otra en su app de noticias. También les retan a diseñar un “algoritmo” en forma de receta para el mejor bocadillo de mantequilla de cacahuete o juegan al bingo (AI Bingo). En definitiva, aprenden de un modo sencillo y divertido, que la tecnología, los robots, las computadoras… no son más que herramientas, rápidas, precisas, potentes, pero no hacen más que seguir los modelos, o los algoritmos con los que los hemos programado. Algunos consejos sencillos para ir poniendo en práctica Los adultos somos una referencia fundamental para los niños, especialmente los padres. Y, sin necesidad de hacer ningún curso del MIT (ni ellos ni nosotros), podemos ayudarles a comprender los límites de la IA con estos sencillos consejos propuestos por Sue Shellenbarger: No te refieras a los asistentes, robots, o juguetes basados en IA como si fueran personas Intenta transmitirles una imagen positiva sobre los beneficios de la IA en general. Nos hacen la vida más fácil en muchos aspectos. Despierta su curiosidad sobre cómo se diseñan y construyen los robots Ayúdales a entender que la "fuente" de la inteligencia de los dispositivos basados en IA son los humanos Plantéales aspectos éticos sobre el diseño de la IA con preguntas como: ¿Deberíamos construir robots que, (como intentamos enseñarles a ellos), sean corteses y pidan las cosas por favor, saluden, den las gracias etc? Fomenta su espíritu crítico respecto a la información que reciben a través de estos juguetes o dispositivos inteligentes; al igual que la recibida de redes sociales e internet. Ten mucho cuidado con los juguetes que se comercializan como el "mejor amigo" de un niño. Pueden llegar a crear dependencias no deseadas. Y lo más importante, intenta rebatir, siempre que surjan, ideas tipo "las máquinas son superiores a los humanos", "los robots acabarán con los humanos" etc, porque pueden resultar perjudiciales para las ingenuas mentes de los más pequeños.

30 de junio de 2022

AI & Data

Python para todos: ¿Por qué usamos números aleatorios ?

Continuamos hablando de "Python para todos". En esta ocasión, explicando por qué necesitamos poder generar números aleatorios para entrenar nuestros modelos de aprendizaje automático. ¿Qué son los números aleatorios? Un número aleatorio es un número obtenido al azar. El ejemplo clásico es lanzar una moneda, o un dado (no trucado). Cada cara de la moneda o del dato, tiene siempre la misma probabilidad de salir, independientemente del resultado anterior. O del resultado de lanzar el otro dado, si lanzamos simultáneamente dos de ellos. En general cuando se requiere una impredecibilidad en unos determinados datos, se utilizan números aleatorios. Números aleatorios y modelos Machine Learning En Ciencia de Datos, como en cualquier otra rama de la Ciencia, se construyen modelos que nos ayuden a representar la realidad o los fenómenos concretos que queremos estudiar. Pero esta realidad, y nosotros mismos, los seres humanos somos altamente impredecibles. Por ello, si queremos que nuestros modelos predictivos se aproximen a la realidad, deben funcionar como ésta: de forma aleatoria. Algunos ejemplos de este tipo de fenómenos son: Evolución del clima Resultado de unas elecciones Erupción del un volcán Evolución del desempleo Epidemias... etc Por tanto, en Machine Learning se trabaja a menudo con generadores de números aleatorios porque éstos permiten a los modelos matemáticos representar la realidad. Generación de números aleatorios Aunque sea tan sencillo como "lanzar un dado", cuando necesitas generar, por ejemplo, un millón de datos, hay que buscar alternativas más eficientes. ¿Por qué no generarlos por ordenador entonces? Esta es un pregunta interesante. Un ordenador es una máquina que repite, a gran velocidad eso sí, los pasos que le pedimos que haga. Sin embargo, es imposible generar algo impredecible en un ordenador. Uno de los primeros científicos interesados en este tema ,el físico John von Neumann, reconocía que la tarea en sí era imposible y acuñó la frase: "Aquel que trate de producir dígitos aleatorios mediante métodos aritméticos está, por supuesto, pecando". "Any one who considers arithmetical methods of producing random digits is, of course, in a state of sin" (John von Neumann) Recientemente han surgido alternativas interesantes, como basar la generación de números aleatorios en procesos físicos realmente impredecibles, como son los procesos cuánticos. Sin embargo, lo más habitual es "tirar por el camino de enmedio" y trabajar con números pseudoaleatorios, que se obtienen a partir de operaciones aritméticas, y se parecen mucho a los números aleatorios. No sirven para todos los casos, por ejemplo en ciberseguridad es muy importante que sean realmente aleatorios, pero para la mayoría de los problemas, funcionan. Una vez aclarado el porqué son necesarios los datos aleatorios en Machine Learning, ya sólo nos queda ponernos manos a la obra y aprender a generarlos en Python. Pero ésto, ya lo dejamos para el próximo post. ¡No te lo pierdas! AI OF THINGS Python para todos: 5 formas de generar datos aleatorios 8 de septiembre de 2020

23 de marzo de 2022

AI & Data

Python para todos: 5 formas de cargar datos para tus proyectos de Machine Learning

Uno de los primeros pasos que hay que dar cuando queremos crear un modelo de aprendizaje automático en Python es cargar los datos a partir de los cuales construiremos nuestro modelo. Hay distintas formas de llevar a cabo esta tarea, que dependerán del formato que tengan los datos, su ubicación o los recursos/librerías de Python que queramos utilizar. Empezaremos por lo más sencillo. Cargar de ficheros csv en Python. Se trata de uno de los formatos de datos más habituales. A la hora de cargar un fichero csv, deberemos tener en cuenta algunos detalles como: Su ubicación Si tienen cabecera o “header” Si tiene comentarios (señalados por medio de #) Qué tipo de delimitador utiliza (“,”, “/”, espacios en blanco etc) Lo primero que habrá que hacer, por tanto, es guardar los datos en nuestro directorio de trabajo. Comprobamos cuál es mediante el comando os.getcwd(). Si queremos cambiarlo, podemos usar el comando chdir(), ojo que tenemos que usar “\” dobles para especificar la nueva ruta: Una vez que tenemos claramente definido el directorio de trabajo, guardamos en él los datasets con los que vamos a trabajar en nuestros proyectos. Para cargar estos datos en Python podemos usar distintas opciones: Cargar los ficheros CSV usando el módulo CSV de la librería estándar de Python Cargar los ficheros CSV usando NumPy Cargar los ficheros CSV usando Pandas Cargar los ficheros desde la URL Cargar ficheros de pruebas desde librerías (Staatsmodels, etc) 1. Usando el módulo csv de la librería estándar Para extraer los datos de un fichero csv, primero lo "abrimos" con la función open(). Después, usamos la función, csv.reader(), que lee línea a línea el fichero, y hace una lista de todas las columnas en el objeto reader. Es mucho más sencillo hacerlo que explicarlo, así que mejor, lo vemos con un ejemplo. Hemos guardado, en nuestro directorio de trabajo, un dataset de ejemplo con datos sobre diabetes. 2. Usando NumPy Otra forma de cargar los datos es usando la función numpy.loadtxt() de la librería NumPy. Para ello, lo primero que tendremos que hacer es cargar la librería. Esta función asume que el fichero no tiene cabeceras, y que todos los datos tienen el mismo formato. Como no es el caso de nuestro dataset sobre diabetes, usaremos el modificador "skiprow" para indicar que no debe tener en cuenta la primera fila. En este ejemplo, también le hemos pedido que nos indique las dimensiones del dataset y nos muestre los datos. 3. Usando Pandas Esta tercera forma de cargar los datos es, probablemente, la más popular entre los científicos de datos como veremos, por muy buenas razones. En este caso, la función que usaremos es readcsv(). Esta función nos ofrece una gran flexibilidad a la hora de importar datos, ya que de forma automática, o con una simple línea de comando, permite hacer cosas como: Detectar automáticamente las cabeceras o "headers" "Saltar" líneas con el modificador "skiprow" Detectar automáticamente el tipo de datos (número entero, decimal, cadena de texto etc) Identificar campos con datos erróneos o vacíos Convertir los datos en formato csv en un dataframe de Pandas Los dataframes de Pandas son unas estructuras de datos diseñadas especialmente para facilitar el trabajo del analista y científico de datos. Permiten trabajar con datos de todo tipo (enteros, decimales, cadenas de texto) dispuestos en forma de tablas, incluso con series temporales. También se pueden usar como vectores y matrices, lo que permite realizar operaciones de álgebra lineal, como la multiplicación de matrices. Otro aspecto importante de pandas.read_csv() es que puede ejecutarse con la opción chunksize, que, en lugar de cargar el fichero de datos completo en memoria, permite hacerlo en fragmentos (chunks) de tamaño configurable, mejorando mucho la eficiencia en la carga de datos de ficheros muy grandes. Veamos un ejemplo. 4. Desde URL. Otra de las formas más habituales de cargar un dataset es directamente desde la URL donde se alojan los datos. Este método es perfectamente compatible con los anteriores. Por ejemplo, podemos modificar el ejemplo anterior, para que cargue los datos desde su ubicación original. 5. Desde otras librerías. Cuando lo que queremos es hacer una prueba rápida, nos pueden resultar muy útiles los datasets que traen "de serie" algunos de los paquetes más populares como statsmodels, scikit-learn, o seaborn. Se trata de conjuntos de datos de todo tipo "para hacer pruebas" que se conocen como "Toy datasets" y de los que hablaremos con más detalle en el próximo post. En el experimento que hicimos para explicar en qué consiste la regresión logística paso a paso, usamos uno de estos conjuntos de datos. En concreto, el dataset "affairs", de statsmodels. En este post, podéis ver cómo se cargan los datos desde la librería y, si os animáis, seguir el ejemplo completo, explicado paso a paso. Como veis, hay muchas formas distintas de cargar los datos. Aunque, según nos resulte más sencillo y cómodo, tendremos cada uno nuestra "favorita", es bueno conocer las otras alternativas por si nos surge algún caso en el que resulte conveniente cambiar de método. ¿Cuál es la tuya?

1 de febrero de 2022

AI & Data

Datos de entrenamiento vs datos de test

Los algoritmos de Machine Learning aprenden de los datos con los que los entrenamos. A partir de ellos, intentan encontrar o inferir el patrón que les permita predecir el resultado para un nuevo caso. Pero, para poder calibrar si un modelo funciona, necesitaremos probarlo con un conjunto de datos diferente. Por ello, en todo proceso de aprendizaje automático, los datos de trabajo se dividen en dos partes: datos de entrenamiento y datos de prueba o test. Datos de entrenamiento o "training data" Los datos de entrenamiento o "training data" son los datos que usamos para entrenar un modelo. La calidad de nuestro modelo de aprendizaje automático va a ser directamente proporcional a la calidad de los datos. Por ello las labores de limpieza, depuración o "data wrangling" consumen un porcentaje importante del tiempo de los científicos de datos. AI OF THINGS ¿La clave del éxito del Machine Learning? Datos de calidad 24 de abril de 2018 Datos de prueba, validación o "testing data" Los datos de prueba, validación o "testing data" son los datos que nos “reservamos” para comprobar si el modelo que hemos generado a partir de los datos de entrenamiento “funciona”. Es decir, si las respuestas predichas por el modelo para un caso totalmente nuevo son acertadas o no. Es importante que el conjunto de datos de prueba tenga un volumen suficiente como para generar resultados estadísticamente significativos, y a la vez, que sea representativo del conjunto de datos global. Normalmente el conjunto de datos se suele repartir en un 70% de datos de entrenamiento y un 30% de datos de test, pero se puede variar la proporción según el caso. Lo importante es ser siempre conscientes de que hay que evitar el sobreajuste u “overfitting”. (En este post, podéis ver un ejemplo en Python de cómo separar un conjunto de datos en datos de entrenamiento y validación). AI OF THINGS Python para todos (5): Termina tu primer experimento de Machine Learning con Python 16 de abril de 2018 Sobreajuste u "overfitting" El sobreajuste ocurre cuando un modelo está “sobre-entrenado”. Son modelos complejos que se ajusta tan milimétricamente al conjunto de datos a partir del cual se han creado, que pierden gran parte de su poder predictivo, y ya no son útiles para otros conjuntos de datos. Esto se debe a que los datos siempre tienen cierto grado de error o imprecisión, e intentar ajustarse demasiado a ellos, complica el modelo inútilmente al mismo tiempo que le resta utilidad. Lo entenderemos mejor con un ejemplo. Señal versus ruido En un conjunto de datos, hay patrones subyacentes que representan la señal que buscamos detectar. Sin embargo, también hay un componente de ruido o aleatoriedad. Un modelo de aprendizaje automático bien ajustado, es capaz de aprender de la señal e ignorar o minimizar el ruido. Figura 1: Ejemplo de sobreajuste- línea verde (fuente) La gráfica anterior representa un problema de clasificación binario. El modelo representado por la línea negra parece ser un buen predictor para nuevos casos. Si está a la derecha de la línea, será de clase "azul" y si está a la izquierda, "rojo". Por el contrario, la línea verde representa un modelo sobreajustado porque ha aprendido del "ruido". Como indicamos antes, es un modelo inútilmente complejo, ya que aunque su rendimiento sea mejor para este conjunto de datos en particular, no será "exportable" a otros conjuntos de datos. Subajuste o underfitting El underfitting o subajuste es justamente el caso contrario. Ocurre cuando el conjunto de datos de entrenamiento es insuficiente, con ruido en alguna de sus dimensiones o, en definitiva, poco representativo. Como consecuencia, nos lleva a un modelo excesivamente simple, con poco valor predictor. Por ello, para generar un buen modelo de aprendizaje automático, es importante encontrar el punto medio entre ambas tendencias. Otra forma de expresar este equilibrio es mediante los conceptos de "Bias vs Varianza". En este otro post de nuestro blog, os explicamos en detalle en qué consisten estos conceptos y cómo conseguir ese punto de equilibrio (sweet spot) que nos garantice un modelo fiable. AI OF THINGS ¿Qué es overfitting y cómo evitarlo? 8 de abril de 2019 Conclusión La partición de los datos de trabajo en estos dos conjuntos diferenciados permite generar el modelo a partir de los datos de entrenamiento para después comprobar su eficiencia con los datos reservados para test. Los resultados de cualquier modelo basado en aprendizaje automático tienen una gran dependencia de los datos a partir de los cuales se han generado. Por ello, es fundamental cuidar su calidad y buscar siempre el equilibrio entre bias y varianza.

24 de enero de 2022

AI & Data

Cómo interpretar la matriz de confusión: ejemplo práctico

La matriz de confusión es una herramienta muy útil para valorar cómo de bueno es un modelo clasificación basado en aprendizaje automático. En particular, sirve para mostrar de forma explícita cuándo una clase es confundida con otra, lo cual nos, permite trabajar de forma separada con distintos tipos de error. En un post anterior de nuestro blog, explicamos detalladamente el concepto de matriz de confusión y sus métricas asociadas. Hoy planteamos un sencillo ejemplo de apliación. AI OF THINGS Machine Learning a tu alcance: La matriz de confusión 23 de enero de 2018 Recordando nuestro "experimento" de predicción de infidelidad Rescatamos para este post uno de nuestros experimentos anteriores. En concreto el de hicimos para explicar el algoritmo de regresión logística. AI OF THINGS Especial San Valentin: ¿Podemos predecir la infidelidad con Inteligencia Artificial? 14 de febrero de 2019 Si recordamos, trabajamos con el dataset “affairs”, basado en en una encuesta realizada por la revista Redbook en 1974, en la que se preguntaba a mujeres casadas por sus aventuras extramaritales. Este dataset, que cargamos desde la librería Staatsmodel, constaba de 6366 observaciones con 9 variables, de tipo "valoración de su matrimonio", "años de casada", "número de hijos", "nivel de estudios" etc. Figura 1: Descripción del dataset affairs Objetivo del modelo El objetivo era crear un modelo que predijera si un individuo (en este caso, mujer) iba a ser “fiel” o “infiel”, basándose en el valor de esas 9 variables para el nuevo caso y en lo “aprendido” por el modelo a partir de los datos de entrenamiento (los datos de la encuesta). Regresión logística En este ejemplo, aplicamos el modelo de regresión logística de scikit-learn. Se trata de un modelo de probabilidad lineal, en el que la probabilidad condicionada es función lineal de los valores de las variables de entrada. Por tanto, obtenemos la probabilidad de que la variable dependiente tenga un valor categórico u otro (en nuestro ejemplo o “infidelity”= 0, o “infidelity”= 1), en función de los valores de las variables de entrada. Evaluación del modelo Llegado el momento de evaluar el modelo, es cuando vamos a echar mano de la matriz de confusión. Para ello, dividimos el dataset en dos partes. Dejamos un 75% de los datos como datos de entrenamiento (train), y reservamos el 25% restando como datos de prueba (test). A continuación, entrenamos el modelo de nuevo, pero ahora sólo con los datos de entrenamiento. AI OF THINGS Datos de entrenamiento vs datos de test 24 de enero de 2022 En el siguiente paso, lo aplicamos a los datos reservados como “test”, y ya evaluamos su rendimiento, calculando la matriz de confusión y las métricas exactitud (Accurary) y precisión (Precision). Figura 2: Cálculo de la matriz de confusión y métricas Para mayor claridad, visualizamos la matriz de confusión en forma de mapa de calor. Figura 3: Matriz de confusión en forma de mapa de calor (ampliar) Matriz de confusión Merece la pena pararnos un momento a recordar el significado de la matriz de confusión y sus métricas asociadas, antes de pasar a interpretarla en nuestro ejemplo. Figura 4: Matriz de confusión y métricas asociadas (ampliar) Los valores de la diagonal principal a=993 y d=176 se corresponden con los valores estimados de forma correcta por el modelo, tanto los verdaderos positivos_ TP(d), como los verdaderos negativos_TN (a). La otra diagonal, por tanto, representa los casos en los que el modelo "se ha equivocado (c=316 falsos negativos_FN, b=107 falsos positivos_FP). Exactitud Si recordamos, la exactitud (o "accuracy") representa el porcentaje de predicciones correctas frente al total. Por tanto, es el cociente entre los casos bien clasificados por el modelo (verdaderos positivos y verdaderos negativos, es decir, los valores en la diagonal de la matriz de confusión), y la suma de todos los casos. Sin embargo, cuando un conjunto de datos es poco equilibrado, no es una métrica útil. Por ejemplo, si lo que intentamos predecir es una enfermedad rara, y nuestro algoritmo clasifica a todos los individuos como sanos, podría ser muy preciso (incluso un 99%), pero también, totalmente inútil. Por ello, en estos casos se suele recurrir a otras métricas, como la sensibilidad (o recall), que representa la habilidad del modelo de detectar los casos relevantes, y que veremos un poco más adelante. (El valor obtenido para este modelo es de un 73%. No es maravilloso, pero podemos considerarlo aceptable). Para calcularlo a mano, a partir de la matriz de confusión: (993+176)/(993+176+107+316)=1169/1592= 0,73—73% Precisión La precisión, (o“precision”) se refiere a lo cerca que está el resultado de una predicción del valor verdadero. Por tanto, es el cociente entre los casos positivos bien clasificados por el modelo y el total de predicciones positivas. Para calcularlo a mano, a partir de la matriz de confusión: (176)/(176+107)= 0,62— 62% El valor obtenido para este modelo es de un 62%. Por tanto, nuestro modelo es más preciso que exacto. Sigamos con otras métricas. Sensibilidad, exhaustividad La sensibilidad (o recall) representa la tasa de verdaderos positivos (True Positive Rate) ó TP. Es la proporción entre los casos positivos bien clasificados por el modelo, respecto al total de positivos. Para calcularlo en este caso: 176/(316+176)=0,35— 35% Representa, como hemos dicho antes, la habilidad del modelo de detectar los casos relevantes. Un 35% es claramente un valor muy malo para una métrica. Podemos decir que nuestro algoritmo de clasificación es poco sensible, "se le escapan" muchos positivos. Especifidad La especificidad, por su parte, es la tasa de verdaderos negativos, (“true negative rate”)o TN. Es la proporción entre los casos negativos bien clasificados por el modelo, respecto al total de negativos. Para calcularlo a mano, a partir de la matriz de confusión: 993/(993+107)=0,90 —90% En este caso, la especificad tiene un valor muy bueno. Esto significa que su capacidad de discriminar los casos negativos es muy buena. O lo que es lo mismo, es difícil obtener falsos positivos. ¿Qué métrica elegir? La conveniencia de usar una métrica otra como medida del estimador dependerá de cada caso en particular y, en concreto, del “coste” asociado a cada error de clasificación del algoritmo. En este ejemplo, la sensibilidad=0,35 y la especifidad=0,90. Por tanto, este modelo mucho más específico que sensible. Esta es la situación que nos interesa cuando nuestro objetivo es evitar a toda costa los falsos positivos. Un ejemplo típico sería una prueba de dopping en un deportista. Si un falso positivo significa expulsarle de la competición injustamente, debemos evitar esta situación. En nuestro ejemplo sobre infidelidad, podemos decir que nuestro modelo evitaría "acusaciones injustas" ;) Si lo que nos interesa es identificar los verdaderos negativos, (evitar falsos positivos) debemos elegir especifidad alta. Por el contrario, si las "falsas alarmas" no nos preocupan, y lo que queremos evitar son los falsos negativos, nos interesa una mayor sensibilidad o recall. Por ejemplo, no nos importa un falso positivo en una prueba de diabetes, ya que, indudablemente, la prueba se repetirá. Sin embargo, no nos interesa que una persona diabética no diagnosticada, no acceda rápidamente al tratamiento adecuado debido a un falso negativo. Si lo que nos interesa es evitar falsos negativos, debemos elegir sensibilidad alta. Conclusión Este pequeño experimento, evidentemente, no tiene mayor utilidad que la de ayudarnos a aprender cómo funciona el algoritmo de regresión logística o cómo interpretar la matriz de confusión. Un modelo no vale nada, si los datos sobre los que se ha entrenado no tienen ni el volumen ni la calidad suficientes (como en este ejemplo). Sin embargo, como vemos, la mejor manera de aprender es...¡haciendo! Para ello, no te pierdas nuestra colección de tutoriales sobre IA y Big Data.

13 de diciembre de 2021

AI & Data

Tipos de aprendizaje en Machine Learning: supervisado y no supervisado

El machine Learning o aprendizaje automático consiste básicamente en automatizar, mediante distintos algoritmos, la identificación de patrones o tendencias que se “esconden” en los datos. Por ello, resulta muy importante no sólo la elección del algoritmo más adecuado (y su posterior parametrización para cada problemática concreta), sino también el hecho de disponer de un gran volumen de datos de suficiente calidad. En los últimos años, el machine learning ha cobrado una gran importancia en el mundo de los negocios, ya que el uso inteligente de las analíticas de datos es clave para el éxito empresarial. En este post vamos a explicar en qué consiste el aprendizaje automático, que tipos de aprendizaje hay, cómo funcionan y para qué se utilizan. Realmente, ¿qué es Machine learning? Es una rama de la inteligencia artificial que empezó a cobrar importancia a partir de los años 80. Se trata de un tipo de IA que ya no depende de unas reglas y un programador, sino que la computadora puede establecer sus propias reglas y aprender por sí misma. El aprendizaje automático se produce por medio de algoritmos. Un algoritmo no es más que una serie de pasos ordenados que se dan para realizar una tarea. El objetivo del machine learning es crear un modelo que nos permita resolver una tarea dada. Luego se entrena el modelo usando gran cantidad de datos. El modelo aprende de estos datos y es capaz de hacer predicciones. Según la tarea que se quiera realizar, será más adecuado trabajar con un algoritmo u otro. La elección del algoritmo no es fácil. Si buscamos información en internet, podemos encontrar con un auténtica avalancha de artículos muy detallados, que a veces, más que ayudarnos, nos confunden. Por ello, vamos a intentar dar algunas pautas básicas para empezar a trabajar. AI OF THINGS Empieza ya a programar Inteligencia Artificial: lenguajes, herramientas y recomendaciones 18 de enero de 2023 Hay dos preguntas fundamentales que nos debemos plantear. La primera es: ¿Qué queremos hacer? El quid de la cuestión es definir de forma clara el objetivo. Para resolver nuestro problema, pues, nos plantearemos qué tipo de tarea es la que tendremos que acometer. Puede tratarse, por ejemplo, de: Problemas de clasificación como detección de correo basura o “spam”. Problemas de clustering como recomendar un libro a un usuario basándonos en sus compras anteriores (sistema de recomendación) f Problemas de regresión, como averiguar cuánto va usar un cliente determinado servicio (determinar un valor) Si consideramos el clásico problema de retención de clientes, vemos que podemos abordarlo desde distintos enfoques. Queremos hacer una segmentación de clientes, sí, pero ¿qué estrategia es la más adecuada? ¿Es mejor tratarlo como problema de clasificación, clustering o incluso regresión? La pista clave nos la va a dar plantearnos la segunda pregunta. ¿Qué información tengo para conseguir mi objetivo? Si yo me pregunto: "Mis clientes, ¿se agrupan de alguna manera, de forma natural?", no he definido ningún objetivo (target) para el agrupamiento. Sin embargo, si planteo la pregunta de esta otra forma: ¿Podemos identificar grupos de clientes con una alta probabilidad de solicitar la baja del servicio en cuanto finalice su contrato?, tenemos un objetivo perfectamente definido: ¿se dará de baja el cliente?, y queremos tomar medidas según la respuesta que obtengamos. En el primer caso, nos encontramos ante un ejemplo de aprendizaje no supervisado, mientras que el segundo lo es de aprendizaje supervisado. En las fases iniciales del proceso de Data Science, es muy importante decidir si la “estrategia de ataque” será supervisada o no supervisada, y en éste último caso definir de forma precisa cuál va a ser la variable objetivo. Según decidamos, trabajaremos con una familia de algoritmos o con otra. Una vez identificado lo anterior, se emplearán algoritmos prefijados para que se pueda escoger con cual trabajar. Entre los más conocidos se tienen: scikit-learning, machine learning algorithm cheat see, entre otros. Figura 2: "Chuleta" de selección de algoritmo de Scikit-learn. Tipos de Machine Learning Los tipos de implementación de machine Learning pueden clasificarse en tres categorías diferentes: Aprendizaje supervisado Aprendizaje no supervisado Aprendizaje de refuerzo según la naturaleza de los datos que recibe. Aprendizaje Supervisado En el aprendizaje supervisado, los algoritmos trabajan con datos “etiquetados” (labeled data), intentado encontrar una función que, dadas las variables de entrada (input data), les asigne la etiqueta de salida adecuada. El algoritmo se entrena con un “histórico” de datos y así “aprende” a asignar la etiqueta de salida adecuada a un nuevo valor, es decir, predice el valor de salida. (Simeone, 2018) Por ejemplo, un detector de spam, analiza el histórico de mensajes, viendo qué función puede representar, según los parámetros de entrada que se definan (el remitente, si el destinatario es individual o parte de una lista, si el asunto contiene determinados términos etc), la asignación de la etiqueta “spam” o “no es spam”. Una vez definida esta función, al introducir un nuevo mensaje no etiquetado, el algoritmo es capaz de asignarle la etiqueta correcta. El aprendizaje supervisado se suele usar en: Problemas de clasificación (identificación de dígitos, diagnósticos, o detección de fraude de identidad). Problemas de regresión (predicciones meteorológicas, de expectativa de vida, de crecimiento etc). Estos dos tipos principales de aprendizaje supervisado, clasificación y regresión, se distinguen por el tipo de variable objetivo. En los casos de clasificación, es de tipo categórico, mientras que, en los casos de regresión, la variable objetivo es de tipo numérico. Los algoritmos más habituales que aplican para el aprendizaje supervisado son: Árboles de decisión. Clasificación de Naïve Bayes. Regresión por mínimos cuadrados. Regresión Logística. Support Vector Machines (SVM). Métodos “Ensemble” (Conjuntos de clasificadores). Aprendizaje no Supervisado El aprendizaje no supervisado tiene lugar cuando no se dispone de datos “etiquetados” para el entrenamiento. Sólo conocemos los datos de entrada, pero no existen datos de salida que correspondan a un determinado input. Por tanto, sólo podemos describir la estructura de los datos, para intentar encontrar algún tipo de organización que simplifique el análisis. Por ello, tienen un carácter exploratorio. Por ejemplo, las tareas de clustering, buscan agrupamientos basados en similitudes, pero nada garantiza que éstas tengan algún significado o utilidad. En ocasiones, al explorar los datos sin un objetivo definido, se pueden encontrar correlaciones espúreas curiosas, pero poco prácticas. El aprendizaje no supervisado se suele usar en: Problemas de clustering Agrupamientos de co-ocurrencias Perfilado o profiling. Si embargo, los problemas que implican tareas de encontrar similitud, predicción de enlaces o reducción de datos, pueden ser supervisados o no. Los tipos de algoritmo más habituales en aprendizaje no supervisado son: 1. Algoritmos de clustering 2. Análisis de componentes principales 3. Descomposición en valores singulares (singular value decomposition) 4. Análisis de componentes principales (Independent Component Analysis) ¿Entonces, qué es el aprendizaje por refuerzo? No todos los algoritmos ML se pueden clasificar como algoritmos de aprendizaje supervisado o no supervisado. Hay una "tierra de nadie" que es donde encajan las técnicas de aprendizaje por refuerzo. Este tipo aprendizaje se basa en mejorar la respuesta del modelo usando un proceso de retroalimentación. El algoritmo aprende observando el mundo que le rodea. Su información de entrada es el feedback o retroalimentación que obtiene del mundo exterior como respuesta a sus acciones. Por lo tanto, el sistema aprende a base de ensayo-error. No es un tipo de aprendizaje supervisado, porque no se basa estrictamente en un conjunto de datos etiquetados, sino en la monitorización de la respuesta a las acciones tomadas. Tampoco es un aprendizaje no supervisado, ya que, cuando modelamos a nuestro "aprendiz"sabemos de antemano cuál es la recompensa esperada. Si quieres saber más sobre tipos de aprendizaje, no te pierdas este otro post, donde explicamos qué es el aprendizaje por transferencia. Usos prácticos del Machine learning Para terminar, veamos algunos de los usos prácticos mas habituales del aprendizaje automático. Seguridad informática, diagnóstico de ataques, prevención de fraude online, detección de anomalías, etc. Reconocimiento de imágenes o patrones (facial, dactilar, objetos, voz, etc) Conducción autónoma, mediante algoritmos deep learning: identificación de imágenes en tiempo real, detección de obstáculos y señales de tráfico, prevención de accidentes... Salud: evaluación automática de pruebas diagnósticas, robótica médica etc Análisis de mercado de valores ( predicciones financieras, evolución de mercados etc) Motores de recomendación Es fundamental tener claro en todo momento los objetivos buscados por la empresa a la hora de utilizar estas técnicas, para poder plantear las preguntas adecuadas a los datos. Y, por supuesto, trabajar siempre con datos de calidad. Simeone, O. (2018). A Very Brief Introduction to Machine Learning With Applications to Communication Systems. Repositorio Universidad de Cornell. Computerworld. (2019). Tendencias tecnológicas para 2020: las apuestas de Gartner.

2 de diciembre de 2021

AI & Data

Tutorial Power BI: ¿De donde vienen los nuevos madrileños?

Si quieres aprender a visualizar datos con Power BI, la mejor manera es ponerse manos a la obra y trabajar sobre un ejemplo. En un post anterior ya explicamos cómo instalar la herramienta y trabajamos sobre un conjunto de datos publicado en el portal de datos abiertos de Londres. Primeros pasos: instalamos la herramienta AI OF THINGS Ciudades Inteligentes: Tutorial de Power BI sobre Open Data 24 de abril de 2017 Descargamos los datos. En esta ocasión, nos hemos planteado investigar sobre el origen de los "nuevos madrileños". Para ello, vamos a trabajar sobre un conjunto de datos que recoge los nacimientos producidos en la ciudad de Madrid por nacionalidad/origen de la madre, publicado en el portal de datos abiertos de la Comunidad de Madrid. Analizando estos datos, vamos a poder dar respuesta a preguntas del tipo: ¿En qué distritos/barrios se producen más nacimientos y cuáles menos? ¿Cuáles son las raíces de estos "nuevos madrileños"?¿de qué región española o país proceden sus madres? En este ejemplo, hemos descargado directamente el csv (botón rojo), pero también hay disponible una API de datos. El asistente nos ofrece ejemplos sencillos sobre cómo cargar los datos en Python, o ejemplos de consultas SQL y Ajax. Figura 1: Dataset de trabajo, descargable desde el portal de datos abiertos de la Comunidad de Madrid Exploramos los datos. Lo primero, como siempre, es echarle un vistazo preliminar al conjunto de datos. Nos interesa conocer aspectos como el número de registros disponibles, quién creó el dataset, cuándo, bajo qué licencia, con qué frecuencia se actualizan etc. Toda esta información está en la ficha de los datos. Figura 2: Información adicional de la ficha de datos. También necesitamos conocer la descripción de los campos o variables del conjunto de datos, en qué formato están, de dónde proceden los datos, Para ello, consultamos el "Dicccionario de datos". En este conjunto de datos tenemos información, desagregada por distrito y barrio , sobre niños y niñas nacidos en el Municipio de Madrid . También se indica la nacionalidad u origen de la madre. Las madres nacidas en el extranjero se agrupan en la provincia 66 denominada "Extranjero". En la categoría "No consta" se incluyen tanto las que no se sabe si han nacido en España o el extranjero, como las que sabiendo que han nacido en España no se sabe en qué provincia lo hicieron. Los datos proceden de la última explotación del Movimiento Natural de la Población. Cargamos los datos en Power BI. Cargamos el csv en la herramienta. Si la usas por primera vez, no dejes de leer el post que hemos indicado al principio, donde estos pasos se describen con todo detalle. Figura 4: Carga de datos en Power BI ¿Cuántos nacimientos hubo en Madrid capital en 2018? Una de las primeras preguntas que podemos hacerlos es: ¿Cuántos niños nacieron en Madrid en 2018? ¿Nacieron más niños o más niñas?. Para responder a estas preguntas, podemos simplemente visualizar, en una tabla, los campos "Número de nacimientos" y "sexo". Figura 5: Visualización del número de nacimientos y sexo del bebé en una tabla Obtenemos: Figura 6: Número de nacimientos por sexo del bebé. Para calcular los porcentajes, no tenemos más que cambiar a la visualización de "pie chart" o bien la "gauge", seleccionar el modo "Focus" para verlo mejor y pasar el ratón por cada sector de la los sectores. Figura 7: Visualización de la distribución de nacimientos por sexo. (Tamaño real) Como era de esperar, los porcentajes están muy igualados, aunque, en este caso, nacieron más varones, con un 48,62% de niñas frente a un 51, 38 de niños. ¿En qué distritos nacieron más niños ? Para saber en qué distritos/barrios han tenido lugar más nacimientos, agregamos el campo "nombre de distrito" a nuestros datos de trabajo. Figura 8: Agregamos campos distrito-barrio. En este caso, por ejemplo, la visualización de "line and clustered column chart" (gráfico de líneas y columnas agrupadas) nos permite apreciar, de un vistazo, la gran diferencia entre distritos. Seleccionamos la opción "Data Labels on" en el menú "Formato" para que indique el valor de referencia. (Pulsar "tamaño real" , en el pie de imagen para verlas a mayor tamaño) Figura 9: Visualización del número de nacimientos por distrito. (tamaño real) Modificamos las visualizaciones según nuestras preferencias. Podemos, por ejemplo, ordenarlos de mayor a menor, usando el menú "más opciones", que aparece en la esquina superior derecha: Figura 10: Menú "mas opciones" O cambiar el color, tipo de letra, tamaño, títulos etc. usando el menú "Formato": Figura 11: Menú formato Figura 10: Visualización del número de nacimientos por distrito de mayor a menor (tamaño real) O bien usar otra visualización diferente, como por ejemplo, el diagrama de árbol ("treemap"): Figura 11: Visualización del número de nacimientos por distrito diagrama árbol (tamaño real) En todas ellas se puede apreciar que el distrito de Fuencarral-El Pardo, con 2521 nacimientos, es aquel donde han nacido más niños, mientras que el de Barajas, con 490, es donde menos. Saltamos al siguiente nivel ("drill down") Pulsando la flecha que aparece en la esquina superior derecha activamos el "Drill down" que nos permite "profundizar" un nivel. Podemos seleccionar un distrito concreto, haciendo click sobre la columna que lo representa y pasamos a ver la distribución de nacimientos por barrios. Por ejemplo, si seleccionamos el distrito de Retiro, vemos la siguiente distribución. Puede ser interesante comparar esta distribución de nacimientos por barrios con la correspondiente a otros distritos de Madrid. En este caso, hemos escogido los distritos de Centro, Fuencarral y Puente de Vallecas. Se aprecia una gran diferencia entre barrios en prácticamente todos los distritos, lo que sugiere que es importante bajar hasta este nivel para asegurarse de que los recursos lleguen a los ciudadanos que los necesitan. Nacimientos por barrios en Centro Nacimientos por barrios en Fuencarral Nacimientos por barrios en Puente de Vallecas Nacimientos por barrios en Retiro Por ejemplo, es fácil ver que la mayor parte de los nacimientos en el distrito de Retiro corresponden al popular barrio de Pacífico. (Podríamos incluso bajar un nivel más y ver, dentro de cada barrio, el número de nacimientos que corresponden a cada sexo, pero en este caso, no aportaría información relevante). Esta información es de gran importancia a la hora de valorar qué inversiones son precisas para proveer a estos nuevos madrileños de las instalaciones y servicios necesarios. Hablamos de temas tan importantes como escuelas infantiles, colegios, profesores, pediatras, zonas verdes, bibliotecas, servicios sociales, instalaciones deportivas etc. Por ello, también nos podría interesar averiguar qué porcentaje de nacimientos corresponde a cada barrio. Una forma muy rápida de verlo es cambiar el tipo de gráfico, y seleccionar el diagrama de sectores o "pie chart". Al pasar el cursor sobre cada sector, nos indica el número de nacimientos por barrio y el porcentaje que supone respecto del total. También, desde el menú "Formato" /Etiquetas de detalles/Estilo de etiqueta se puede elegir que el porcentaje aparezca de forma explícita. El barrio de Valverde, en Fuencarral, por ejemplo, supone un 33,68% del total. Porcentaje de nacimientos por barrio en Fuencarral Porcentaje de nacimientos por barrio en Latina Porcentaje de nacimientos por barrio en Puente de Vallecas Figura 11: Porcentaje de nacimientos por barrio. ¿Cuál es el origen de las madres? Para contestar a esta pregunta, agregamos un nuevo campo de datos. En particular el campo " provincia de nacimiento de la madre". Su valor puede ser cualquier provincia española, "nació en el extranjero", o "no consta" . Si queremos ver, "grosso modo" el origen de las madres, nos sirve el mismo diagrama de sectores o "pie chart" una vez agregado el nuevo campo. Figura 12: Nacimientos según el origen de la madre (tamaño real) Así, podemos ver que, de un total de 29.032 nacimientos, un 43,76% de las madres eran originarias de Madrid. Del resto, un 21,01% procedían de otras provincias españolas, y un 34,13% del extranjero. Los datos corresponden sólo a los nacimientos producidos en Madrid en 2018 y para ser precisos, habría que considerar un conjunto de datos más amplio que abarcara un intervalo temporal más amplio. Ya que no tenemos datos de nacionalidades, podemos filtrar por los campos "Origen Madrid, Extrajero y no consta", podemos ver de qué provincias españolas proceden las madres. Podemos elegir, por ejemplo, un diagrama de barras agrupadas ("clustered bar chart"), en el que resulta muy sencillo ver que Barcelona, Asturias y Toledo son las provincias que más pequeños "nuevos madrileños" han aportado, con 307, 296 y 273 nacimientos respectivamente. Y Ceuta, Teruel y Lérida, las que menos, con 10. Figura 13: Nacimientos por provincia (tamaño real) Conclusiones. Hemos visto lo sencillo que es visualizar información a partir de conjuntos de datos públicos con la herramienta Power BI. A la hora de sacar conclusiones, no hay que olvidar que los datos se refieren a los nacimientos producidos en Madrid en 2018. No podemos extrapolar directamente conclusiones sobre la composición de la población madrileña. Para ello, habría que considerar periodos de varios años, o considerar otras fuentes de datos. Por ejemplo, censales, de la seguridad social, sistema educativo etc. Lo que es evidente, es que los datos son la mejor herramienta con la que contamos para conocer las necesidades de la población y gestionar los recursos disponibles de la forma más eficiente. Con este objetivo, el Ayuntamiento de Madrid lanzó un concurso para diseñar un sistema capaz de sistematizar de forma consistente la valoración de las necesidades de los barrios. La herramienta, desarrollada por la Universidad Carlos III, se basa en el análisis jerarquizado de 12 parámetros agrupados en 5 categorías que permiten detectar situaciones de vulnerabilidad en los barrios. De esta forma, los datos se convierten en una poderosa herramienta en pro de la igualdad. Lo que sí podemos afirmar, tras este pequeño "ejercicio" es el hecho de que Madrid, pese a todos los problemas propios de una gran ciudad, es una ciudad abierta, y acogedora, donde personas de orígenes muy diversos pueden sentirse tan a gusto como los auténticos "gatos". Para mantenerte al día con el área de Internet of Things de Telefónica visita nuestra página web o síguenos en Twitter, LinkedIn y YouTube

4 de mayo de 2021

AI & Data

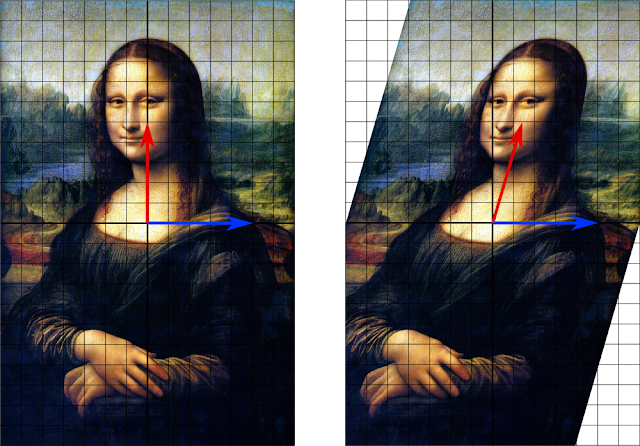

Deep Learning para predecir la calidad del aire

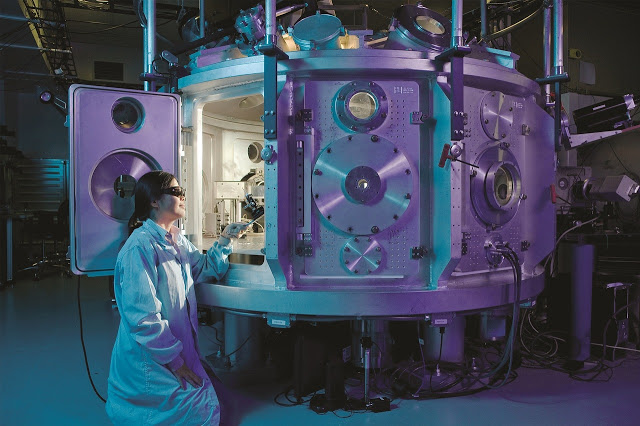

La contaminación atmosférica por gases procedentes de combustibles fósiles genera graves problemas de salud a los habitantes de las ciudades. Por ello, la creación de modelos predictivos que permitan estimar los niveles de calidad del aire en un lugar, momento y condiciones dadas resulta de gran interés. Pero no es una tarea fácil. Veamos cómo el Deep Learning puede a superar estas dificultades. El problema Las principales agencias encargadas de la protección de la salud y del medio ambiente -como la OMS, la Agencia Europea de Medio Ambiente o la Agencia de Protección Ambiental de los EEUU (EPA), afirman que la inhalación de contaminantes, especialmente de las partículas de menor tamaño, incrementa el riesgo de daños pulmonares permanentes y muerte prematura. A pesar de la gravedad de sus efectos, tanto a corto como a largo plazo, las observaciones existentes sobre contaminación no son adecuadas para planificar estrategias de protección a la población vulnerable con suficiente antelación. ¿Por qué resulta tan complicado? El problema principal radica en cómo combinar las dos fuentes de datos principales. Por un lado, las observaciones por satélite, que permiten medir la contaminación atmosférica en un lugar determinado a la misma hora cada día, pero no pueden medir cómo varían las emisiones a horas distintas. Por otro lado, las estaciones meteorológicas terrestres, que recogen datos de forma continuada, pero sólo en un número limitado de ubicaciones. Sensores satelitales El Sentinel-5p (p de precursor) es un satélite de monitorización atmosférica que, mediante instrumentos como el TROPOMI y UVNS, permite monitorizar la distribución de componentes atmosféricos como: ozono (O3), dióxido de nitrógeno (NO2), dióxido de azufre (SO2), formaldehidos (HCHO), monóxido de carbono (CO) y metano (CH4), o el espesor óptico de aerosoles (AOD). (los datos de los satélites Sentinel son siempre gratuitos y de acceso libre para todos los usuarios y, por supuesto, preferente para los servicios Copernicus). En particular, TROPOMI, el espectrómetro de imágenes multiespectrales fue desarrollado conjuntamente por la ESA y la Oficina Espacial de los Países Bajos. Proporciona una medición de la calidad del aire troposférico de alta resolución espacial (~5 km) que capta la variabilidad espacial de la contaminación del aire. En la imagen, podemos ver como ejemplo una visualización de la variación en la concentración de dióxido de nitrógeno sobre China. Gif: Concentración de dióxido de nitrógeno sobre China (ESA (CC BY-SA 3.0 IGO) ) Estaciones terrestres AirNow es una asociación que unifica datos procedentes de diferentes asociaciones gubernamentales de EEUU, y datos procedentes de sus embajadas y consulados en todo el mundo con el objeto de poner a disposición del investigadores, empresas y publico en general datos de calidad sobre contaminación atmosférica. Las estaciones de AirNOW, ofrecen observaciones horarias de los niveles de dióxido de nitrógeno (NO2) a nivel del suelo. Sin embargo, se trata de mediciones discretas, procedentes de las distintas estaciones terrestres asociadas al programa. Los niveles de dióxido de nitrógeno varían mucho durante el día. Por ello, resultaría muy interesante comparar las observaciones a nivel de superficie con las registradas por satélite, para así poder elaborar estimaciones con mayor resolución espacial y temporal. Lo ideal sería disponer de medidas a escala suburbana cada hora. Deep Learning para medir contaminación atmosférica En un estudio publicado en Science Direct, los investigadores Manzhu Yu y Qian Liu aplican algoritmos de aprendizaje profundo (Deep Learning) para integrar las observaciones horarias de NO2 a nivel del suelo, con las observaciones de la columna de NO2 troposférica recogidas por TROPOMI. Para ello, trabajaron con datos de la ciudad de Los Ángeles, donde los altos niveles de NO2 se deben, principalmente a emisiones del tráfico y de las centrales eléctricas. ¿Por qué usar Deep Learning? El deep learning o aprendizaje profundo es, por tanto, un subcampo dentro del Machine Learning que utiliza redes neuronales para obtener representaciones cada vez más significativas de los datos mediante el aprendizaje por capas. Cada una de estas capas va extrayendo características de un nivel cada vez más alto hasta llegar a su respuesta final. Es por ello, que el deep learning es especialmente apropiado para detectar patrones a partir de grandes volúmenes de datos, incluso datos no estructurados. También realiza de forma automática una de las tareas más complejas del proceso de trabajo de Machine Learning: la ingeniería de atributos. Las redes neuronales seleccionan de forma automática qué atributos son los relevantes y cuáles se pueden desechar. Si quieres comprender mejor cómo funciona el aprendizaje profundo o deep learning: AI OF THINGS Atrévete con Deep Learning: Principios básicos al alcance de todos 20 de noviembre de 2018 ¿Cómo lo hicieron? Para obtener estimaciones de las emisiones de NO2 a escala suburbana sobre una base horaria, los investigadores entrenaron los modelos con los siguientes datos de entrada: Ubicación de las estaciones AirNOW Observaciones de NO2 de AirNOW, la altura de la capa límite, Información meteorológica Altitud Vías de tráfico principales Centrales eléctricas Trabajaron sobre dos modelos: un método integrado entre la distancia ponderada inversa y una red neuronal de avance (IDW + DNN), y una red matricial profunda (DMN) que mapea las observaciones discretas de AirNOW directamente a la distribución de las observaciones de TROPOMI Compararon las precisiones de ambos modelos utilizando diferentes configuraciones de predictores de entrada y validamos su error medio cuadrático medio (RMSE), su error medio absoluto (MAE) y la distribución espacial de los errores. Comprobaron que el modelo DMN, que compara las observaciones terrestres directamente con las observaciones por satélite, genera estimaciones de NO2 más fiables y captura una mejor distribución espacial de las concentraciones de NO2 que el modelo IDW + DNN. La adición de información como los datos meteorológicos, la elevación y la ubicación de las estaciones terrestres y las principales carreteras y centrales eléctricas mejoró aún más la precisión de la predicción. El modelo, una vez entrenado, ofrece estimaciones horarias de de dióxido de nitrógeno atmosférico en cuadrículas de aproximadamente 5km cuadrados. Esta alta resolución espacio-temporal resulta muy útil para estudiar la evolución de los contaminantes en el aire, ya que también podría aplicarse a otros gases de efecto invernadero y a otras escalas geográficas (de ciudades a regiones o continentes). Por otra parte, el modelo también podrá actualizarse y mejorar su precisión cuando se lancen nuevos satélites de mayor resolución. Conclusión La aplicación de algoritmos de deep learning a las distintas fuentes de datos sobre contaminación atmosférica permite crear modelos que predicen, con una alta resolución espacio-temporal, los niveles de calidad del aire. Este resultado es de gran importancia, la calidad del aire, especialmente en los entornos urbanos, tiene un gran impacto sobre nuestra salud. ________________________________________ 1. Manzhu Yu, Qian Liu. Deep learning-based downscaling of tropospheric nitrogen dioxide using ground-level and satellite observations. Science of The Total Environment, 2021; 773: 145145 DOI: 10.1016/j.scitotenv.2021.145145 ________________________________________ Para mantenerte al día con el área de Internet of Things de Telefónica visita nuestra página web o síguenos en Twitter, LinkedIn y YouTube

26 de abril de 2021

Conectividad e IoT

IoT4All: La importancia de la interoperabilidad

¿A qué llamamos interoperabilidad en IoT?¿Es posible lograr una interoperabilidad plena?¿Es deseable?¿Qué implicaciones, más allá de las meramente técnicas, tiene?. En este nuevo post de nuestra serie IoT4All, hablaremos de la importancia de la interoperabilidad. El significado de la interoperabilidad La interoperabilidad está impresa en el ADN de Internet. De hecho, la conexión y comunicación entre dispositivos o sistemas para intercambiar información es lo que da sentido a la World Wide Web. También es la base que da soporte a la Internet abierta, donde los usuarios pueden conectarse, hablar, compartir e innovar. Pero, en la práctica esta interoperabilidad es compleja, porque ocurre en distinta medida en las distintas capas de la pila de protocolos de comunicación entre dispositivos. Y puede no ser siempre recomendable. Por poner un ejemplo, algunos fabricantes de dispositivos consideran más interesante crear ecosistemas cerrados de productos propietarios compatibles, ya que crean clientes "cautivos" de sus soluciones. Desde este punto de vista, forzar legalmente una estandarización podría desmotivar la inversión en innovación. Los defensores de la interoperabilidad, por su parte, consideran que este tipo de ecosistemas suponen una barrera a la innovación y la competencia, ya que limitan la capacidad de crear nuevos productos basados en infraestructuras ya existentes. También defienden que los consumidores deberían ser libres de cambiar a otra marca o elegir componentes de otros proveedores. Por ejemplo, que las bombillas de un proveedor fueran interoperables con los interruptores de otro. Y no hablamos sólo de los dispositivos. También deberían poder migrar sus datos al cambiar de un proveedor de servicios a otro. Para ello, éstos deberían estar accesibles y en un formato abierto estándar. Impacto económico Hace ya unos cuantos años, en 2015, el McKinsey Global Institute publicó un informe en el que sostenía que la interoperabilidad es clave para impulsar el desarrollo de Internet de las Cosas, y por tanto, permitirle desplegar todo su potencial económico. Defendía, frente a las empresas que consideran los sistemas propietarios más ventajosos y competitivos, que en un mercado de silos, las oportunidades económicas se ven muy limitadas. La interoperabilidad bien construida, aumenta el valor económico del mercado al fomentar una innovación más abierta y ofrecer eficiencias a quienes fabrican los dispositivos. Por otra parte, la creación de nuevos estándares, así como el uso de los ya existentes, permite reducir barreras de entrada, crear nuevos modelos de negocio y construir economías de escala. Desafíos para los fabricantes En ocasiones, diseñar e incluir características de interoperabilidad en un producto y probar su conformidad con los estándares puede resultar más costoso para un fabricante. Sin embargo, si el análisis costo-beneficios se amplía al ciclo de vida más amplio de un producto interoperable, el resultado puede ser totalmente diferente. Por otra parte, aunque en ocasiones, el cronograma de un nuevo producto se adelante a la disponibilidad de estándares de interoperabilidad, y la ventaja comercial de ser el primero que saca determinado producto al mercado sea clara, se corren ciertos riesgos. Desarrollar dispositivos sin estándares que sirvan de guía, puede traducirse en la creación de productos fallidos, capaces impactar de forma negativa sobre las redes de acceso a Internet, o incluso sobre la propia Internet. En definitiva, la incorporación de estándares genéricos, abiertos y ampliamente accesibles al diseño de sistemas y productos, no sólo implica un menor riesgo técnico. También aporta ventajas, como facilitar el acceso al talento técnico, a herramientas de software y. como consecuencia, la reducción de los costes de desarrollo. (RFC 7452, “Architectural Considerations in Smart Object Networking”). Desafíos para los usuarios Como ya hemos comentado antes, la interoperabilidad para los usuarios, se traduce en una mayor libertad de elección en la adquisición de dispositivos y servicios. También hay otro aspecto nada desdeñable, que tiene que ver con la usabilidad de estos. Cada día aumenta el número de dispositivos que manejamos. Por ello, es fundamental disponer de herramientas, métodos o interfaces de configuración que nos permitan modificar la configuración de nuestros dispositivos en red de forma cómoda, sencilla y segura. Otros desafíos La emergencia sanitaria originada por el coronavirus ha puesto de relieve la importancia de Internet como vehículo de conexión, información y comunicación de la sociedad, así como la necesidad de disponer de redes de telecomunicaciones fuertes que la sustenten. Hemos visto cómo el libre flujo mundial de datos en la Internet abierta e interconectada nos ha permitido seguir la evolución del virus, compartir buenas prácticas para luchar contra él y nos ha ayudado a gestionar esta crisis global. Sin embargo, vemos también cómo está surgiendo una peligrosa tendencia hacia la fragmentación, una disociación tecnológica (decoupling) que puede poner en peligro el ecosistema mundial de Internet. Gobiernos de países como Rusia e Irán están adoptando medidas para evitar que sus ciudadanos se conecten a la red mundial. Por tanto, no se trata sólo de una división en el acceso a los contenidos (capa social), sino también en las capas tecnológica y lógica de Internet. Esta diferenciación en la infraestructura -- hardware, software y protocolos-- puede conducir a islas tecnológicas independientes o autosuficientes, no interoperables ni interconectables, que acabarían con Internet tal y como la conocemos. Probablemente, en este ejemplo nos sea más fácil identificar cómo de negativo sería el impacto de la falta de interoperabilidad sobre la economía, la innovación, el conocimiento y la cooperación humana. Puedes encontrar todos los post del nuestra serie IoT4All aquí. Referencias: La Internet de las Cosas— Una breve reseña (ISOC) El valor de la conectividad y el internet abierto (Revista Telos) Para mantenerte al día con Telefónica Tech AIofThings, visita nuestra página web, o síguenos en Twitter, LinkedIn o YouTube.

16 de abril de 2021

AI & Data

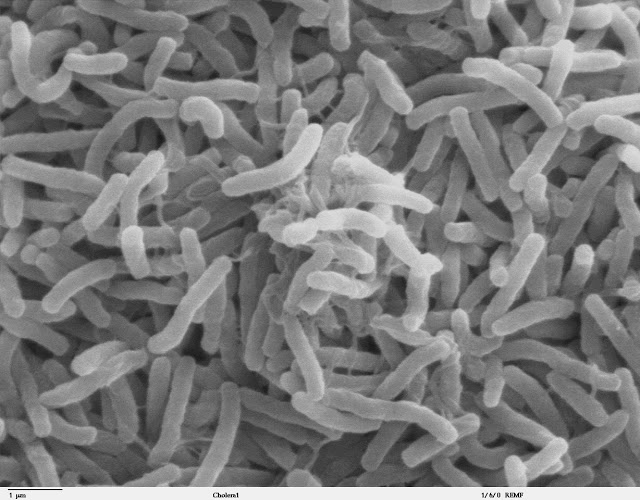

Drones contra plagas en cultivos ecológicos

Cada día nos encontramos con una nueva e interesante aplicación del tándem IA of Things, a nuestra realidad más cercana. En este caso, los protagonistas son sencillos drones dirigidos por tecnología inteligente y cámaras especiales que escanean el espacio aéreo en invernaderos para combatir las plagas de polillas sin tener que recurrir al uso de pesticidas. El problema La Plutella xylostella , palomilla dorso de diamante o polilla de la col, es un lepidóptero con una distribución continua y global, que se ha convertido en la plaga más destructiva de cosechas de plantas alimentarias de la familia crucíferas. Esta extensa familia está formada por muchas especies de gran importancia económica, tanto para el consumo humano, como para usos ornamentales, oleaginosos, forrajeros. Ejemplos del tipo de cultivos más afectados son: brócoli, repollo, coliflor, col, col rizada, mostaza, rábano, nabos etc. Se trata de una plaga difícil de controlar, ya que ha desarrollado resistencia a distintos plaguicidas. El uso indiscriminado de insecticidas sintéticos a partir de los años 50, no sólo acabó eliminado los enemigos naturales de p. xylos tella, sino que además dio lugar a un indeseado proceso de selección natural. Como consecuencia, P. xylostella se convirtió en el primer insecto que desarrolló resistencia al DDT en 1953, y es resistente a muchos otros insecticidas sintéticos más recientes e incluso es la primera especie que capaz de desarrollar resistencia a toxinas de B. thuringiensis. Cultivos ecológicos Por otra parte, los productores que quieran obtener una certificación de cultivo ecológico, no pueden emplear sustancias químicas que podrían ser perjudiciales para nuestro planeta e incluso nuestra salud. Por tanto, pesticidas y fertilizantes no son una opción. ¿Cómo librarse entonces de las hambrientas larvas de polilla que pueden llegar a arruinar sus cultivos? Igual que en este otro post os contamos cómo de una conversación casual en una boda entre la ecóloga Annie Schmidt, y el ingeniero Mac Schwager, surgió una ingeniosa solución para controlar la buena salud de las colonias de pingüinos en la Antártida, la idea para controlar plagas de Plutella xylostella tuvo también un origen curioso. Un grupo de estudiantes de la universidad de Delft se planteó si sería posible usar pequeños drones para acabar con los mosquitos que se colaban en su habitación. De esta forma, lo que empezó como un divertido pasatiempo, se acabó convirtiendo en el origen de una startup de tecnología inteligente para control de plagas sin pesticidas en invernaderos. AI OF THINGS Drones y conservación de especies 3 de febrero de 2021 Drones inteligentes contra polillas Los propios drones son muy básicos, pero están dirigidos por tecnología inteligente y cámaras especiales que escanean el espacio aéreo de los invernaderos. Cuando las cámaras detectan una polilla, el dron se lanza como un kamikaze contra el insecto y lo destruye con sus rotores. El sistema está aún en desarrollo, pero los resultados son prometedores. Pequeños drones escanean de forma autónoma el espacio aéreo del invernadero durante la noche, eliminado de forma selectiva a las polillas. Es en ese punto donde entra en juego la inteligencia artificial. No hay que eliminar cualquier insecto, sólo las polillas. Por tanto, mediante técnicas de visión artificial, las cámaras del dron son capaces de distinguir entre los insectos beneficiosos (abejorros y mariquitas) y los que no lo son. Otras aplicaciones Hay otras curiosas relaciones entre drones y polillas. Investigadores de la Universidad de Boston y de la Universidad de Washinton han publicado un artículo en la revista PLOS Computational Biology, en el que plantean la aplicación de estrategias de navegación de polillas para desarrollar programas que ayuden a los drones a navegar de forma autónoma por entornos desconocidos. Otros post sobre drones contra plagas en nuestro blog: AI OF THINGS Machine Learning, satélites y drones contra “plagas bíblicas” 8 de abril de 2020 Para mantenerte al día con Telefónica Tech AIofThings, visita nuestra página web, o síguenos en Twitter, LinkedIn o YouTube.

15 de abril de 2021

AI & Data

Aprendizaje federado: IA con privacidad

¿Podemos beneficiarnos de las ventajas de la IA en nuestros smartphones sin ceder nuestros datos a las grandes tecnológicas mundiales? Porque, efectivamente, gracias a ello recibimos, por ejemplo, recomendaciones personalizadas, si; pero también anuncios. Por otra parte, esos datos pueden ser compartidos por terceros, poniendo en riesgo nuestra privacidad. Veamos cómo el aprendizaje federado propone una forma alternativa de entrenar los modelos de aprendizaje Según el portal de estadísticas Statista, para 2030 habrá cerca de 50.000 millones de dispositivos conectados. Se dice pronto... 50.000 millones de dispositivos, no sólo móviles inteligentes, sino también, ordenadores, teléfonos, coches, relojes, wearables, neveras, aspiradoras etc generando datos. El dónde, el cómo y el qué se haga con esos datos va a ser muy relevante. Tan relevante como un volumen de 27.800 millones, estimado para negocio mundial de análisis de IoT en 2022 por la consultora Market Reports. ¿Dónde se almacenan, tratan y analizan todos los datos? El mercado de la IA esta dominado por gigantes tecnológicos como Google, Amazon y Microsoft, que ofrecen soluciones API e IA basadas en la nube. En los métodos tradicionales de IA, los datos confidenciales del usuario se envían a los servidores de estas grandes empresas, y es allí donde se entrenan los modelos. El aprendizaje federado propone un nuevo enfoque, basado en un modelo de inteligencia artificial descentralizada. Permite que el aprendizaje automático se lleve a cabo en nuestros dispositivos móviles en tiempo real, sin comprometer su funcionalidad y sin tener que compartir nuestros datos. Así, mientras usas tu teléfono móvil, parte de su energía sobrante se puede invertir en tareas de aprendizaje automático. Definición de Aprendizaje Federado El Aprendizaje Federado es un paradigma de Machine Learning dirigido al aprendizaje colaborativo de modelos de datos descentralizados, como los datos ubicados en los teléfonos inteligentes de los usuarios, en hospitales, o en bancos, y que asegura la privacidad de los datos. ¿Cómo lo consigue? Muy sencillo. Entrenando el modelo localmente en cada nodo (por ejemplo, en cada teléfono inteligente), compartiendo los parámetros actualizados del modelo (no los datos) y agregando de forma segura estos parámetros para construir un mejor modelo global. En otras palabras, El aprendizaje federado es un aprendizaje colaborativo que consiste en crear un modelo global entrenado con actualizaciones calculadas en los dispositivos móviles mientras se mantienen los datos de los usuarios a nivel local. ¿Qué ventajas tiene? La ventaja más atractiva del aprendizaje federado es la protección de la privacidad. Los modelos locales se agregan y contribuyen a un modelo global, pero al no ser necesario compartir los datos en bruto, se garantiza la confidencialidad. Por otra parte, al entrenarse de forma local con los datos del usuario, le ofrecen una gran personalización. Al mismo tiempo, se reducen las latencias y el coste de intercambiar datos de forma continua con un servidor. ¿Qué dificultades enfrenta? El aprendizaje federado está en sus orígenes, y tiene por delante muchos desafíos que afrontar. Aunque en la actualidad, muchos teléfonos inteligentes y dispositivos IoT son capaces de ejecutar algoritmos de aprendizaje automático, este tipo de aprendizaje estará siempre condicionado por las limitaciones de los dispositivos locales en los que se ejecute. Otras dificultades tienen que ver con la dificultad en disponer de datos etiquetados para el entrenamiento en local, el mayor tiempo de convergencia de estos modelos comparados con el aprendizaje automático tradicional, o los problemas de confiabilidad, cuando no todos los dispositivos participan en el proceso de aprendizaje federados por problemas de conectividad u otros motivos. Tampoco hay que olvidar las presiones que puedan ejercer en su contra las grandes empresas interesadas en acaparar los grandes silos de datos propios de los modelos de aprendizaje automático centralizado. ¿Cuáles son los frameworks más populares? Entre los frameworks más populares, podemos destacar: TensorFlow Federated, un entorno de código abierto de Google para aprendizaje automático y otros cálculos con datos descentralizados. PySyft, una biblioteca de codigo abierto construida sobre PyTorch para el aprendizaje profundo cifrado y la privacidad Federated AI Technology Enabler (FATE), un proyecto de codigo abierto iniciado por el grupo de inteligencia artificial de Webank Sherpa.ai Federated Learning and Differential Privacy Framework, framework de código abierto desarrollado para facilitar la investigación y experimentación abierta en el Aprendizaje Federado y la Privacidad Diferencial etc ¿Para qué se utiliza? Los escenarios de uso están caracterizados principalmente por los aspectos de seguridad y confidencialidad. Por ejemplo en aplicaciones de recomendaciones personalizadas o de salud, que deben proporcionar mecanismos de privacidad de datos para aprender de un conjunto de usuarios, mientras los datos sensibles permanecen en cada dispositivo del usuario. En entornos industriales, en aplicaciones para mejorar la gestión y la cadena de suministro. En este tipo de entornos, los datos se encuentran en silos. Sin embargo, un fabricante de recambios de automóvil, por ejemplo puede beneficiarse de modelos que aprenden de los datos de los demás sin tener que revelar los suyos. Otros entornos sometidos a normativas de protección de la privacidad, como bancos o empresas de telecomunicaciones, pueden beneficiarse de modelos que aprenden de datos distribuidos en varias entidades, sin compartir registros individuales de sus clientes. El aprendizaje federado también facilita el Edge Computing, mejorando los modelos de Machine Learning en los dispositivos distribuidos al compartir información global entre nodos. Al mismo tiempo, asegura la privacidad de los datos en cada dispositivo. CLOUD AI OF THINGS Edge Computing y Machine Learning, una alianza estratégica 7 de julio de 2022 Conclusión A pesar de los desafíos que tiene que afrontar este nuevo paradigma de aprendizaje automático, la tendencia actual de intentar devolver al usuario el poder sobre sus datos, y las legislaciones que surgen en pos de la protección de la confidencialidad, suponen un gran impulso para este tipo de modelos.

17 de marzo de 2021

AI & Data

Ciencia Ciudadana e IA para luchar contra la soledad

Ante el aumento de personas mayores en riesgo de soledad, el proyecto Serena propone una interesante alianza entre Psicología, Inteligencia Artificial y Ciencia Ciudadana. Veamos cómo el aprendizaje automático puede usarse para mejorar la calidad de vida de la personas mayores y sus cuidadores. ¿Qué es la Ciencia Ciudadana? La "Ciencia Ciudadana" es un concepto abierto que abarca las distintas formas en las que el público general participa en la ciencia. Hay dos características definitorias: Los ciudadanos contribuyen activamente a la ciencia, con su esfuerzo intelectual , conocimientos, herramientas o recursos; en colaboración con científicos o profesionales. La obtención de resultados que se traduzcan en conocimiento científico, acciones de conservación o iniciativas políticas. El objetivo de la ciencia ciudadana es mejorar las interacciones entre la ciencia, la sociedad y la política, para lograr una investigación más democrática, basada en la toma de decisiones fundamentadas en la evidencia. Tanto los campos de actuación, como la escala son muy variados. Proyectos locales o globales; breves o con desarrollos que se extienden durante décadas. En campos como la medicina, astronomía, ecología, informática, historia etc. Serena, un chatbot contra la soledad El proyecto Gerontec, de 'Aprendizaje automático como herramienta de ciencia ciudadana para mejorar la calidad de vida de las personas mayores y sus personas cuidadoras', desarrollado por el equipo de investigación GIANT (Machine Learning for Smart Environments) de la Universitat Jaume I de Castelló es una iniciativas financiadas por FECYT. La Fundación Española para la Ciencia y la Tecnología (FECYT), promueve en sus convocatorias la realización de acciones que acercan la ciencia a la población y también la hacen partícipe de ella. El objetivo final del proyecto es la creación de un chatbot conversacional diseñado para hablar con las personas y evaluar sus sentimientos de soledad: Serena. Un problema de salud pública Las evidencias de efectos adversos de la soledad no deseada en las personas mayores son muy numerosas. Y la situación de alerta sanitaria por la COVID-19 no ha hecho sino aumentar el aislamiento social de un gran número de ellas. Tanto es así, que los especialistas han llegado a considerarlo un problema de salud pública. Para poder llevar a cabo cualquier estrategia de mitigación de este problema, un paso previo ineludible es la detección de estas personas en riesgo de soledad. Con este objetivo, el equipo GIANT creó Serena, un chatbot diseñado para hablar con las personas y evaluar sus sentimientos de soledad. Serena es un eficaz herramienta que permite a alertar a los profesionales de la salud de situaciones en las que es necesaria su intervención. La herramienta ha sido desarrollada por un equipo interdisciplinario en los campos de la Psicología y las Ciencias de la Computación y aprovecha la tecnología para recoger la colaboración de la población, en el marco de la Ciencia Ciudadana. Así, una investigación científica sobre el análisis de constructos como la soledad, el aislamiento social, el bienestar o el estrés; se realiza de forma accesible a la ciudadanía, y se enriquece con su participación, gracias a herramientas de aprendizaje automático. ¿Cómo? El proyecto, que se desarrolló entre octubre de 2019 y junio de 2020, se articula en tres fases: captación de datos, procesamiento y etiquetado, entrenamiento y puesta en marcha de la plataforma web. Primera fase: Recogida de información En esta fase, personas voluntarias (mayores y cuidadores/as) respondieron a cuestionarios estandarizados y preguntas de respuesta abierta de forma natural y sencilla: a través de la voz y el uso de teléfonos móviles y aplicaciones tipo chat-bot. Figura 1: Cuestionario La herramienta utilizada para la programación del chat-bot, la recolección de locuciones y la transcripción de las respuestas de voz a texto, es DialogFlow1 de Google. Para la difusión y captación de personas voluntarias, se contó con el apoyo de instituciones públicas y privadas de Castellón, además de empresas del sector del cuidado de personas mayores. En esta primera fase se prestó especial atención a la protección de los datos, así como a la confiabilidad y trazabilidad de los mismos. A partir de las locuciones de las respuestas a las preguntas realizadas por el chat-bot, se obtuvo gran volumen de datos no etiquetados. Segunda fase: Etiquetado colaborativo de los datos Una vez recogidos los datos en la fase uno, se anonimizaron, eliminando cualquier información que permita identificar a la persona que los generó. A continuación, y para que los algoritmos de aprendizaje automático "aprendieran" a detectar cuando un determinado mensaje indica que una persona está en situación de riesgo, era necesario etiquetar los datos. Figura 2: Ejemplo de etiquetado de datos En esta segunda fase, se recurrió nuevamente a la ciencia ciudadana para la realización de un etiquetado colaborativo a través de la plataforma Zooniverse. De esta forma, fueron personas voluntarias las que leyeron un determinado mensaje como "Mi hija se ha ido de viaje y mi mujer lleva días llegando tarde de trabajar" y lo etiquetaron como "Expresa soledad" o "No expresa soledad". A continuación, con un gran volumen de datos etiquetados, ya se pudo entrenar los algoritmos de aprendizaje automático para que aprendieran a etiquetar audios de forma automática e indicar si éstos expresan soledad, aislamiento, estrés, bienestar etc Tercera fase: Entrenamiento de los algoritmos de aprendizaje automático En la tercera fase, y siguiendo una metodología de co-diseño, en la que los usuarios finales participan en toda las fases del proyecto, se creó una plataforma web accesible tanto para los profesionales de salud, como para la ciudadanía en general. A través de esta plataforma, los algoritmos de aprendizaje automático entrenados con los datos etiquetados en la fase anterior se pusieron a disposición de los usuarios como herramienta de valoración de situaciones de riesgo emocional. De esta forma, los algoritmos ya entrenados, seguían aprendiendo, mejorando su eficacia. Si quieres colaborar o comprobar cómo funciona... Habla con Serena. Figura 3: Plataforma web "Habla con Serena" Conclusión Con este proyecto vemos un ejemplo más de cómo distintas disciplinas científicas se alían con la colaboración ciudadana y tecnologías basadas en el aprendizaje automático para ayudar a resolver un problema tan humano como la soledad no deseada. Si eres trabajador de Telefónica y quieres contribuir a mitigar al soledad no deseada de las personas mayores, puedes colaborar con el proyecto "Conectando Personas" de Voluntarios Telefónica. Si no eres trabajador de Telefónica, puedes hacerlo directamente, con Cruz Roja, a través de su página de voluntariado.

11 de marzo de 2021

AI & Data

Florence Nightingale, pionera en el uso de datos para la salud