AI & Data

Modelos interpretables con Python SHAP

Recientemente se publicó en este blog un interesante artículo sobre la interpretabilidad de modelos de Machine Learning. Los modelos de inteligencia artificial se han vuelto complejos, en especial con el auge del Deep Learning. Este es un problema grave, especialmente cuando los humanos son responsables de las decisiones basadas en soluciones digitales. El objetivo de hacer que los algoritmos sean accesibles, entendible e interpretables es fundamental para lo que se conoce como "Inteligencia Artificial Explicable (XAI)", y en los últimos tres años se ha convertido en un área de investigación muy activa. En este post vamos a realizar un ejemplo simple de cómo dotar de explicabilidad e interpretabilidad a un modelo de análisis de sentimiento de regresión logística lineal usando la librería de Python Shap. Tomando como ejemplo un análisis típico de sentimiento sobre un dataset de críticas de películas, veremos cómo los valores SHAP de cada palabra nos permitirán entender cuáles son las más importantes a la hora de tomar la decisión de si esa crítica es buena o mala. Con un modelo lineal el valor SHAP para la característica $latex i$ para la predicción $latex f(x)$ (asumiendo que las características son independientes) es simplemente: Dado que estamos explicando un modelo de regresión logística, las unidades de los valores SHAP estarán en el espacio log-odds. No nos vamos a complicar para realizar esta prueba de usabilidad; el conjunto de datos que utilizamos es el conjunto de datos clásico de IMDB de este enlace. Para empezar a usar la librería, dentro de nuestro entorno virtual de Python, simplemente hay que ejecutar el siguiente comando en un terminal: pip install shap Importando librerías Para esta rápida prueba, vamos a usar scikit-learn como librería desde la que haremos uso de las funciones necesarias. import sklearn

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report

import numpy as np

import shap

from gensim.parsing.preprocessing import remove_stopwords

shap.initjs() Cargando y procesando en IMDB dataset corpus, y = shap.datasets.imdb() Como ejemplo, tenemos la siguiente reseña: corpus[10]

This film is one giant pant load. Paul Schrader is utterly lost in his own bad screenplay. And his directing is about as comatose as it can be without his actually having been sleepwalking during the process. <br /><br />The worst though is Woody Harrelson, whom I ordinarily like when he's properly cast...

Estamos manejando un dataset perfectamente balanceado, con 12500 reseñas positivas y el mismo número de reseñas negativas. print('Posibles etiquetas para el dataset: ', np.unique(y, return_counts=True))

Posibles etiquetas para el dataset: (array([False, True]), array([12500, 12500])) Antes de empezar con la tokenización de las palabras que componen las reseñas de las películas, debemos eliminar las stopwords de nuestro dataset, sobre lo que ya hablamos con anterioridad en este blog. Estas palabras no añaden información válida a la reseña y son muy frecuentes (conjunciones, preposiciones, pronombres, verbos auxiliares, etc.) Este paso se puede abordar con un simple bucle para todas las reseñas: corpus_cleaned = list()

for review in corpus:

corpus_cleaned.append(remove_stopwords(review).replace('</br>', '')) Por ejemplo, la reseña corpus[10] queda de la siguiente manera: corpus_cleaned[10]

This film giant pant load. Paul Schrader utterly lost bad screenplay. And directing comatose actually having sleepwalking process. </></>The worst Woody Harrelson, I ordinarily like he\'s properly cast... Partición train-test del dataset Una vez nuestro dataset está limpio de stopwords, se debe realizar la partición entrenamiento-testeo (vamos a elegir una razón 80%-20%) y se procede a su transformación TF-IDF con la TfidfVectorizer de sklearn. corpus_train, corpus_test, y_train, y_test = train_test_split(corpus_cleaned,

y,

test_size=0.2,

random_state=42)

vectorizer = TfidfVectorizer(min_df=10)

X_train = vectorizer.fit_transform(corpus_train).toarray() # sparse also works but Explanation slicing is not yet supported

X_test = vectorizer.transform(corpus_test).toarray() Con este paso ya tenemos la partición train-test realizada con 20,000 muestras de entrenamiento y 5,000 muestras de testeo. Cada una de esas muestras o arrays tiene 16,364 elementos. print(X_train.shape)

print(X_test.shape)

(20000, 16364)

(5000, 16364) Entrenando un algoritmo de Regresión Logística model = sklearn.linear_model.LogisticRegression(penalty="l2", C=0.1)

model.fit(X_train, y_train)

LogisticRegression(C=0.1, class_weight=None, dual=False, fit_intercept=True,

intercept_scaling=1, l1_ratio=None, max_iter=100,

multi_class='auto', n_jobs=None, penalty='l2',

random_state=None, solver='lbfgs', tol=0.0001, verbose=0,

warm_start=False)

Tras este rápido entrenamiento, el comportamiento de nuestro modelo es aceptable. Se consiguen unas precisiones y recalls en el intervalo 0.82-0.88 para los datos de validación. Para esta partición, el comportamiento es muy similar al obtenido en el train dataset. print(classification_report(y_test, model.predict(X_test)))

precision recall f1-score support

False 0.88 0.82 0.85 2515

True 0.83 0.88 0.85 2485

accuracy 0.85 5000

macro avg 0.85 0.85 0.85 5000

weighted avg 0.85 0.85 0.85 5000

Ahora bien, ¿en qué palabras se está fijando nuestro sencillo modelo de regresión logística para determinar si una secuencia de palabras pertenece a una reseña buena o mala? Con SHAP, visualizar esta información es muy sencillo. Explicación de nuestro modelo lineal explainer = shap.Explainer(model, X_train, feature_names=vectorizer.get_feature_names())

shap_values = explainer(X_test) Resumen de la contribución de todas las características Para obtener una descripción general de qué características son más importantes para un modelo, se pueden trazar los valores SHAP de cada característica para cada muestra. El gráfico siguiente clasifica las características por la suma de las magnitudes de los valores SHAP en todas las muestras y usa los valores SHAP para mostrar la distribución de los impactos que cada característica tiene en la salida del modelo. El color representa el valor de la característica (rojo alto, azul bajo). shap.plots.beeswarm(shap_values) Figura 1. Beeswarm summary plot de la contribución de las características más relevantes para el modelo. Podemos observar cómo altos valores de frecuencias en palabras como bad o worst tienen un impacto negativo importante en la toma de decisiones del modelo. Si esas palabras aparecen en una reseña, es bastante probable que la misma sea mala. Por el contrario, palabras como great, best o love son indicativos de que la reseña tiene altas probabilidades de ser positivas. Al final, el criterio de nuestro modelo de clasificación termina siendo bastante simple y fácilmente interpretable. Explicación de la predicción del sentimiento de la segunda reseña ind = 1

print("Reseña Positiva" if y_test[ind] else "Reseña Negativa")

print(corpus_test[ind])

Reseña Positiva

The idea ia short film lot information. Interesting, entertaining leaves viewer wanting more. The producer produced short film excellent quality compared short film I seen. I rated film highest possible rating. I recommend shown office managers ... Otra forma de visualizar la contribución de cada componente a la decisión final del modelo sobre una secuencia de muestra es el force plot (descrito en el paper Nature BME paper): shap.plots.force(shap_values[ind]) Figura 2. Force plot de la contribución de las palabras más relevantes a la toma de decisión. Otra librería similar es LIME, la cual es capaz de explicar cualquier clasificador, con dos o más clases. Todo lo que necesitamos es que el clasificador implemente una función que tome texto sin formato o una matriz numérica y genere una probabilidad para cada clase, también integrado para clasificadores de scikit-learn. Jugaremos con esta librería en próximos posts. Para mantenerte al día con el área de Internet of Things de Telefónica visita nuestra página web o síguenos en Twitter, LinkedIn y YouTube

27 de abril de 2021

AI & Data

Optimizando los hiperparámetros de una red neuronal con TensorBoard

Al crear modelos de Machine Learning se deben investigar múltiples parámetros como el número de nodos de las capas, diferentes optimizadores, valores de tasas de aprendizaje, distintas tasas de dropout, etc. Por lo tanto, un paso importante en el flujo de trabajo del Machine Learning es identificar los mejores hiperparámetros para el problema que se está abordando, lo que a menudo implica un gran número de pruebas. Este proceso se conoce como Optimización de hiperparámetros. Para poder realizarlo, TensorFlow 2.0 proporciona el panel de HParams en TensorBoard, que nos permitirá visualizar el comportamiento de nuestro modelo en función de los valores que definen nuestro modelo en nuestro dashboard. Hace unos meses escribimos un breve post sobre TensorBoard, un kit de herramientas de TensorFlow que permite monitorizar métricas como la precisión y la función de pérdida durante el entrenamiento de modelos profundos. En este anterior artículo investigamos, dentro de las funcionalidades más básicas de TensorBoard, cómo se podía monitorizar las métricas de un modelo de Machine Learning, la evolución de los pesos y sesgos de nuestra arquitectura, visualizar el grafo de nuestro modelo e incluso realizar un sencillo análisis de matriz de confusión de nuestro modelo una vez estuviera entrenado. En el presente post vamos a probar a encontrar los hiperparámetros de una red neuronal recurrente dedicada a multivariate time series forecasting. Para más detalles sobre cómo abordar un problema de este tipo, puede leer el siguiente enlace. Figura 1. Grafo del modelo recurrente usado para la predicción de time series en el dashboard de TensorBoard. Definiendo los valores de los hiperparámetros a probar Con TensorBoard, se puede realizar un seguimiento de la precisión y la pérdida del modelo en cada época; y también con diferentes valores de hiperparámetros. La precisión de seguimiento para diferentes los diferentes valores nos ayudará a ajustar el modelo más rápido. A continuación, se muestra un ejemplo de cómo listar los intervalos de valores para cada hiperparámetro. # ## Create hyperparameters

HP_INPUT_WIDTH = hp.HParam('num_input_width', hp.Discrete([12, 24, 48, 96]))

HP_OUTPUT_WIDTH = hp.HParam('num_output_width', hp.Discrete([6, 12, 24, 48]))

HP_RNN_UNITS = hp.HParam('num_rnn_units', hp.Discrete([30, 40, 60, 80, 100]))

HP_DROPOUT = hp.HParam('dropout', hp.Discrete([0.05, 0.1, 0.2]))

HP_OPTIMIZER = hp.HParam('optimizer', hp.Discrete(['adam']))

HP_LEARNING_RATE = hp.HParam('learning_rate', hp.Discrete([0.001]))

METRIC_ACCURACY = 'accuracy' Creando, compilando y ajustando el modelo Suponiendo que ya tenemos realizada la partición de nuestro dataset de time series en train, test y/o validación y que ese dataset está convenientemente preprocesado, definimos la arquitectura del modelo (haciendo uso de Keras) junto con algunos callbacks como EarlyStopping o el propio callback de TensorBoard que nos permitirá loguear el desempeño de nuestra red para cada combinación posible de hiperparámetros. def create_model(hparams):

# Define model architecture

input_shape = (hparams[HP_INPUT_WIDTH], num_features)

inp = tf.keras.layers.Input(input_shape)

x = tf.keras.layers.LSTM(hparams[HP_RNN_UNITS], return_sequences=False)(inp)

x = tf.keras.layers.Flatten()(x)

x = get_dropout(x, p=hparams[HP_DROPOUT], mc=True)

# Shape => [batch, 1, out_steps*features]

x = tf.keras.layers.Dense(hparams[HP_OUTPUT_WIDTH]*num_features,

kernel_initializer=tf.keras.initializers.VarianceScaling())(x)

out = tf.keras.layers.Reshape([hparams[HP_OUTPUT_WIDTH], num_features])(x)

# Build model

model = tf.keras.models.Model(inputs=inp, outputs=out)

# Setting the optimizer and learning rate

optimizer = hparams[HP_OPTIMIZER]

learning_rate = hparams[HP_LEARNING_RATE]

if optimizer == 'adam':

optimizer = tf.optimizers.Adam(learning_rate=learning_rate)

else:

raise ValueError("Unexpected optimizer name: %r" % (optimizer_name,))

# Define Early Stopping

early_stopping = tf.keras.callbacks.EarlyStopping(monitor='val_loss',

patience=3,

mode='min')

# Define path where TensorBoard logs will be stored

log_dir = os.path.join(tensorboard_path,

'lstm_verbose',

datetime.datetime.now().strftime("%Y%m%d-%H%M%S"))

with tf.summary.create_file_writer(log_dir).as_default():

hp.hparams_config(

hparams=

[

HP_INPUT_WIDTH, HP_OUTPUT_WIDTH,

HP_RNN_UNITS, HP_DROPOUT,

HP_OPTIMIZER, HP_LEARNING_RATE

],

metrics=[hp.Metric(METRIC_ACCURACY, display_name='accuracy')],

)

# We compile the model

model.compile(loss=tf.losses.MeanSquaredError(),

optimizer=optimizer,

metrics=[

tf.metrics.MeanAbsoluteError(),

tf.keras.metrics.MeanSquaredError(),

'accuracy'

])

# Define a Window Generator to feed the neural network

multi_window = WindowGenerator(input_width=hparams[HP_INPUT_WIDTH],

label_width=hparams[HP_OUTPUT_WIDTH],

shift=hparams[HP_OUTPUT_WIDTH])

# Fitting the model

history = model.fit(multi_window.train, epochs=max_epochs,

validation_data=multi_window.val,

callbacks=[early_stopping,\

tf.keras.callbacks.TensorBoard(log_dir),

hp.KerasCallback(log_dir, hparams)])

return history.history['val_accuracy'][-1] Para cada ejecución del modelo, necesitamos registrar el resumen de hparams con el hiperparámetro y la precisión de las épocas finales. Necesitamos convertir la precisión de validación de la última época en un valor escalar. def run(run_dir, hparams):

with tf.summary.create_file_writer(run_dir).as_default():

hp.hparams(hparams) # record the values used in this trial

accuracy = create_model(hparams)

# converting to tf scalar

accuracy = tf.reshape(tf.convert_to_tensor(accuracy), []).numpy()

tf.summary.scalar(METRIC_ACCURACY, accuracy, step=1) Ejecutando el modelo con diferentes valores de hiperparámetros En este paso se usa Grid Search para probar todas las combinaciones posibles. session_num = 0

for num_input_units in HP_INPUT_WIDTH.domain.values:

for num_output_units in HP_OUTPUT_WIDTH.domain.values:

for num_rnn_units in HP_RNN_UNITS.domain.values:

for dropout_rate in HP_DROPOUT.domain.values:

for optimizer in HP_OPTIMIZER.domain.values:

for learning_rate in HP_LEARNING_RATE.domain.values:

hparams = {

HP_INPUT_WIDTH: num_input_units,

HP_OUTPUT_WIDTH: num_output_units,

HP_RNN_UNITS: num_rnn_units,

HP_DROPOUT: dropout_rate,

HP_OPTIMIZER: optimizer,

HP_LEARNING_RATE: learning_rate,

}

run_name = "run-%d" % session_num

print('--- Starting trial: %s' % run_name)

print({h.name: hparams[h] for h in hparams})

run(os.path.join(tensorboard_path,

'lstm_mc_hgs_verbose',

datetime.datetime.now().strftime("%Y%m%d-%H%M%S")),

hparams)

session_num += 1 Visualizando los resultados de la búsqueda Ejecutamos en un terminal (tras haber activado nuestro entorno virtual de Python) y ejecutamos el siguiente comando: tensorboard --logdir "/logs/lstm_verbose/" --port 6006 Si nos vamos a http://localhost:6006/ podremos acceder al dashboard de TensorBoard. Si se ha logueado todo correctamente, en el dashboard se tendrá disponible una pestaña llamada HParams, que muestra las ejecuciones individuales para cada combinación de hiperparámetros ordenadas de acuerdo a los valores de METRIC_ACCURACY especificada arriba. Figura 2. Resumen de experimentos realizados con estrategia de Grid Search en HParams con TensorBoard. Figura 3. Parallel Coordinates View de HParams en el dashboard de TensorBoard. Figura 4. Scatter Plot Matrix View de HParams en el dashboard de TensorBoard. Como se ve en la figura anterior, el panel izquierdo del panel proporciona capacidades de filtrado que están activas en todas las vistas en el panel de HParams: Filtrar qué hiperparámetros/métricas se muestran en el panel; Filtrar qué valores de hiperparámetros/métricas se muestran en el panel; Filtrar por estado de ejecución (en ejecución o terminadas); Ordenar por hiperparámetro/métrica en la vista de tabla; Número de grupos de sesiones para mostrar (útil para el rendimiento cuando hay muchos experimentos). El panel de HParams tiene tres vistas diferentes, con diversa información útil: La vista de tabla (Figura 2) enumera las ejecuciones, sus hiperparámetros y sus métricas. La pestaña de coordenadas paralelas (Figura 3) muestra cada tramo como una línea que pasa por un eje para cada hiperparámetro y métrica. La vista de gráfico de dispersión (Figura 4) muestra gráficos que comparan cada hiperparámetro/métrica con cada métrica. Esto puede ayudar a identificar correlaciones. Conclusión Os invitamos a intentar realizar un experimento similar al expuesto en este post con la red convolucional que construimos en Supervisa tu entrenamiento de redes neuronales con TensorBoard para Fashion MNIST, probando a modificar el número de filtros, el tamaño de kernel, el número de unidades en las capas densas finales y/o distintos optimizadores distintos de Adam. Para más detalle sobre Hyperparameter Tuning, puede consultar el tutorial de TensorFlow.

24 de marzo de 2021

AI & Data

Clustering de series temporales con Python

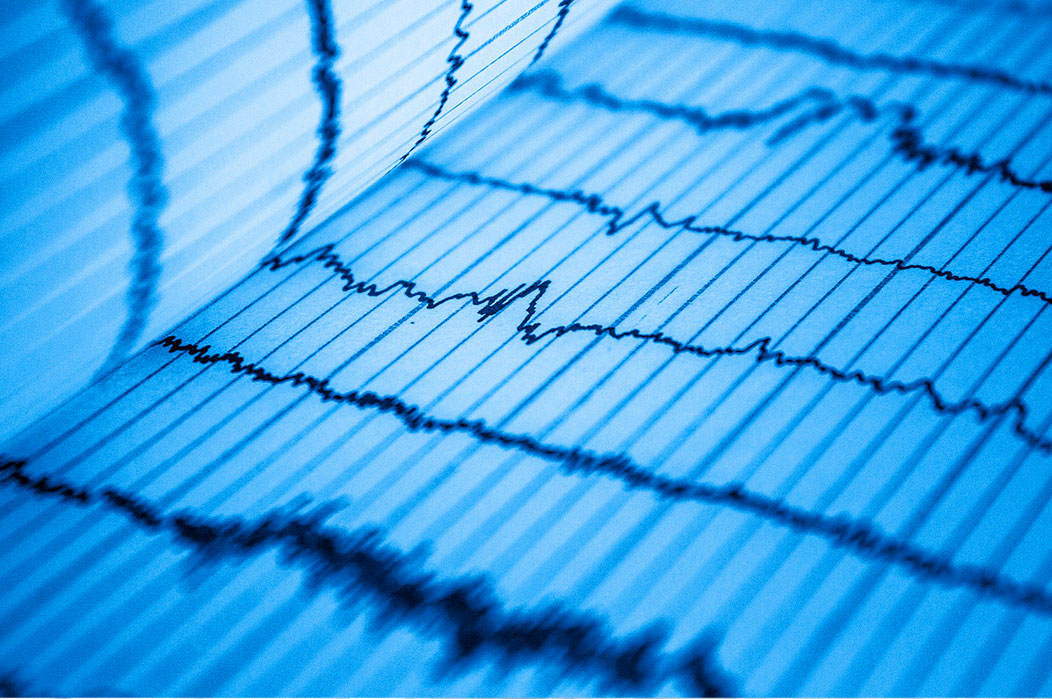

La proliferación y la ubicuidad de los datos con dependencia temporal en un amplio abanico de disciplinas genera un interés sustancial en el análisis y la extracción de series temporales. La agrupación o clustering es uno de los métodos de extracción de datos más populares, no sólo por su poder de exploración, sino también como paso previo al procesamiento de otras técnicas. tslearn es una librería de Machine Learning de Python para series temporales que ofrece herramientas para el preprocesamiento y la extracción de características, así como modelos dedicados para clustering, clasificación y regresión. En esta rápida prueba de concepto, vamos a realizar una tarea de clustering de un dataset de una sola variable bien conocido. Importando librerías Para empezar, importamos las librerías que vamos a usar: import tslearn

import numpy as np

import time

import matplotlib.pyplot as plt Con TimeSeriesScalerMeanVariance procesaremos las time series para que tengan una media nula y una desviación típica igual a 1. from tslearn.preprocessing import TimeSeriesScalerMeanVariance Obteniendo un dataset Afortunadamente, tslearn nos ofrece un gran número de series temporales con las que podemos empezar a trastear. Podemos acceder a los UCR/UEA time series datasets de la siguiente manera. from tslearn.datasets import UCR_UEA_datasets En el siguiente enlace se puede consultar la extensa lista de datasets de series temporales a la que podemos acceder. Como se puede ver, todos estos datasets están convenientemente etiquetados, por lo que podremos comprobar la bondad de nuestro modelos una vez que hayamos terminado de clusterizar las secuencias. En este artículo vamos a trabajar con el dataset ECG5000. Este dataset contiene 20 horas de registros de electrocardiogramas (ECGs). En total se cuentan con 5,000 pares de ECGs y etiquetas. Fue publicado en "Goldberger AL, Amaral LAN, Glass L, Hausdorff JM, Ivanov PCh, Mark RG, Mietus JE, Moody GB, Peng C-K, Stanley HE. PhysioBank, PhysioToolkit, and PhysioNet: Components of a New Research Resource for Complex Physiologic Signals. Circulation 101(23)". Figura 1. Muestra de electrocardiogramas de ECG5000. Fuente. Es muy simple acceder a las particiones de entrenamiento y testeo del dataset que nos interesa. X_test, y_test, X_train, y_train = UCR_UEA_datasets().load_dataset("ECG5000") Las etiquetas del dataset tienen el siguiente significado: 1 = N - Normal 2 = SVEB - Supraventricular ectopic beats 3 = VEB - Ventricular ectopic beats 4 = Fusion beat 5 = Unknown beat Entendiendo el dataset Lo primero que hay que comprobar es la distribución de etiquetas en el dataset. labels, counts = np.unique(y_train, return_counts=True)

_labels = ['Normal', 'SVEB', 'VEB', 'Fusion', 'Unknown']

plt.div(figsize=(8, 6))

plt.bar(_labels, counts, align='center')

plt.gca().set_xticks(_labels)

plt.grid()

plt.ylabel('No. samples')

plt.xlabel('Beat type')

plt.show() Figura 2. Histograma de clases en ECG5000. Como se puede observar, el dataset está muy desbalanceado. Hay muy pocas muestras de las clases y_train > 2 en comparación con los latidos normales o SVEB. Por ello, para simplificar el análisis, vamos a partir el dataset en latidos normales (y_train | y_test = 0) y latidos anómalos (y_train | y_test = 1) y_test[y_test == 1] = 0

y_test[y_test > 1] = 1

y_train[y_train == 1] = 0

y_train[y_train > 1] = 1 El número de muestras pertenecientes a cada clase sigue estando desbalanceado, aunque no de manera tan extrema como antes. Esto nos permitirá clusterizar en dos grupos con mejores resultados. labels, counts = np.unique(y_train, return_counts=True)

_labels = ['Normal', 'Anomalous']

plt.div(figsize=(8, 6))

plt.bar(_labels, counts, align='center')

plt.gca().set_xticks(_labels)

plt.grid()

plt.ylabel('No. samples')

plt.xlabel('Beat type')

plt.show() Figura 3. Histograma de clases adaptadas para ECG5000. Preprocesado del dataset y visualización Debemos escalar nuestras series temporales para poder obtener buenos resultados de clustering. X_train = TimeSeriesScalerMeanVariance().fit_transform(X_train)

X_test = TimeSeriesScalerMeanVariance().fit_transform(X_test) Como vemos, contamos con 4500 secuencias de 140 elementos de una sola variable para entrenar y 500 secuencias de igual longitud para testear. print(X_train.shape)

print(X_test.shape) (4500, 140, 1) (500, 140, 1) size = X_train.shape[1]

n_classes = len(set(y_train)) plt.div(figsize=(10, 10))

for i, cl in enumerate(set(y_train)):

plt.subplot(n_classes, 1, i + 1)

for ts in X_train[y_train == cl]:

if cl == 0:

plt.plot(ts.ravel(), color="green" , alpha=.15)

else:

plt.plot(ts.ravel(), color="red" , alpha=.15)

plt.xlim(0, size - 1)

plt.grid()

plt.suptitle("Training time series")

plt.show() Figura 4. ECG5000 Training dataset (normal - green ; anomalous - red) plt.div(figsize=(10, 10))

for i, cl in enumerate(set(y_train)):

plt.subplot(n_classes, 1, i + 1)

for ts in X_test[y_test == cl]:

if cl == 0:

plt.plot(ts.ravel(), color="green" , alpha=.15)

else:

plt.plot(ts.ravel(), color="red" , alpha=.15)

plt.xlim(0, size - 1)

plt.grid()

plt.suptitle("Test dataset time series")

plt.show() Figura 5. ECG5000 Test dataset (normal - green ; anomalous - red) A simple vista, únicamente en base a la forma, es sencillo distinguir entre los latidos de un individuo sano y los de un paciente con una patología (sin especificar). Clustering de secuencias Vamos a probar dos algoritmos de clustering: K-Means y K-Shape. Para el caso de K-Means, vamos a centrarnos únicamente en la métrica "euclidean". Hay otras dos alternativas para este hiperparámetro: "dtw" y "softdtw". Se deja como ejercicio al lector, si éste lo desea. Aviso: los tiempos de ejecución en estos dos casos son ostensiblemente más largos. from tslearn.clustering import TimeSeriesKMeans, KShape, silhouette_score Time Series K-Means para dos clusters start_time = time.time()

km_euc = TimeSeriesKMeans(n_clusters=2,

verbose=2,

n_init=10,

metric="euclidean").fit(X_train)

labels_euc = km_euc.labels_

print("--- %s seconds ---" % (time.time() - start_time)) ...

--- 9.683111190795898 seconds --- Time Series K-Shape para dos clusters start_time = time.time()

ks = KShape(n_clusters=2,

verbose=True,

n_init=10).fit(X_train)

labels_kshape = ks.labels_

print("--- %s seconds ---" % (time.time() - start_time)) ...

--- 91.33036160469055 seconds --- Las silhouette scores de ambas soluciones son muy similares: silhouette_score(X_train, labels_euc, metric="euclidean") 0.45911902366303975 silhouette_score(X_train, labels_kshape, metric="euclidean") 0.4550914094152607 Resultados de los agrupamientos Dado que contamos con las etiquetas del dataset, podemos comprobar cómo de bien hemos agrupado los electrocardiogramas entre pacientes sanos o con patologías. from sklearn.metrics import accuracy_score print('Training dataset accuracy for TimeSeriesKMeans clustering with euclidean metric: ', accuracy_score(y_train, labels_euc))

print('Training dataset accuracy for KShape clustering: ', accuracy_score(y_train, labels_kshape)) Training dataset accuracy for TimeSeriesKMeans clustering with euclidean metric: 0.9411

Training dataset accuracy for KShape clustering: 0.9391 print('Test dataset accuracy for TimeSeriesKMeans clustering with euclidean metric: ', accuracy_score(y_test, km_euc.predict(X_test)))

print('Test dataset accuracy for KShape clustering: ', accuracy_score(y_test, ks.predict(X_test))) Test dataset accuracy for TimeSeriesKMeans clustering with euclidean metric: 0.958

Test dataset accuracy for KShape clustering: 0.954 La clasificación parece satisfactoria. Como vemos, tenemos una precisión cercana al 96% en el test dataset. Vamos a analizar, con matrices de confusión, los errores de Tipo I y Tipo II en los que nuestros modelos de clustering está incurriendo. Estos conceptos ya se trataron en los siguientes posts: Video Post #11: Tipos de error en Machine Learning y Tipos de error en Machine Learning, ¿los conoces?. from sklearn.metrics import confusion_matrix confusion_matrix(y_train, labels_euc) NormalAnomalousNormal256364Anomalous2011672 Tabla 1. Training dataset TimeSeriesKMeans confusion matrix. confusion_matrix(y_train, labels_kshape) NormalAnomalousNormal254582Anomalous1921681 Tabla 2. Training dataset KShape confusion matrix. confusion_matrix(y_test, km_euc.predict(X_test)) NormalAnomalousNormal2839Anomalous12196 Tabla 3. Test dataset TimeSeriesKMeans confusion matrix. confusion_matrix(y_test, ks.predict(X_test)) NormalAnomalousNormal28311Anomalous12196 Tabla 4. Test dataset KShape confusion matrix. El desempeño de ambos algoritmos es muy parecido. Dado que estamos trabajando con datos clínicos de pacientes, lo que deseamos es tener el menor error de tipo I posible. Es decir, debemos minimizar la posibilidad de que a una persona con una patología cardiaca no se le diagnostique correctamente, considerándolo una persona sana. Para ambas aproximaciones, esto sólo ocurre en 12 muestras en el test dataset. Representando los clusters y sus centroides Con las siguientes líneas de código podremos representar los distintos grupos de series temporales junto con los centroides que los definen. Estos centroides se consiguen con model.cluster_centers_. def plot_groups(model):

if model == 'kmeans-euclidean':

model = km_euc

elif model == 'kshape':

model = ks

else:

sys.exit('Please, provide a valid model string.')

labels = model.labels_

plt.div(figsize=(10, 10))

for yi in range(2):

plt.subplot(2, 1, 1 + yi)

for xx in X_train[labels == yi]:

plt.plot(xx.ravel(), "k-", alpha=.15)

plt.plot(model.cluster_centers_[yi].ravel(), "r-")

plt.xlim(0, size-1)

if yi == 0:

plt.title("Normal")

else:

plt.title("Anomalous")

plt.grid()

plt.tight_layout()

plt.show() plot_groups(model='kmeans-euclidean') Figura 6. Secuencias del training dataset para latidos normales (arriba) y anómalos (abajo) para TimeSeriesKMeans. En rojo, se observan los centroides de los dos clusters. def compare_cluster_centers():

plt.div(figsize=(10, 10))

for yi in range(2):

plt.subplot(2, 1, 1 + yi)

plt.plot(km_euc.cluster_centers_[yi].ravel(), "-", alpha=1., label='K-Means euclidean')

#plt.plot(km_softdtw.cluster_centers_[yi].ravel(), "-", alpha=0.5, label='K-Means softdtw')

plt.plot(ks.cluster_centers_[yi].ravel(), "-", alpha=.5, label='K-Shape')

if yi == 0:

plt.title("Normal")

else:

plt.title("Anomalous")

plt.xlim(0, size-1)

plt.grid()

plt.legend()

plt.tight_layout()

plt.show() Figura 7. Secuencias del training dataset para latidos normales (arriba) y anómalos (abajo) para KShape. En rojo, se observan los centroides de los dos clusters. Conclusiones Los centroides de los clusters son bastante similares comparando entre los dos algoritmos usados, tal y como se preveía dadas las tasas de acierto y error mostradas por las matrices de confusión. def compare_cluster_centers():

plt.div(figsize=(10, 10))

for yi in range(2):

plt.subplot(2, 1, 1 + yi)

plt.plot(km_euc.cluster_centers_[yi].ravel(), "-", alpha=1., label='K-Means euclidean')

plt.plot(ks.cluster_centers_[yi].ravel(), "-", alpha=.5, label='K-Shape')

if yi == 0:

plt.title("Normal")

else:

plt.title("Anomalous")

plt.xlim(0, size-1)

plt.grid()

plt.legend()

plt.tight_layout()

plt.show() compare_cluster_centers_classes() Figura 8. Perfiles de los centroides para latidos normales (arriba) y anómalos (abajo) con TimeSeriesKMeans (azul) y KShape (amarillo). def compare_cluster_centers_classes():

plt.div(figsize=(10, 6))

plt.plot(km_euc.cluster_centers_[0].ravel(), "-", c='green', alpha=.75, label='Normal')

plt.plot(km_euc.cluster_centers_[1].ravel(), "-", c='red', alpha=.75, label='Anomalous')

plt.xlim(0, size-1)

plt.title("Cluster Centers comparison per classes")

plt.tight_layout()

plt.legend()

plt.grid()

plt.show() compare_cluster_centers_classes() Figura 9. Diferencias en el perfil de los centroides para TimeSeriesKMeans. Resulta muy interesante ver cómo con unas pocas líneas de código en Python, se puede obtener un perfil promedio de latido que nos permite diferenciar entre un ritmo cardíaco normal y un individuo con una patología. Otra opción alternativa a la clusterización de series temporales de este tipo podría abordarse a través de una reducción de dimensionalidad con PCA. Por ejemplo, se podría convertir el training dataset en un pandas dataframe de 4500 filas y 140 columnas y, sobre ese array, realizar un Principal Component Analysis. Con 2 componentes mantendríamos un 65% de varianza y con 3 componentes subiríamos hasta el 75%. Con esta aproximación y también de manera muy rápida, podríamos encontrar patrones comunes entre secuencias muy bien agrupados. Figura 10. Scatterplot de las primeras 2 componentes tras realizar PCA en el training dataset de ECG5000. Figura 11. Scatterplot 3D de las primeras 3 componentes tras realizar PCA en el training dataset de ECG5000. Os invitamos a probar a usar tslearn en problemas de clasificación, clustering y regresión de series temporales con éste y otros de los muchos datasets disponibles.

13 de enero de 2021

AI & Data

Supervisa tu entrenamiento de redes neuronales con TensorBoard

TensorBoard es una herramienta que permite monitorizar métricas como la precisión y la función de pérdida durante el entrenamiento de modelos profundos tanto en el conjunto de entrenamiento como en los conjuntos de validación y/o testeo. Esta herramienta también resulta bastante fácil de usar y se puede visualizar e interactuar con ella a través del navegador. A continuación, resumimos algunos de los aspectos que se van a cubrir en este artículo: Monitorización de escalares durante el entrenamiento; Visualización de imágenes; Comprobación de los pesos de los modelos y los sesgos; Visualización de la arquitectura del modelo; Análisis de la matriz de confusión del modelo. Con TensorBoard ya instalado, podemos usarlo en un Notebook Jupyter, en Google Colab o en el entorno virtual de vuestro proyecto. Nosotros trabajaremos en un Jupyter Notebook en Colab. %load_ext tensorboard Una vez cargada la extensión de TensorBoard, establecemos la ruta del directorio de logs. Aquí es donde el TensorBoard almacenará todos los registros durante el entrenamiento. En el caso de que se necesite recargar la extensión de TensorBoard, el comando indicado a continuación resultará útil. %reload_ext tensorboard Cargando un dataset Vamos a empezar a explorar TensorBoard con un ejemplo de clasificación de imágenes simple haciendo uso de Deep Learning. Usaremos uno de los datasets más sencillos y conocidos que hay: fashion-MNIST y trabajaremos con Keras. Se nos ofrecen imágenes de 28x28 de 10 tipos distintos de prendas en color blanco y negro. import numpy as np

import random

import matplotlib.pyplot as plt

import os

import datetime

import tensorflow as tf (X_train, y_train), (X_test, y_test) = tf.keras.datasets.fashion_mnist.load_data()

X_train, X_test = X_train / 255., X_test / 255.

Tamaño del training dataset: (60000, 28, 28) Tamaño del test dataset: (10000, 28, 28) Tamaño de cada imagen: (28, 28) Número de clases: 10 Si le echamos un vistazo al dataset, podemos ver que el mismo está formado por un conjunto de prendas: for i in range(0, 9):

plt.subplot(331+i) # plot of 3 rows and 3 columns

plt.imshow(X_train[i], cmap='gray') # gray scale Cada entero indicado en las etiquetas del dataset corresponde a las siguientes categorías: "top", "trouser", "pullover", "dress", "coat", "sandal", "shirt", "sneaker", "bag", "ankle boot" Figura 1. Muestra de 9 imágenes del Fashin-MNIST dataset. Necesitaremos hacer un reshape de las muestras de entrenamiento y testeo para poder alimentar un modelo convolucional de clasificación. Veremos a continuación cómo construirlo. Creando un modelo muy sencillo con Keras Vamos a crear un modelo convolucional simple que tenga 10 unidades de salida con activación softmax. No es nuestra intención conseguir precisiones muy altas en este artículo. # Model

model = tf.keras.models.Sequential()

# Add convolution 2D

model.add(tf.keras.layers.Conv2D(32,

kernel_size=(3, 3),

activation='relu',

input_shape=(28, 28, 1)))

model.add(tf.keras.layers.MaxPooling2D((2, 2)))

model.add(tf.keras.layers.Conv2D(64,

kernel_size=(3, 3),

activation='relu'))

model.add(tf.keras.layers.MaxPooling2D(pool_size=(2, 2)))

model.add(tf.keras.layers.Conv2D(128,

kernel_size=(3, 3),

activation='relu'))

model.add(tf.keras.layers.Flatten())

model.add(tf.keras.layers.Dense(128, activation='relu'))

model.add(tf.keras.layers.Dense(10, activation='softmax')) model.summary()

Model: "sequential"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

conv2d (Conv2D) (None, 26, 26, 32) 320

_________________________________________________________________

max_pooling2d (MaxPooling2D) (None, 13, 13, 32) 0

_________________________________________________________________

conv2d_1 (Conv2D) (None, 11, 11, 64) 18496

_________________________________________________________________

max_pooling2d_1 (MaxPooling2 (None, 5, 5, 64) 0

_________________________________________________________________

conv2d_2 (Conv2D) (None, 3, 3, 128) 73856

_________________________________________________________________

flatten (Flatten) (None, 1152) 0

_________________________________________________________________

dense (Dense) (None, 128) 147584

_________________________________________________________________

dense_1 (Dense) (None, 10) 1290

=================================================================

Total params: 241,546

Trainable params: 241,546

Non-trainable params: 0 Compilamos el modelo model.compile(optimizer='Adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy']) Cómo usar el callback de TensorBoard El siguiente paso es definir el callback TensorBoard durante el método de ajuste del modelo. Esta llamada es responsable de registrar eventos como Histogramas de Activación, Gráficos de Resumen de Métricas, Perfiles y Visualizaciones de Gráficos de Entrenamiento. from tensorflow.keras.callbacks import TensorBoard Ahora podemos crear el callback del TensorBoard y especificar el directorio de registro usando log_dir. El callback de TensorBoard también toma otros parámetros: histogram_freq es la frecuencia con la que se calculan los histogramas de activación y peso para las capas del modelo. Poner esto a 0 significa que los histogramas no serán calculados. Para que esto funcione, hay que definir los datos de validación. write_graph determina si el gráfico será visualizado en TensorBoard. write_images cuando se ajusta a True, los pesos del modelo se visualizan como una imagen en TensorBoard. update_freq determina cómo las pérdidas y las métricas se escriben en el TensorBoard. Cuando se establece en un número entero, digamos 100, las pérdidas y métricas se registran cada 100 lotes. Cuando se establece en un bath, las pérdidas y métricas se establecen después de cada lote. Cuando se establece en la época se escriben después de cada época. profile_batch determina qué batches serán perfilados. Por defecto, se perfila el segundo batch. También se puede establecer, por ejemplo de 5 y a 10, para perfilar los lotes de 5 a 10, es decir, profile_batch='5,10′ . Si se establece profile_batch en 0, se desactiva la creación de perfiles. embeddings_freq la frecuencia con la que se visualizarán las capas de embedding. Ponerlo a cero significa que esos embeddings no se visualizarán. Podríamos también definir un callback de checkpoint en el caso de que queramos almacenar el aprendizaje de nuestro modelo al final de cada época. callback = [

TensorBoard(log_dir=os.path.join("./logs", datetime.datetime.now().strftime("%Y%m%d-%H%M%S")),

histogram_freq=1,

write_graph=True,

write_images=True,

update_freq='epoch',

embeddings_freq=1)

] El siguiente paso es ajustar el modelo pasándole el callback. tf.keras.backend.clear_session() model.fit(X_train, y_train,

epochs=15,

batch_size=32,

validation_data=(X_test, y_test),

callbacks=callback) A partir de la época 5 empezamos a sufrir overfitting, pero lo hacemos con una precisión sobre el conjunto de validación del 90.47%. Epoch 5/15

1875/1875 [==============================] - 6s 3ms/step - loss: 0.2050 - accuracy: 0.9225 - val_loss: 0.2538 - val_accuracy: 0.9047 En este punto deberíamos haber parado nuestro entrenamiento, de haber implementado un callback de EarlyStopping y otro de ModelCheckpoint. Visualizando la evolución de los escalares durante el entrenamiento Ejecutando en nuestro Jupyter: %tensorboard --logdir logs Video 1. Explorando escalares, pesos, grafos y distribuciones con TensorBoard. Escalares TensorBoard La pestaña Scalars muestra los cambios en la función pérdida y las métricas durante las épocas tanto en entrenamiento como en validación. Se puede usar para rastrear otros valores escalares como la tasa de aprendizaje y la velocidad de entrenamiento. Imágenes de TensorBoard También podemos analizar las imágenes que muestran los pesos de la red. La barra deslizante muestra los pesos a lo largo de todas las épocas. Grafos de TensorBoard Además, se nos permite comprobar el grafo del modelo, analizando la relación entre capas y la topología global de la red. Distribuciones e Histogramas en TensorBoard Podemos consultar las distribuciones e histogramas de los tensores, tanto en pesos como en bias para cada época. Embedding Projector de TensorBoard Puede utilizar el proyector de TensorBoard para visualizar cualquier representación vectorial. Por ejemplo, Word Embeddings o imágenes. Sobre esta funcionalidad, que podéis encontrar bajo en menú desplegable Inactivo, ya hablamos en este artículo anterior. AI OF THINGS Analiza tus datos con Embedding Projector de Tensorflow 26 de febrero de 2020 Ejecutando TensorBoard en remoto Cuando se está trabajando con TensorBoard en un servidor remoto, se puede usar SSH tunneling para dirigir un puerto de ese servidor a un puerto en tu máquina local (por ejemplo, el 6006). Esto se podría hacer de la siguiente manera: ssh -L local_port:localhost:server_port your_username@my_server_ip De esta forma, podremos ejecutar sin ningún problema en nuestro servidor remoto, suponiendo que nuestro puerto en local es el local_port 8000 y el puerto en remoto expuesto es el server_port 8880: tensorboard --logdir=logs --port 8880 De forma que, en nuestro navegador, podremos visualizar TensorBoard en: http://localhost:8000 Representando imágenes de entrenamiento en TensorBoard Además de visualizar los tensores de imagen, también puede visualizar imágenes de nuestro dataset en TensorBoard. Para ilustrar eso, debe convertir los tensores de Fashion-MNIST en imágenes usando numpy. Después de eso, necesitas usar tf.summary.image para trazar las imágenes en Tensorboard. Sabemos que las imágeson son de un tamaño de 28 por 28. Debemos especificar que sólo tenemos un canal, pues las imágenes vienen en escala de grises. Luego, usa file_write para escribir las imágenes en TensorBoard. En este ejemplo, las imágenes en el índice 0 a 20 se escribirán en TensorBoard. logdir = "./logs/train_data/"

file_writer = tf.summary.create_file_writer(logdir)

with file_writer.as_default():

images = np.reshape(X_train[0:20], (-1, 28, 28, 1))

tf.summary.image("20 Clothes", images, max_outputs=25, step=0)

class_names = ["top", "trouser", "pullover", "dress", "coat",

"sandal", "shirt", "sneaker", "bag", "ankle boot"]

logdir = "logs/plots/"

file_writer = tf.summary.create_file_writer(logdir) A continuación, creamos una cuadrícula que contenga las imágenes. En este caso, la cuadrícula tendrá 25 prendas. def image_grid():

div = plt.div(figsize=(12,8))

for i in range(25):

plt.subplot(5, 5, i + 1)

plt.xlabel(class_names[y_train[i]])

plt.xticks([])

plt.yticks([])

plt.grid(False)

plt.imshow(X_train[i].reshape(28,28), cmap=plt.cm.coolwarm)

return div

div = image_grid() Figura 2. Cuadrícula de muestras del dataset. Ahora convertimos las muestras en una sola imagen para su visualización. def plot_to_image(div):

buf = io.BytesIO()

plt.savefig(buf, format='png')

plt.close(div)

buf.seek(0)

clothes = tf.image.decode_png(buf.getvalue(), channels=4)

clothes = tf.expand_dims(digit, 0)

return clothes with file_writer.as_default():

tf.summary.image("Fashion MNIST", plot_to_image(div), step=0) Vídeo 2. Representando muestras del dataset en TensorBoard. Representando la matriz de confusión en TensorBoard Se puede generar la matriz de confusión para todas las épocas. Primero, definimos una función que devolverá una figura de Matplotlib que contenga la matriz de confusión. import itertools

def plot_confusion_matrix(cm, class_names):

div = plt.div(figsize=(8, 8))

plt.imshow(cm, interpolation='nearest', cmap=plt.cm.Accent)

plt.title("Confusion matrix")

plt.colorbar()

tick_marks = np.arange(len(class_names))

plt.xticks(tick_marks, class_names, rotation=45)

plt.yticks(tick_marks, class_names)

cm = np.around(cm.astype('float') / cm.sum(axis=1)[:, np.newaxis], decimals=2)

threshold = cm.max() / 2.

for i, j in itertools.product(range(cm.shape[0]), range(cm.shape[1])):

color = "white" if cm[i, j] > threshold else "black"

plt.text(j, i, cm[i, j], horizontalalignment="center", color=color)

plt.tight_layout()

plt.ylabel('True label')

plt.xlabel('Predicted label')

return div !rm -rf "./logs/*"

logdir = "logs"

file_writer_cm = tf.summary.create_file_writer(logdir)

from sklearn import metrics

class_names = ["top", "trouser", "pullover", "dress", "coat",

"sandal", "shirt", "sneaker", "bag", "ankle boot"]

def log_confusion_matrix(epoch, logs):

predictions = model.predict(X_test)

predictions = np.argmax(predictions, axis=1)

cm = metrics.confusion_matrix(y_test, predictions)

div = plot_confusion_matrix(cm, class_names=class_names)

cm_image = plot_to_image(div)

with file_writer_cm.as_default():

tf.summary.image("Confusion Matrix", cm_image, step=epoch) A continuación debemos definir un callback LambdaCallback. LambdaCallback generará la matriz de confusión en cada época. Dado que el modelo ya se ha entrenado con anterioridad, es recomendable reiniciar la ejecución y asegurarse de que volvemos a hacer un fitting desde el inicio. callbacks = [

TensorBoard(log_dir=logdir,

histogram_freq=1,

write_graph=True,

write_images=True,

update_freq='epoch',

profile_batch=2,

embeddings_freq=1),

keras.callbacks.LambdaCallback(on_epoch_end=log_confusion_matrix)

]

tf.keras.backend.clear_session()

model.fit(X_train, y_train,

epochs=15,

batch_size=128,

validation_data=(X_test, y_test),

callbacks=callbacks) Vídeo 3. Matriz de confusión de un modelo de clasificación con TensorBoard. Como podemos observar, resulta muy útil usar está herramienta como ayuda para mantener un registro de todos las métricas relacionadas con el entrenamiento de nuestras redes neuronales. En un artículo posterior trataremos la optimización de hiperparámetros de nuestra red. TensorBoard también se puede usar para visualizar la evolución de la precisión y métricas de performance de los modelos con la finalidad de poder elegir los parámetros que se pueden considerar como óptimos para el dataset que tenemos disponible y el problema que queremos resolver.

11 de noviembre de 2020

AI & Data

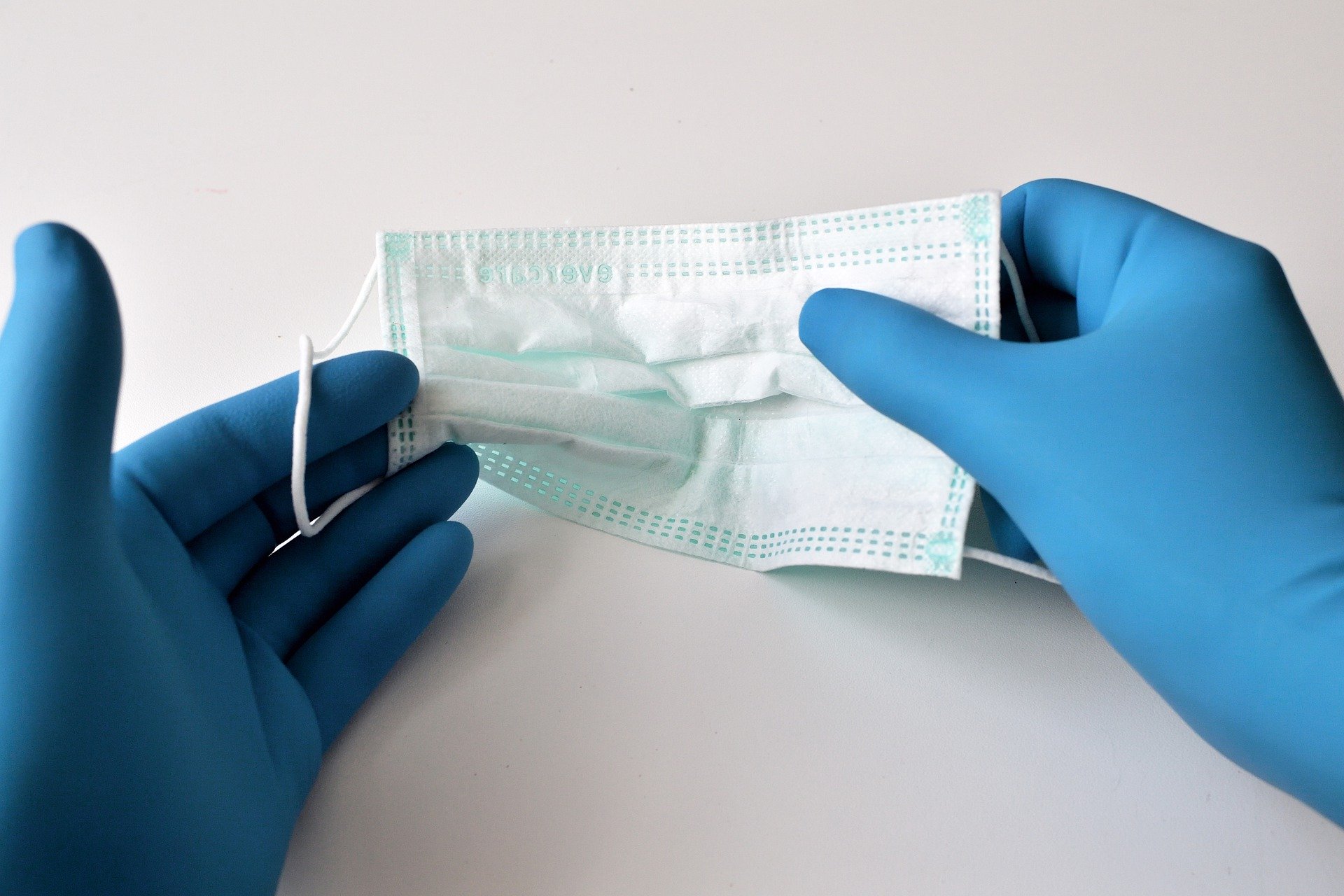

IA para detectar EPIs y Distancia Social

Dadas las circunstancias actuales, de la pandemia que estamos viviendo, desde el departamento de Ideas Locas seguimos interesándonos por todas aquellas soluciones que puedan ofrecer algún tipo de ayuda, en especial cuando están relacionadas con Machine Learning y Deep learning. En el anterior artículo sobre IA, hablamos de cómo se podría abordar la detección de afecciones respiratorias haciendo uso de Transfer Learning. En este artículo traemos una serie de soluciones que, haciendo uso de visión artificial, nos permiten determinar: si un sujeto lleva puesta, o no, una mascarilla; si esa persona lleva, o no, guantes; si dentro de un determinado entorno se está manteniendo la distancia de seguridad. En el artículo realizado a finales de mayo por Fran Ramírez en elladodelmal pudimos ver una prueba de concepto (PoC) adaptada a Raspberry Pi para la detección de rostros con mascarilla, para que, cualquier persona con un pequeño dispositivo en casa, pueda hacer uso de esta PoC. Detección de mascarillas en rostro Empecemos viendo cómo podemos crear un motor de visión artificial que nos permita determinar si una persona lleva la protección facial adecuada. El código lo tenéis disponible en el siguiente repositorio. Para realizar un detector de máscara facial personalizado, necesitamos dividir nuestro proyecto en dos fases distintas: Entrenamiento: aquí nos enfocaremos en cargar nuestro conjunto de datos de detección de máscara facial desde el disco, entrenar un modelo (usando Keras / TensorFlow) en este conjunto de datos y luego serializar el detector de máscara facial en local; Despliegue: Una vez que el detector de máscara facial está entrenado, podemos pasar a cargar el detector de máscara, realizar la detección de la cara y luego clasificar cada cara como Mask o No Mask. Dataset El conjunto de datos usados se ha obtenido del siguiente repositorio y se ha completado con algunas imágenes más de individuos de distintas etnias para garantizar un modelo más robusto. En total, el conjunto de datos consta de 1.442 imágenes que pertenecen a dos clases: Con máscara: 723 imágenes Sin máscara: 719 imágenes Este método es, en realidad, mucho más fácil de lo que parece una vez que aplicamos puntos de referencia faciales al problema. Los puntos de referencia faciales nos permiten inferir automáticamente la ubicación de las estructuras faciales, que incluyen: ojos, cejas, nariz, boca y contorno del rostro. Para obtener la Region of Interest (ROI) que enmarca el rostro: Entendemos que incluir la máscara en las imágenes y tapar ciertos landmarks ayudará al modelo a discretizar las muestras satisfactoriamente. Sobre el dataset disponible se hace data augmentation durante el entrenamiento: Rotación aleatoria de cada imagen de hasta 20 grados; Desplazamiento en altura y anchura de hasta el 20% de la dimensión de la imagen; Horizontal flipping; 'zoom_range' y 'shear_range' de 0.15 Entrenando el modelo Se usa Keras y TensorFlow para entrenar a un clasificador para detectar automáticamente si una persona usa una máscara o no. Para llevar a cabo esta tarea, ajustaremos la arquitectura MobileNet V2, una arquitectura altamente eficiente que se puede aplicar a dispositivos integrados con capacidad computacional limitada (por ejemplo, Raspberry Pi, Google Coral, NVIDIA Jetson Nano, etc.). Ejecutando el siguiente comando: $ python train_mask_detector.py --dataset dataset Se lanza un entrenamiento que terminará cuando la condición de EarlyStopping implementada se cumpla. Lo que estamos haciendo es un fine-tuning de MobileNetv2 para ahorrar tiempo y garantizar una buena predicción. Se obtienen dos checkpoints tras el entrenamiento: mask_detector_model.h5 y mask_detector.model. Actualmente, la precisión sobre el test dataset está alrededor del 98%, lo suficientemente alta como para considerar que el modelo de clasificación es de buena calidad. Detectando en vídeo Nuestro detector de mascarillas COVID-19 también puede funcionar en tiempo real. Simplemente ejecutamos en terminal: $ python detect_mask_video.py Para poder servir en video, desde la webcam de nuestro dispositivo, las predicciones de nuestro modelo. En el siguiente vídeo encontraréis un ejemplo de detección en tiempo real. Vídeo 1:Comprobando el uso de mascarillas en tiempo real. Detección de guantes Continuamos con un modelo que "trackea" las manos de un sujeto en un vídeo y, por otro lado, determina si lleva puestos, o no, guantes. El código está disponible en este siguiente enlace. Para ello, se hace uso del siguiente repositorio y de un modelo entrenado en Teachable Machine, herramienta de la que ya hemos hablado en este blog, cuyo checkpoint también se facilita en el código enlazado. En la carpeta Teachable Machine Gloves Detection se incluye todo el material descargable de ese servicio. Para entrenar este último modelo de Machine Learning, se han tomado aproximadamente unas 1000 fotografías de manos con guantes (gloves-on) y otras 1000 fotografías de manos sin guantes (gloves-off) en diversas posiciones, siguiendo una estrategia similar de data augmentation a la especificada en el apartado anterior. Para poder servir de manera rápida este modelo lanzamos una predicción sobre cada imagen servida por la webcam y lo mezclamos con el modelo de detección y seguimiento de manos. Detectando en vídeo Para poder hacer uso de la PoC tras hacer un setup del entorno virtual necesario, simplemente se tiene que ejecutar el script. $ python detect_single_threaded_gloves.py Un ejemplo rápido de cómo funciona se facilita en el siguiente vídeo. Video 2. Tracking de manos y detección de guantes a través de la webcam. Comprobando que se respeta la distancia social De manera muy rápida hemos investigado la posibilidad de medir la distancia social COVID-19 usando OpenCV, Deep Learning. Este código está basado en el siguiente artículo de pyimagesearch. Los pasos para construir un detector de distanciamiento social incluyen: Aplicar la detección de objetos para detectar a todas las personas (y solo a las personas) en una transmisión de video Calcular las distancias por pares entre todas las personas detectadas De acuerdo a las distancias recogidas, verificar si dos personas están separadas por menos de N píxeles. Todos los detalles del código implementado lo tenéis en este tercer repositorio de GitHub. Cálculo de las distancias entre sujetos Para su uso, simplemente ejecutamos: $ python social_distance_detector.py --input input.mp4 \ --output output.avi --display 0 Aspectos a mejorar El detector de distanciamiento social no aprovecha una calibración de cámara adecuada, lo que significa que, para medir la distancia entre individuos, lo que realmente estamos haciendo (hasta ahora) es medir las distancias en píxeles. Claramente, es una buena solución si se trata de un estudio en 2D pero, en este caso, como estudiamos un caso tridimensional, este aspecto debía mejorar. Por lo tanto, el primer paso para esta mejora de nuestro detector de distanciamiento social es utilizar una calibración de cámara adecuada. Una vez hecho esto, podremos calcular unidades de medida reales (en lugar de píxeles). En segundo lugar, debe considerar aplicar una transformación de arriba hacia abajo de su ángulo de visión. En este punto Marta Vilá, recientemente incorporada al equipo de Ideas Locas, se puso manos a la obra y desarrolló una rutina que nos permite corregir la distorsión introducida en la perspectiva de la imagen. Figura 1. Corrección vista aérea desde una cámara en vivo de la Plaza de España en Roma. Además, nos topamos con otra implementación que permitía estimar el grado de ocupación de un volumen definido por el usuario sobre un video. El repositorio con todo el código necesario puede encontrarse en el siguiente enlace. Video 3. Monitorización de la distancia de seguridad en un entorno elegido por el usuario. Cómo habéis visto, siguiendo siempre la misma estrategia de entrenamiento de modelos de clasificación de imágenes y haciendo uso de librerías como Keras u OpenCV, podemos crear o aprovechar herramientas de manera muy rápida que pueden ayudarnos a controlar ciertos entornos. Juntando todas soluciones, por ejemplo, podemos impedir la entrada a una sala de reuniones a una persona si no lleva mascarilla y/o guantes o incluso, si, dentro de un entorno controlado, mantienen la distancia de seguridad.

23 de junio de 2020

AI & Data

¿Qué es el self-supervised learning?

Self-supervised learning (o aprendizaje auto-supervisado en castellano) es un término que se refiere a un tipo de aprendizaje no supervisado enmarcado dentro de un problema de aprendizaje supervisado. Es una técnica de aprendizaje relativamente reciente donde los datos de entrenamiento se etiquetan de forma autónoma. Los datos se etiquetan encontrando y explotando las relaciones (o correlaciones) entre diferentes inputs al modelo. Este tipo de aprendizaje está ganando cada vez más visibilidad en investigación en Deep Learning. Este artículo tiene como finalidad hacer una breve presentación del self-supervised learning y cómo éste está dejando su impronta en el Machine Learning. Los distintos tipos de aprendizaje En ocasiones, explicar la diferencia entre el aprendizaje no supervisado, semi-supervisado y totalmente supervisado puede resultar arduo, por no hablar del aprendizaje reforzado. Os recordamos, por si necesitáis poneros en contexto, que en el blog se ha escrito sobre los dos principales paradigmas de aprendizaje que nos podemos encontrar en el mundo del Machine Learning. Sobre aprendizaje semi-supervisado también podéis consultar este post. No debemos confundir self-supervised learning con el aprendizaje no supervisado. Tal y como declaraba Yan LeCun el año pasado a través de Twitter: Ahora lo llamo "aprendizaje auto-supervisado", porque "no supervisado" es un término que se presta a confusión. Yan LeCun. 30 de abril de 2019. Twitter. En self-supervised learning, el sistema aprende a predecir parte de su entrada a partir de otras partes de su entrada. En otras palabras, una parte de la entrada neuronal a una red se utiliza como elemento de supervisión para un predictor alimentado con la parte restante del input. Este tipo de aprendizaje utiliza muchas más señales de supervisión que el aprendizaje supervisado, y mucho más que el aprendizaje reforzado. Es por eso que llamarlo "sin supervisión" es totalmente engañoso. Se puede aprender más sobre la estructura del mundo a través del aprendizaje auto-supervisado que de los otros dos paradigmas. La principal razón: los datos son ilimitados y el feedback proporcionado por cada ejemplo es enorme. El paradigma del aprendizaje supervisado El aprendizaje supervisado es un paradigma arduo, que requiere recolectar cantidades masivas de datos, limpiarlos, llevar a cabo un etiquetado manual, entrenar y perfeccionar un modelo diseñado específicamente para el caso de uso de clasificación o regresión que desee resolver, y luego usarlo para predecir etiquetas para datos desconocidos. Por ejemplo, con imágenes, recopilamos un conjunto de datos de imágenes grandes, etiquetamos los objetos en imágenes manualmente, entrenamos la red y luego la usamos para un caso de uso específico. Este tipo de aprendizaje, si bien es fácil de entender, dista bastante de la manera de aprender que tendría, por ejemplo, una persona. Aprendemos principalmente de manera no supervisada y reforzada, utilizando la curiosidad y el resultado de prueba-error. También aprendemos de manera supervisada, pero podemos aprender de muchas menos muestras, ya que si en algo se distingue el ser humano es en que es bastante bueno a la hora de generalizar y abstraer información. Self-supervised learning Self-supervised learning guarda similitudes con el aprendizaje no supervisado porque el sistema aprende sin usar etiquetas proporcionadas explícitamente como entrada. Pero también difiere de éste porque no estamos aprendiendo la estructura inherente de los datos. El aprendizaje auto-supervisado, a diferencia del aprendizaje no supervisado, no se centra en la agrupación, la reducción de dimensionalidad, los motores de recomendación, la estimación de densidad o la detección de anomalías. Una aplicación al PLN: BERT El aprendizaje auto-supervisado ha tenido un enorme éxito en el procesamiento del lenguaje natural. Por ejemplo, el modelo BERT de Google y técnicas similares producen excelentes representaciones de texto. Fig. 2. A great summary of how self-supervised learning tasks can be constructed (Image source: LeCun’s talk) BERT es un ejemplo claro de caso satisfactorio de aprendizaje auto-supervisado. Se le puede mostrar una secuencia de palabras en la entrada, se oculta un 15% de las palabras y se le pide al algoritmo que prediga las palabras que faltan (o una distribución de palabras). Este es un ejemplo de Autoencoder enmascarado, en sí mismo un caso especial de Denoising Autoencoder. Esta terminología referente a redes profundas ya la hemos tratado en este blog (ver artículo) sobre cómo los Autoencoders funcionan muy bien dentro de un paradigma no supervisado. Fig. 3. Illustration of context encoder. (Image source: Pathak, et al., 2016) Pero el texto es un espacio discreto en el que las distribuciones de probabilidad son fáciles de representar. Una persona es capaz de determinar el significado semántico de una palabra a partir del contexto cuando aparece cerca de otra palabra. Por ejemplo, el adjetivo “fría” da a entender algo diferente si se pone detrás del sustantivo “persona” o detrás del sustantivo “cerveza”. Del mismo modo, en Machine Learning, el algoritmo Word2Vec predice el contexto semántico de una palabra en función de las palabras circundantes. La investigación detrás self-supervised learning sigue el mismo principio de identificación automática, extracción y uso de señales de supervisión. Aplicaciones a otros campos Hasta ahora, enfoques similares también han funcionado para imágenes o videos a pesar de la dificultad a la hora de representar distribuciones en espacios continuos de alta dimensión, como muestra su reciente incorporación como soporte a problemas relativos al mundo de la robótica y del aprendizaje reforzado. En este enlace y en este otro se puede consultar cómo los algoritmos auto-supervisados se pueden utilizar para sacarle el máximo provecho a datos sin etiquetar. Aprendizaje reforzado profundo (Deep Reinforcement Learning) El aprendizaje reforzado profundo (Deep Reinforcement Learning) ha mostrado resultados notables en juegos y simulación. En los últimos años, el aprendizaje por refuerzo ha conquistado muchos juegos que anteriormente se consideraban prohibidos para la inteligencia artificial. Los programas de IA ya han barrido a los campeones mundiales en StarCraft 2, DOTA y el famoso juego de mesa chino Go. Pero la forma en que estos programas de IA aprenden a resolver problemas es drásticamente diferente de la de los humanos. Básicamente, un agente comienza sin ningún tipo de "conocimiento" del entorno y sólo se le proporciona un conjunto básico de acciones que puede realizar en su entorno. Luego, la IA se queda sola para aprender a través de prueba y error cómo generar la mayor cantidad de recompensas (por ejemplo, evitar perder una vida o maximizar la puntuación de un intento). Y aquí es donde el self-supervised learning está demostrando que puede ayudar también a los problemas que tienen cabida dentro del aprendizaje reforzados. Este modelo funciona cuando el espacio del problema es simple y tiene suficiente potencia de cómputo para ejecutar tantas sesiones de prueba y error como sea posible. En la mayoría de los casos, a los agentes de aprendizaje reforzado les lleva una cantidad elevada de intentos para dominar un entorno. Esto es computacionalmente costoso y sólo gigantes como Google se pueden permitir realizar investigaciones de alta calidad al respecto. En el Departamento de Ideas Locas ya profundizamos en el Aprendizaje Reforzado Profundo en esta serie de artículos y webinars.

22 de abril de 2020

AI & Data

Suplantación con un selfie y Deep Learning

A pesar del estado de alerta que estamos viviendo en la actualidad en el departamento Ideas Locas CDCO no descansamos, y seguimos investigando activamente todo lo relacionado con el Machine Learning y el Deep learning. Una de las líneas de investigación del departamento está centrada en el análisis y prevención de las Fake News, en especial aquellas generadas a partir de Deepfakes. Podéis echar un vistazo a esta investigación sobre generación de contenido no legítimo en el siguiente enlace. En el artículo de hoy queremos enseñaros de una manera lúdica lo fácil que resulta suplantar a un individuo haciendo uso única y exclusivamente de una fotografía del rostro o selfie. La mayor parte de las investigaciones centradas en suplantación de identidad con las tecnologías de Deepfakes hacen uso de Variational Autoencoders (VAEs) y General Adversarial Networks (GANs) tomando como fuente de entrenamiento una gran cantidad de imágenes del usuario a suplantar. A mayor número de muestras de la víctima, mayor calidad en el modelo y mayor credibilidad en la suplantación. Si no estáis tan familiarizados con estos términos aquí tenéis este artículo o este otro donde introducimos algunos conceptos básicos sobre este tipo de arquitecturas profundas. Figura 1 : Esquema de una Generative Adversarial Network (GAN) (Fuente) El principal inconveniente de este tipo de arquitecturas es que no sólo se necesitan muchas muestras para entrenarlas sino también mucho tiempo y una elevada capacidad de cómputo. Google Colab Para todo esto vamos a lanzar un Jupyter Notebook en Google Colab que nos permitía hacer un rápido uso de un repositorio muy interesante, como veremos más adelante. En Ideas Locas nos encanta Google Colab porque permite, no sólo realizar pruebas rápidas, sino también hace posible la democratización del Machine Learning y del Data Science para todo el mundo - desde investigadores en Inteligencia Artificial hasta gente no ducha con esta disciplina - y facilita el que podamos disfrutar de la potencia de estos recursos independientemente del dispositivo desde el que se consulte. Simplemente te tienes que preocupar por correr cada una de las celdas de código del Jupyter Notebook desplegado, editarlas si lo deseas y jugar conforme vayamos ganando destreza en el manejo del código. Un proyecto interesante Hace poco nos encontramos con el siguiente proyecto: First Order Motion Model for Image Animation. Esta línea de investigación, muy bien llevada, permite generar una secuencia de vídeo a partir de una imagen fuente siguiendo como patrón el movimiento de un vídeo de referencia. Figura 2. Esquema de la solución presentada por Siarohin et al. (2019) (Fuente) Lo más sorprendente de esta herramienta es que permite obtener resultados de muy buena calidad sin ningún tipo de información relativa a los recursos multimedia usados y en muy poco tiempo. En este enlace os facilitamos la página del proyecto y en este otro el enlace al GitHub donde podéis encontrar todo el código asociado. A continuación, tenéis un ejemplo de lo que se puede conseguir con este repositorio. No es habitual ver a Lisa Gherardini gesticular como Donald Trump. Video 1. Motion transfer from driving video (Donald Trump) to source image (Mona Lisa) Siempre y cuando se mantengan las mismas orientaciones del rostro, el resultado es bastante creíble y de buena calidad. ¿Quieres probarlo? Para poder cambiar la imagen fuente y el video de referencia a vuestro gusto, os hemos preparado un Jupyter de prueba. Podéis abrir el siguiente Gist y clicar en Open in Colab en la parte superior del cuaderno. Siguiendo las instrucciones, seguro que conseguís resultados divertidos que hagan más llevadera la cuarentena.

25 de marzo de 2020

AI & Data

Analiza tus datos con Embedding Projector de Tensorflow

Los datos son el combustible de la Inteligencia Artificial. En estado bruto, sin procesar, tienen una utilidad bastante limitada, pero una vez que son analizados y se procede a estructurarlos y agregarlos, los usos de los datos parecen casi ilimitados. Además, con los datos sucede algo bastante especial, y es que cuantos más datos estén disponibles, mejor. Muchas veces su calidad está en la propia diversidad y cantidad de los datos y esto es muy relevante para la IA. En este artículo, veremos una herramienta llamada Embedded Projector, que nos permite visualizar datos de altas dimensiones fácilmente para que podamos entender qué aprende un modelo sobre los datos. Figura 1. Embedding del término "Linux" junto con varios vecinos de acuerdo al modelo Word2Vec visualizado haciendo uso de t-SNE. Procesado de datos El preprocesamiento de datos constituye una tarea imprescindible en el desempeño de un científico de datos. Para poder obtener un resultado final óptimo tras la aplicación de un modelo a un determinado dataset, es necesario transformar los datos de entrada para que el algoritmo encargado de procesar la información funcione correctamente. Limpieza de datos El primer paso está asociado a la limpieza de los datos – data cleaning –subdividido tal y como se especifica a continuación: Limpieza de datos o data cleansing: se eliminan todos aquellos datos que puedan contener errores. Identificación de características: se seleccionan sólo aquellas características que se ven necesarias para caracterizar los modelos. Corrección de errores en los datos: cualquier fallo en el contenido de un string o un valor numérico en un campo alfanumérico se deben identificar y corregir. Estandarización de los datos: esta fase se destina a normalizar y tanto variables numéricas como categóricas en un dataset. Una vez los datos han sido limpiados, se procede a la integración de los mismos de acuerdo a los formatos definidos para el modelo que deseamos implementar, como por ejemplo integrar todos los datos en un fichero .csv, en una base de datos con una determinada estructura prefijada, en un Pandas Dataframe, etc. Transformación de los datos El siguiente paso corresponde a la transformación de los datos – data transformation – muy similar a la fase de estandarización de data cleaning, donde se corrigen o mitigan inconsistencias presentes en los datos a través de técnicas de normalización, la estandarización o el suavizado de datos. Reducción de datos La fase final se corresponde con la reducción de datos – data reduction – dedicada a la eliminación de información que no sea útil a los modelos de Machine Learning. La reducción de la dimensión implica la transformación de los datos a nuevas dimensiones (siempre a un número menor de dimensiones) de manera que se facilite el descarte de algunas de ellas minimizando la pérdida de información. Los problemas a gran escala provocan varias dimensiones que pueden llegar a ser muy difíciles de visualizar. Algunas de las técnicas más utilizadas de reducción de datos son Principal Component Analysis (PCA) o t-Distributed Stochastic Neighbor Embedding (t-SNE), como se verá a continuación. Aquí es donde entra la necesidad de los Embeddings. Embeddings Los Embeddings son ampliamente utilizados en Machine Learning, desde sistemas de recomendación hasta Procesado de Lenguaje Natural. Los científicos de datos necesitan explorar las propiedades de un dataset, y una forma de realizar el análisis es mediante su visualización. Embedding Projector cuenta una visualización precargada para el conjunto de datos MNIST, el conjunto de datos Iris, Word2Vec y GNMT Interlingua con el que poder jugar y acostumbrarse a la herramienta. De forma adicional, proporciona una opción para cargar sus propios datos de embeddings para su visualización. Uso de la aplicación Embedding Projector Esta aplicación web nos permite consultar rápidamente los Embeddings de nuestro modelo y representarlos en un número menor de dimensiones; en este caso dos o tres. Aquí hay una visualización de las diez mil imágenes del MNIST dataset coloreadas por su etiqueta haciendo uso de PCA. Video 1. Análisis de Principal Component Analysis en 3D para MNIST dataset. En el vídeo anterior observamos que la aplicación que consta de cinco paneles distintos. Panel de datos (arriba a la izquierda) donde podemos elegir qué dataset examinar. Un panel de visualización (centro) es el área donde se muestran los datos. Panel de proyecciones (abajo a la derecha): podemos elegir el tipo de proyección aplicar a la visualización de nuestros datos Panel de inspectores (derecha), donde podemos buscar puntos particulares y ver una lista de vecinos más cercanos en base a distancia euclidiana y distancia de coseno. El panel de marcadores (inmediatamente debajo del panel de datos) nos permite guardar el estado actual - incluidas las coordenadas calculadas de cualquier proyección - como un pequeño archivo que luego se puede compartir. Otra de las proyecciones disponibles dentro de un paradigma no supervisado o semi-supervisado es la mostrada en el siguiente video. Video 2. Análisis de t-SNE para MNIST dataset en 3D y 2D. t-SNE o t-distributed Stochastic Neighbour Embedding visualiza datos de alta dimensión al dar a cada punto de datos una ubicación en un mapa bidimensional o tridimensional. De esta forma se encuentran grupos en los datos. Arriba se observa cómo los dígitos similares están claramente agrupados en una misma vecindad. Otras proyecciones que tenemos disponibles son: Custom es una proyección lineal sobre los ejes horizontal y vertical especificada utilizando las etiquetas de datos. Las proyecciones personalizadas ayudan principalmente a descifrar las "direcciones" significativas en los conjuntos de datos. UMAP: acrónimo de Uniform Manifold Approximation and Projection for Dimension Reduction. t-SNE es una técnica excelente para visualizar conjuntos de datos de alta dimensión, pero tiene ciertos inconvenientes, como un alto tiempo de cálculo y pérdida de información a gran escala. UMAP, por otro lado, trata de superar estas limitaciones, ya que puede manejar conjuntos de datos bastante grandes con facilidad y al mismo tiempo preservar la estructura de datos local y global. A continuación podéis ver cómo se agrupan las muestras haciendo uso de UMAP. Video 3. UMAP en acción para MNIST dataset en 3D. Conclusión La herramienta Embedding Projector facilita la tarea de visualizar Embeddings de datasets de alta dimensionalidad, permitiendo abstraernos de la complejidad de los algoritmos involucrados. Os animamos a investigar al máximo esta herramienta, a jugar con los Embeddings disponibles e incluso, a probar con embeddings creados por vosotros.

26 de febrero de 2020

AI & Data

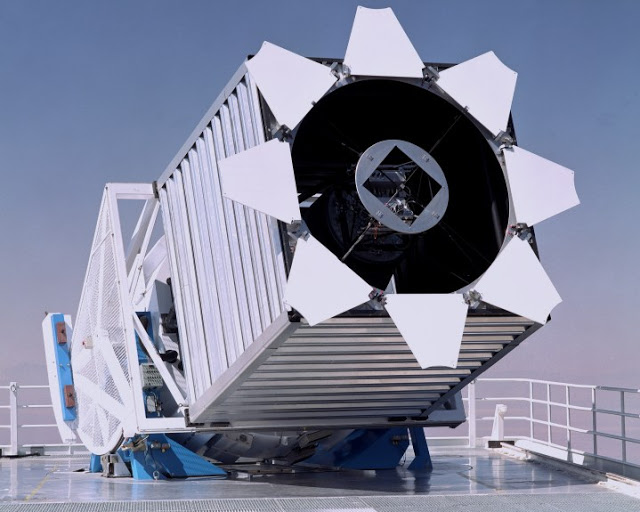

Crea tu modelo Machine Learning con Teachable Machine

Hace unos pocos meses, Google liberó Teachable Machine, una herramienta y un recurso sorprendentes para Machine Learning dirigida al público general. Esta herramienta nos permite abstraernos de la definición del modelo, algoritmo y tratamiento de datos y centrarnos sólo en el despliegue del modelo que generemos. Funciona en el navegador, con una webcam o con archivos que tengamos alojados en local o en Google Drive, y en pocos minutos puede comprender rápidamente cómo un modelo "aprende" a través de una simple demostración de clasificación. Figura 1. Teachable Machine webpage. En marzo del año pasado realizamos una serie de artículos donde mostramos cómo aplicar un algoritmo de clasificación muy sencillo haciendo uso de Random Forest a través de los estimadores de Scikit-Learn. Podéis consultar la serie aquí o en este otro enlace. Para diferenciarnos un poco de la extensa literatura soportada en datasets muy conocidos y usados, decidimos clasificar los datos del Sloan Digital Sky Survey (SDSS) DR14, relacionado con el mundo de la astrofísica, donde se recogen datos fotométricos de estrellas, galaxias y quasars. Podéis encontrar el dataset en el siguiente enlace. Para abrir boca, vamos a usar datos no tan usuales en la demostración del excelente desempeño de este servicio. Recurriremos al Galaxy Zoo classification dataset. Obtener y entender los datos Por poner en antecedentes, Galaxy Zoo es un proyecto de crowdsourcing, donde se pide a los usuarios que describan la morfología de las galaxias en base a imágenes. Se les hacen preguntas como "¿Cómo de redonda es la galaxia?" y "¿Tiene una protuberancia central?". Las respuestas de los usuarios determinan qué pregunta se hará a continuación. Las preguntas forman un árbol de decisión que se muestra en la figura a continuación, tomada de Willett et al. 2013. Figura 2. Árbol de decisión de clasificación de galaxias (Willett et al. 2013) Cuando muchos usuarios han clasificado la misma imagen, sus respuestas se pueden agregar en un conjunto de probabilidades para cada respuesta. A menudo, no todos los usuarios estarán de acuerdo con todas sus respuestas, por lo que es útil cuantificar esta incertidumbre. Determinar la morfología de un objeto es una tarea muy subjetiva. El objetivo del desafío Galaxy Zoo es predecir estas probabilidades a partir de las imágenes de galaxias que se muestran a los usuarios. En otras palabras, construya un modelo de cómo "la multitud" percibe y clasifica estas imágenes. El dataset, consistente en más de 60,000 imágenes, se puedes descargar en el siguiente enlace. Esto significa que estaríamos ante un problema de regresión, no un problema de clasificación: no tenemos que determinar a qué clases pertenecen las galaxias, sino la fracción de personas que las clasificaría como tal. Sin embargo, dada la funcionalidad de Teachable Machine, nos vamos a tomar una licencia y vamos a procesar las imágenes que tenemos para poder separarlas en varias clases morfológicas que se intenten adaptar lo más posible a la secuencia del Hubble. Esta secuencia es un esquema de clasificación morfológica para galaxias. Figura 3. Hubble Tunning Fork. Grosso modo, en su definición más simple, las galaxias: elípticas tienen distribuciones de luz suaves y sin características y aparecen como elipses en las imágenes. espirales consisten en un disco aplanado, con estrellas formando una estructura (generalmente de dos brazos) y una concentración central de estrellas conocida como el bulbo galáctico, que es similar en apariencia a una galaxia elíptica. lenticulares también consiste en un brillante bulbo central rodeado por una estructura extendida, similar a un disco pero, a diferencia de galaxias espirales, sin estructura espiral visible. Ordenando las imágenes Como comentamos con anterioridad, hay alrededor de 60,000 imágenes en el conjunto de entrenamiento, en formato JPEG en color con dimensiones 424x424. Figura 4. Ejemplos de imágenes de galaxias en el Galaxy Zoo dataset. Con esas fotografías también se nos facilita un fichero CSV con el resultado de las clasificaciones realizadas por los usuarios. Hemos usado ese CSV para ordenar las imágenes en base a la clase con voto mayoritario. Haciendo uso del siguiente script de Python, todas las imágenes de la carpeta 'data/' quedarán convenientemente ordenadas. import os

import numpy as np

import csv

import shutil

dir_path = os.path.dirname(os.path.realpath(__file__))

path = os.path.join(dir_path, 'data')

files = os.listdir(path)

def get_all_solutions():

### Import solutions file and load into all_solutions

all_solutions = {}

with open('training_solutions_rev1.csv', 'r') as f:

reader = csv.reader(f, delimiter=",")

labels = next(reader)[1:-1]

for i, line in enumerate(reader):

all_solutions[line[0]] = labels[np.argmax([float(x) for x in line[1:]])]

return all_solutions, labels

def move_pics():

"""

Classify images by its label from training_solutions_rev1.csv

"""

mapping, labels = get_all_solutions()

for type in labels:

if not os.path.exists(os.path.join(path, type)):

try:

os.mkdir(os.path.join(path, type))

except OSError:

print("Creation of the directory %s failed" % path)

else:

print("Successfully created the directory %s " % path)

for file in files:

shutil.move(os.path.join(path, file), os.path.join(path, mapping[file.split('.')[0]], file))

if __name__=="__main__":