Cómo evaluar la madurez en IA para maximizar la inversión y asegurar una adopción responsable

En 2024, una empresa de logística global se enfrentó a un dilema: tras invertir en IA para el mantenimiento predictivo, planificación de rutas automatizadas y el análisis de clientes, sus responsables seguían sin tener respuesta a una pregunta clave: “¿estamos preparados para confiar en la IA para la toma de decisiones críticas?”

Aunque sus modelos de IA funcionaban en la mayoría de los casos, no era posible determinar si la organización contaba con la infraestructura, gobernanza, talento y capacidades necesarias en ética, privacidad, sostenibilidad y Ciberseguridad para cumplir con las nuevas regulaciones o prevenir posibles ciberataques.

Lo que realmente se cuestionaban los responsables no era sobre la tecnología en sí, sino sobre la madurez en IA de su empresa. La falta de claridad sobre este aspecto podía generar incertidumbre en la toma de decisiones estratégicas en un entorno caracterizado por la volatilidad, regulación, competencia y conectividad.

■ La madurez de la IA no puede validarse únicamente mediante documentos o declaraciones: requiere demostraciones tangibles de que las prácticas, controles y mecanismos de gobernanza son operativos y eficaces.

Esta incertidumbre es habitual. En la actualidad, las empresas reconocen que evaluar su nivel y capacidad de madurez en IA constituye una necesidad estratégica, más que un lujo. Esta determinación permite definir si la adopción de la IA se limita a proyectos piloto interesantes o si se integra como un componente resiliente, escalable y confiable dentro del ADN organizacional.

¿Por qué es necesario evaluar la madurez en IA?

Una evaluación precisa, clara, exacta y rigurosa de la madurez en IA proporciona a las empresas una hoja de ruta para la inversión, poniendo en relieve las brechas y desafíos en las capacidades actuales y las ambiciones estratégicas.

Sin ella, la adopción de la IA corre el riesgo de convertirse en una costosa colección de experimentos inconexos con rendimientos pocos claros y, en el peor de los casos, en un lastre en cuanto a la seguridad, privacidad, ética, sostenibilidad y cumplimiento.

En la actualidad existen diversos instrumentos de evaluación de madurez de la IA de organismos como NIST, OWASP y MITRE, quienes han enfocado su misión en ayudar a las organizaciones a evaluar, implementar, orientar y mejorar el uso de la IA desde un enfoque práctico.

■ La madurez objetiva surge cuando las evaluaciones se prueban en contextos reales —a través del rendimiento, la resiliencia bajo rigor y la capacidad de adaptación— en lugar de en marcos teóricos alejados de la práctica.

Marco y modelos para la evaluación de la madurez en IA

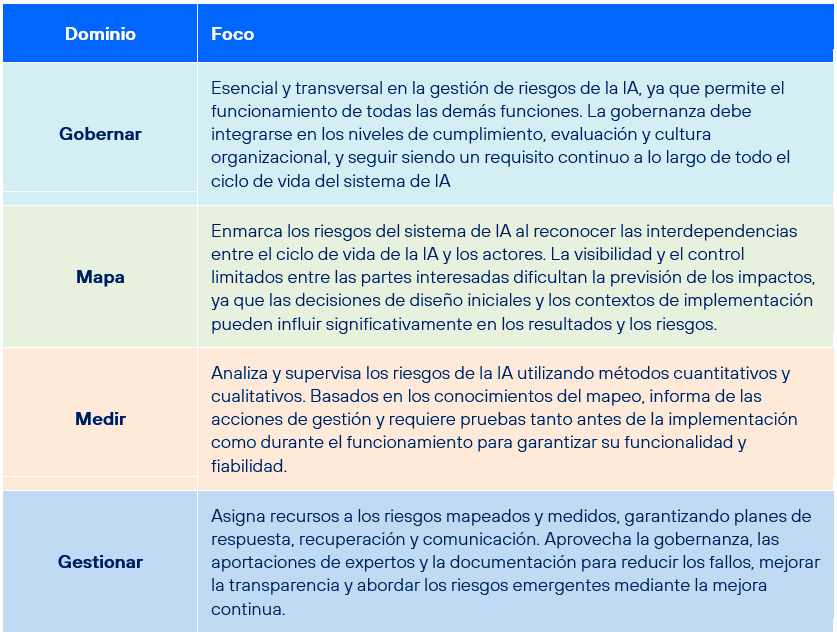

NIST AI Risk Management Framework

El marco NIST AI Risk Management Framework, puede ser de aplicación y utilidad de forma adaptativa para evaluar la madurez de la IA desde un enfoque adaptativo y de riesgos en sus capacidades de Gobernar, Mapa, Medir y Gestionar.

Al enmarcar la madurez de la IA en términos de gobernanza, fiabilidad e integración sociotécnica, este marco permite a las organizaciones evaluar críticamente no solo si los sistemas de IA funcionan según lo previsto, sino también si son fiables, explicables, seguros y están alineados con las expectativas éticas y normativas.

Desde este enfoque se refuerza la toma de decisiones al vincular la evaluación de la madurez con consideraciones de riesgos, lo que ayuda a las organizaciones a identificar las deficiencias en materia de resiliencia, rendición de cuentas y transparencia a lo largo del ciclo de vida de la IA.

Sin embargo, desde un punto de vista crítico y analítico, transforma la evaluación de la madurez de un ejercicio de cumplimiento estático en un proceso dinámico de mejora continua, incorporando la consciencia del riesgo como piedra angular de la adopción responsable de la IA.

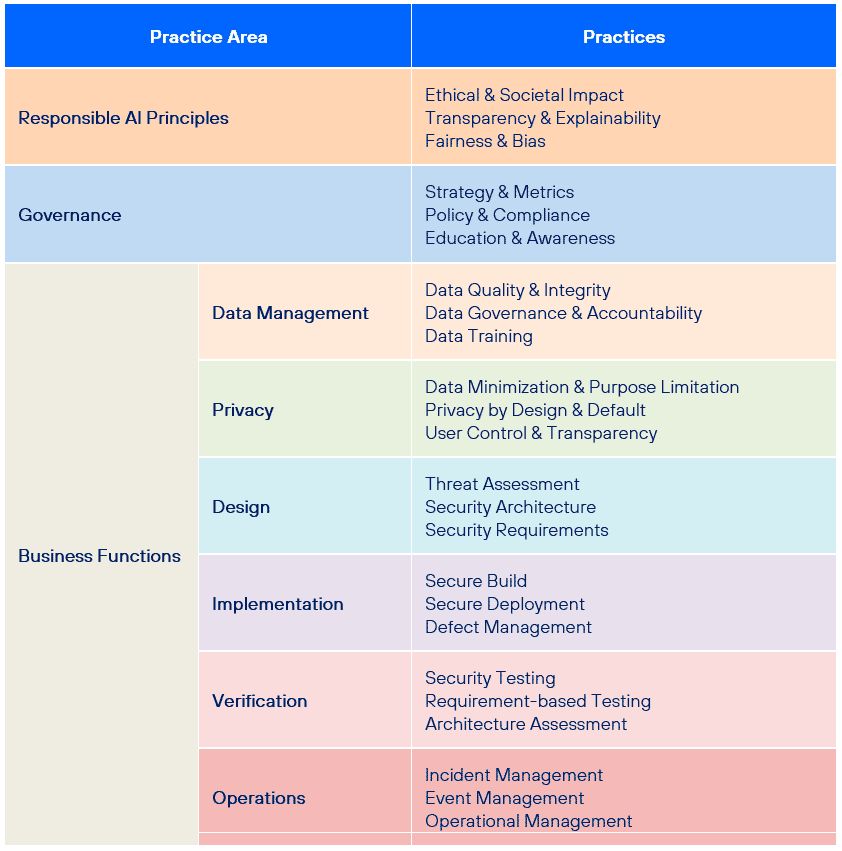

OWASP AI Maturity Assessment (AIMA)

El modelo OWASP AI Maturity Assessment (AIMA), tiene en cuenta los dominios de Responsabilidad, Gobernanza, Gestión de Datos, Privacidad, Implementación, Verificación y Operación, al tiempo que evalúa que los sistemas IA se alinean con los objetivos estratégicos, principios éticos y las necesidades operativas. Se trata de un modelo basado en el OWASP Software Assurance Maturity Model (SAMM).

Hay que destacar que este modelo dispone de escalas de madurez definidas en tres niveles:

- Nivel 1: estrategia integral de IA con métricas.

- Nivel 2: mejora continua.

- Nivel 3: optimización.

La aplicación de AIMA permite no solo evaluar la preparación para la IA, sino también identificar brechas que podrían dar lugar a riesgos éticos, operativos o de ciberseguridad.

Lógicamente, esto facilita un proceso de toma de decisiones más basado en pruebas, lo que garantiza que la adopción de la IA se ajuste a los objetivos de resiliencia de la organización, las expectativas normativas y la sostenibilidad a largo plazo. Por tanto, la evaluación funciona como una herramienta para priorizar las inversiones, fomentar la mejora continua y construir ecosistemas de IA fiables que equilibren la innovación con la seguridad y la responsabilidad.

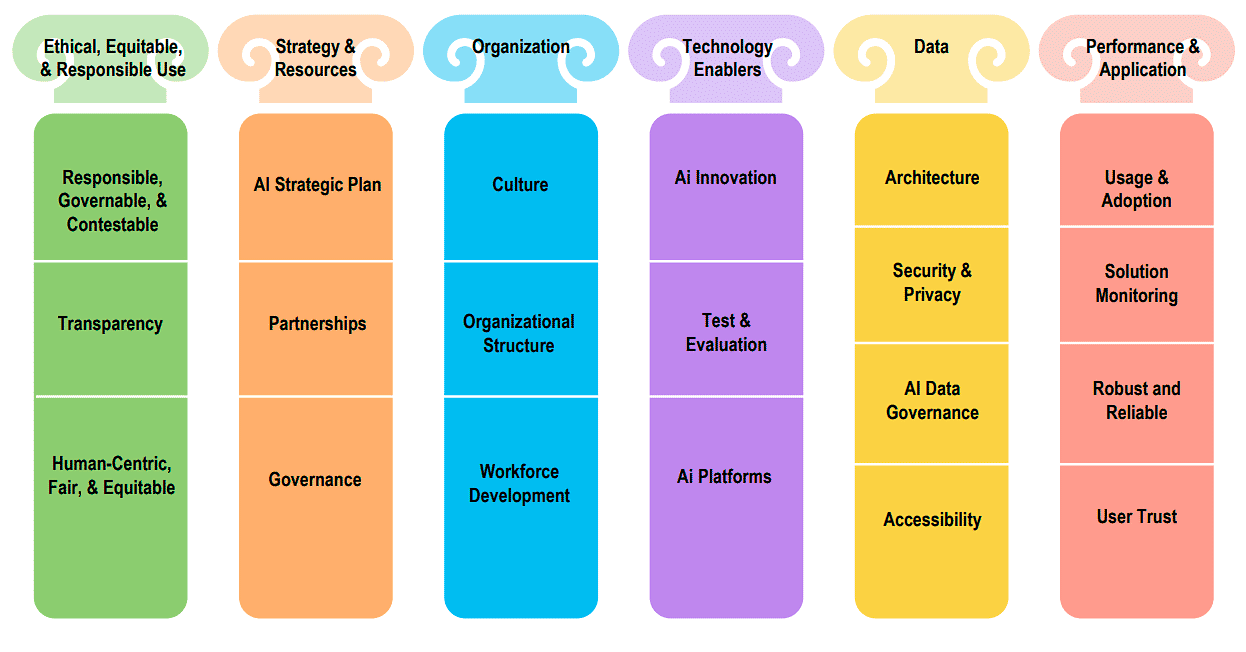

MITRE AI Maturity Model

Además, el MITRE AI Maturity Model en conjunto a su Herramienta de Evaluación (AT) se estructura acorde a los siguientes dominios que son reconocidos como críticos para la adopción exitosa de la IA: Uso Ético, Equitativo y Responsable; Estrategia y Recursos; Organización; Habilitadores de Tecnología; Datos; y Rendimiento y Aplicación.

Fuente: Mitre.

Fuente: Mitre.

Estos pilares y dimensiones se evalúan a través de cinco niveles de preparación, adaptado al Modelo de Integración de Madurez de Capacidades (CMMI), de manera cualitativa y cuantitativa destinados a describir el progreso jerárquico y escalable a lo largo de la adopción de la IA.

A diferencia de las evaluaciones ad hoc o con un enfoque limitado, este marco hace hincapié en la madurez en materia de gobernanza, gestión de riesgos, preparación de la plantilla o fuerza laboral, operatividad y alineación con los objetivos estratégicos.

Fundamentalmente, este enfoque permite a las organizaciones no solo comparar su estado actual, sino también identificar deficiencias —como la supervisión ética, la resiliencia y la adaptabilidad— que a menudo se pasan por alto cuando se evalúa la IA únicamente a través de métricas de rendimiento.

El modelo impulsa decisiones basadas en pruebas, relacionando los niveles de madurez de la IA con los resultados organizacionales y presentando su desarrollo como un proceso progresivo que requiere alinear personas, procesos y tecnología, no como un objetivo estático. Esto eleva la evaluación de la madurez de una lista de verificación de cumplimiento a una herramienta estratégica para la adopción sostenible y responsable de la IA.

Evaluar la madurez de la IA es clave para la resiliencia y la innovación responsable

Evaluar las capacidades de madurez ya no es un ejercicio teórico, sino una necesidad estratégica para empresas y organizaciones que se mueven en un entorno cada vez más digital e interconectado. Estas evaluaciones ayudan a entender no solo dónde están hoy las iniciativas de IA, sino también cómo alinear las inversiones, la gobernanza y las habilidades para lograr un valor sostenible mañana.

Al examinar las capacidades de IA en dimensiones como preparación de los datos, infraestructura tecnológica, gobernanza, seguridad, talento y adopción ética, las organizaciones pueden transformar las evaluaciones de madurez en hojas de ruta viables para la innovación y la resiliencia.

■ En este sentido, evaluar la madurez de la IA no se trata tanto de cumplir con los requisitos sobre el papel, sino de demostrar, a través de acciones medibles, que una organización está preparada para aprovechar la IA de forma responsable, segura y sostenible.

En última instancia, evaluar la madurez de la IA no trata tanto de alcanzar un destino final como de permitir un viaje continuo de adaptación, responsabilidad y confianza. Con el avance de los sistemas de IA y la evolución de los riesgos, oportunidades y marcos regulatorios asociados, las organizaciones que integran la evaluación de su madurez en el proceso de toma de decisiones estratégicas estarán mejor preparadas para implementar la IA de manera responsable, fortalecer su resiliencia y lograr una ventaja competitiva sostenible a largo plazo.

Cloud Híbrida

Cloud Híbrida Ciberseguridad & NaaS

Ciberseguridad & NaaS AI & Data

AI & Data IoT y Conectividad

IoT y Conectividad Business Applications

Business Applications Intelligent Workplace

Intelligent Workplace Consultoría y Servicios Profesionales

Consultoría y Servicios Profesionales Pequeña y Mediana Empresa

Pequeña y Mediana Empresa Sanidad y Social

Sanidad y Social Industria

Industria Retail

Retail Turismo y Ocio

Turismo y Ocio Transporte y Logística

Transporte y Logística Energía y Utilities

Energía y Utilities Banca y Finanzas

Banca y Finanzas Ciudades Inteligentes

Ciudades Inteligentes Sector Público

Sector Público