Quantum Machine Learning: ¿la próxima revolución en la IA?

La IA y el Machine Learning fueron durante décadas el 'patito feo' de las ciencias de la computación por las limitaciones de hardware, lo que dejaba métodos como las redes neuronales confinados a la teoría de los libros y papers académicos. No existía una garantía de que realmente pudieran funcionar, pero hoy en día las redes neuronales dominan el mundo, aun sin llegar a entenderlas del todo.

Aplicaciones como clasificadores, sistemas de recomendación, computer vision o los LLM (ChatGPT y familiares) ya forman parte de nuestra vida. Existen no pocos paralelismos con la computación cuántica, la eterna promesa que poco a poco va vislumbrando un horizonte práctico que, aunque incierto, mueve miles de millones en inversión.

Así que vamos a juntar los dos mundos con más hype del momento: la IA y la computación cuántica. ¿Qué podría salir mal?

El tablero de juego: clásico vs. cuántico

Primero, un disclaimer: aquí nos vamos a centrar en el Quantum Machine Learning (QML), que presupone unas mínimas nociones de lo que va la computación cuántica. Para entender los basics (y dónde está Telefónica Tech), nada como leer la estupenda seríe de posts previos del blog,

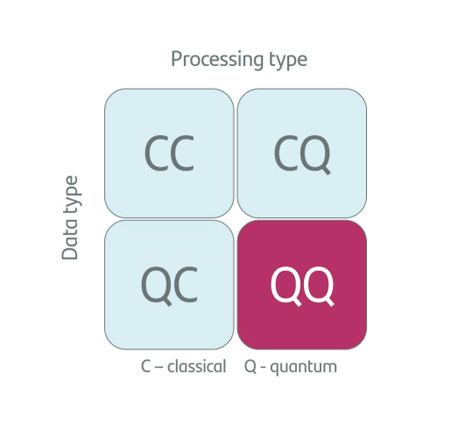

Si vamos a hablar de IA y Machine Learning, primero debemos establecer qué vamos a cocinar (los datos) y en qué horno (el procesamiento). Esto da lugar a cuatro paradigmas fundamentales:

- CC (Datos clásicos, procesamiento clásico): el ML “de toda la vida”. Una regresión logística, una red neuronal para detectar caras o ChatGPT.

- QC (Datos cuánticos, procesamiento clásico): ML clásico para analizar estados cuánticos de experimentos, detectores… aplicaciones en ciencia básica.

- CQ (Datos clásicos, procesamiento cuántico): El "Santo Grial" actual. Usar datos clásicos (imágenes, texto…) en un ordenador cuántico para aprovechar su capacidad de cómputo infinitamente superior.

- QQ (Datos cuánticos, procesamiento cuántico): La visión pura, el sueño de Feynman. Un ordenador cuántico aprendiendo de la naturaleza cuántica (por ejemplo, simulación molecular). Ahora mismo, más ciencia ficción que Star Wars..

Si vamos a hablar de IA y machine learning, primero debemos establecer qué vamos a cocinar y en qué horno.

Centrémonos en ese 'santo grial', en el que usamos un ordenador cuántico para hacer nuestro machine learning más preciso y rápido. El entrenamiento de modelos complejos basados en redes neuronales no es más que un problema de optimización: tenemos un mapa montañoso desconocido (la función de pérdida o loss function), y tenemos que encontrar el punto más bajo del mismo. ¿Hacia dónde y con qué rapidez nos movemos? ¿Cuándo sabemos si el mínimo que hemos encontrado es realmente el mínimo del mapa? ¿Cuánto debería influir nuestro entorno en la decisión de la dirección de desplazamiento?

Entrenar un pedazo de red neuronal es un problema muy complicado, así que toda ayuda desde el punto de vista de potencia de cálculo es bienvenida (de ahí la fiebre por las GPU de Nvidia y los megacentros de datos). En la computación cuántica actual (la llamada NISQ, Noisy Intermediate-Scale Quantum), no tenemos ordenadores perfectos ya que, por las delicadísimas propiedades de estos chips, se cometen demasiados errores difíciles de corregir. Por eso, el enfoque dominante son los Circuitos Cuánticos Variacionales (VQC).

Desafíos en la codificación de datos clásicos en sistemas cuánticos

Esto funciona como un sistema híbrido, en el que la CPU (clásica) le dice a la QPU (cuántica): "Prueba con estos parámetros de rotación en tus qubits" (algo que no se puede hacer en bits tradicionales). La QPU ejecuta el circuito y mide el resultado. La CPU analiza el resultado y le dice: "Mejoramos un poco, ahora ajusta los parámetros de esta otra manera". Y así iterativamente hasta llegar al mejor resultado posible.

Un ordenador cuántico no entiende de archivos JPEG ni de excel.

Es decir, es un problema de optimización muy parecido al que hemos presentado antes. La ventaja teórica es que el 'mapa montañoso' en el espacio de Hilbert (el espacio matemático donde viven los qubits) es inmensamente más rico y dimensional que el espacio clásico. Esto permite, en teoría, encontrar atajos hacia el mínimo global que un ordenador actual jamás vería. ¿Entonces es así de sencillo? Si alguien nos diera un ordenador cuántico, ¿sería plug-and-play?

Lamentablemente, no. Un ordenador cuántico no entiende de archivos JPEG ni de excel. Su idioma son las amplitudes de onda y estados de espín. El encoding (codificación) es el proceso de traducir datos clásicos (la x de toda la vida) a un estado cuántico . Pero claro, si tenemos un dataset de 1 millón de datos, y tardamos 1 millón de pasos en cargarlos en el ordenador cuántico, ya hemos perdido la ventaja exponencial antes siquiera de empezar. Es como tener un Ferrari, pero tener que empujarlo a mano hasta la autopista.

■ Existen técnicas como el amplitude, basis o phase encoding, pero preparar ese estado en problemas reales es tremendamente costoso y requiere circuitos muy profundos que, hoy por hoy, acumulan demasiado ruido. Sin una QRAM (memoria RAM cuántica), que aún no existe físicamente, este es el primer cuello de botella. Pero no es ni mucho menos el último.

En busca del algoritmo perdido

El legendario algoritmo de Shor de 1995 demostró matemáticamente que un ordenador cuántico puede factorizar números exponencialmente más rápido que cualquier algoritmo clásico conocido, rompiendo así la encriptación RSA (basado en la factorización de números gigantescos) que codifica la mayor parte de nuestra información en los sistemas informáticos. Mientras que los mayores superordenadores de hoy en día tardarían miles de millones de años en encontrar la clave, un ordenador cuántico práctico de miles de qubits tardaría apenas unas horas.

En Machine Learning aún no hemos tenido un 'momento Shor': no existe una prueba definitiva de que un algoritmo de QML ofrezca una ventaja exponencial generalizable para problemas de datos clásicos. Existen algoritmos como HHL para resolver sistemas de ecuaciones lineales, la base de muchas técnicas de ML. Es exponencialmente rápido, pero tiene tantas condiciones sobre la entrada y salida de datos que es casi imposible de usar en la práctica para obtener ventaja real.

En Machine Learning aún no hemos tenido un 'momento Shor'.

La esperanza no es la fuerza bruta, sino el kernel trick cuántico (cuya versión clásica se aplica en ML a las Support Vector Machines). Los ordenadores cuánticos pueden calcular distancias entre datos en espacios de dimensiones infinitas de forma natural. Si logramos demostrar que ciertos patrones de datos solo son separables en este espacio cuántico, habremos conseguido una ventaja tangible.

Desafíos técnicos y teóricos en el Quantum Machine Learning

Así que hoy en día, aún estamos en la fase de 'juego científico'. Puede que algún día se pueda entrenar un LLM de forma muchísimo más eficiente y con menos parámetros usando computación cuántica; de momento, los llamados quantum-inspired algorithms ya han demostrado que usar técnicas propias del campo de la mecánica cuántica y sistemas complejos como las tensor networks pueden comprimir modelos de redes neuronales, desde las CNN hasta los LLM, lo que demuestra que la cuántica y la IA están condenadas a entenderse.

Las Quantum Neural Networks (QNN) existen y funcionan en simuladores y chips pequeños. Sin embargo, tienen un problema llamado barren plateau (meseta estéril). Algo así ya sucedía en el ML clásico bajo el nombre vanishing gradient: volvamos a nuestro mapa montañoso e imaginemos que estamos en un valle poco profundo. La pendiente es suave y el terreno es irregular; nos cuesta saber hacia dónde bajar, pero si tenemos paciencia y pasos precisos, encontraremos el fondo. Soluciones como nuevas funciones de activación, conexiones residuales o las puertas de olvido en LSTMs mitigaron el problema.

El Quantum Machine Learning aún permanece en una fase de 'juego científico'.

Pero las barren plateaus cuánticas son mucho peores. Es como si nos soltaran en medio del desierto del Sáhara y nos dijeran que en algún lugar hay un agujero de 1 metro de ancho y 10km de profundidad (la solución óptima). Como el terreno es plano, no importa cuánto tanteemos con el pie o miremos a nuestro alrededor, no tenemos ni idea de si estamos a 1 km o a 1000 km del agujero. El algoritmo se pierde en la inmensidad del espacio de Hilbert y deja de aprender.

Aunque, si el hardware cuántico actual (NISQ) es ruidoso y limitado, y los ordenadores clásicos son robustos pero ciegos a ciertas correlaciones, ¿por qué elegir uno solo?

Quantum Boosting: unión de lo clásico y lo cuántico para maximizar el aprendizaje

Una de las vías más pragmáticas y prometedoras es el uso de técnicas de ensemble. En el aprendizaje automático clásico sabemos que combinar varios modelos 'débiles' (como en un Random Forest) reduce la varianza y mejora la generalización. La idea es crear un 'comité de expertos' heterogéneo, y esto tiene ciertas ventajas. Por ejemplo, la ortogonalidad de los errores, ya que la teoría de ensembles dicta que la combinación de modelos funciona mejor cuando sus errores no están correlacionados.

Supongamos que se entrena un modelo clásico potente para resolver el problema con dignidad, por ejemplo con un 85% de precisión. Tomamos ese 15% de casos donde el modelo clásico falló (los residuos). Ahora, entrenamos un modelo cuántico pequeño específicamente para resolver esos residuos.

Como este modelo cuántico está enfocado en un subconjunto de datos con estructuras 'difíciles', se maximiza su utilidad sin necesidad de cargar todo el dataset en la QPU. Este es el llamado Quantum Boosting, que aprovecha el kernel cuántico solo donde realmente aporta ventaja dimensional.

La combinación de modelos funciona mejor cuando sus errores no están correlacionados.

Conclusión: ¿optimismo o realismo?

El Quantum Machine Learning no es simplemente 'ML pero más rápido', sino un cambio de paradigma. Cabe la posibilidad de que nunca lleguemos a usar ordenadores cuánticos para clasificar fotos de gatos o predecir clics en anuncios (el ML clásico ya es excelente en eso), pero si aún estamos explorando lo que los LLM pueden llegar a hacer, cualquier predicción acerca del futuro de la computación cuántica es más que osada.

Donde seguro que el QML tendrá valor es en el cuadrante QQ: descubrir nuevos materiales, fármacos o entender la física fundamental, procesos inherentemente cuánticos. Ahí el QML juega en casa, porque como dijo Richard Feynman en el cierre de su célebre conferencia de 1981: “La naturaleza no es clásica, maldita sea; y si quieres hacer una simulación de la naturaleza, más vale que la hagas cuántica". Para el resto, seguimos buscando ese algoritmo esquivo que demuestre que el esfuerzo de codificar nuestro mundo clásico en átomos vale la pena.

El Quantum Machine Learning no es simplemente ‘ML pero más rápido’, sino un cambio de paradigma.

Referencias:

- What is Quantum Machine Learning (QML)? | by Be Tech! with Santander | Be Tech! with Santander | Medium

- Visión general | IBM Quantum Learning

- Understanding quantum computing's most troubling problem—the barren plateau

Cloud Híbrida

Cloud Híbrida Ciberseguridad & NaaS

Ciberseguridad & NaaS AI & Data

AI & Data IoT y Conectividad

IoT y Conectividad Business Applications

Business Applications Intelligent Workplace

Intelligent Workplace Consultoría y Servicios Profesionales

Consultoría y Servicios Profesionales Pequeña y Mediana Empresa

Pequeña y Mediana Empresa Sanidad y Social

Sanidad y Social Industria

Industria Retail

Retail Turismo y Ocio

Turismo y Ocio Transporte y Logística

Transporte y Logística Energía y Utilities

Energía y Utilities Banca y Finanzas

Banca y Finanzas Ciudades Inteligentes

Ciudades Inteligentes Sector Público

Sector Público