AI & Data

Quantum Intelligence (parte III): Despliegues en España y nuestro papel en Telefónica

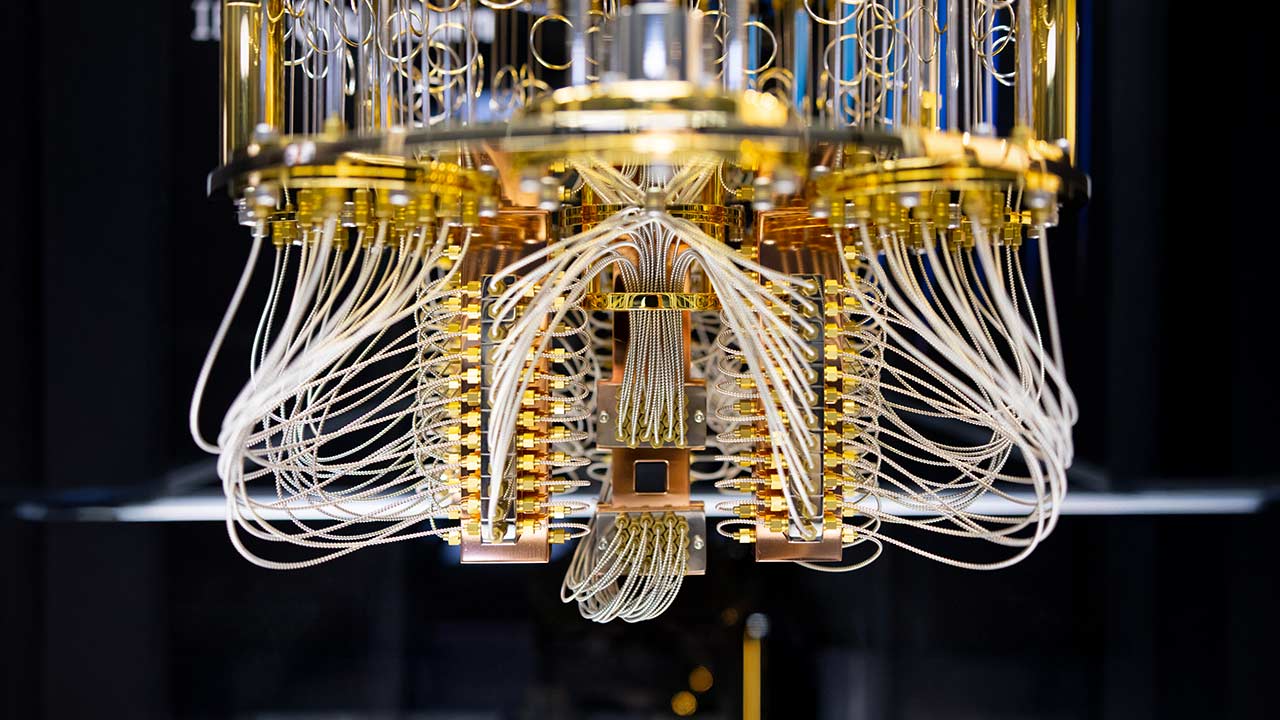

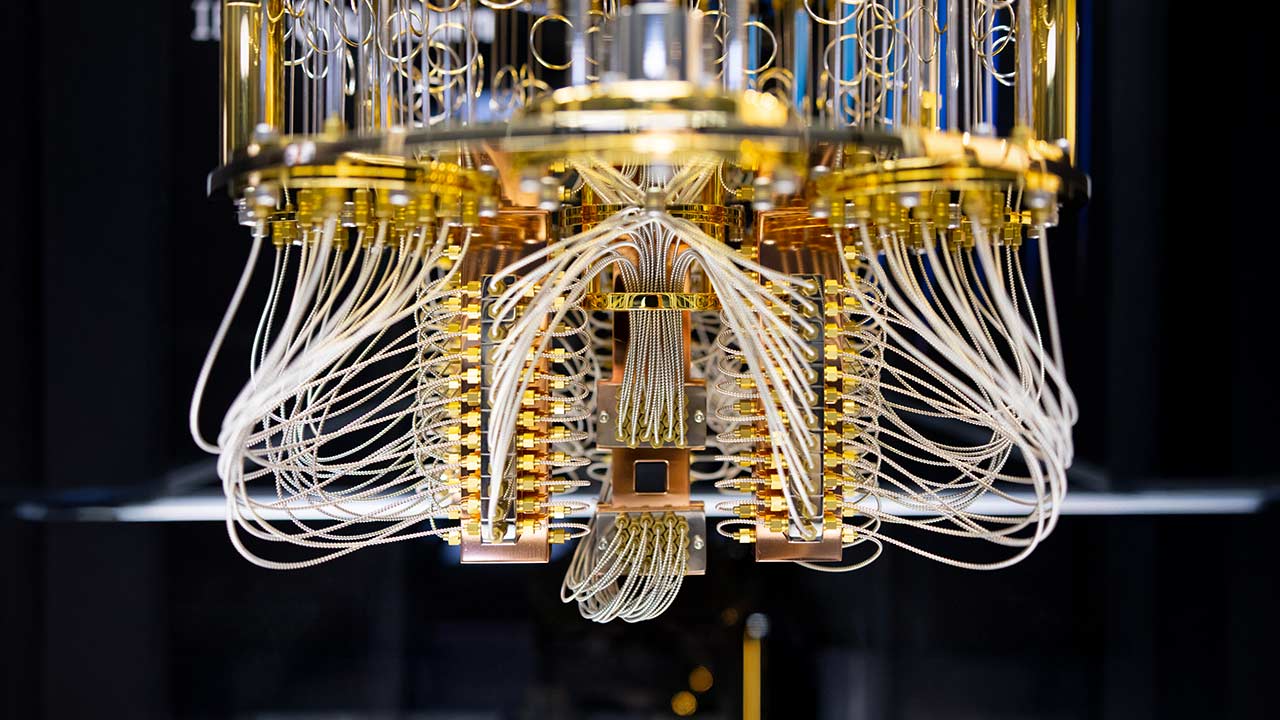

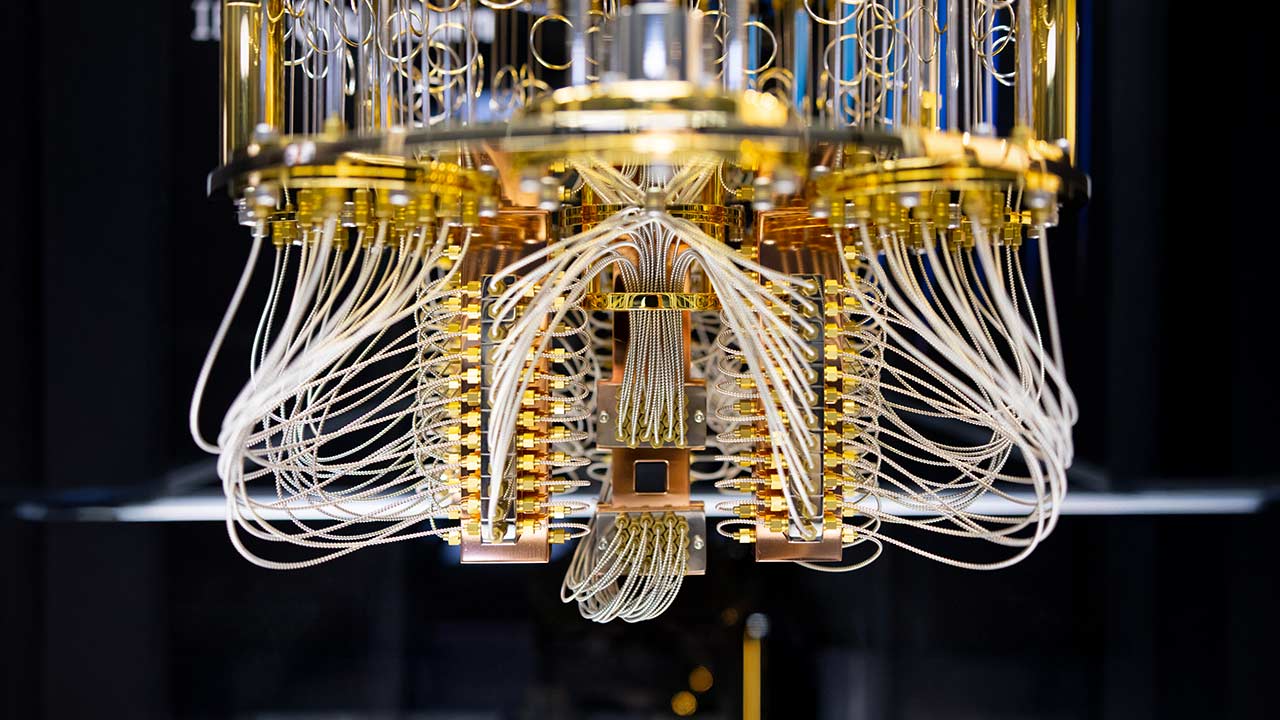

La computación cuántica comienza a aplicarse en áreas como el aprendizaje automático y la optimización. Descubre las posibilidades reales de esta tecnología para abordar problemas complejos y conoce las tendencias actuales, desde Quantum-as-a-Service hasta nuestra posición en el ecosistema cuántico. Te invito a leer una visión práctica y realista de este campo. Cerramos este ciclo con las experiencias reales de despliegues en España y el papel de Telefónica. ______ En España, la computación cuántica ha experimentado un fuerte crecimiento en los últimos años, impulsado por iniciativas tanto públicas como privadas. El país se está consolidando como un nodo estratégico para la aplicación práctica de la tecnología cuántica, con proyectos que combinan innovación tecnológica con socios industriales. Veamos estas iniciativas y qué papel juega Telefónica en ellas Computadores cuánticos en España El proyecto Quantum Spain, impulsado por el Gobierno con una inversión inicial de 22 millones de euros y un plazo de ejecución 2022-2025, es la iniciativa principal del Gobierno central. Coordinado por el Barcelona Supercomputing Center (BSC), integra a centros de investigación y universidades. Entre sus objetivos está la instalación de un ordenador cuántico en el BSC, adquirir simuladores cuánticos HPC y proveer acceso y formación a investigadores. Por otro lado, la otra gran iniciativa de financiación pública en España es BasQ, que es un proyecto liderado por el Gobierno Vasco junto con las Diputaciones Forales, que pretende posicionar a Euskadi como uno de los principales hubs cuánticos del mundo. Gracias a estos dos programas, para finales de 2025 habrá dos ordenadores cuánticos funcionando en España: BSC: Primer ordenador cuántico español con tecnología europea, integrado en el supercomputador MareNostrum 5. Con un límite de 30 qubits físicos ofrecerá acceso en la nube a empresas e investigadores a través de la Red Española de Supercomputación (RES). IBM Quantum System Two en Euskadi: Instalado durante 2025 en San Sebastián, este sistema híbrido (156 qubits) servirá como banco de pruebas para startups y centros tecnológicos vascos, centrados en aplicaciones industriales. Veamos ahora qué papel juega Telefónica en este campo y qué puede aportar. Telefónica y la computación cuántica En Telefónica estamos consolidando nuestra posición en el ecosistema cuántico europeo mediante una estrategia basada en colaboración público-privada y despliegue de infraestructuras especializadas. En 2025 tenemos varios proyectos clave: Alianza con la Diputación de Vizcaya En febrero de 2025, Telefónica España se convirtió en socio tecnológico de la Diputación de Vizcaya para impulsar su estrategia industrial cuántica. Esta colaboración incluye la instalación del primer Digital Annealer de Fujitsu fuera de Japón, un sistema híbrido que combina técnicas quantum-inspired con supercomputación clásica. Alojado en una central de Telefónica en Vizcaya, este equipo resolverá problemas en múltiples industrias. Centro de Excelencia en Tecnologías Cuánticas Presentado en el MWC 2025, este centro coordina todas las iniciativas cuánticas de Telefónica, centrándose en tres pilares: Comunicaciones y ciberseguridad cuántica: Desarrollo de redes cuánticas seguras y migración a algoritmos post-cuánticos para proteger infraestructuras críticas. Computación y simulación: Integración de procesadores cuánticos con supercomputación clásica para casos prácticos en optimización y machine learning. Sensores cuánticos: Investigación en metrología de precisión para telecomunicaciones y monitorización de redes. Colaboración Telefónica Tech e IBM Desde Telefónica Tech colaboramos con IBM en soluciones quantum-safe, integrando tecnologías para proteger datos críticos frente a amenazas futuras de computación cuántica. Esta alianza incluye el despliegue de infraestructuras criptográficas en Madrid y la creación de un laboratorio conjunto. Además de estas colaboraciones públicas, en Telefónica Tech seguimos desarrollando nuestras capacidades internas para poder ofrecer a sus clientes computación cuántica y abordar proyectos para solucionar problemas mediante la combinación de IA y cuántica. Como veis, mientras seguimos viendo avances en hardware y aplicaciones reales, una cosa es segura: la computación cuántica no solo es el futuro, sino que ya está aquí. Así que prepárate para un viaje emocionante. ¡No te lo pierdas! Photo (cc) de un modelo IBM Quantum System One, en Shin-Kawaski para la Universidad de Tokio. IBM Research.

8 de mayo de 2025

AI & Data

Quantum Intelligence (parte II): Problemas (complejos) y soluciones (complejas)

La computación cuántica comienza a aplicarse en áreas como el aprendizaje automático y la optimización. Descubre las posibilidades reales de esta tecnología para abordar problemas complejos y conoce las tendencias actuales, desde Quantum-as-a-Service hasta nuestra posición en el ecosistema cuántico. Te invito a leer una visión práctica y realista de este campo. Te invito a leer una visión práctica y realista de este campo. En esta segunda parte hablaremos de dónde es útil (y dónde no) y de las herramientas disponibles. ______ La computación cuántica está explorando su potencial para abordar desafíos complejos en tres áreas clave: optimización, simulación de sistemas complejos y mejora de procesos en inteligencia artificial y aprendizaje automático. Aunque aún es una tecnología emergente, ya se aplica en casos prácticos donde su capacidad para procesar información de forma distinta a los métodos clásicos ofrece ventajas prometedoras. Optimización Los problemas de optimización, que buscan la mejor solución entre un gran número de posibilidades, son un área donde la computación cuántica destaca. Existen ya algoritmos cuánticos para abordar este tipo de problemas. Ejemplos como la planificación de rutas logísticas o la gestión de cadenas de suministro, requieren evaluar millones de combinaciones para encontrar la solución óptima. La computación cuántica aborda estos desafíos mediante algoritmos como el Quantum Approximate Optimization Algorithm (QAOA), que explora soluciones en paralelo aprovechando la superposición cuántica. En la práctica los resultados de estos algoritmos hay que combinarlos con sistemas clásicos en sistemas que podemos llamar híbridos. Simulación Esta es una de las aplicaciones más naturales para la computación cuántica, ya que los ordenadores clásicos enfrentan limitaciones para modelar sistemas que siguen las leyes de la mecánica cuántica. Por ejemplo, simular moléculas complejas o materiales avanzados requiere recursos computacionales que crecen exponencialmente con el tamaño del sistema. Los procesadores cuánticos, en cambio, pueden representar estos estados de forma inherente, lo que acelera el estudio de interacciones atómicas. Investigadores y empresas están utilizando esta capacidad para diseñar fármacos más eficaces o materiales innovadores. Mejora de la IA y machine learning En el ámbito concreto del machine learning, la computación cuántica se investiga para acelerar tareas como la optimización de parámetros en modelos predictivos. Al procesar información en espacios de alta dimensionalidad, los algoritmos cuánticos podrían identificar patrones en grandes conjuntos de datos. Sin embargo, las limitaciones actuales del hardware obligan a emplear enfoques híbridos, donde la parte cuántica se reserva para subtareas específicas, como la selección de modelos relevantes dentro de un algoritmo de ensamblado (aproximación que ya está disponible en algunas plataformas). Ecosistemas y tecnologías La industria de la computación cuántica está formada por grandes empresas tecnológicas y por startups especializadas. Las grandes empresas tecnológicas están disponibilizando ecosistemas que combinan procesadores cuánticos con servidores clásicos y servicios de Quantum as a Service (QaaS) en los que ofrecen acceso a computadores cuánticos en la nube. Los hiperescalares también participan de este mercado desarrollando su propio hardware (Willow, Majorana, Ocelot, etc.) y librerías y lenguajes de programación (Cirq, Q#). Entre los fabricantes de hardware emergentes, podemos destacar empresas como D-Wave Systems, Atom Computing, Xanadu, IonQ o Quantinuum, entre muchos otros. Herramientas para el desarrollador El desarrollo cuántico depende de frameworks que abstraen la complejidad del hardware. Qiskit se ha convertido en un estándar de facto, seguido por Cirq y Pennylane. Mientras que estas librerías se pueden consumir mediante lenguajes de programación populares como Python, también hay lenguajes específicos para programación cuántica, como Q#. Acceso a la tecnología cuántica Actualmente existen dos vías principales para trabajar con computadores cuánticos: En primer lugar, puedes desplegar un ordenador cuántico. Esta es la opción más costosa pero también la que permite un uso intensivo con presupuesto controlado. Normalmente se instalará un sistema híbrido cuántico-clásico donde los procesadores cuánticos se utilizarán para subtareas específicas donde pueden ofrecer una ventaja. En segundo lugar, y como hemos adelantado, está el Quantum as a Service (QaaS), que es un modelo de servicio en la nube que proporciona acceso remoto a recursos de computación cuántica. Este enfoque permite experimentar con tecnologías cuánticas sin necesidad de realizar inversiones significativas iniciales. QaaS ofrece ventajas clave, como acceso a tecnología de vanguardia actualizada o escalabilidad según las necesidades del proyecto. Quantum vs Quantum inspired En el mercado también existen empresas que venden computación inspirada en lo cuántico en vez de computación cuántica. Es importante entender las diferencias. Quantum vs Quantum Inspired. La computación inspirada en lo cuántico es un enfoque que aplica principios y métodos matemáticos de la física cuántica para desarrollar algoritmos clásicos mejorados, sin necesidad de hardware cuántico real. Hay que apuntar que no puede igualar el potencial de los ordenadores cuánticos para problemas complejos y su rendimiento está limitado por el hardware clásico que lo soporta. Aunque no aprovechan fenómenos cuánticos estos métodos buscan replicar algunas ventajas teóricas de los algoritmos cuánticos para resolver problemas específicos. En esta línea, los sistemas HPC (computación de alto rendimiento) pueden actúar como un puente temporal hacia la adopción de la computación cuántica, especialmente en tareas que requieren procesamiento masivo, pero no dependen de ventajas cuánticas. Por otro lado, y como ya deberías saber a estas alturas del artículo, la computación cuántica es un paradigma radicalmente nuevo que aprovecha los principios de la mecánica cuántica para procesar información. ■ En la próxima (y última) entrega de esta trilogía hablaremos de los ordenadores cuánticos existentes en España y cómo Telefónica está participando en su implantación. Photo (cc) de un modelo IBM Quantum System One, en Shin-Kawaski para la Universidad de Tokio. IBM Research.

30 de abril de 2025

AI & Data

Quantum Intelligence (parte I): Principios y mercado cuántico

La computación cuántica comienza a aplicarse en áreas como el aprendizaje automático y la optimización. Descubre las posibilidades reales de esta tecnología para abordar problemas complejos y conoce las tendencias actuales, desde Quantum-as-a-Service hasta nuestra posición en el ecosistema cuántico. Te invito a leer una visión práctica y realista de este campo. En esta primera parte haremos una introducción al campo y hablaremos del negocio cuántico. ______ Introducción a la computación cuántica La computación cuántica es una disciplina que aprovecha los principios de la física cuántica para procesar información de manera radicalmente diferente a los ordenadores clásicos. Se aprovecha de estos tres fenómenos para codificar la información y procesarla: Ilustración 1: Principios físicos de la computación cuántica. La superposición permite que un qubit (bit cuántico) exista en múltiples estados simultáneamente. Mientras que un bit clásico solo puede ser 0 o 1, un qubit puede ser 0, 1 o cualquier combinación de ambos al mismo tiempo. Esto es como si una moneda pudiera estar en cara y cruz a la vez antes de caer. La interferencia cuántica permite manipular las probabilidades de los posibles resultados de un cálculo. Se pueden reforzar ciertos resultados y cancelar otros. Es como si pudiéramos influir en cómo caerá una moneda mientras aún está girando en el aire El entrelazamiento es un fenómeno por el cual dos o más qubits quedan conectados de tal forma que el estado de uno afecta instantáneamente al estado del otro, sin importar la distancia que los separe. Es como si dos monedas giratorias estuvieran sincronizadas para caer siempre del mismo lado, incluso estando muy alejadas ■ Los qubits pueden existir en superposición (0 y 1 simultáneamente) y entrelazarse entre sí lo que permite explorar múltiples soluciones en paralelo, en un fenómeno llamado paralelismo cuántico. —Por ejemplo, un circuito con 50 qubits puede analizar hasta 2^50 posibilidades en una sola operación. A pesar de su potencial, la tecnología enfrenta retos: Decoherencia cuántica: Los qubits pierden su estado cuántico debido a interferencias ambientales (vibraciones, temperatura), limitando su tiempo útil para cálculos a microsegundos. Ruido y errores: Las operaciones cuánticas tienen tasas de error altas que se acumulan rápidamente en circuitos complejos. Esto obliga a tener que repetir cada operación (llamada shot) miles de veces para conseguir resultados fiables Infraestructura exigente: Los qubits superconductores, como los de IBM y otros, requieren refrigeración cerca del cero absoluto (-273°C), aislamiento en cámaras de vacío y escudos de radiación para minimizar perturbaciones. Construyendo el candelabro Los ordenadores cuánticos, a diferencia de los ordenadores clásicos, carecen de elementos como memoria RAM o discos duros, y su diseño se centra en mantener la coherencia cuántica y minimizar interferencias. Para operar, los qubits superconductores necesitan temperaturas cercanas al cero absoluto (-273°C). Esto se logra mediante sistemas de enfriamiento que utilizan helio y nitrógeno líquido. Estas temperaturas ultra bajas reducen el movimiento térmico de los átomos, crucial para mantener los estados cuánticos. Refrigerador de dilución es el nombre que recibe la estructura que sostiene todo el sistema. Es la imagen más icónica de la computación cuántica y por su forma, se le llama informalmente el candelabro (se ve muy bien en esta infografía del Barcelona Supercomputing Centre). El núcleo del sistema alberga los qubits, normalmente en circuitos superconductores de niobio o aluminio depositados sobre obleas de silicio. Estos se protegen con blindajes electromagnéticos para evitar interferencias externas. Además, las cámaras de vacío eliminan vibraciones y partículas residuales que podrían alterar los qubits. La manipulación de los estados cuánticos de los qubits se realiza mediante pulsos de microondas. Como puedes ver, estos ordenadores difieren mucho de un ordenador convencional. Veamos ahora cómo es el mercado cuántico. El mercado cuántico actual El mercado de la computación cuántica ha experimentado un crecimiento en los últimos años. Este crecimiento se divide en tres áreas clave, como señala el informe del World Economic Forum 2025: Ilustración 2: El mercado cuántico. El objetivo principal de la seguridad y comunicaciones cuánticas es mitigar las amenazas que la computación cuántica plantea a la criptografía clásica. Esto incluye el desarrollo de criptografía poscuántica (PQC), que resiste ataques cuánticos, y la distribución cuántica de claves (QKD), que permite la transmisión segura de claves mediante fotones entrelazados. Estas tecnologías son cruciales para proteger infraestructuras críticas como bancos y redes eléctricas. Los sensores cuánticos aprovechan propiedades como el entrelazamiento y la superposición para realizar mediciones ultra-precisas. Tecnologías como los SQUIDs pueden detectar campos magnéticos débiles. Estos sensores tienen aplicaciones en salud o energía. La computación cuántica está siendo explorada para su aplicación en inteligencia artificial, aprendizaje automático u optimización entre otros. En optimización, se investiga su potencial para analizar combinaciones complejas en problemas de logística y planificación de recursos. En aprendizaje automático, se estudian nuevas formas de procesar datos en espacios de alta dimensionalidad, con posibles aplicaciones en clasificación y análisis predictivo. La financiación de este mercado, tanto de fuente pública como privada, se está centrando en dos áreas. Por un lado, la inversión en hardware y en el desarrollo de ordenadores más grandes (más qubits), y menos ruidosos. Los fabricantes están creando sistemas cada vez más avanzados, como por ejemplo IBM y sus chips Heron de 156 qubits anunciados en 20231. Por otro lado, se están disponiblizando plataformas de tipo Quantum-as-a-Service (como IBM Quantum) que democratizan el acceso a procesadores cuánticos. En la próxima entrega de la serie hablaremos de dónde son útiles (y dónde no) y de las herramientas disponibles. Stay tuned! ___ 1. Aunque el número de qubits no es la única métrica por la que se miden los computadores cuánticos, sí es la más sencilla de entender. En general, se prefiere utilizar el término volumen cuántico, que incluye el número de qubits, la tasa de errores y la velocidad de computación (circuitos ejecutados por segundo). Photo (cc) de un modelo IBM Quantum System One en Shin-Kawaski para la Universidad de Tokio. IBM Research.

23 de abril de 2025

AI & Data

Descifrando los Espacios de Datos (parte II): Aspectos tecnológicos

Este artículo forma parte de una serie dedicada a los Espacios de Datos, de la cual ya hemos publicado un primer artículo que ofrece una guía para empresas y aborda los pilares fundamentales de un espacio de datos, roles, beneficios y desafíos. Te invitamos a consultarlo para obtener una visión completa del marco conceptual y estratégico de los Espacios de Datos. En este artículo nos centraremos en los aspectos tecnológicos que diferencian a los Espacios de Datos de otras tecnologías, explorando elementos clave como sus componentes principales y dando ejemplos específicos de Espacios de Datos Sectoriales, como EONA-X y Catena-X. ¿Qué diferencia a los Espacios de Datos de otras tecnologías? Los espacios de datos pretenden convertirse en un pilar fundamental para impulsar la economía del dato en diversos sectores. Pero ¿qué los diferencia de otras tecnologías como las nubes de los hiperescalares, Cloud computing, data warehouses o data lakes? Vamos a verlo: Aspectos tecnológicos diferenciadores A nivel tecnológico podemos destacar cuatro aspectos que forman parte intrínseca de los Espacio de Datos y que los diferencian del resto de tecnologías. Verificación de identidades: Los Espacios de Datos utilizan mecanismos robustos para verificar la identidad de los participantes y garantizar la confianza en las transacciones. Clearing houses: Componente que facilita el intercambio de datos de forma segura y transparente, actuando como intermediario entre los participantes. Marketplaces: Permite el descubrimiento, la compra y la venta de datos (y otros activos como apps o servicios) de forma segura y regulada, creando valor para los participantes. Contratos: Los Espacios de Datos utilizan contratos inteligentes para automatizar el acceso y uso de datos, asegurando el cumplimiento de las condiciones acordadas por quién ofrece los datos, como el uso que se le puede dar, o las regiones a las que se pueden mover los datos. Son contratos vinculantes con validez legal. Componentes tecnológicos Los Espacios de Datos están compuestos por varios componentes técnicos que trabajan juntos para crear un entorno seguro y descentralizado. Aunque cada organización (como IDSA o GAIA-X) está describiendo sus propios estándares técnicos acerca de los elementos que tienen que componer un Espacio de Datos, podemos extraer los elementos comunes: Conector: Esencial para la comunicación, el Conector permite a los proveedores y consumidores de datos intercambiar información dentro del ecosistema. Actúa como un puente entre nubes de datos industriales, nubes empresariales, aplicaciones locales o dispositivos individuales, conectándolos al ecosistema. Suele ser un componente que se instala cada participante en sus instalaciones, aunque existen empresas que ofrecen servicios de conectores en la nube o alojados en el propio Espacio de Datos. Broker: Facilita el intercambio de datos mediante servicios de búsqueda en tiempo real. Su función principal es conectar a los proveedores de datos con los consumidores de datos dentro del ecosistema. Proveedor de identidad: Responsable de gestionar y autenticar las identidades de los participantes dentro del Espacio de Datos. Garantiza un acceso seguro al ecosistema, controlando y verificando la identidad de cada usuario o entidad que interactúa con el espacio. Tienda de aplicaciones (App Store): La Tienda de Aplicaciones es un componente que permite a los participantes descubrir y acceder a diversas aplicaciones, datos, y servicios dentro del espacio de datos. Actúa como un mercado para servicios digitales e innovaciones. Centro de vocabulario: Juega un papel crucial en la integración de vocabularios de datos específicos de cada dominio dentro del Espacio de Datos. Contribuye a la estandarización y armonización de formatos y estructuras de datos, facilitando la interoperabilidad entre diferentes fuentes de información. Suelen estar definidos por vertical de negocio o ámbito de aplicación. Por ejemplo, para el ámbito sanitario se cuenta con el estándar OMOP. ✅ Más allá de estos componentes principales, las distintas organizaciones y desarrolladores incluyen otros elementos para complementar el ecosistema como repositorio de versiones de software, verificación de datos, etc. Ejemplos de Espacio de Datos Sectoriales (EONA, CATENA) Los Espacios de Datos ya no son una idea abstracta, sino que son una realidad en desarrollo con iniciativas que pretenden transformar la forma en que se gestiona y comparte la información. A través de Data Spaces Radar poder tener una visión completa del panorama de los Espacios de Datos a nivel mundial. ✅ Data Spaces Radar incluye información sobre iniciativas de Espacios de Datos, casos de uso y proyectos relevantes de plataformas como GAIA-X, IDSA, FIWARE y otras. Este repositorio central es una herramienta a tener en cuenta para comprender la evolución y el alcance de los Espacios de Datos. Estas son algunas de las iniciativas más destacadas que están dando forma al futuro de los Espacios de Datos: Catena-X: Este ecosistema de datos colaborativo y abierto surge de la industria automotriz. Conecta actores globales en toda la cadena de valor, desde el diseño hasta la producción y el servicio. Catena-X promueve la transparencia y la colaboración en la gestión de datos, impulsando la innovación y la eficiencia en el sector automotriz. EONA-X: Este proyecto, parte del ecosistema GAIA-X LightHouse (proyectos faro o punta de lanza del desarrollo), busca crear un entorno de confianza para el intercambio de datos en el ámbito de la movilidad, transporte y turismo. EONA-X se enfoca en la optimización de viajes multimodales, contribuyendo a la reducción de emisiones y a la sostenibilidad del transporte. MDS – Mobility Data Space: Otro proyecto del ecosistema GAIA-X LightHouse, MDS se centra en el intercambio de datos soberano en el sector de la movilidad. Ofrece un ecosistema para el desarrollo de soluciones de movilidad innovadoras, sostenibles y amigables para el usuario, promoviendo la participación justa y equitativa en la economía de datos. HEALTH-X dataLOFT: Basado en la plataforma dataLOFT, este proyecto del ecosistema GAIA-X LightHouse, busca implementar datos de salud de manera segura y transparente. HEALTH-X dataLOFT permitirá el uso individual de los datos de salud y el desarrollo de modelos de negocio innovadores en la industria de la salud. Estas iniciativas demuestran el potencial transformador de los Espacios de Datos en diversos sectores. A medida que la tecnología evoluciona y la demanda de colaboración y transparencia en la gestión de datos aumenta, los Espacios de Datos jugarán un papel cada vez más importante en la construcción de un futuro más conectado e inteligente. ◾ Ahora ya sabes un poco más de la tecnología detrás de los Espacios de datos. En el próximo artículo intentamos poner orden a todas las siglas y organizaciones que has ido viendo durante el artículo (IDSA, GAIA-X, etc.). AUTORES Santiago Morante Responsable de Alianzas IA y Diseño de Soluciones Paula Valles Data Sales Consulting * * * IA & Data Visualización de datos: elección del gráfico adecuado 13 de diciembre de 2023 Imagen: rawpixel.com / Freepik.

16 de septiembre de 2024

AI & Data

Inteligencia Artificial en la ficción: The Bestiary Chronicles, de Steve Coulson

En la era de la inteligencia artificial (IA), es común escuchar hablar de cómo esta tecnología puede revolucionar diferentes ámbitos de la vida humana, desde la medicina hasta la fabricación. Sin embargo, en nuestros posts anteriores, hemos tratado principalmente el tratamiento que se da a las IA en las películas, series y libros de ficción. Hoy vamos a cambiar de enfoque y explorar cómo las inteligencias artificiales generativas pueden ser utilizadas en la creación de arte. Aunque la idea de utilizar la tecnología para crear arte puede parecer desconcertante para algunos, en realidad hay muchas formas en las que las IA pueden ayudar a los artistas a generar ideas, experimentar con diferentes enfoques y enriquecer sus obras finales. En este post, vamos a ver cómo las IA pueden ser utilizadas como herramientas de apoyo en el proceso creativo de artistas y creadores de contenido. Si estás interesado en conocer cómo las inteligencias artificiales pueden ayudar a impulsar tu creatividad, ¡sigue leyendo! Generadores de texto Una de las formas más conocidas en las que las inteligencias artificiales pueden ser utilizadas en la creación de arte es a través del uso de modelos de lenguaje generativo. Estos modelos, como GPT-3 de OpenAI, son capaces de generar texto de forma autónoma, siguiendo ciertas instrucciones o patrones de lenguaje previamente establecidos. Para hacer esto, los modelos de lenguaje generativo utilizan una técnica conocida como "transferencia de aprendizaje", en la que se alimentan con grandes cantidades de texto y aprenden a imitar el estilo y la forma en que se escribe. Luego, pueden utilizar esto para generar nuevo texto que sigue el mismo patrón o estilo. Un ejemplo de un modelo de lenguaje generativo es ChatGPT, un modelo desarrollado por OpenAI que fue diseñado para simular conversaciones humanas. ChatGPT ha sido utilizado para generar diálogos en videojuegos, chatbots y aplicaciones de mensajería. Foto: Onur Binay / Unsplash Otro uso potencial para los modelos de lenguaje generativo es en la escritura de guiones y libros. Alimentados con información sobre un tema o género específico, estos modelos podrían ayudar a los escritores a generar ideas y a estructurar sus historias de una manera más eficiente. Sin embargo, es importante tener en cuenta que estos modelos aún tienen sus limitaciones y no pueden reemplazar completamente el trabajo creativo de un escritor humano. Los modelos de lenguaje generativo son una herramienta poderosa que pueden ayudar a los artistas y creadores a generar ideas y a experimentar con diferentes enfoques en su trabajo. Aunque todavía tienen sus limitaciones, su potencial es enorme y es probable que veamos más y más usos de estas IA en el futuro. AI OF THINGS Inteligencia Artificial en la ficción: Autómata (2014), de Gabe Ibáñez 1 de septiembre de 2022 Generadores de imágenes Otra forma en la que las inteligencias artificiales pueden ser utilizadas en la creación de arte es a través del uso de modelos de generación de imágenes. Estos modelos, como DALL-E de OpenAI, son capaces de generar imágenes a partir de una descripción textual o de un conjunto de palabras clave. Para hacer esto, los modelos de generación de imágenes utilizan una técnica similar a la transferencia de aprendizaje utilizada por los modelos de lenguaje generativo. Se alimentan con grandes cantidades de imágenes y aprenden a imitar el estilo y la forma en que se dibujan. Luego, pueden utilizar esto para generar nuevas imágenes que sigan el mismo patrón o estilo. Un ejemplo de un modelo de generación de imágenes es Midjourney, desarrollado por una compañía independiente. Con Midjourney, los usuarios pueden crear imágenes a partir de descripciones textuales simples, como "un gato sentado en una ventana". Esto puede ser útil para artistas y diseñadores que buscan inspiración o una manera rápida de generar bocetos y conceptos. Foto: Chen / Unsplash Otro uso potencial para los modelos de generación de imágenes es en la ilustración de libros o en la creación de gráficos y diagramas. Alimentados con información sobre un tema o estilo específico, estos modelos podrían ayudar a los ilustradores a generar ideas y a crear imágenes que se ajusten a una temática específica de manera más eficiente. Sin embargo, es importante tener en cuenta que estos modelos aún tienen sus limitaciones y no pueden reemplazar completamente el trabajo creativo de un ilustrador humano. The Bestiary Chronicles Un ejemplo de cómo las inteligencias artificiales generativas pueden ser utilizadas en la creación de arte es la serie de cómics "The Bestiary Chronicles", según describe Chema Alonso en su blog. Esta serie fue creada utilizando MidJourney, una IA que permite a los artistas construir el estilo gráfico de un cómic viñeta a viñeta, similar a modelos como Dall-e 2 o Stable Diffusion. Foto: Donovan Reeves / Unsplash Las historias de "The Bestiary Chronicles", como "The Lesson", "Exodus" o "Summer Island", han demostrado el potencial del uso de las IA generativas como herramienta para la creación de arte. "Exodus" describe una odisea de ciencia ficción que se desarrolla en 35 páginas espectaculares, todas generadas usando MidJourney. "Summer Island" es una historia de terror folclórico que sigue a un fotoperiodista en una asignación en un pueblo escocés remoto, donde descubre que los habitantes del pueblo esconden un oscuro secreto. "The Lesson" es una historia distópica que sigue a los últimos restos de la humanidad reunidos en un lugar subterráneo para aprender acerca de los monstruos que han destruido su planeta. Aunque el uso de IA generativas en la creación de arte puede tener muchas ventajas, como la capacidad de experimentar con diferentes enfoques y estilos de manera más rápida y eficiente, también hay desventajas que deben tenerse en cuenta. Por ejemplo, los modelos de IA aún tienen sus limitaciones y no pueden reemplazar completamente el trabajo creativo de un artista humano. Además, es importante tener en cuenta que el uso de IA generativas en la creación de arte puede plantear cuestiones éticas y de derechos de autor. AI OF THINGS Mundos infinitos, mundos realistas: generación procedural e inteligencia artificial en videojuegos 22 de agosto de 2022 Conclusión… En conclusión, las inteligencias artificiales generativas pueden ser utilizadas como herramientas de apoyo en el proceso creativo de artistas y creadores de contenido de diferentes formas, como en la generación de texto y de imágenes. Aunque todavía tienen sus limitaciones, estas IA tienen un gran potencial y es probable que veamos más y más usos de ellas en el futuro. Sin embargo, es importante tener en cuenta que el uso de IA generativas en la creación de arte también puede plantear cuestiones éticas y de derechos de autoría. A pesar de esto, el uso de IA generativas puede ser una manera eficiente y útil de experimentar con diferentes enfoques y estilos en el arte y la creación de contenido. …Y ¡sorpresa! ¡Todo este post ha sido escrito usando ChatGPT y las imágenes generadas por Midjourney![1] Esto demuestra el gran potencial de las IA generativas como herramientas de apoyo en el proceso creativo y cómo pueden ser utilizadas para crear contenido de alta calidad. ¡Esperamos que hayas disfrutado leyendo este post y hayas aprendido algo sobre el uso de las IA generativas en la creación de arte! Nota del Autor (humano) Sirva este pequeño experimento no como burla al lector, sino como demostración de las capacidades de las nuevas IA. Si bien es cierto que el texto ha sido generado por ChatGPT, ha habido que aplicar cierta inteligencia humana a la hora de hacer las peticiones (con varias repeticiones en algunos casos, como se puede comprobar en este PDF). Más que sustituir a los artistas, esto demuestra que saber qué pedirle a una IA puede ser una nueva habilidad a desarrollar por los creadores de contenido. [1] Por motivos de derechos de autor, las imágenes generadas por Midjourney no han podido ser incluidas en el post. Las imágenes incluidas provienen de un banco de imágenes e intentan representar el sentido del texto.

10 de enero de 2023

AI & Data

Inteligencia Artificial en la ficción: El Círculo (2017), de James Ponsoldt

En el último post hablamos de Autómata de Gabe Ibañez y, siguiendo con “La Inteligencia Artificial en las películas de ciencia ficción”. Hoy analizamos El Círculo (2017), de James Ponsoldt y que protagonizan Emma Watson y Tom Hanks. Argumento de El Círculo (2017) La película El Círculo, basada en la novela de Dave Eggers con el mismo título, nos presenta a Mae Holland (Emma Watson) una joven becaria que entra a trabajar en la compañía El Círculo. Se trata de una Big-Tech, un gigante tecnológico capitaneado por Eamon Bailey (Tom Hanks) que desarrolla desde hardware hasta redes sociales (y cualquier parecido con alguna gran tecnológica es puramente casual). Deslumbrada por la aparente modernidad y apertura de la empresa, Mae asiste al evento corporativo en el que se presenta una innovadora tecnología para colocar, en todos los lugares, cámaras que emiten en tiempo real a las redes sociales. Partiendo de este punto, la trama desciende de la mano de la protagonista hacia la parte más oscura de la pérdida de privacidad y las prácticas corporativas no reguladas. https://www.youtube.com/watch?v=Z4wu6J6DLLM El culto a la tecnolog-IA Con reminiscencias que a veces recuerdan a 1984, el tema principal alrededor del cual gira la trama de El Círculo es claramente el de la privacidad que, en el mundo real, se ha visto muy afectada, e incluso cuestionada, en la última década debido principalmente a las redes sociales. Si hemos incluido esta película en nuestra sección sobre Inteligencia Artificial, no es porque la película trate específicamente sobre Inteligencia Artificial (IA), sino por el culto a la tecnología que sostiene la trama. La tecnología sirve en la película, de manera evidente, como palanca para que El Círculo gane poder. Pero esto no sería posible si no fuera por la masa de usuarios que la apoyan de manera incondicional. La tecnología por la tecnología. La tecnología como pertenencia a un grupo. La defensa incuestionable de los desarrollos. Y es en ese punto dónde enlaza con la IA. Hay una tendencia en confiar en las decisiones de las inteligencias artificiales, especialmente si refuerzan nuestra opinión previa. La IA es difícil de desarrollar, y es aún más difícil entender por qué toma las decisiones que toma, especialmente los nuevos desarrollos en Deep Learning. Es por ello por lo que hay una tendencia en confiar en las inteligencias artificiales de formar acrítica y asumir la corrección de los resultados, especialmente si refuerzan la opinión previa que se tenía sobre un tema. Considero que es necesario poner en perspectiva cualquier desarrollo tecnológico, por muy moderno, actual, atractivo y molón que parezca, pues el propósito de la tecnología es hacer mejor la vida de las personas. Si no cumple ese objetivo, la tecnología no vale. No hay que desarrollar por desarrollar. Ese es uno de los mensajes más claros que nos regala la película. Si la tecnología no cumple su propósito de hacer mejor la vida de las personas no tiene sentido desarrollarla Inteligencia Colectiva como Inteligencia Artificial La tecnología presentada en la película funciona básicamente por inteligencia colectiva. Es decir, muchas personas mirando las imágenes que emiten las cámaras, como la identificación de personas usando todas las cámaras del mundo que ocurre (¡alerta de spoiler!) en una de las escenas. Es un paso lógico que ese trabajo lo acabase realizando una Inteligencia Artificial, tema que la película no aborda. En cierto sentido, la masa de usuarios hace la función de una inteligencia artificial pues no juzga lo que está haciendo y ofrece resultados. Esta forma de funcionar, hacer pequeños trabajos de manera manual y agregar los resultados, ya existe en el mundo real y lo ofrecen varias plataformas que pagan pequeñas cantidades de dinero a muchas personas que hace pequeñas tareas para después agregar los resultados. Así, la inteligencia colectiva se convierte en la fuente de datos de la que bebe la Inteligencia Artificial, siendo los usuarios quienes etiquetan los datos para que después la IA haga su trabajo. Los usuarios trabajando para la IA, para que la IA trabaje después para los usuarios. Un círculo curioso que en la película se queda en semicírculo, abordando sólo la primera parte. Valoración El Círculo es una distopía que no se aleja demasiado de nuestra realidad actual. La película se queda corta estimando el uso de la IA en la tecnología, recurriendo a la inteligencia colectiva en su lugar. En ese sentido ha sido menos ambiciosa que otras propuestas similares como Person of Interest. A cambio, nos ofrece una visión descarnada de por qué las empresas impulsan las tecnologías que diluyen la privacidad de las personas. Con el objetivo de poder hacer un ranking de películas y series en el futuro, vamos a valorar el grado de realismo de cada tecnología presentada, mediante una escala (sobre 5): Inteligencia artificial: 1/5 (infravalora su uso) Otras tecnologías: 5/5 (redes sociales y cámaras por todos sitios) Resultado: 3/5 de realismo tecnológico ¿Dónde ver la película El Círculo? El Círculo (2017) de James Ponsoldt, con Emma Watson y Tom Hanks, está disponible a través de Prime Video.

24 de noviembre de 2022

AI & Data

Inteligencia Artificial en la ficción: Autómata (2014), de Gabe Ibáñez

Después de analizar Eva de Kike Maíllo, seguimos con la serie “La Inteligencia Artificial en las películas de ciencia ficción”. Hoy analizamos Autómata (2014), de Gabe Ibáñez y que protagoniza Antonio Banderas. Esta película española nos sitúa en un futuro cercano postapocalíptico (2044) donde apenas quedan unos millones de personas en la Tierra. En esta sociedad, muchos trabajos son llevados a cabo por robots humanoides de la compañía ROC. Jacq Vaucan (Antonio Banderas) es un agente de seguros de ROC que investiga fraudes y malfuncionamientos de los robots, cuando en una inspección rutinaria descubre que existe la posibilidad de que un robot se haya saltado sus protocolos de seguridad. En un entorno al estilo Blade-Runner, la película sigue la trama detectivesca de Jacq hasta dar con la solución al enigma. https://www.youtube.com/watch?v=WEJGQbK6VIw Inteligencia Artificial funcional y realista Sin ánimo de hacer espóiler, diremos que la película tiene un tratamiento realista de la Inteligencia Artificial hasta la mitad de la película y otro más fantástico en la última mitad. Si nos centramos en la primera parte de la película, tenemos robots que se usan para trabajos físicos (soldadores, constructores, etc.) cuyos movimientos son lentos, ligeramente torpes y con habilidades funcionales únicamente para desarrollar sus trabajos. La Inteligencia Artificial que tienen asociada es limitada en cuanto a interacciones sociales, y consiste básicamente en órdenes y respuestas preprogramadas. En este sentido nos encontramos con una película que trata este tema de manera muy realista y que plantea un horizonte razonable de tiempo en el que se puede conseguir. Autómata (2014) de Gabe Ibáñez es una película que trata la Inteligencia Artificial de manera muy realista y que plantea un horizonte razonable de tiempo en el que se puede conseguir. Los robots actuales más avanzados ya se mueven como los de la película (e incluso un poco mejor) y la interacción humano-máquina es similar a la que tenemos hoy en día con Siri o Alexa. Además, el aspecto de los robots es pragmático, duro e industrial, sin intentar asemejarse a un humano. No obstante, han contado con una asesora científica del campo de la robótica (Concha Monje) para darle esa capa de realismo: https://www.youtube.com/watch?v=X2OjKvUMdAM No revelaremos qué ocurre en la segunda mitad de la película, pero si adelantamos que el tratamiento del género se vuelve menos realista y más en línea con el conjunto de películas de ciencia ficción de robots. Los protocolos Bebiendo de la mejor tradición robótica clásica, como son las famosas leyes de la robótica de Asimov, la película plantea dos protocolos que son implantados de manera imborrable en los robots: Un robot no puede dañar a ninguna forma de vida Un robot no puede modificarse a sí mismo o a otros robots Aunque estas leyes y protocolos son muy llamativos y ayudan a contextualizar las historias que se cuentan, en el mundo real no resulta tan sencillo hacer que una IA obedezca unas normas tan generales. Los humanos, por nuestra forma de razonar, podemos valorar cada acción que hacemos en un marco definido. Por ejemplo, si alguien te dice que tienes que cuidar el planeta Tierra y ser más ecologista, tú, como humano, podrías analizar cada acción cotidiana que realizas (tirar la basura, comprar tecnología, elegir unos productos del supermercado u otros, etc.) y comparar si estás cumpliendo mejor o peor esa regla. No se ha conseguido que las IA tengan esa capacidad y, tal y como van los desarrollos tecnológicos, para poder entender unas normas tan generales, habría que codificar, es decir, dar una respuesta adecuada, a cada una de las situaciones posibles en las que esa regla puede intervenir. Esto no es factible y limita lo que se puede conseguir en este ámbito. En un contexto industrial, con límites definidos y comportamientos esperados, es relativamente sencillo programar un robot para que no dañe a un humano: no sobrepasar cierta velocidad de movimiento, no apretar a más de tanta fuerza con la pinza, etc. Esto es así porque las interacciones están muy limitadas y sabemos cuáles van a ser. Sin embargo, en el mundo abierto que es un entorno urbano o rural, existen tantas situaciones imprevisibles, que no es factible esperar que una IA pueda cumplir normas tan genéricas. El poder de las empresas tecnológicas Otro aspecto interesante que plantea la película es el papel de las empresas tecnológicas y el poder que tienen. En la sociedad distópica que se presenta, no parece existir ningún gobierno o, prácticamente, autoridades públicas de ningún tipo. El sistema económico-social parece un capitalismo llevado al extremo donde el poder lo acumula una empresa, ROC (Robot Organic Century), dueña de los robots. La desigualdad extrema es imperante, por ejemplo, con una muralla que separa la ciudad, donde viven las personas que tienen trabajo, con el resto en las afueras, o con la exigencia de contar con un seguro médico a una embarazada para dejarla entrar al hospital a parir a través de la ventanilla del coche. En este contexto, la dependencia de la sociedad de los robots hace que ROC pueda controlar a las pocas fuerzas de seguridad que aparecen, a dirigir la construcción de la ciudad y su clima, o a realizar acciones ilegales sin consecuencias. La película parece querer transmitir el mensaje de que, al existir una dependencia tan grande de la tecnología, se está cediendo poder a quién a la controla. Desde luego es un tema que merece un debate. Valoración Autómata es una buena película que destaca por su realismo tecnológico y por prever las consecuencias de un capitalismo tecnológico sin límites. Con el objetivo de poder hacer un ranking de películas y series en el futuro, vamos a valorar el grado de realismo de cada tecnología presentada, mediante una escala (sobre 5): Inteligencia artificial: 4,5/5 Robótica: 5/5 Otras tecnologías: 4,5/5 Resultado: 4,6/5 de realismo tecnológico. ¿Dónde ver la película Autómata, de Gabe Ibáñez? Autómata está disponible de manera completamente gratuita a través del portal RTVE Play.

1 de septiembre de 2022

AI & Data

La Inteligencia Artificial en las películas de ciencia ficción: un patrón recurrente de fascinación y terror

En el post de hoy vamos a analizar cómo las películas de Hollywood han tratado el tema de los avances tecnológicos, especialmente la robótica y la Inteligencia Artificial (IA). Te sorprenderá descubrir que muchas de las películas siguen un mismo patrón, que podemos decir que empezó a principios del siglo XX y que se popularizó con "Terminator" (1984). ¡Empezamos! Del Golem judío a C3PO de "Star Wars" Existe una narrativa que se demuestra recurrente en la historia de la cultura humana, esto es, la creación de vida artificial para usarla en nuestro beneficio. Hay multitud de ejemplos, ya sea el famoso "Frankestein" (1818) de Mary Shelley o los simpáticos R2D2 y C3PO de "La guerra de las galaxias" (1977) (mira nuestro post anterior sobre "The Mandalorian"). Esta narrativa recurrente se puede rastrear hasta la mitología judía, con el Golem de barro que cobra vida cuando le introduces las instrucciones en la boca con un papel y realiza las tareas que le pidas sin rechistar. Ciertamente es un concepto interesante, poder descargar tareas en otro ser que no sufre ni se cuestiona la tarea. Es, cuanto menos, útil, y por eso esta historia la encontramos repetida en todos los ámbitos de la cultura, incluido el cine. En este punto entra en juego un género literario que se basa en contar historias ficticias en un contexto en el que la tecnología y las ciencias han evolucionado más allá de nuestra realidad. Es lo que conocemos como ciencia ficción. Cuando la narrativa del Golem y la ciencia ficción se juntan tenemos los libros y películas de robots. El “patrón R.U.R.” frecuente en la ciencia ficción Si bien es cierto que no todas las películas sobre robots e inteligencia artificial tratan el tema exactamente igual, sí que encontramos un patrón recurrente, especialmente en el mundo occidental, que sería algo así como: El ser humano ha desarrollado la tecnología hasta el punto de poder crear un ente capaz de realizar tareas de forma autónoma. Una entidad (una empresa, un ejército o un individuo) decide poner a este ente al mando de un activo o proceso crítico para la humanidad, con la excusa de mejorar la productividad, la fiabilidad o la rentabilidad. El ente se desarrolla de forma autónoma más allá de lo que los diseñadores esperaban. El ente decide que el ser humano es un obstáculo para su nueva visión del universo y que éste tiene que ser eliminado, encarcelado o subyugado para que no moleste. Y podríamos acabar con que el ente es difícil de apagar o destruir y a nadie se le ha ocurrido ponerle un mecanismo de seguridad. Seguro que al leer los puntos se te ha ocurrido alguna película o libro que has leído. Es normal, este patrón se repite más de lo que nos damos cuenta. De hecho, podemos encontrar este patrón ya en la primera obra que incluye la palabra robot (del checo robota, o sea, esclavo). Este libro es "R.U.R." (1920) del checo Karel Čapek, que en su argumento nos cuenta la historia de una empresa que fabrica seres artificiales (1) para reducir la carga de trabajo de los humanos (2). AI OF THINGS Ciencia Ficción vs Inteligencia Artificial: Matrix ¿vivimos en una simulación? 24 de septiembre de 2019 En este punto, Harry Domin y Helena Glory, dueño de la fábrica de robots y mujer de este respectivamente, deciden dotar de sentimientos a los seres, que acaban desarrollándose más allá del objetivo inicial (3), tomando conciencia de la esclavitud a la que les someten los humanos, iniciando una rebelión y conquistando el planeta (4). La historia acaba con todos los humanos eliminados de la Tierra, porque los robots eran muy fuertes y no tenían puntos débiles (5). Conocido el patrón, al que llamaremos “patrón R.U.R.” en deferencia al origen de este, vámonos a Hollywood a dar una vuelta. Una lista (no exhaustiva) de películas de ciencia ficción que siguen el patrón R.U.R. (Spoiler alert!) Aunque si la película aparece en este listado ya te puedes imaginar el argumento, si prefieres no conocerlo, ¡sáltatela! "Terminator" (1984): Probablemente la más famosa y la que puso de moda el género, nos cuenta como Skynet, una IA militar toma el control de todas las máquinas y de todos los ordenadores con el objetivo de exterminar a los humanos. Menos mal que tenemos a Schwarzenegger de nuestro lado. "Pequeños guerreros" (1998): Por azares del destino, un chip militar acaba en unos muñecos articulados de juguete que, una vez adquieren consciencia, deciden acabar con los humanos. "Matrix" (1999): Una vez adquieren autoconsciencia, las máquinas deciden acabar con el ser humano. Éste decide quitarles su fuente de alimentación (el Sol) y ellas, a cambio, empiezan a recolectar a los humanos y a usarlos como pilas mientras les mantienen en una simulación. "Planeta rojo" (2000): Un simpático perro robot acompaña a unos astronautas en su exploración de Marte, pero, debido a un fallo en su programación de origen militar, decide acabar con todos los humanos. "Yo, robot" (2004): Una IA empresarial decide que los humanos han de ser protegidos de sí mismos y, oh sorpresa, los intenta encarcelar a todos. "Stealth, la amenaza invisible" (2005): Un programa militar secreto pone a una IA a los mandos de un avión con capacidad de iniciar una guerra nuclear y el avión decide dejar de obedecer órdenes. "La conspiración del pánico" (2008): Una IA militar muy avanzada coordina la vida de muchas personas para acabar con un gobierno que considera que impide sus planes de dominación mundial. "La conspiración del poder" (2009): Palabra por palabra el mismo argumento que "La conspiración del pánico." "Tron" (2010): Un mundo en el que las inteligencias artificiales gobernantes han evolucionado hasta esclavizar a todos los seres. Por suerte para nosotros, en este caso la dominación queda reducida a un mundo subatómico. "Vengadores: La era de Ultrón" (2015): Un robot mitad alienígena mitad informático pretende apoderarse de todo el planeta y eliminar a los humanos. "Westworld" (2016): En este caso los robots son creados para fines recreativos, hasta que se dan cuenta de lo que son… y se rebelan. "I am mother" (2019): Las IA creadas por el ser humano ven cómo éste se autodestruye y deciden hacer borrón y cuenta nueva con los humanos, a su pesar claro. Seguro que podríamos seguir así un rato más, pero el punto ha quedado claro: nos fascina la tecnología, pero nos da miedo dejar de entenderla. Seguro que en el futuro seguimos viendo películas que siguen este patrón. ¡Espero que lo reconozcas cuando las veas! Microepílogo: La visión oriental Siendo justos he de reconocer que esta es la visión occidental del género. En oriente hay una visión completamente distinta de los robots, donde éstos suelen ser los buenos de la historia, que están aquí para ayudarnos. Pero eso será otro post. I’ll be back! Nota: Si conoces más películas que sigan este patrón, ¡déjanoslas en los comentarios! AI OF THINGS Ciencia Ficción vs Inteligencia Artificial ¿Qué tal una partidita de Ajedrez, Dr. Falken? 26 de octubre de 2017

12 de mayo de 2022

AI & Data

Deep Learning en Star Wars: que la computación te acompañe

Hoy vamos a hablar de cómo la Inteligencia Artificial y, en concreto el Deep Learning, se están infiltrando en los rodajes de películas y series, consiguiendo resultados en efectos especiales mejores que los que ningún estudio había conseguido hasta ahora. ¿Y qué mejor que una de las mejores sagas de ciencia ficción, como Star Wars, para demostrarlo? Parafraseando al maestro Yoda: «Lee el post o no lo leas, pero no lo “leas en diagonal”». Rejuvenecimiento facial a través de Deepfake Desde que se estrenó "Una Nueva Esperanza" en 1977 hasta ahora se han hecho multitud de películas y series sobre Star Wars, sin seguir un orden cronológico continuo. Esto hace que personajes que se interpretaron cuando los actores eran jóvenes tengan que ser interpretados muchos años después por los mismos actores, que ya no son tan jóvenes... Esto es un problema que Hollywood ha solucionado tirando de efectos especiales “clásicos”, como el CGI, pero el avance de Deep Learning ha resultado en un hecho curioso, como es que los fans con ordenadores caseros han conseguido igualar o mejorar el trabajo de estos estudios. Un ejemplo lo encontramos en la tecnología DeepFake. DeepFake es un término paraguas para nombrar a las arquitecturas de redes neuronales entrenadas para sustituir una cara en una imagen por la de otra persona. Entre las arquitecturas de redes neuronales utilizadas están los autoencoders y las Generative Adversarial Networks (GANs). Desde 2018 esta tecnología se ha desarrollado rápidamente, con páginas web, apps y proyectos open source listos para el desarrollo, disminuyendo así la barrera de entrada para cualquier usuario que quiera probarlo. ¿Y cómo se relaciona esto con Star Wars? El 18 de diciembre de 2020 se estrenaba el capítulo 8 de la temporada 2 de la serie The Mandalorian, en el que se incluía una escena con un “joven” Luke Skywalker hecho por ordenador (el actor original, Mark Hamill, tenía 69 años). Tan sólo 3 días después el youtuber Shamook subió un vídeo en el que comparaba el rejuvenecimiento facial de Industrial Light&Magic (responsables de los efectos especiales) con el que había hecho él usando DeepFake. Como habrás visto, el trabajo de una sola persona, en 3 días, había conseguido mejorar el trabajo del estudio de efectos especiales, que, en este caso, también había usado DeepFake en combinación con otras técnicas. Además, Shamook lo hizo usando dos proyectos open source como DeepFaceLab y MachineVideoEditor. El mismo autor realizó otras sustituciones en películas recientes de Star Wars como la del Gobernador Tarkin en Rogue One (el actor original, Peter Cushing, falleció en 1994) o la de Han Solo en la película homónima (dónde contrataron a un nuevo actor en vez de rejuvenecer a Harrison Ford) que demostraron que la técnica del DeepFake generalizaba bien a otras películas. Estos vídeos, que se hicieron virales, no pasaron desapercibidos para Lucasfilm, que unos meses después contrató al youtuber como Senior Facial Capture Artist. Fuera del universo Star Wars, Shamook ha realizado sustituciones de caras en muchas otras películas, normalmente metiendo a actores en películas en las que no tienen nada que ver, con divertidos resultados. Modelos de upscaling para mejorar la calidad de vídeos antiguos Pero rejuvenecer caras no es único uso que el Deep Learning puede ofrecer a los estudios cinematográficos. Otro tipo de modelos, llamados de upscaling, se entrenan para mejorar la resolución de imágenes y vídeos (y videojuegos). Esto es útil cuando se quieren remasterizar, por ejemplo, películas antiguas que fueron digitalizadas y que no permiten una mejora de la resolución sencilla. Los fans, de nuevo, han tomado la delantera y están mejorando la calidad de trailers de videojuegos antiguos de Star Wars usando estas tecnologías. Algunos incluso se han atrevido a restaurar escenas eliminadas de las primeras películas, y aportan tutoriales para que, quien se atreva, continúe mejorando los resultados. En definitiva, como vemos, los modelos de Deep Learning están cambiando cómo se desarrollan muchos negocios. La industria del cine tiene un amplio abanico de opciones para mejorar sus procesos usando Machine Learning que nos permitirán disfrutar de unos efectos cada vez más realistas y espectaculares. Nota: puedes ver el proceso de rejuvenecimiento de Luke Skywalker en The Mandalorian en el episodio 2 de la temporada 2 (“Making of the Season 2 Finale”) de la docuserie “Disney Gallery: Star Wars: The Mandalorian” disponible en Disney+.

31 de marzo de 2022

AI & Data

Inteligencia Artificial en la ficción: "Eva", de Kike Maíllo

¿Tienes miedo de que tu robot de cocina se rebele y te envenene las lentejas? ¿Crees que tu Roomba te vigila? ¿Te tapas con una gorra cuando ves un dron? Entonces este es tu sitio. Comenzamos hoy una serie de artículos sobre el tratamiento que se da en las películas y series a la inteligencia artificial, analizándolo desde el punto de vista del estado tecnológico actual, valorando cómo de realistas son las tecnologías que se presentan. ¿Y por qué deberías creerme? Digamos que hasta hace unos años me dedicaba a investigar con robots, a simularlos, a programarlos, y hasta escribí una tesis doctoral sobre ellos… ¿Empezamos? Argumento Abrimos esta serie con una película española poco conocida, Eva (2011) del director Kike Maíllo, la que es, probablemente, mi película favorita en cuanto al tratamiento que se da a la robótica. La película se sitúa en un futuro cercano, 2041, en un mundo en el que los humanos conviven con robots que son utilizados para tareas repetitivas o pesadas, como limpiar o llevar la compra. En este contexto, Álex (Daniel Brühl), un ingeniero cibernético/robótico vuelve a su pueblo después de una ausencia prolongada, con el encargo de la universidad de crear el primer niño robot. La película se centra en las relaciones entre el protagonista y la familia que dejó al marcharse, y cuenta con algún giro de guion sorprendente. La robótica que ya existe En la película, la inteligencia artificial y la robótica son tratadas de 2 maneras muy diferenciadas. Por un lado, tenemos a la mayoría de los robots, cuya estructura física y su inteligencia son completamente realistas y asumibles hoy en día o en un futuro cercano. Desde los asistentes con base móvil, al estilo de PR2, hasta los cuadrúpedos de carga, como los que produce Boston Dynamics, estos robots representan la versión comercial de lo que hoy en día está en las universidades o en determinadas industrias. Hay que destacar el gato-robot de Álex, que es casi una versión estilizada de Spot. La robótica que nos gustaría que existiera Por otro lado, hay unos pocos robots, como el asistente Max (Lluís Homar), cuya inteligencia, aspecto, sentimientos y movimientos rivalizan con los de lo humanos. Estos robots son la parte más futurista. Vamos a analizar por partes sus características. Empezamos con la capacidad de movimiento. Tenemos que el movimiento realista y estable de los robots es un tema de investigación que viene de lejos y que, quitando Boston Dynamics con Atlas, nadie ha conseguido resolver adecuadamente. El aspecto exterior realista, hasta el punto de confundirlo con un humano, es un área en el que arte e ingeniería se dan la mano. Algunos desarrollos actuales pueden llegar a engañar momentáneamente a un observador ingenuo (o miope), pero ninguno soporta el reto de los movimientos faciales, siendo fácilmente detectable que no estamos ante una persona. En cuanto a los sentimientos… ¿Qué son exactamente? ¿expresiones externas adecuadas ante determinados eventos? Entonces sí que existe un campo de estudio que, unido al punto anterior, en algún momento conseguirá resultados realistas. Pero si consideras que los sentimiento son algo más que expresiones faciales, entonces me temo que la ingeniería no ha llegado tan lejos. Algunos estudios consideran que las emociones artificiales son “necesidades” (drives) que el robot busca mantener en rango (como estar contento y no triste, por ejemplo). Sin embargo, un problema viene al determinar qué significa para un robot estar contento o triste (¿tiene que afectar a sus decisiones estar enfadado o exultante?) o cómo tienen que influirle las situaciones (¿si se le acaba la batería se pone triste?). Incluso pensando más allá, ¿para que querríamos un robot con esta funcionalidad? ¿Qué aporta a su trabajo? Podríamos acabar con robots depresivos yendo al robopsicólogo. En resumen, la inteligencia que propone la película en estos robots casi humanos queda lejos de lo que la ingeniería ha conseguido hasta ahora y es el punto menos creíble de la tecnología que se presenta. Retrofuturo Otras tecnologías no relacionadas directamente con la inteligencia artificial si que están inspiradas en tecnologías existentes o que se proyecta que existirán en breve, como las interfaces táctiles visuales para controlar el ordenador (hay que tener en cuenta que la película es de 2011 y que, Microsoft Surface, por ejemplo, se lanzó en 2012), o los indicadores de navegación proyectados sobre la luna del coche (como los Head-up Display de algunos vehículos). En cuanto a los hologramas que el protagonista usa para ver vídeos o para diseñar el cerebro del robot, hoy en día no se ha conseguido aún prescindir de un soporte físico. Sin embargo, no parece tan descabellado pensar que para 2041 pueda existir una versión más o menos funcional de lo que vemos en pantalla. Valoración Eva es una gran película que destaca por su buena integración de tecnología avanzada, pero asumible, en un entorno cotidiano reconocible y que, salvo unos pocos elementos más fantásticos, consigue un buen efecto global de realismo. Con el objetivo de poder hacer un ranking de películas y series en el futuro, vamos a valorar el grado de realismo de cada tecnología presentada, mediante una escala (sobre 5): Inteligencia artificial: 5/5 para los robots no humanoides, 2/5 para éstos, luego le damos un 3.5/5 de media Robótica: 4.5/5 Otras tecnologías: 4/5 Resultado: 4/5 de realismo tecnológico Disponibilidad: Eva estuvo disponible en Filmin, pero ahora no se encuentra en las grandes plataformas. Se puede conseguir en Amazon.

23 de diciembre de 2021

AI & Data

Precauciones a la hora de normalizar datos en Data Science

Para que funcionen mejor muchos algoritmos de Machine Learning usados en Data Science, hay que normalizar las variables de entrada al algoritmo. Normalizar significa, en este caso, comprimir o extender los valores de la variable para que estén en un rango definido. Sin embargo, una mala aplicación de la normalización, o una elección descuidada del método de normalización puede arruinar tus datos, y con ello tu análisis. Vamos a ver unos ejemplos de los métodos de normalización más usados actualmente. Escalado de variables Feature Scaling En este caso, cada entrada se normaliza entre unos límites definidos: Figura 1: Fórmula normalización. El problema de este tipo de normalizacion, es que comprime los datos de entrada entre unos límites empíricos (el máximo y el mínimo de la variable). Esto quiere decir que si existe ruido, éste va a ser ampliado. Pongamos por ejemplo que queremos analizar la calidad de la fibra óptica de 30 Mb/s de un hogar y para ello medimos durante 50 días su velocidad de conexión. Figura 2: Velocidad de conexión a lo largo de 50 días. Parece una conexión bastante estable, ¿verdad?. Vamos a proceder a escalar esta variable en el rango 0-1, usando como maximo y minimo los maximos y minimos de la señal. Figura 4: Velocidad conexión /día en escala 0-1. Después del escalado, nuestros datos se han distorsionado. Lo que era una conexión estable, ahora parece tener muchas variaciones. Esto nos dice que este método de normalización no es adecuado para señales estables. Escalado estándar (Standard Scaler) Una alternativa al escalado de variables es usar otra técnica conocida como escalado estándar (a cada dato se le resta la media de la variable y se le divide por la desviación típica). Figura 5: Fórmula de escalado estándar. Éste método funcionaría para normalizar la señal de la fibra óptica del ejemplo anterior, conservando su forma, pero, ¿qué pasará con otras señales?. Los dos estadísticos que se usan ( media y desviación típica) son muy sensibles a valores anómalos (muy grandes o muy pequeños con respecto al resto). Imaginemos otro ejemplo. Vamos a medir cuánto se usa la palabra “resaca” en publicaciones de Facebook (datos reales). La frecuencia de uso de esta palabra tiene picos durante el fin de semana y valles entre semana. Los datos tienen valores anormalmente altos en fiestas como Halloween y Navidad. Figura 6: Número de veces que se usa la palabra "resaca" en Facebook/días. Antes de normalizar, calculamos la media (5.55) y la desviación típica (10.53). Ya podemos ver que la media está en torno a 5, cuando nuestros datos sin anomalias no pasan de valores en torno al 4 (mala señal). Si aplicamos ahora la normalización estándar, tenemos lo siguiente. Figura 7: La normalización estándar para los datos anteriores no es una buena elección. Lo primero que vemos es que no hemos conseguido normalizar entre 0-1 con este método. Además ahora tenemos valores negativos, cuando antes no los teníamos. Por si esto fuera poco, nuestros valores pico y valle han quedado muy atenuados por culpa de las anomalías. Una solución a esto sería eliminar las anomalías antes de normalizar (tema para otro post). Análisis similares se puede hacer para otros métodos de normalización: escalar sobre máximo, normalizer, escalado robusto, etc. Puedes consultar una versión extendida de este análisis en este enlace. Cosas a recordar La normalización puede (posiblemente [peligrosamente]) distorsionar tus datos No existe un método ideal de normalización que funcione para todas las formas de variables. Es trabajo del Data Scientist conocer cómo se distribuyen los datos, saber si existen anomalías, comprobar rangos, etc. Con este conocimiento, se puede seleccionar la mejor técnica para no distorsionar los datos.

1 de noviembre de 2018

Descubre más sobre nosotros

-

📲 Fermax ha conectado sus videoporteros con conectividad IoT gestionada, lo que le permite supervisar dispositivos en tiempo real, anticiparse a incidencias y garantizar una experiencia más segura para los usuarios.

10 DE FEBRERO, 2026

-

¿Cómo nos ve la IA en Telefónica Tech? 👀💙 Le hemos pedido que retrate a nuestros techies en versión caricatura: mismos rasgos, misma esencia y pequeños detalles que reflejan su día a día en ciber, cloud, datos, workplace…

13 DE FEBRERO, 2026

-

🛜 Así es nuestro NOC que gestiona Redes Móviles Privadas 4G/5G 24x7x365: monitorización en tiempo real, incidencias, SIMs y seguridad desde una única plataforma.

11 DE FEBRERO, 2026

Cloud Híbrida

Cloud Híbrida Ciberseguridad & NaaS

Ciberseguridad & NaaS AI & Data

AI & Data IoT y Conectividad

IoT y Conectividad Business Applications

Business Applications Intelligent Workplace

Intelligent Workplace Consultoría y Servicios Profesionales

Consultoría y Servicios Profesionales Pequeña y Mediana Empresa

Pequeña y Mediana Empresa Sanidad y Social

Sanidad y Social Industria

Industria Retail

Retail Turismo y Ocio

Turismo y Ocio Transporte y Logística

Transporte y Logística Energía y Utilities

Energía y Utilities Banca y Finanzas

Banca y Finanzas Ciudades Inteligentes

Ciudades Inteligentes Sector Público

Sector Público