AI & Data

Mujeres que cambiaron las Matemáticas

Por Fran Ramírez y Fran Fenoll Aprovechando que en marzo también se celebra el día Internacional de las Matemáticas, hemos querido rendir con esta recopilación un pequeño homenaje a mujeres que han tenido una gran influencia en esta ciencia desde los inicios de nuestra civilización y hasta la actualidad. Por supuesto, faltan muchas mujeres que no aparecen en este artículo, pero queremos que esta representación sirva para honrar y reconocer a todas ellas. Y como la línea que divide la Tecnología de las Matemáticas es muy delgada, en este enlace os dejamos también la influencia de cinco mujeres que ha destacado en disciplinas como Criptografía, Informática o Comunicaciones. Las pioneras en la Historia Téano Busto de Téano. Fuente. Quizás una de las primeras matemáticas que tenemos constancia es Téano, nacida en el siglo VI a.C. A parte de ser matemática, dominaba también otras disciplinas como la Filosofía, la Física y la Medicina. Se le atribuyen tratados de poliedros, así como de proporcionalidad, en concreto la proporción áurea. Téano es conocida también por ser la mujer del matemático Pitágoras, y pertenecer a la escuela pitagórica. De hecho, gracias a Téano podemos hoy en día estudiar a Pitágoras, pues cuando murió Pitágoras hubo una revuelta contra su escuela, y tanto Téano como sus hijas salvaron sus trabajos, ampliando y difundiendo su estudio años después por Grecia y Egipto. Hipatia Representación de Hipatia de Rafael Sanzio. Fuente. Avanzando en la Historia, nos encontramos con otra gran mujer, innovadora en su tiempo, maestra en la Escuela Neoplatónica de Alejandría, Hipatia. Nació alrededor del año 350 d.C, hija del también matemático y astrónomo Teón. Desde bien joven recibió una enseñanza en ciencias, pero su busca de conocimiento y verdad la llevaron a recorrer diferentes puntos de Atenas y Roma en busca del saber. Ese afán la llevó a la enseñanza, a la oratoria como directora de la escuela de Teón, también conocida como Museion. Destacó durante años como maestra de muchos alumnos tanto cristianos como no cristianos. Aportó escritos en campos como Geometría, Álgebra y especialmente Astronomía. Desafortunadamente falleció linchada por una turba de cristianos en el año 415. El Siglo de las Luces Émilie du Châtelet Gabrielle Emilie Le Tonnelier. Fuente. A principios del siglo XVIII, nace en Francia, Émilie du Châtelet , marquesa de Châtelet, que pese a que podía haber disfrutado de una vida plena de lujos y extravagancias, decidió dedicarse a la investigación a la divulgación de sus teorías, algunas incluso provocando amplios debates en Europa. Destacó sobre todo por su papel en la difusión de las teorías newtonianas, por sus trabajos en el Cálculo Diferencial e Integral. Dada su posición, recibió grandes conocimientos matemáticos de grandes profesores de la época como, Pierre Louis Moreau de Maupertuis, Clairaut, o Koenig entre otros. La influencia de Voltaire fue notable en la marquesa durante muchos años, ambos hicieron una gran pareja, tanto sentimental como laboral. De hecho, ambos estuvieron a punto de ganar el concurso en 1737 organizado por la Academia de Ciencias al mejor ensayo científico sobre la naturaleza del fuego y su propagación, ganado por el famoso matemático-físico Leonhard Euler. La marquesa de Châtelet fue la primera mujer que entró en el Café Gradot para discutir de matemáticas con Maupertuis vestida de hombre, cabe recordar que en aquella época las mujeres no tenían permitida la entrada en dichos lugares sin ir acompañadas. Además, fue la primera mujer en tener un debate científico público. María Gaetana Agnesi También durante el siglo XVIII nos encontramos con la matemática italiana María Gaetana Agnesi, considerada por muchos como la primera profesora universitaria, pues se encargó en 1748 durante dos años de los cursos de su padre. En 1750, después de publicar su obra de las Instituciones analíticas, el Papa le dio el nombramiento para ocupar la cátedra de Matemáticas superiores y Filosofía Natural de la Universidad de Bolonia. El esplendor del Siglo de las Luces se extiende… Sofia Kovalévskaya Sofia Kovalévskaya. Fuente. Sin embargo, otros autores afirman que la matemática rusa Sofia Kovalévskaya, fue la primera profesora universitaria con plaza en Europa en 1881, en Suecia. Recibió clases del famoso matemático Weierstrass en Berlín. Su aportación al Cálculo Diferencial fue muy importante, sobre todo consiguió mejorar un resultado del matemático Cauchy, enunció y demostró el teorema conocido hoy en día como Cauchy-Kowalevski. Esto fue uno de los motivos por los cuales le valió obtener el título de Doctora Summa Sum Laude en la Universidad de Gotinga en 1874, convirtiéndose junto a Agnesi en una de las primeras mujeres en el mundo en conseguirlo. Durante su estancia en Estocolmo su estudio de Cálculo Diferencial consiguió resolver uno de los problemas que más habían atribulado a matemáticos famosos: la rotación de cuerpo sólido en torno a un punto fijo, que junto a las soluciones conocidas de Euler y Lagrange se resolvió el problema planteado en 1850 por la Academia de Ciencias de Berlín. Hoy el día Sofía Kovalevsky, organizado por la Asociación de Mujeres en Matemáticas (AWM), promueve la financiación de talleres en los Estados Unidos para alentar a las niñas a explorar las matemáticas. Sophie Germain Hacia finales del siglo XVIII, nos encontramos con la matemática francesa Sophie Germain. Destacó entre otras cosas por el desarrollo de la Teoría de Números y la Teoría de la Elasticidad, pero sobre todo de su estudio podemos destacar los números primos de Sophie Germain y el intento de demostración del teorema de Fermat, que pese a no conseguirlo pudo extraer conclusiones como el teorema que lleva su nombre. Durante su vida mantuvo correspondencia con los matemáticos Lagrange y Gauss. En ambos casos y dados los tiempos que eran Sophie Germain se hacía pasar por hombre, solo al cabo de un tiempo dio a conocer su verdadera identidad. En 1816 ganó el concurso, con el trabajo que tenía por título “Mémoire sur les Vibrations des Surfaces Élastiques” Se convirtió en la primera mujer que asistió a las sesiones de la Academia Francesa de las Ciencias. Hoy en día se otorga anualmente Premio Sophie Germain al investigador/a que haya realizado el trabajo más importante en Matemáticas. La inspiración de Ada Lovelace Mary Somerville Durante el avance de las universidades escocesas frente a otras europeas, comandadas por el científico Lord Kelvin, surge la figura de Mary Somerville. Nació en Edimburgo en 1740, y pese a que en aquella época las mujeres no podían acceder a universidades ni sociedades matemáticas, no le impidió divulgar sus conocimientos adquiridos y conseguir la medalla de plata por la solución de un problema sobre las ecuaciones diofánticas en el Mathematical Repository de William Wallace. Además, en 1826 Mary Somerville escribió su primer artículo The Magnetic Properties of the Violet Rays of the Solar Spectrum para Royal Society en Philosophical Transactions y eran los primeros escritos firmados por una mujer hasta la fecha. Entre sus logros más destacados podemos destacar su trabajo en Astronomía en el estudio de la órbita de Urano, algo que permitió años después el descubrimiento del planeta Neptuno, dicho trabajo le valió la medalla de honor de la Sociedad de Astronomía y diferentes medallas reconocimientos en diferentes sociedades y universidades europeas. Ada Lovelace Ada Lovelace circa 1836. Fuente. Mary Somerville fue una inspiración para Ada Lovelace. Ada Augusta Byron, hija del poeta Lord Byron y de la también matemática Anne Isabella Noel Byron, nació en 1815, y destaca por el trabajo que realizó junto a Charles Babagge en la construcción de una máquina diferencial y la analítica (esta última nunca la llegó a construir), posiblemente la precursora de los ordenadores. Todas las contribuciones de Ada aportadas al funcionamiento de la máquina de Babbage tenía que firmarlas bajo las siglas AAL y estas notas se han convertido en lo que hoy día en la base de lo que hoy llamamos algoritmos informáticos. Por lo tanto, podemos afirmar entonces que Ada Lovelace fue la primera programadora de la Historia. Y pese a su muerte temprana, su legado es reconocido hoy en día, recibiendo un lenguaje de programación su nombre ADA. Las grandes injusticias y los tiempos modernos Amalie Emmy Noether Una de las grandes injusticias que se han cometido con las mujeres matemáticas por su condición de sexo es sin duda la sufrida por Amalie Emmy Noether. Emmy nació en Alemania en 1882, destacó por su trabajo en el campo del Álgebra y la Topología, pero pese a sus grandes conocimientos, estudios y la ayuda de matemáticos como David Hilbert y Felix Klein, no consiguió una plaza en la universidad, ni durante su etapa en Alemania ni en Estados Unidos en la universidad de Princeton, debía dar sus clases en el College para señoritas Bryn Mawr. Maryam Mirzakhani Maryam Mirzajani. Fuente. De los últimos años nos gustaría resaltar la figura matemática iraní Maryam Mirzakhani, nació en 1977 en Teherán y ha estado dando clases en Stanford, hasta su fallecimiento temprano a los 40 años. Se dedicó al estudio de la Geometría, Topología y Cálculo Diferencial, pero sobre todo a las superficies hiperbólicas y de Riemann. Maryam tiene el honor de ser la primera mujer que ha recibido la medalla Fields, premio cada cuatro años desde 1936 que tiene el reconocimiento académico similar al premio Abel desde 2003 y al Premio Nobel (Recordemos que Alfred Nobel no consideró otorgar Premio Nobel matemático por las diferentes leyendas que hablan de “problemas” con los matemáticos). * * * Nota personal de Fran Fenoll Me gustaría resaltar a una matemática en mi vida, que fue toda una inspiración y modelo a seguir, su nombre es Fuensanta Andreu (1955-2008) Catedrática de Matemática aplicada de la Universidad de Valencia. Tuve la gran suerte de tenerla como profesora, no sólo por todo su trabajo en el análisis funcional y diferencial sino la cercanía y la sencillez con la que transmitían sus clases. Gracias por tu paciencia y ayuda. AI OF THINGS Las Matemáticas del Machine Learning ¿Qué debo saber? 19 de febrero de 2019

9 de marzo de 2023

AI & Data

Las matemáticas del Machine Learning: Números aleatorios y dónde encontrarlos (II)

En el artículo anterior mencionamos la importancia que tienen en nuestro día a día los números aleatorios, utilizados para realizar cualquier tipo de simulación y fundamentales a la hora de la seguridad en un mundo cada vez más digital. Sabemos que su origen se remonta al principio de los tiempos, y su evolución ha sido constante desde entonces. No obstante para conseguir una secuencia de números aleatorios necesitaremos un determinado algoritmo determinista el cual asemeje su secuencia a una realmente aleatoria. Dichos algoritmos reciben el nombre de generadores de números pseudo-aleatorios. En este artículo nombraremos algunos de ellos y su importancia a lo largo de nuestra historia. Fueron Maurice Kendall y Bernard Babington-Smith a finales de los años 30 quienes nos aportaron nada más y nada menos que 100.000 dígitos completamente aleatorios, una cifra que en aquella época era todo un logro, y que hasta que Rand Corporation en 1955 publicó un millón de dígitos fueron ampliamente utilizados en diferentes campos de investigación. Pero podríamos afirmar que los grandes impulsores de los números aleatorios fueron Von Neumann, Metropolis, Ulam y Lehmer, quienes con sus diferentes métodos revolucionaron el mundo de lo aleatorio. El método MidSquare Durante los años 40, John Von Neumann y Nicholas Metropolis desarrollaron el método de los cuadrados medios, Mid-square Method. Originalmente dicho método era para poder generar números pseudoaleatorios de 4 dígitos, aunque bien es cierto que el algoritmo también funciona si introducimos un valor inicial x0 que tenga 2n cifras. El algoritmo en reglas generales consiste en los siguientes pasos: Coger un valor inicial denominado semilla x0 de 4 dígitos. Elevar dicho número al cuadrado x20 y obtener sus 4 cifras centrales x1. Se genera un número pseudoaleatorio: Figura 1. Fórmula para generar un número pseudoaleatorio 4. Volver al paso 2 y repetir proceso. Continuaremos repitiendo y obteniendo una sucesión hasta obtener un valor repetido, lo que producirá que la secuencia pase a ser cíclica y por tanto predecible completamente. En el siguiente fichero PDF contiene un par de ejemplos obtenidos utilizando este método: method-square Download Métodos Congruenciales Hoy en día, los métodos más utilizados para obtener una sucesión de números pseudo-aleatorios son mediante los generadores congruenciales lineales, (GLC), los cuales fueron introducidos en 1951 por Lehmer. Un generador GLC es un algoritmo que obtiene números pseudoaleatorios a través de una función lineal definida a trozos discontinua. La sucesión de números pseudoaleatorios se obtiene mediante la siguiente fórmula de recurrencia: Figura 2. Fórmula de recurrencia. Donde m es un número natural, recibe el nombre de módulo, a es el multiplicador y b el incremento. Además tanto a como b son números naturales menores que el valor m. Diremos que se trata de un generador congruencial lineal multiplicativo (GLMC) cuando b=0. Dicho generador también recibe el nombre de Generador de números pseudoaleatorios de Lehmer. En caso de que b sea no nulo diremos que el generador congruencial es mixto. La secuencia de números generada será el residuo de la operación aXk+b entre m. Eso es lo que significa el operador mod. Por lo tanto los resultados del residuo de la división pueden ir desde 0 hasta m-1. Veamos a continuación un ejemplo: Consideramos x0 = 17, a = 6, b = 5, m = 38 xk a b axk+b m mod m x{k+1}177512436161616 117 999 68 323232 229 131313 96 242424 173 292929 208 282828 201 212121 152 888 61 252525 180 000 5 555 40 444 33 333333 236 202020 145 111 12 121212 89 171717 124 161616 117 99 Los números pseudoaleatorios, los obtenemos: Figura 3. Fórmula para obtener los números pseudoaleatorios. Otros métodos de la actualidad Uno de las variantes de los métodos congruenciales evolucionados de los métodos congruenciales lineales de Lehmer es el conocido como Generador Lagger-Fibonacci. El nombre es por la familiaridad con la famosa serie de Fibonacci. La serie de recurrencia viene dada por la siguiente expresión: Figura 4. Fórmula para la serie de recurrencia. Donde: M = 2m , siendo m cualquier entero positivo. ⊗ es cualquier operador binario como + , - , * ... 0 < J < k < n Entre sus características podemos destacar que el máximo periodo generado puede ser (2k - 1) * 2m-1, y además puede generar hasta 2k-1 * 2m-1 ciclos diferentes con periodo máximo. Otro generador muy utilizado por su alta calidad es el generador Mersenne twister que fue desarrollado por Makoto Matsumoto y Takuji Nishimura en 1997. El nombre proviene de que su longitud del periodo proviene de un número primo de Mersenne. (Mn = 2m-1 - 1). Dicho generador es utilizado a día de hoy en programas como Python, Ruby, Excel, C++, Mathlab entre otros, pues puede generar un periodo de 219937 - 1. Nostalgia retro Para terminar este artículo y como anécdota, durante los años 80 en tiempos del famoso Spectrum y Commodore 64, muchos de nosotros nos quedamos realmente maravillados ante la simpleza y la complejidad de los números aleatorios. En concreto, había una sola línea, en este caso para el BASIC de Commodore 64 que era la siguiente: 10 PRINT CHR$(205.5+RND(1)); : GOTO 10 Esta simple línea de código generaba maravillosos laberintos interminables. Muchos quedamos maravillados con lo que era posible generar simplemente con una sola linea de programación. Este simple programa define, como ningún otro, la maravillosa relación de los números aleatorios con la programación. Por cierto, hay incluso un libro (que podéis descargar desde aquí) hablando del impacto y lo maravilloso de esta simple línea de código. Recuerda que este articulo es uno más de nuestra serie de Matemáticas del Machine Learning: Las Matemáticas del Machine Learning ¿Qué debo saber? Las Matemáticas del Machine Learning: explicando la Regresión Lineal (I) Las Matemáticas del Machine Learning: Ejemplos de Regresión Lineal (II) y Multilineal. Las Matemáticas del Machine Learning: Ejemplos de Regresión Lineal (III) y Multilineal. Contraste y Fiabilidad. Las Matemáticas del Machine Learning: Ejemplos Regresión Lineal (IV y último). Implementación en lenguaje R Las Matemáticas del Machine Learning: Redes Neuronales (Parte I) Las Matemáticas del Machine Learning: Redes Neuronales (Parte II) Las matemáticas del Machine Learning: Funciones de activación Las matemáticas del Machine Learning: el mecanismo de Backpropagation Las matemáticas del Machine Learning: Números aleatorios y dónde encontrarlos (Parte I) Escrito para LUCA por el matemático Fran Fenoll (@ffenoll16) y Fran Ramírez (@cyberhadesblog y @cybercaronte) del equipo de Ideas Locas CDCO de Telefónica).

24 de febrero de 2021

AI & Data

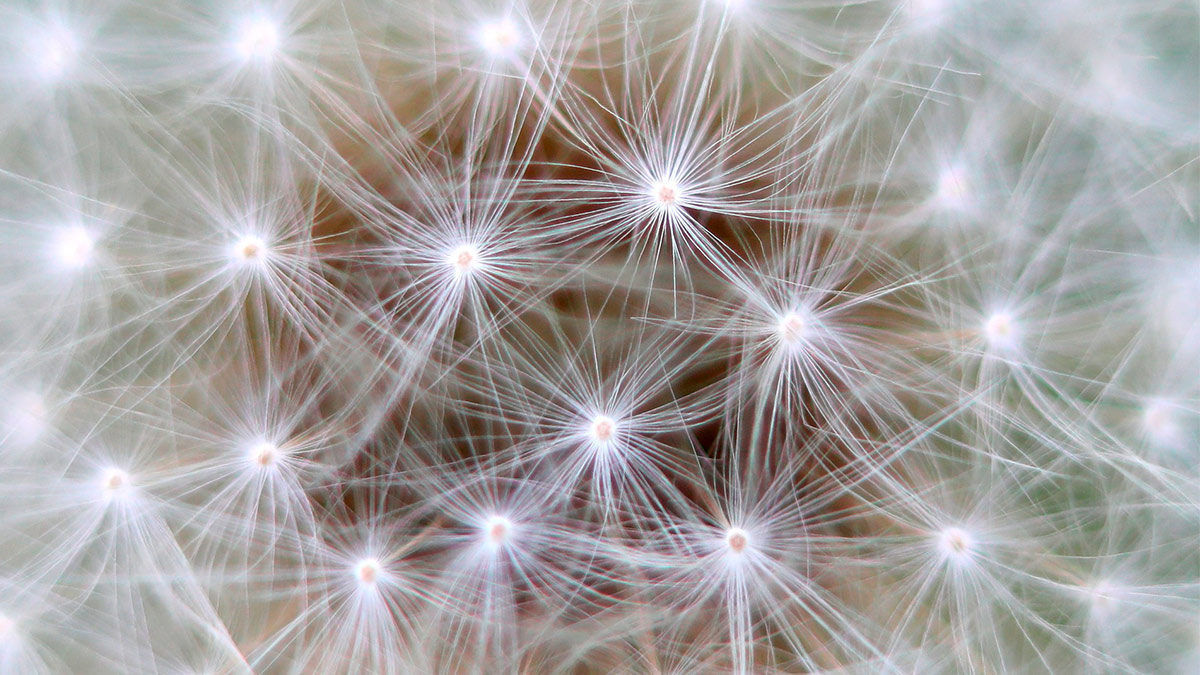

Las matemáticas del Machine Learning: Números aleatorios y dónde encontrarlos (Parte I)

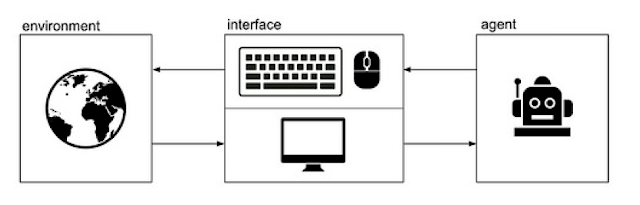

¿Cuántas veces a la hora de repartir algo con los amigos/as hemos dicho: "piensa en un número del 1 al 10"? ¿La respuesta es realmente aleatoria? Si utilizamos una calculadora o un ordenador, ¿sería más aleatoria? O por el contrario ¿existe un algoritmo que genere dicho número aleatorio? ¿Los patrones en los juegos son predecibles, o no lo son? En caso de serlos, ¿podríamos encontrar un algoritmo y resolverlo siguiendo los pasos?. Nuestra compañera Paloma Recuero ya nos ha hablado en algunos artículos sobre los números aleatorios ofreciendo siempre un enfoque práctico hacia la Inteligencia Artificial y el Machine Learning utilizando Python: Python para todos: ¿Por qué usamos números aleatorios ? Python para todos: 5 formas de generar datos aleatorios Por nuestra parte, en Ideas Locas CDCO también hemos trabajado con ellos como en este proyecto de una baliza generadora de números aleatorios con una Raspberry Pi. Por lo tanto, como habéis podido comprobar, los números aleatorios están en todas las facetas de la tecnología y sí, también en los videojuegos como veremos más adelante. Figura 1. Funcionamiento de la baliza de números aleatorios donde se puede comprobar la utilización de los diferentes sensores para generarlos. Significado de "aleatoriedad" Pero vayamos por pasos. Antes de ver si podemos predecir o no estos números, tengamos en cuenta lo que significa aleatoriedad. Podemos definir la aleatoriedad como un proceso en el cual el resultado es imprevisible, un proceso en el cual solo influye el azar. Por ejemplo la extracción de una bola de una urna que contiene 5 bolas numeradas del 1 al 5, es un proceso aleatorio. Sin embargo, si hablamos de extraer un número par o impar de una urna de bolas numeradas del 1 al 5 no se trataría de un proceso aleatorio. ¿Cuál es la diferencia entre el primer y segundo caso? La probabilidad de los sucesos, en el primer caso todos tenían la misma probabilidad, eran equiprobables, pero en el segundo caso la probabilidad de obtener un número par es menor que la de obtener un número impar. Si nosotros pensamos ahora mismo un número al azar, ¿es realmente aleatorio? O por el contrario tenemos algún favorito o algún número que se repite más en nuestra mente. Nosotros podemos estar sugestionados por algún número en particular, pero las máquinas no (excepto Terminator que demuestra que tiene sentimientos). Entonces, ¿cómo conseguimos un generador de números aleatorios realmente eficaz? Generadores aleatorios El concepto de aleatoriedad se conoce desde tiempos antiguos y diferentes culturas. Por ejemplo, según la mitología griega, Zeus, Poseidón y Hades, una vez derrotaron a Cronos, se repartieron a suertes quién reinaba en el cielo, tierra y el inframundo. Los números aleatorios han sido utilizados tradicionalmente en una gran variedad de aplicaciones (juegos, aplicaciones, criptografía, experimentos científicos, etc.). Desde el principio de la historia, “la calidad” o “pureza” de estos números aleatorios determinará el éxito en la resolución de los problemas en diferentes áreas. Por lo tanto, ¿cómo podemos encontrar o generar una sucesión de números aleatorios? Figura 2. A la izquierda, presentación gráfica de un número aleatorio y a la derecha otra representación de uno menos eficiente al incluir patrones de repetición. Fuente. Un generador de números aleatorios es un dispositivo informático o físico diseñado para producir secuencias de números sin aparentemente orden alguno. Conviene resaltar que los números aleatorios no deben ser generados con métodos escogidos al azar. Las sucesiones de números aleatorios reales se fundamentan en fenómenos físicos como la radioactividad, erupciones solares, sonidos atmosféricos,… Random.org Por ejemplo en RANDOM.ORG podemos encontrar verdaderos números aleatorios en un determinado rango elegido por el usuario. La aleatoriedad proviene del sonido atmosférico, que para muchos propósitos es mejor que los algoritmos de números pseudo-aleatorios, de los cuales hablaremos a continuación. RANDOM.ORG se usa fundamentalmente para realizar sorteos, loterías, para impulsar juegos en línea, para aplicaciones científicas y para arte y música. El servicio existe desde 1998 y fue creado por el Dr. Mads Haahr de la Escuela de Ciencias de la Computación y Estadística del Trinity College de Dublín en Irlanda. Los números generados a partir de la teoría matemática y con ayuda de computadoras que logran pasar las pruebas estadísticas con respecto a su carácter aleatorio, reciben el nombre de números pseudoaleatorios. Un generador de números pseudoaleatorios, también conocidos por sus siglas en inglés GPAN, es un algoritmo que produce una sucesión numérica aproximada de un conjunto aleatorio de números. Desde un punto de vista más matemático/teórico definimos un generador pseudoaleatorio como una estructura: Figura 3. Estructura de un generador pseudoaleatorio Donde X es un conjunto finito, x0 es un valor inicial, T es una función de transición: Figura 4. Función de transición U es un conjunto finito de "observación" y g es la función de salida: Figura 5. Función de salida Básicamente, a partir de un valor x0, se genera una sucesión xn mediante una función de recurrencia: Figura 6. Función de recurrencia Cada uno de estos números genera a su vez un número pseudoaleatorio: Figura 7. Número pseudoaleatorio La sucesión de estos números es periódica dado que X es un conjunto finito. Podemos decir que un buen generador de números pseudoaleatorios tiene que tener una sucesión no repetitiva tan larga como sea posible. Es decir, que cuanto más tarde en volver a generar un número pseudoaleatorio repetido, mejor. Modelos más conocidos A finales de los años 30, Maurice Kendall y Bernard Babington-Smith obtuvieron 100.000 dígitos aleatorios, gracias a uno de los primeros dispositivos mecánicos que producían números aleatorios. Dicho dispositivo recopilaba dígitos aleatorios obtenidos mediante la iluminación de una lámpara relámpago sobre un disco giratorio iluminado. Dichos dígitos fueron ampliamente usados hasta la publicación por parte de la RAND Corporation de un millón de dígitos aleatorios en 1955. Podemos decir que los modelos de generadores aleatorios nacieron en la década de los cuarenta gracias a Von Neumann, Nicholas Metropolis ( ¿o quizás deberíamos decir Arianna Rosenbluth?), Ulam y Lehmer, que influyeron notablemente en los procesos estocásticos. Sobre todo, el punto de inflexión fue el Método de Montecarlo. Aunque originalmente Neumann y Ulam utilizaron ruletas y dados en los problemas de difusión de neutrones, hoy en día este es uno de los métodos para generar números más usado en el mundo. A continuación destacamos algunos de los generadores más conocidos o que más han influido a lo largo de los años: Midsquare method. Método congruencial lineal de Lehmer. Método Mixto de congruencias Método multiplicativo de congruencias Generador Shift-Register Generador Lagged-Fibonnaci Mersenne Twister Aplicaciones de generadores Los generadores de números pseudo aleatorios son ampliamente utilizados hoy en día, sobretodo en aplicaciones tanto de seguridad como de uso particular. Método de Montecarlo La simulación de Montecarlo, también conocida como el Método de Montecarlo debe su nombre al gran famoso casino de la ciudad de Montecarlo. La ruleta es uno de los juegos más populares de azar y apuestas, y también uno claro ejemplo de generador de números aleatorios. El objetivo principal del Método de Montecarlo no es otro que imitar el comportamiento de variables reales para predecir resultados y/o evoluciones. Este método es utilizado sobretodo en el campo de la economía, en concreto en finanzas, para crear, valorar y analizar carteas de inversión, creación de modelos de gestión de riesgo… Criptografía Hoy en día la seguridad en la información es una de las cosas más importantes que posee una empresa. Por ello la criptografía influye notablemente en la seguridad de las empresas, a su vez los números aleatorios son la fuente de esta disciplina. Algunos de los ejemplos más claros donde influyen son: Claves o firmas digitales. Mecanismos de autentificación. Llaves secretas. Videojuegos Comportamientos aleatorios o secuencias no deterministas en los juegos, por ejemplo en los juegos de azar de cartas, o algún comportamiento/movimiento de jugadores (Pacman fue uno de los primeros y prácticamente cualquier videojuego que imagines lleva números aleatorios de una forma u otra) , las piezas que salen en el Tetris, etc. Como hemos podido observar, las aplicaciones de los números aleatorios son prácticamente ilimitadas y muy importantes en el mundo de la tecnología. Por este motivo no te pierdas las siguientes publicaciones sobre este apasionante tema de los números aleatorios. Recuerda que esta serie tiene los siguientes artículos ya publicados: Las Matemáticas del Machine Learning ¿Qué debo saber? Las Matemáticas del Machine Learning: explicando la Regresión Lineal (I) Las Matemáticas del Machine Learning: Ejemplos de Regresión Lineal (II) y Multilineal. Las Matemáticas del Machine Learning: Ejemplos de Regresión Lineal (III) y Multilineal. Contraste y Fiabilidad. Las Matemáticas del Machine Learning: Ejemplos Regresión Lineal (IV y último). Implementación en lenguaje R Las Matemáticas del Machine Learning: Redes Neuronales (Parte I) Las Matemáticas del Machine Learning: Redes Neuronales (Parte II) Las matemáticas del Machine Learning: Funciones de activación Las matemáticas del Machine Learning: el mecanismo de Backpropagation Escrito para LUCA por Fran Fenoll (@ffenoll16) y Fran Ramírez (@cyberhadesblog y @cybercaronte) del equipo de Ideas Locas CDCO de Telefónica).

26 de enero de 2021

AI & Data

Neuromante vs Neurolink:"Alto, Policía de Turing: ¡usted es una IA!"

Este clásico de la Ciencia Ficción (escrito en 1984) por el genial Willian Gibson llamado "Neuromante" (Neuromancer), es una auténtica montaña rusa de emociones, donde se mezclan diversos géneros (acción, mafia, cine negro, ciencia ficción, etc), implantes biónicos, hackers, ciberdelincuentes, Inteligencia Artificial, drogas, psicodelia y un largo etcétera. En la sociedad descrita en el libro, prácticamente todo el mundo tiene su propio implante electrónico en alguna parte de su cuerpo, ya sea para potenciar algún sentido o para “simplemente” conectarse a algún dispositivo. La navegación por el Internet del libro que Gibson denominó con gran acierto “Ciberespacio” (término que se utiliza hoy día y se acuñó por primera vez en este libro) se realiza justamente de esa manera, conectando el cerebro directamente a la red. Qué locura ¿verdad? Conectar aparatos directamente al cerebro humano … vaya ocurrencia ¿a quién se le ocurriría semejante idea a día de hoy?. Pues a Elon Musk, quién si no ;) Neuromante, el icono "Ciberpunk" Pero antes de ver las relaciones entre la última idea de Elon y Neuromante, vamos a adentrarnos un poco en las entrañas de fantástico libro, ya un clásico de la Ciencia Ficción, símbolo del movimiento Ciberpunk que inspirado obras de arte como Matrix o Ghost in the Shell, entre muchas otras. Aviso importante, habrá spoilers (aunque pocos...) En esta novela, se nos presenta un mundo distópico donde como antes hemos comentado, las conexiones al Ciberspacio y con otros dispositivos electrónicos se realizan usando una interfaz implantada directamente en el cerebro. Al conectarse por ejemplo a la red (que por cierto, la cual denomina también “Matrix”), el ciberespacio aparece ante nosotros en todo su esplendor en algo parecido a lo que sería hoy día la realidad virtual. Y por supuesto, la Inteligencia Artificial tiene un papel bastante importante dentro de la historia, como ahora veremos. Figura 1. Portada de la primera edición de Neuromante. Fuente. Henry Dosertt Case, el “console cowboy” Henry Dorsett Case, es un hacker, adicto a las drogas y un cibercriminal (recuerda, un hacker NO ES un cibercriminal) de poca monta que vive en los suburbios de Chiba City, en Japón. Debido a un pequeño incidente con una de las mafias locales (básicamente le pillaron robándoles), estos le inyectan una toxina en su cuerpo la cual le bloquea el uso de su interfaz de conexión. Esto para él es la perdición ya que es su principal medio de vida y es entonces cuando comienza a buscar alguna clínica ilegal que le ayude a eliminar dicha toxina. Esto le lleva a una espiral de autodestrucción de la cual es salvado por Molly, una “samurái callejera” que trabaja para otro misterioso personaje llamado Armitage. Este le ofrece a su vez una cura a cambio de algunos "trabajos" variados, pero además, le implanta un recambio de su páncreas con otro capaz de evitar que metabolice cocaína y anfetaminas, y de esta forma eliminar su mortal adicción a las drogas. Lo que no sabía Case es que también le habían insertado unos sacos con un veneno que le quitarían cuando terminara de realizar todo su trabajo. A partir de este punto comienza realmente la aventura de Case. A medida que Armitage le va encargando diferentes misiones, Case también intenta averiguar quién es ese misterioso personaje a la vez que aparecen otros muy interesantes dentro de la historia. El desarrollo de la trama es demasiado largo y complejo para tratarlo aquí así que vamos a centrarnos en aquellos que están relacionados directamente con la Inteligencia Artificial y de una forma más indirecta, con el trabajo de Elon Musk. Fi gura 2. Imagen de Shibuya (Tokio), escenarios que influyeron en la estética de Neuromante. Fuente. Volcando la mente en una ROM El primer trabajo que Armitage le asigna a Case es robar una ROM. Hasta aquí nada excepcional, es "simplemente" robar un chip. Pero lo interesante de esta misión es que dentro de ese chip se encuentra, nada más y nada menos, la conciencia completa de una persona. En concreto, de un experto hacker llamado McCoy Pauley o también llamado “The Dixie Flatline” fallecido unos años antes. Y este es uno sólo uno de los maravillosos conceptos futuristas que nos regala Neuromante: almacenar la conciencia de una persona fallecida en un medio de almacenamiento electrónico. Esto además es un primer salto hacia una posible inmortalidad del ser humano (este concepto es también brillantemente implementado en la serie Black Mirror aunque de manera un poco más superficial). Pero por otro lado abre otro abanico de problemas tanto éticos, espirituales o incluso morales ¿es realmente la misma persona? ¿se puede “clonar” esa conciencia? Etc. Además, esta integración mente-máquina abre todo un campo de posibilidades donde sólo podemos soñar las habilidades que esta podría tener en nuestro mundo actual super conectado. Esto provocaría que, junto al a Inteligencia Artificial, sería prácticamente indistinguible una consciencia humana de una IA. Pero además, una posible fusión entre ellas podría dar lugar a toda una super raza, superior incluso a aquellas que hemos imaginado como Skynet al integrar ambas, la consciencia humana y la IA, las cuales podrían llegar a dominar ambos mundos, el real y el virtual. Es más, estas consciencias o incluso las IA, podría acceder directamente al cerebro de las personas a través de esa interfaz de conexión en una especie de "posesión diabólica" digital. Vaya lío ¿no?. Pero no os preocupéis, para eso tenemos a la Policía de Turing. Figura 3. Detalle de un cartucho de videojuegos con memorias ROM. Fuente. La policía de Turing, para poner un poco orden La Policía de Turing (maravilloso nombre con infinitas implicaciones) aparece en la novela justo para eso, controlar a la Inteligencia Artificial. De hecho, su principal misión es regular su potencia o poder, limitando (utilizando dispositivos o software bloqueador e incluso otras IA) por ejemplo, que pueda mezclarse con una consciencia o que esta se fusione con otros dispositivos, arquitecturas o incluso, pueda acceder a un cerebro humano y finalmente también fusionarse con él. En otras palabras, esta policía existe para evitar que esta crezca de manera descontrolada o llegue a tener demasiado poder. Por cierto, hoy día existe un organismo, que a pesar de estar muy lejos del concepto “Policía de Turing”, comparten el mismo principio: controlar a la IA por el bien de la humanidad. Y este organismo se llama OpenAI cuyo eslogan es “Our mission is to ensure that artificial general intelligence benefits all of humanity”. ¿Y sabéis quién está detrás de esta organización? Habéis acertado otra vez: Elon Musk. Wintermute y Neuromante, el Ying y el Yang del ciberspacio En este mundo ciberpunk, las IA son una herramienta habitual para todo tipo de situaciones y aplicaciones. Cada hacker tiene su propia colección en su caja de herramientas las cuales va utilizando en función de las necesidades, sobre todo para realizar sus “gestiones” dentro del ciberespacio. Estas inteligencias artificiales están alojadas en grandes servidores dentro de las diferentes corporaciones (¿alguien dijo cloud?) y se mueven a su antojo por todos los rincones del ciberespacio, pero también del mundo real a través de los diferentes interfaces implantados en los seres humanos. Wintermute y Neuromante, son dos poderosas inteligencias artificiales cuyo objetivo principal es fusionarse en una sola IA (bueno, en realidad es el objetivo sólo de Wintermute) y además, obtener algún host, es decir, fusionarse a su vez con un ser humano. El problema es que ambas tienen esos mecanismos introducidos por la Policía de Turing los cuales bloquean cualquier intento por conseguirlo. Ambas IA tienen un gran protagonismo en la historia actuando en diferentes situaciones en las cuales podemos ver sus grandes dotes de manipulación. Es decir, llegados a un punto, es prácticamente imposible distinguir entre un ser humano, una consciencia volcada en una ROM o una Inteligencia Artificial. Antes hemos comentado que las consciencias volcadas de personalidades se almacenan en una ROM, pero las IA se almacenan en RAM. Ambos términos son utilizados dentro del contexto de la época, no olvidemos que se escribió en los años 80. Pero su concepto es interesante ya que quiere decir que una conciencia almacenada en una ROM no puede evolucionar, es decir, no puede cambiar su programación por lo cual permanece inalterada manteniendo su personalidad. En cambio, las IA tienen RAM, es decir, pueden expandir su poder de computación en función de su disponibilidad y evolucionar prácticamente sin límite desarrollando cualquier tipo de personalidad o personalidades. De hecho, la RAM es el bien más preciado dentro del mundo ciberpunk de Neuromante. Figura 4. Arquitectura de Vision AI en la nube de Google. Como ocurría en Neuromante, hoy día la potencia de la IA está ubicada en la nube. Fuente Elon Musk y la interfaz de conexión en Neuromante Aunque el proyecto de Elon Musk no tiene ni de lejos, la tecnología necesaria para llegar a crear el fantástico mundo de Neuromante, sí que abre la puerta para para soñar con un primer paso para crear esa interfaz de conexión inicial humano – máquina- ciberespacio. El pobre Elon está recibiendo muchas críticas desde el mundo científico (como desde el MIT por ejemplo), pero si algo ha demostrado el fundador de SpaceX y Tesla es que no se deja amedrentar por las críticas. En la presentación que ofrecieron recientemente básicamente mostraron unos nuevos electrodos conectados al cerebro de un cerdo, algo que decepcionó a muchos debido al hype que se creó antes del evento. Incluso se llegó a pensar que se implantaría el chip a un ser humano, algo que hasta donde sabemos, aún no se ha realizado. El implante que tenía el animal registraba las diferentes activaciones de las neuronas (capaz de registrar hasta más o menos 1.000) y esas eran convertidas a su vez a sonidos. Esto no sorprendió a los científicos, era algo que ya se había hecho antes en el pasado. Lo que sí llamó la atención de los científicos fue un dispositivo llamado “The Link”, una definición que acerca aún más esa pasarela de Neuromante con la tecnología de Musk. Este pequeño aparato de forma circular contiene la tecnología necesaria para procesar toda la información recibida desde el cerebro. Se “conecta” superficialmente con el cerebro a través de un pequeño agujero realizado en el cráneo para transmitir de forma inalámbrica los datos. En otras palabras: ya tenemos la interfaz de conexión con nuestro cerebro. Incluso han diseñado la máquina para insertar la tecnología necesaria tanto en la piel como en el cerebro. Y claro, también una app … Figura 5. "The Link". Fuente. Neuralink y la funsión IA – mente para curar enfermedades y algo más … Las implicaciones beneficiosas en el mundo de la medicina, si esta tecnología se lleva a cabo, pueden ser realmente excepcionales. Desde poder volver a dar movimiento a personas con algún tipo de parálisis hasta analizar y buscar posibles curas para enfermedades relacionadas con el cerebro como el Alzheimer, por ejemplo. Pero abre otros interrogantes como el posible daño al cerebro debido a los implantes o la seguridad de los dispositivos (nadie quiere tener un malware en su cabeza), entre otros muchos. Sobre la integración de la IA y la consciencia, algo que pasaba en Neuromante y que la Policía de Turing tenía que perseguir, es otro factor a tener en cuenta. El mismo Elon Musk habla de esta posible integración IA – mente: “On a species level, it’s important to div out how we coexist with advanced AI, achieving some AI simbiosis. Such that the future of world is controlled by the combined will of the people of the earth. That might be the most important thing that a device like this achieves.” Es decir “A nivel de especie, es importante averiguar cómo coexistimos con una IA avanzada, consiguiendo algún tipo de simbiosis con ella. De tal manera el futuro del mundo estará controlado por la combinación de las voluntades de la gente de la Tierra. Esto podría ser el logro más importante que pueda conseguir este dispositivo”. Ahí es poco. De nuevo, la realidad se parece cada vez más a la ficción. Si te ha gustado este post, no olvides visitar nuestra serie Ciencia Ficción vs Inteligencia Artificial: Ciencia Ficción vs Inteligencia Artificial: Star Wars, “…para ser un droide mecánico parece que piensas demasiado…” Ciencia Ficción vs Inteligencia Artificial: HAL 9000 “Doctor, no entiendo a los humanos” Ciencia Ficción vs Inteligencia Artificial: Saturno 3, “Héctor, robot malo, el perro no se come” Ciencia Ficción vs Inteligencia Artificial ¿Qué tal una partidita de Ajedrez, Dr. Falken? Ciencia Ficción vs Inteligencia Artificial: Interestellar, “… hey Tars, ¿cuál es tu parámetro de honestidad? Ciencia Ficción vs Inteligencia Artificial: Her, “Mi novia es un sistema operativo y no me importa lo que digan” Ciencia Ficción vs Inteligencia Artificial: “Star Trek: la película”. ET es una IA. Ciencia Ficción vs Inteligencia Artificial: Matrix ¿vivimos en una simulación? Ciencia Ficción vs IA: Cita con Rama o cómo mantener tu nave interestelar limpia y operativa con robots autosuficientes Para mantenerte al día con el área de Internet of Things de Telefónica visita nuestra página web o síguenos en Twitter, LinkedIn y YouTube

28 de octubre de 2020

AI & Data

Estado del arte de la IA aplicada a videojuegos

En el post anterior, nos planteamos por qué los videojuegos, a pesar de su extraordinario desarrollo en los últimos años, no han incorporado los últimos avances en IA y empezamos con un breve repaso a la historia de la IA aplicada a este campo. Hoy, hablaremos de cuál es el estado del arte en el momento actual. AI OF THINGS Breve historia de la IA en los videojuegos 19 de agosto de 2020 The legend of Zelda: Breath of the Wild ¿Te gusta “The Legend of Zelda: Breath of the Wild? (vaya pregunta, pues claro). Pensarás que el juego utiliza las últimas técnicas en IA para obtener este alucinante mundo abierto y cientos de personajes y entornos con los que interactuar. Pues no, lo que hace este juego tan espectacular es el trabajo minucioso de simular efectos físicos como la gravedad, cocinar, efectos climáticos, agua, fuego, hielo, etc. Es decir, crear un mundo lo más parecido al físico real simulando todo lo que sea posible, hasta el más mínimo detalle. Esto provoca que ocurran hechos totalmente aleatorios, pero no quieren decir que haya una "gran" IA detrás. Esta interacción tan realista puede llevar a casos para solucionar problemas que no son los habituales. Por ejemplo, podríamos quemar con fuego una liana que sostiene una plataforma sobre la cual hay un enemigo, romperse y este caer, muriendo finalmente. Pero si antes de caer ponemos justo en el punto de caída, por ejemplo, algo blando como paja, este no morirá. Alien Isolation Incluso juegos tan complejos y espectaculares como Alien Isolation, donde nos ponemos en la piel de una tripulante (la hija de la mítica Ripley) de una nave espacial en la cual hay un Alien campando a sus anchas, está basado en árboles de decisión. Eso sí, complejos y con mucha profundidad. Con ellos son capaces de simular una situación del juego gato-ratón. El Alien no sabe en ningún momento dónde se encuentra el jugador, tiene que averiguarlo por sí solo. Para ello, debe ir deambulando por la nave, realizando acciones para ver las reacciones, abrir puertas, hacer ruido, lanzar objetos, ser cauteloso, ruidoso, etc. Con el único objetivo de forzar una reacción por parte del jugador que finalmente haga que este aparezca y “acariciarlo”. No Man´s Sky Por último, uno de los quizás mejores ejemplos que combine todos los algoritmos que hemos comentado, sea el juego No Man´s Sky, que personalmente a mi me apasiona. Ya hablé de él en su día en nuestra sección “Ciencia Ficción vs IA”, que podéis ver aquí. En él se mezclan desde la generación procedural de escenarios, enemigos, naves, etc hasta todas las técnicas comentadas. Dwarf Frotress Pero no creáis que No Man´s Sky fue el primero, existe un juego que también me apasiona llamado Dwarf Fortress que casi es tan complejo como este. Y es sólo texto. Sí, los caracteres que aparecen en pantalla son texto ASCII, pero ordenado de forma que ofrezcan una apariencia un poco más amigable. Todo el universo es generado con algoritmos procedurales, desde los árboles hasta las cavernas pasando por la personalidad de los enanos y animales que habitan el mundo. Este juego es un RPG donde tenemos que construir una ciudad bajo tierra para enanos e ir explorando, minando y construyendo, intentando sobrevivir. Lo curioso es que cada enano tiene su propia personalidad (como antes hemos comentado) y todos están bajo la influencia del entorno (ellos y el resto de criaturas que pueblan el mundo) y de lo que hagan los otros enanos. De hecho, hay una anécdota curiosa con una enfermedad que afectaba a los gatos (adelanto ya que se emborrachaban), que también los hay en el juego, la cual no estaba prevista y ni los mismos desarrolladores ni se imaginaron que podía suceder. Básicamente, los gatos del juego estaban empezando a morir y nadie sabía el por qué. Para entender mejor lo que ocurría, tenemos que explicar que los enanos de Dwarf Fortress son tremendamente adictos al alcohol. En el momento que terminan su jornada laboral, lo primero que hacen es ir a la taberna y emborracharse como si no hubiera mañana (cosa que era muy habitual, ya que suelen morir al día siguiente). Allí los enanos derraman, vomitan, etc, es decir, manchan el suelo con restos de las bebidas. Los pobres gatos se pasean por las tabernas, sin saber que al andar, se están llevando en sus patas el alcohol derramado. Luego, ya en sus casas, los gatos se lamen (sí, esta característica también está incluida) y claro, ese alcohol pasaba en grandes cantidades a su cuerpo llegando a fallecer por intoxicación etílica (esto también le pasaba a los enanos pero estos aguantaban más que los gatos por su complexión). Este es un estupendo ejemplo que aparentemente demuestra inteligencia, pero realmente no es más que una consecuencia de llevar al límite de realismo un universo, lo que provoca eventos totalmente aleatorios, imprevistos y espectaculares. Eso sí, siempre dentro de las reglas programadas originalmente. Figura 5. Ejemplo de mapa de terreno en Dwarf Fortress ( fuente) Pues si amigos/as, básicamente hoy día también los videojuegos de última generación se basan en la búsqueda de caminos (pathfinding) y las FSM (junto a los MCST, aderezados con algunos árboles de decisión. Básicamente, lo mismo que nuestro querido Pac-Man. Entonces, ¿Por qué no son tan inteligentes? Antes de responder, tenemos que dejar claro que no es lo mismo una IA digamos, "Científica", con una IA de "Juegos". Los algoritmos de IA empleados en la IA "Científica" se aplican a la resolución de problemas, interactuando con el entorno reaccionando de manera impredecible a los acontecimientos que aparecen en sus sensores (coches autónomos, asistentes digitales, etc). Es decir, son procedimientos de autoaprendizaje para reaccionar frente a un entorno totalmente nuevo. Pero claro, en un juego no queremos que todo sea impredecible ya que esto reduciría la experiencia del jugador, y por eso necesitamos que la IA se predecible, es decir que el desarrollador sepa lo que va a pasar (al menos en un porcentaje alto). La IA "Científica" sí que es perfecta por ejemplo, para testear estos juegos. De hecho ya nos habéis visto hablar aquí de OpenAI y la resolución de juegos de Atari, por ejemplo. Pero hoy día ya podemos ver como las IA están ganando (por no decir "aplastando") poco a poco, a los mejores jugadores de juegos tan complejos como por ejemplo, StarCraft II. Ahora entendemos por qué son tan buenos los videojuegos para entrenar agentes de IA. Por lo tanto, para ofrecer una mayor experiencia de jugador (básicamente que pueda ganar o avanzar), lo que los desarrolladores quieren (excepto algunas contadas excepciones), es que el jugador obtenga la mejor experiencia inmersiva, realista pero sobre todo, jugable y controlada. Y para ello se necesita un mínimo de control sobre ese universo (aunque haya eventos impredecibles, como el de los enanos y los gatos). Conclusión Hemos podido ver que hoy día, los juegos no necesitan realmente una IA avanzada. Basta con ofrecer los universos con reglas de simulación físicas más complejas para dejar que estas, junto a los PNJ, la temática, las historias y sobre todo, la interacción con el jugador, ofrezcan la mejor experiencia. Pero podríamos responder también al por qué no hay juegos con IA tan avanzadas tan solo con esta frase: por que no sabemos realmente cómo aplicarla. Es cierto, en el momento que los desarrolladores encuentren una forma adecuada de integrar por ejemplo, Deep Learning en un videojuego, estaremos abriendo las puertas a una nueva generación de juegos que sólo podemos imaginar en la Ciencia Ficción. Bueno, os dejo que tengo que seguir con mi partidita ... ;) Para mantenerte al día con LUCA visita nuestra página web, suscríbete a LUCA Data Speaks o síguenos en Twitter, LinkedIn y YouTube.

27 de agosto de 2020

AI & Data

Breve historia de la IA en los videojuegos

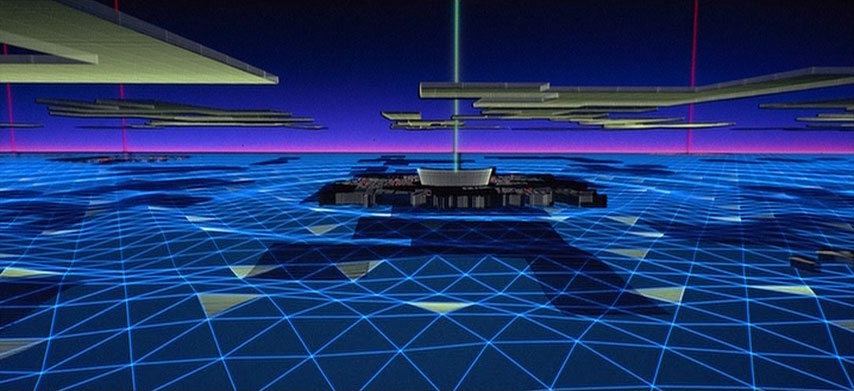

Los videojuegos son cada vez más espectaculares y cercanos a la realidad, tanto en gráficos como en la interacción entre el jugador y el entorno completo en el cual se desarrolla la acción. Sin embargo, no están utilizando los últimos avances que vemos en otros campos de la IA. ¿Por qué? Para responder a esta pregunta, empezaremos con un poco de historia. Hoy día, con la aparición de las nuevas tarjetas gráficas, podemos ver juegos absolutamente realistas con unos gráficos realmente espectaculares. Es curioso que esa misma tarjeta gráfica que muestra el mundo virtual del videojuego, también es el hardware que hace posible hoy día muchos de los avances dentro de la Inteligencia Artificial. El uso de las GPU (Graphics Processing Units) tiene un diseño perfecto para optimizar la fase de entrenamiento (sobre todo en Deep Learning), ya que estas saben gestionar perfectamente operaciones de coma flotante, es decir, operaciones matemáticas, pero utilizando la gran cantidad de cores o núcleos que tienen para paralelizar los cálculos. Pero hoy no vamos a hablar de las GPUs (posiblemente lo hagamos en otro artículo). Hoy vamos a hablar de la Inteligencia Artificial (IA) aplicada a los videojuegos que, curiosamente, no está utilizando todos los avances que vamos viendo sobre todo en el campo del Machine Learning. Podríamos pensar que, con los avances actuales, podríamos tener PNJ (Personajes No Jugadores) controlados por la máquina, mucho más inteligentes. Pues curiosamente, prácticamente los mismos tipos de algoritmos (eso sí, con mucha más potencia de cálculo para hacerlos más complejos) que se usaban hace años, se utilizan a día de hoy. Figura 1. GPU de NVidia GEFORCE 6600 GT. Fuente. Finalmente veremos que el motivo de no utilizar este tipo de IA es más simple de lo que parece. Un poco de historia Antes vamos a dar un brevísimo repaso a la historia de la IA en los videojuegos. Utilizar algoritmos para conseguir que los personajes de un videojuego tengan algún tipo de comportamiento similar a la IA, viene prácticamente desde los comienzos de la Informática, durante los años 50. Años 50 Podríamos pensar que el primer videojuego con cierto nivel de IA fue el famoso Pong, pero no. Viene de más atrás, de hecho, 20 años antes de Pong nada menos. En concreto, el primer videojuego que utilizó algún algoritmo de IA se llamaba Nim. Era un juego sencillo. Trata de ir eligiendo diferentes elementos en una estructura (los elementos clásicos son las cerillas) y ser el último en retirar un objeto. La IA implementaba teoría combinatoria de juegos utilizando operaciones lógicas binarias (aquí más información). Una curiosidad antes de continuar, Alan Turing desarrolló, antes de que existieran los ordenadores (si, en papel y lápiz, igual que el “crackeo” a la máquina Enigma, luego nos quejamos que nuestro ordenador "va lento"), un algoritmo completo para jugar al ajedrez. ) Años 70 En los 70, Atari revolucionó el mercado con juegos que ya se empezaban a tomar más en serio la programación de la IA. Antes hemos hablado de Pong, el cual realizaba cambios en el movimiento de la paleta del oponente controlado por la máquina en función de lo que iba haciendo el oponente humano. Todo esto en un juego de acción en tiempo real (aquí me he venido un poco arriba pero bueno). Otros juegos de otras empresas también empezaron a incluir estos simples algoritmos para poder ofrecer la mejor experiencia al jugados a la hora de disfrutar en solitario de los videojuegos. Space Invaders (1978) y posteriormente Galaxian (1979) fueron otros dos juegos, que aparte de revolucionar el mercado del videojuegos, también incluían IA simples (la mayoría eran patrones prefijados basándose simplmente en examinar la entrada del usuario humano, igual que hacía Pong). Figura 2. Captura de una escena del juego Pong original de 1972. Fuente. Años 80 Entonces, en 1980 apareció Pac-Man (ni se me pasa por la cabeza que alguien no conozca este juego mítico) y revolucionó la utilización de patrones dentro del mundo de la IA en los videojuegos que hasta entonces se estaban utilizando. Por ejemplo, los cuatro fantasmas del juego utilizaban diferentes patrones, cada uno podríamos decir que tenía su propia “personalidad”. El fantasma azul, llamado Inky, tenía posiblemente el comportamiento más especial. Siempre era el último en salir de la casa de los fantasmas (donde empezaban) pero además tenía la características de intentar “adivinar” hacia dónde se movería Pac-Man. Es decir, intentaba predecir (con técnicas muy sencillas, basándose en algo de aleatoriedad, cálculos para encontrar el camino más corto y un poco de vectores) hacia donde era posible que se moviera Pac-Man. Esto hacía que a veces acertara y otras fallara estrepitosamente (seguro que alguna vez habéis visto como se acercaba directo hacia vosotros un fantasma y de repente, sin motivo, cambiaba de dirección), aunque pronto volvería a intentar cazarlo. Hablar de la IA utilizada por Pac-Man daría para varias entradas, podéis visitar este enlace donde se explica en detalle su funcionamiento. Figura 3. Ejemplo del comportamiento de los fantasmas dentro de Pac-Man para calcular el camino más corto y adecuado. Fuente. Años 90 Ya en los 90, el estilo de las clásicas IA de los 80 ya había pasado de moda. Gracias a los avances en computación, los ordenadores eran cada vez más potentes por lo tanto, se podría utilizar otro tipo de algoritmos o incluso, mejorar los actuales gracias a la nueva potencia de computación. Aparecieron los juegos de estrategia en tiempo real o RTS, como Dune II o Warcraft, los cuales básicamente se basan máquinas de estado finito (FSM), algoritmos para la resolución de laberintos o cálculos para hallar el camino más corto. Pero claro, utilizar FSM puede llevar a un estado de repetición donde el ordenador siempre realizará los mismos pasos. Y aquí es donde entra MCST, Monte Carlos Search Tree o Árbol de búsqueda Monte Carlo. Este algoritmo es capaz de visualizar los posibles movimientos disponibles en un momento dado de la partida. Por cada uno de esos pasos, se realiza un análisis completo para considerar si es o no factible realizarlo. Estos avances utilizando FSM y MSCT se aplicaron también en la revolución de los juegos 3D, comenzando por Wolfstein 3D, Doom, etc. Durante los 80 también se produjo una revolución en la forma en las que los PNJ interactuaban con los jugadores humanos. Pero no sólo los PNJ, también la generación de terrenos, planetas, enemigo, etc totalmente aleatorios y únicos. Estamos hablando de la generación de datos utilizando algoritmos en vez de estructuras de datos prefijadas o generación procedural. Es decir, si una posición específica del espacio hay un planeta, este no se crea hasta que el usuario llega a él. Una vez que se acerca, estos algoritmos van creando el planeta totalmente desde cero, con un terreno, atmósfera, etc., todo ello aleatorio. Esto permite hacer los juegos mucho más interesantes ya que se puede incorporar mucha más información (¿infinita?) la cual se genera sólo cuando se necesita. Aunque no son directamente algoritmos de IA, sí que se integran perfectamente con ellos para ofrecer la mejor experiencia de juego. El precursor de la aplicación de esta técnica a los videojuegos fue el mítico Elite, desarrollado en 1984. Figura 4. Ejemplo de generación de árboles usando algoritmos procedurals. Fuente. Pues bien, en este punto, aunque podríamos estar hablando mucho más, al menos hemos reunido diferentes algoritmos populares en videojuegos, generación procedural de mundos y enemigos… finalmente ahora toca hablar de la situación actual de la IA en los videojuegos. Pero eso, lo dejamos para el siguiente post, donde daremos respuesta a la pregunta que nos hemos planteado al principio del post: ¿Por qué los video juegos no están utilizando los últimos avances en IA? AI OF THINGS Estado del arte de la IA aplicada a videojuegos 27 de agosto de 2020 Estado del arte de la IA actual aplicada a videojuegos Para mantenerte al día con LUCA visita nuestra página web, suscríbete a LUCA Data Speaks o síguenos en Twitter, LinkedIn y YouTube.

19 de agosto de 2020

AI & Data

Las matemáticas del Machine Learning: el mecanismo de Backprogation

Ya hemos hablado anteriormente sobre Backpropagation, primera parte aquí y la segunda aquí. Este fue uno de los grandes avances que impulsaron el mundo de la Inteligencia Artificial y en concreto, las redes neuronales. Dicho algoritmo apareció por primera vez en 1974 por Werboz, el cual lo introdujo en su tesis doctoral, aunque bien es cierto que hasta el 86 no tuvo un mayor reconocimiento. Con la propagación hacia atrás se conseguía evitar el problema del o-exclusivo que tenía el Perceptrón. Es un algoritmo de aprendizaje supervisado que se utiliza mayormente para entrenar redes neuronales artificiales. Durante los años 80 este algoritmo fue mejorado para ser un sistema automático de entrenamiento de redes neuronales con capas ocultas. Básicamente el mecanismo es que una vez que se le aplica un patrón a la entrada de la red como estímulo, este se propaga desde la primera capa, hasta la última, hasta generar una salida, la cual se compara con la salida deseada. Una vez tenemos la comparación de ambas se calcula una señal de error para cada una de las salidas. A rasgos generales el sistema de entrenamiento consiste en dos fases, la primera sigue estos pasos: Introducción de pesos sinápticos (aleatorios). Introducción de datos de entrada (capa de entrada) elegidos al azar entre todos los datos de entrada. Esperar una salida generada por la red (propagación hacia delante) Comparar salidas. Figura 10. Ejemplo gráfico de Backpropagation. Fuente. La segunda fase una vez comparadas las salidas obtenidas con las deseadas/esperadas, se calcula su diferencia y sigue los siguientes pasos: El error (diferencia entre las salidas) se utiliza para ajustar los pesos sinápticos de cada capa de neuronas. El error se va propagando hacia atrás, hacia las capas anteriores, comienza por la capa de salida y va yendo hacia atrás, de ahí su nombre back-propagation, hacia la capa de neuronas anterior. Continua propagándose hacia atrás capa por capa, ajustando los diferentes pesos sinápticos hasta llegar a la última capa, o primera según se mire, la capa de entradas. ¿Cuáles son las grandes características que lo diferenciaban con otros algoritmos de la época? Se basa en una generalización de la Regla Delta (la cual es una variante del método de descenso por el gradiente). Estructura de niveles y conexiones estricta hacia atrás entre neuronas. El gran avance que supuso este algoritmo de aprendizaje es que dadas unas entradas y salidas, es capaz de autocorregirse, de adaptar los pesos de las neuronas de las capas intermedias y aprender/entender la relación que pueda existir entre el conjunto de entradas y salidas. Como hemos mencionado anteriormente el algoritmo backpropagation o propagación hacia atrás fue introducido por Werbos en su tesis doctoral de 1976, pero fueron David E. Rumelhart y James McClelland quienes en 1986 gracias a los avances computacionales de la época comenzaron a fomentarlo en su libro, donde además consiguieron promover el movimiento del "conexionismo". También mencionar el gran avance que supuso la creación del grupo PDP (Parallel Distributed Processing), gracias al cual resurgió buena parte del campo en redes neuronales desde la publicación de Minsky y Papert. Figura 11. Marvin Minsky (izquierda) y Seymourt Papert. Fuente. Por último nos gustaría mencionar y explicar más adelante, (quien sabe si en el siguiente artículo) otras grandes aportaciones de esta época: La neurona Hoopfiel y su función de activación. Mapas de Kohonen Máquina de Boltzmann Con estas últimas aportaciones llegaríamos a los 90, donde el campo de las redes neuronales y la inteligencia artificial comenzaría su gran expansión y avance, un avance que crece exponencialmente hasta nuestros días gracias al poder computacional de los ordenadores. Las redes neuronales permiten hoy día, entre otras cosas: Investigación en campos como la medicina mediante el análisis de grandes datos. Inversión en mercados. Estudio y predicción de sucesos. Reconocimiento de patrones. Visión artificial Etc Hoy día, con el Machine Learning y el Deep Learning, las redes neuronales están máxima actualidad. De hecho, el número de investigaciones y nuevos papers científicos está en contínuo movimiento. Quizás una de las investigaciones relacionadas con las redes neuronales y el Deep Learning han sido las GANs o Generative Adversarial Networks. Esta nueva arquitectura ha revolucionado para siempre el mundo de la Inteligencia Artificial, ya que ha abierto un nuevo campo de exploración. Hasta ahora, sólo podíamos clasificar y predecir, pero gracias a las GANs podemos generar nuevo contenido. Temas tan de moda como los DeepFakes o incluso la generación de obras de arte imitando a artistas famosos son consecuencia de esta gran investigación desarrollada por Ian Goodfellow. Como vemos, esto no ha hecho más que empezar. Seguro que veremos más avances espectaculares en los próximos años o incluso meses. Estaremos atentos. No os perdáis el resto de esta serie de "Matemáticas y el Machine Learning": Las Matemáticas del Machine Learning ¿Qué debo saber? Las Matemáticas del Machine Learning: explicando la Regresión Lineal (I) Las Matemáticas del Machine Learning: Ejemplos de Regresión Lineal (II) y Multilineal. Las Matemáticas del Machine Learning: Ejemplos de Regresión Lineal (III) y Multilineal. Contraste y Fiabilidad. Las Matemáticas del Machine Learning: Ejemplos Regresión Lineal (IV y último). Implementación en lenguaje R Las Matemáticas del Machine Learning: Redes Neuronales (Parte I) Las Matemáticas del Machine Learning: Redes Neuronales (Parte II) Escrito para LUCA por Fran Fenoll (@ffenoll16), Fran Ramírez (@cyberhadesblog y @cybercaronte) y Enrique Blanco (@eblanco_h) (ambos del equipo de Ideas Locas CDCO de Telefónica).

25 de junio de 2020

AI & Data

Las matemáticas del Machine Learning: Funciones de activación

En el anterior artículo nos centramos en los primeros pasos de la neurona artificial, haciendo hincapié sobre todo en el origen del Perceptrón, y de cómo Minsky y Papert expusieron las limitaciones del Perceptrón Simple. En esta segunda parte de la evolución de las redes neuronales veremos qué consecuencias tuvieron en el campo de la investigación, y de cómo a partir de los años 80 hubo un gran auge en el mundo de la Inteligencia Artificial. En cambio, durante finales de los 70 y principios de los 80 encontramos muy poco movimiento. Hay muchos factores que influyeron en dicha ralentización en las investigaciones, pero posiblemente la falta de inversión al no ver resultados prácticos o comerciales puede ser quizás uno de los principales. Esto cambiaría radicalmente durante la década de los 80, ya que justo aquí comenzó el auge del computador, tanto personal como los supercomputadores (por ejemplo, los Cray). De esta forma ahora era posible corregir errores en las teorías y lo mejor de todo, obtener resultados prácticos de los mismos. Figura 1. Superordenador Cray-2. Fuente. Un breve repaso ... A modo de repaso, el Perceptrón es un clasificador binario de modelo lineal con una relación de entrada-salida simple como en el que se realiza un producto escalar de un n número de entradas con sus pesos asociados y luego enviamos esta "entrada de red" a una función de paso con un umbral definido. Esta función de paso o función de activación, en un principio solía ser una Función de Escalón de Heaviside con un valor de umbral de 0.5. Esta función generará un único binario de valor real (0 o 1), dependiendo de la entrada. La función de escalón quedaría definida como: Figura 2. Función de escalón. La salida de la función de activación (función escalón) no deja de ser la salida de nuestro Perceptrón y nos permite realizar una clasificación binaria simple de los valores de entrada a la unidad. En este artículo de esta misma serie tenéis más información detallada sobre las redes neuronales. Buscando respuestas Pero volvamos al principio para intentar encontrar respuestas al por qué no evolucionó por aquella época el mundo de la Inteligencia Artificial, y en concreto el Perceptrón. ¿Dónde estaba el problema principal? Pues principalmente fueron dos: 1. Los Perceptrones básicos no podían procesar el circuito de o-exclusivo (XOR). Un XOR es un operador lógico, un tipo de disyunción lógica, la cual es verdadera si y solo si una de ellas es verdadera y la otra no. Si ambas son verdaderas o ambas falsas la disyunción también es falsa. 2. El segundo problema y puede que definitivo, era que los ordenadores no tenían suficiente poder de procesamiento para manejar con eficiencia el gran tiempo de ejecución que requerían las grandes redes neuronales, recordemos que estamos hablando de finales de los 60, con valores de entrada y salida binarios. Tanto el valor de los pesos como el de umbral de cada neurona se asignaban manualmente. Cuantos más Perceptrones en las capas, mucho más difícil conseguir los pesos para obtener salidas deseadas. La revolución neuronal Las funciones que gobiernan el comportamiento de la neurona artificial se llaman funciones de activación. La transmisión de esa entrada se conoce como forward propagation. Las funciones de activación transforman la combinación de entradas, pesos y sesgos. Los productos de estas transformaciones se ingresan para la siguiente capa de nodo. Muchas (aunque no todas) las transformaciones no lineales usadas en redes neuronales transforman los datos a rango conveniente, por ejemplo [0,1] ó [-1,1] . Cuando una neurona artificial pasa de un valor distinto de cero a otro, decimos que esa neurona se ha activado. Las funciones de activación se usan para propagar la salida de los nodos de una capa hacia la siguiente capa. Se tratan de funciones escalares a escalar, que produce la activación de la neurona. Este tipo de funciones permiten incorporar el modelado de datos de entrada no lineales a la red. Figura 3. Ejemplo de algunas funciones de activación. Fuente. La familia de funciones sigmoideas es la más importante y usada en las funciones de activación, pero no la única. Veamos ahora algunas funciones de activación útiles en redes neuronales, junto con sus principales características y casos de uso: Funciones de activación sigmoideas Este tipo de funciones permiten mitigar el efecto de outliers en el entrenamiento de nuestro modelo. La imagen de este tipo de funciones suele estar contenida en los intervalos o , por lo que valores muy extremos siempre estarán cerca de los límites del intervalo de esa imagen. Función logística. Convierte variables independientes de rango casi infinito en probabilidades simples entre [0,1] Figura 4. Función logística. Softmax. La función softmax es una generalización de la regresión logística que puede ser aplicada a datos continuos. Soporta sistemas de clasificación multinomial, por lo que se convierte en el recurso principal utilizado en las capas de salida de un clasificador. Esta función de activación devuelve la distribución de probabilidad de cada una de las clases soportadas en el modelo. La función Softmax calcula la distribución de probabilidades del evento sobre 'n' eventos diferentes. En términos generales, esta función calculará las probabilidades de cada clase objetivo sobre todas las clases objetivo posibles. Más tarde, las probabilidades calculadas serán útiles para determinar la clase objetivo para las entradas dadas. La principal ventaja de usar Softmax es el rango de probabilidades de salida. El rango será de 0 a 1, y la suma de todas las probabilidades será igual a uno. Si la función softmax utilizada para el modelo de clasificación múltiple devuelve las probabilidades de cada clase y la clase objetivo tendrá una probabilidad alta. Figura 5. Función Softmax. La fórmula calcula la exponencial del valor de entrada dado y la suma de los valores exponenciales de todos los valores en las entradas. Luego, la relación de la exponencial del valor de entrada y la suma de los valores exponenciales es la salida de la función Softmax. Este tipo de función de activación es muy utilizado en el modelo de regresión logística de clasificación múltiple y en diferentes niveles de capa de cara a la construcción de redes neuronales. Más detalles sobre la usabilidad de la función Softmax se puede encontrar en el siguiente enlace. Tangente hiperbólica. La tanh representa la relación del seno hiperbólico al coseno hiperbólico: tannh x = sinh x / cosh. A diferencia de la Función Sigmoidea, el rango normalizado de tanh es de [-1,1]. La ventaja de tanh es que puede manejar más fácilmente los números negativos. Figura 6. Tangente hiperbólica Funciones de activación lineales Las transformadas lineales son básicamente la función de identidad, donde la variable dependiente tiene una relación directa y proporcional con la variable independiente. En términos prácticos, significa que la función pasa la señal sin cambios. Figura 7. Función de identidad Funciones de activación Rectified Linear Las funciones de Rectificado lineal son transformaciones que activan un nodo sólo si la entrada está por encima de una cierta cantidad. Mientras la entrada es inferior a cero, la salida es cero, pero cuando la entrada supera un cierto umbral, tiene una relación lineal con el dependiente variable: con una imagen: Funciones de activación Softplus Las funciones de activación Softplus se consideran la versión suavizada de las transformaciones por rectificación lineal. Si bien la forma es similar, vemos que la función que las define es derivable en todo su dominio. Figura 8. Gráfica de Rectified Linear y Softplus. Fuente. Durante finales de los 70, uno de los grandes avances por no decir el único fue el de la neurona sigmoide o neurona sigmoidal, ésta muy parecida al Perceptrón en estructura tenía una gran diferencia, y es que al contrario que el perceptrón (que solo podía tener como entradas 0-1) podía tener entradas de cualquier valor numérico. La función sigmoidea o sigmoidal viene representada por la siguiente función: Figura 8. Función sigmoidal El estudio de esta función nos garantiza que se trata de una función continua acotada superior e inferiormente por sus dos asíntotas horizontales y=1 e y=0, pues cuando sus valores se acercan al infinito la función roza los valores 0 o 1, 0 cuando los valores son extremadamente negativos, 1 cuando los valores son exageradamente altos. La gráfica de esta función muestra además que posee un cambio de curvatura en el valor x=0, y=0.5, y tiene una forma de S como podemos observar. F igura 9. Forma de "S" de la función sigmoidal. En el siguiente post cerraremos el tema del Deep Learning explicando el mecanismo de Back Propagation. No te lo pierdas. Aquí tenéis el resto de esta serie de "Matemáticas y el Machine Learning": Las Matemáticas del Machine Learning ¿Qué debo saber? Las Matemáticas del Machine Learning: explicando la Regresión Lineal (I) Las Matemáticas del Machine Learning: Ejemplos de Regresión Lineal (II) y Multilineal. Las Matemáticas del Machine Learning: Ejemplos de Regresión Lineal (III) y Multilineal. Contraste y Fiabilidad. Las Matemáticas del Machine Learning: Ejemplos Regresión Lineal (IV y último). Implementación en lenguaje R Las Matemáticas del Machine Learning: Redes Neuronales (Parte I) Las Matemáticas del Machine Learning: Redes Neuronales (Parte II) Escrito para LUCA por Fran Fenoll (@ffenoll16), Fran Ramírez (@cyberhadesblog y @cybercaronte) y Enrique Blanco (@eblanco_h) (ambos del equipo de Ideas Locas CDCO de Telefónica).

4 de junio de 2020

AI & Data

El Juego de la Vida de Conway y la compleja belleza de lo simple