Stanford AI Index: ¿Se quedarán los LLM sin datos de entrenamiento?

Introducción

La prestigiosa universidad americana Stanford ha publicado recientemente su estudio sobre el estado actual de la Inteligencia artificial desde múltiples perspectivas: investigación, técnica, sectorial y un análisis de la percepción de esta tecnología por el público general.

Se trata de la séptima edición de este estudio que continúa siendo una referencia y una lectura más que interesante para todos los que estamos involucrados en el ámbito de la Inteligencia Artificial de uno u otro modo…buena, (y larga) lectura para el fin de semana.

En este artículo repasaremos los principales puntos destacados del estudio y profundizaremos en la posible limitación del colapso de modelos de LLM por uso de datos sintéticos, una temática particular sobre la que ya hablamos en las conclusiones de nuestro artículo sobre data poisoning incluido en la serie sobre ataques a los sistemas de Inteligencia Artificial.

Puntos destacados del estudio de Stanford

En esta sección repasamos los principales puntos del estudio aportando nuestra visión sobre algunos de ellos.

- La IA supera a los humanos en algunas tareas, pero no en todas. La IA ha superado el rendimiento humano en varios campos de referencia: clasificación automática de imágenes, razonamiento visual y comprensión del inglés por mencionar algunas.

Sin embargo, se queda atrás en tareas más complejas como matemáticas de nivel avanzado, razonamiento de sentido común (el menos común de los sentidos) y planificación. - La industria continúa dominando la investigación de IA de vanguardia. En 2023, la industria produjo 51 modelos notables de aprendizaje automático, mientras que la academia contribuyó solo con 15. También hubo 21 modelos notables fruto de colaboraciones entre industria y academia en 2023.

- El coste de entrenamiento de los modelos de última generación no para de subir. Por ejemplo, se estima que el GPT-4 de OpenAI tuvo un coste aproximado de 80 millones de dolares solamente en cómputo para su entrenamiento, mientras que para el reciente modelo Gemini Ultra de Google la factura para computo se estima en el entorno de los 200 millones de dólares. Aquí no solamente debemos pensar en el coste directo sino también en su impacto medioambiental, como sucede con las criptomonedas. En este caso es cierto que se trata de una iniciativa má centralizada en grandes corporaciones tecnológicas pero estamos convencidos que a medio-largo plazo este será un tema de debate importante.

- Estados Unidos lidera a China y a la UE como la principal fuente de modelos de IA destacados. En 2023, 61 modelos de IA notables se originaron en instituciones con sede en EE. UU., superando los 21 de la Unión Europea y los 15 de China.

- La inversión en IA generativa se dispara. A pesar de una disminución en la inversión privada total en IA el año pasado, la financiación para la IA generativa se disparó, casi octuplicando desde 2022 para alcanzar los 25,2 mil millones de dólares. Jugadores importantes en el espacio de IA generativa, incluidos OpenAI, Anthropic, Hugging Face e Inflection, informaron de sustanciosas rondas de financiación.

- Las evaluaciones robustas y estandarizadas desde la perspectiva de una IA responsable y ética de los LLM son claramente insuficientes.

Nuevas investigaciones revelan una falta significativa de estandarización en los informes de IA responsable. Los principales desarrolladores, incluidos OpenAI, Google y Anthropic, prueban principalmente sus modelos contra diferentes puntos de referencia de IA responsable. Esta práctica complica los esfuerzos para comparar sistemáticamente los riesgos y limitaciones de los principales modelos de IA. - Los datos están claros: la IA hace a los trabajadores más productivos y conduce a un trabajo de mayor calidad. En 2023, varios estudios evaluaron el impacto de la IA en el entorno laboral, sugiriendo que la IA permite completar tareas más rápidamente y mejorar la calidad del resultado. Estos estudios también demostraron el potencial de la IA para cerrar la brecha de habilidades entre trabajadores de baja y alta calificación o el proceso de onboarding a una organización. Sin embargo, otros estudios advierten que el uso de la IA requiere de una supervisión adecuada puede no llegar a ser contraproducentes.

- El progreso científico se acelera aún más, gracias a la IA. En 2022, la IA comenzó a avanzar en el descubrimiento científico. Sin embargo, 2023 vio el lanzamiento de aplicaciones de IA relacionadas con la ciencia aún más significativas, desde AlphaDev, que hace que la clasificación algorítmica sea más eficiente, hasta GNoME, que facilita el proceso de descubrimiento de materiales.

- El número de regulaciones de IA aumenta drásticamente. En Europa con la conocida Ley de Inteligencia Artificial, centrándonos en EE. UU., el número de regulaciones relacionadas con la IA, ha aumentado significativamente en el último año y en los últimos cinco años. En 2023, hubo 25 regulaciones relacionadas con la IA, frente a solo una en 2016. Solo el año pasado, el número total de regulaciones relacionadas con la IA creció un 56.3%.

- Las personas de todo el mundo son más conscientes del impacto potencial de la IA. Una encuesta de Ipsos muestra que, en el último año, la proporción de quienes piensan que la IA afectará drásticamente sus vidas en los próximos tres a cinco años ha aumentado del 60% al 66%. Además, el 52% expresa nerviosismo hacia los productos y servicios de IA, lo que marca un aumento de 13 puntos porcentuales desde 2022.

¿Se quedarán los LLM sin datos de entrenamiento?

Hasta la actualidad, las principales mejoras de los Grandes Modelos de Lenguaje, LLM por sus siglas en inglés (Large Language Models) podríamos decir que se han conseguido por fuerza bruta. Con esto nos referimos a la ingesta, durante la fase de entrenamiento de los modelos fundacionales, de una cantidad cada vez mayor de datos como principal vector de avance.

Pero la pregunta es,

¿Es esto sostenible en el tiempo? En base a las predicciones de expertos en la materia la respuesta es, de forma resumida, no.

En una investigación de Epoch se han generado proyecciones históricas y de potencia de cálculo para tratar de predecir de forma estimada cuándo los investigadores de IA podrían esperar quedarse sin datos.

Las proyecciones históricas se basan en las tasas de crecimiento observadas en los tamaños de los datos utilizados para entrenar modelos de fundación. Las proyecciones de cálculo ajustan la tasa de crecimiento histórica en función de las proyecciones de disponibilidad de cálculo.

✅ Por ejemplo, los investigadores estiman que los científicos informáticos podrían agotar el stock de datos lingüísticos de alta calidad para 2026, agotar los datos lingüísticos de baja calidad en dos décadas y consumir los datos de imágenes para una horquilla entre finales de la década de 2030 a mediados de la década de 2040.

Para paliar esta limitación en la mejora de los modelos existen dos vías alternativas:

- La generación de datos sintéticos: Donde un sistema de Inteligencia Artificial Generativa crea nuevos datos que luego se utilizan para entrenar otros modelos fundacionales.

- La mejora de los modelos a través de un paradigma que no implique un mayor consumo de datos de entrenamiento sino refinar su arquitectura o capacidades mediante otras vías de mejora.

Existe hoy en día multitud de publicaciones científicas centradas en la generación de datos sintéticos por parte de sistemas de IA Generativa, especialmente relevante en entornos o sectores donde la existencia de datos sea escasa o de difícil acceso por cuestiones de confidencialidad o privacidad,

✅ Pensemos, por ejemplo, en el ámbito de la salud o la educación: la generación de datos sintéticos puede ser una solución eficiente y ética para mejorar los modelos de LLM sin necesidad de utilizar datos reales que puedan comprometer la privacidad o la seguridad de las personas o las organizaciones.

Sin embargo, esta alternativa requiere de un cuidadoso diseño y evaluación para asegurar que los datos creados sean verosímiles, relevantes y diversos, y que no introduzcan sesgos o distorsiones en los modelos que los utilicen.

Colapso del modelo

Imagen generada automáticamente con IA.

Imagen generada automáticamente con IA.

Aparte de la necesidad de avanzar e investigar en mecanismos de generación de datos sintéticos que aseguren un diseño que sea similar a los que se producen naturalmente en un entorno real y sin sesgos, existe un segundo componente o riesgo que se conoce como el fenómeno del colapso del modelo y que pasaremos a explicar con algo más de detalle.

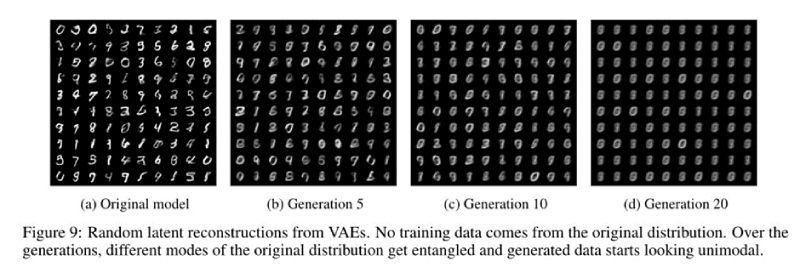

Recientes estudios, como el de un equipo de investigadores británicos y canadienses, detallan que conforme se utilizan más y más datos sintéticos, los modelos entrenados de esta forma pierden la capacidad de recordar la distribución verdadera de los datos y producen una salida con una distribución cada vez más limitada.

En términos estadísticos, a medida que aumenta el número de generaciones sintéticas, las colas de las distribuciones desaparecen y la densidad de generación se desplaza hacia la media. Este patrón significa que, con el tiempo, las generaciones de modelos entrenados predominantemente en datos sintéticos se vuelven menos variados y no están tan ampliamente distribuidos…. como se puede ver en la imágen a continuación:

Imagen extraída del estudio de un equipo de investigadores británicos y canadienses sobre el fenómeno del colapso del modelo.

Imagen extraída del estudio de un equipo de investigadores británicos y canadienses sobre el fenómeno del colapso del modelo.

Conclusiones

- El estudio de Stanford sobre el estado de la IA ofrece una visión multidimensional de la situación actual de la inteligencia artificial, desde la investigación hasta la percepción pública, una interesante lectura que se puede consumir por capítulos, los que al lector le resulten más interesantes para facilitar su digestión.

- El problema de la escasez de datos para los LLM: Los grandes modelos de lenguaje (LLM) se enfrentan al desafío de mejorar su rendimiento sin depender de un consumo creciente de datos, que no es sostenible en el tiempo.

- La generación de datos sintéticos como solución potencial y sus riesgos: Una de las alternativas para superar la limitación de los datos es la generación de datos sintéticos mediante sistemas de IA generativa, que pueden crear datos verosímiles, relevantes y diversos para entrenar otros modelos. Sin embargo, esta opción tiene riesgos como el colapso del modelo o la introducción de sesgos.

Para finalizar, un simil respecto a la problemática del colapso del modelo: la endogamia en colectivos humanos.

Conforme los datos que ingesta un modelo LLM sean provenientes de otro modelo LLM la ganancia marginal sobre los nuevos datos decrece hasta llegar a convertirse en un problema más que un beneficio a nivel de prestaciones.

Todos conocemos los peligros de la endogamia y parece que la Inteligencia Artificial no está exenta de ello desde el punto de vista de los datos.

¿Seremos capaces de generar datos diversos y similares a los que se producirían de forma natural a la velocidad que requiere el avance de la inteligencia artificial?

⚠️ Para recibir alertas de nuestros expertos en Ciberseguridad, suscríbete a nuestro canal en Telegram: https://t.me/cybersecuritypulse

Cloud Híbrida

Cloud Híbrida Ciberseguridad & NaaS

Ciberseguridad & NaaS AI & Data

AI & Data IoT y Conectividad

IoT y Conectividad Business Applications

Business Applications Intelligent Workplace

Intelligent Workplace Consultoría y Servicios Profesionales

Consultoría y Servicios Profesionales Pequeña y Mediana Empresa

Pequeña y Mediana Empresa Sanidad y Social

Sanidad y Social Industria

Industria Retail

Retail Turismo y Ocio

Turismo y Ocio Transporte y Logística

Transporte y Logística Energía y Utilities

Energía y Utilities Banca y Finanzas

Banca y Finanzas Ciudades Inteligentes

Ciudades Inteligentes Sector Público

Sector Público