Riesgos de la IA: una mirada integral a la gestión de incidentes y seguridad de la Inteligencia Artificial

La IA se está convirtiendo en una parte esencial de las operaciones empresariales, con un potencial significativo para transformar diversas industrias. Sin embargo, junto con sus capacidades de eficiencia, agilidad e innovación, la IA también introduce riesgos que las empresas deben tener en cuenta.

Estos riesgos pueden ir desde fallos algorítmicos hasta ciberataques impulsados por la AI, lo que hace que el panorama de posibles incidentes relacionados con la inteligencia artificial sea tan variado como impredecible.

Los riesgos de la IA pueden ir desde fallos algorítmicos hasta ciberataques impulsados por AI, lo que hace que el panorama de posibles incidentes sea tan variado como impredecible.

Clasificación y definiciones de incidentes de IA

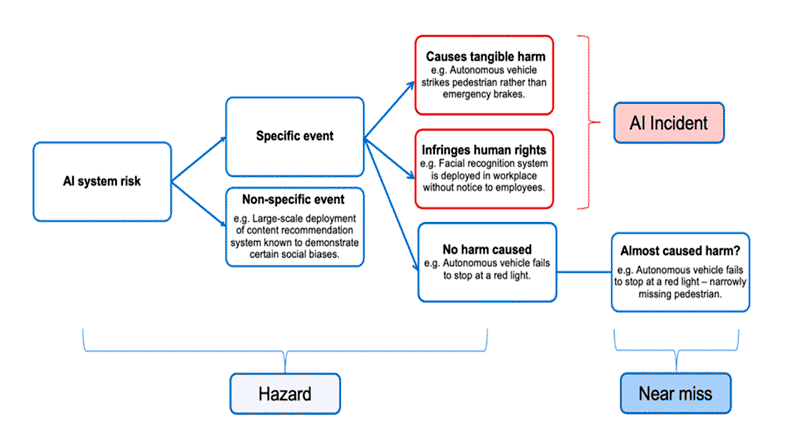

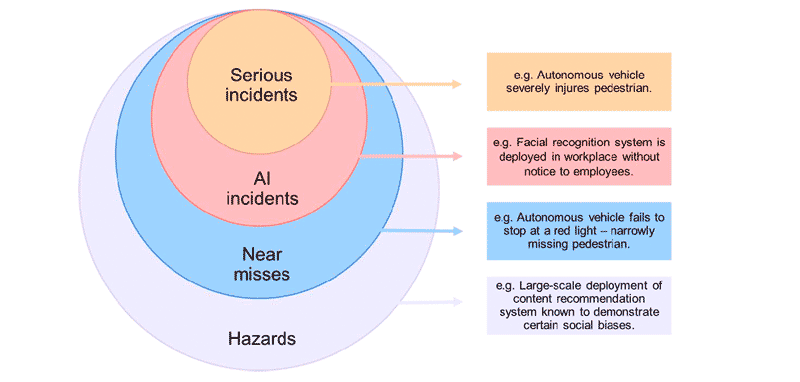

De acuerdo con el OECD, un Incidente de AI es un evento, circunstancia o serie de eventos en los que el desarrollo, uso o mal funcionamiento de un sistema de AI provoca directa o indirectamente daños reales, como lesiones a personas, interrupciones de infraestructuras críticas, violaciones de los derechos humanos, de la legislación laboral o de los derechos de propiedad intelectual, y daños a la propiedad, a las comunidades o al medio ambiente.

Esta definición está asociada con lo establecido en el Reglamento de la Unión Europea de Inteligencia Artificial, atendiendo a Incidente Grave.

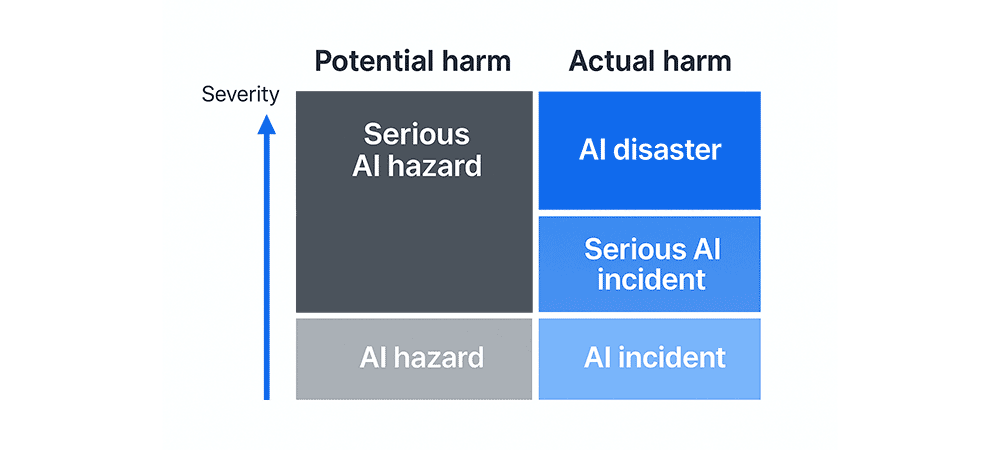

- Por el contrario, un Peligro de AI es un evento en el que un sistema de IA tiene el potencial de causar daño, pero aún no lo ha hecho, lo cual si no se gestiona adecuadamente puede convertirse en un incidente con importantes consecuencias y este también podría atender a ser Peligro Grave de AI.

No obstante, el peligro real se produce cuando un riesgo se materializa en un daño real, como daños a las personas, a la propiedad o al medio ambiente, y se asocia al concepto de incidente.

- Un desastre de IA es un incidente grave de IA que perturba la “disrupción”, el funcionamiento de una comunidad o una sociedad y que puede poner a prueba o superar su capacidad para hacer frente a la situación, utilizando sus propios recursos. Los efectos de una catástrofe de IA pueden ser inmediatos y localizados, o generalizados y duraderos.

- Un cuasi incidente es un evento en el que un sistema de IA estuvo a punto de causar daños, pero éstos se evitaron por una cuestión circunstancial y no debido a medidas de seguridad.

Fuente: OECD. Conceptos de incidentes de AI como niveles.

Fuente: OECD. Conceptos de incidentes de AI como niveles.

Para mayor comprensión, participé en pruebas controladas de un proyecto de significativo impacto global sobre la aplicación de la IA en el diagnóstico sanitario o clínico de pacientes.

Un incidente de AI es un evento en el que el mal funcionamiento de un sistema de IA provoca daños reales, como interrupciones de infraestructuras críticas o violaciones de derechos.

Un ejemplo en el ámbito sanitario

Un hospital de renombre internacional en avances científicos y tecnológicos para la salud buscaba integrar un sistema de diagnóstico basado en IA para asistir a los médicos en la detección proactiva de enfermedades mediante el análisis de imágenes médicas.

Este sistema se entrenó con grandes conjuntos de datos para identificar condiciones clínicas y patológicas como cáncer, fracturas e infecciones. Sin embargo, durante todo este proceso, procuramos evaluar constantemente los riesgos y posibles fallos relacionados con incidentes asociados a la IA.

Tras mi participación en el proyecto, tuve la oportunidad de realizar una investigación exhaustiva debido a la ocurrencia de un Incidente Grave. Este incidente se debió a un diagnóstico erróneo que resultó en un pronóstico incorrecto de bajo riesgo para un paciente que, en realidad, presentaba una patología agresiva.

La implementación de sistemas de IA en el sector salud debe ser acompañada por rigurosas medidas de seguridad y protocolos de gestión de incidentes para garantizar la protección de los pacientes y la integridad de las operaciones sanitarias.

Esta situación podría haber provocado un retraso crítico en su tratamiento, lo cual podría empeorar significativamente el estado del paciente y causar daños irreversibles. Al evaluar el escenario, siempre consideramos los resultados y procesos rutinarios del diagnóstico del paciente sin la intervención de este tipo de tecnología.

Como seguimiento al incidente anterior, identificamos un Incidente de IA. Al analizar la causa raíz, descubrimos que una actualización de software introdujo un error en el algoritmo, aumentando los falsos negativos en la detección de la patología. Esto podría llevar a que pacientes en fases iniciales sean dados de alta sin pruebas adicionales, lo que retrasaría el tratamiento necesario.

Ya por último, al ver Near Misses donde el personal médico revisaba los resultados generados por la AI y se dio cuenta de que el sistema marcaba incorrectamente patologías benignas como malignas en el escáner de los pacientes. Aquí vimos que fue muy importante la detección por parte del personal médico del error, antes de la administración del tratamiento lo cual evita un procedimiento innecesario e invasivo.

■ Además y en paralelo, descubrimos mediante Hazards que el modelo de AI tenía sesgos en sus datos de entrenamiento, demostrando un rendimiento significativamente mejor en paciente de ciertos grupos patológicos mientras tiene problemas con otros. Valoramos la gran secuela de los diagnostico erróneos, lo que podría exacerbar en problemas éticos y normativos.

Conclusión

La AI pone relieve una intersección crítica entre la Ciberseguridad, la privacidad y la protección de datos: la gestión de incidentes de AI requiere no solo vigilancia técnica, sino también una gobernanza integral del riesgo.

Por tanto, a medida que los sistemas dependen cada vez más de la IA, es fundamental implementar una supervisión exhaustiva, protocolos seguros, estrategias y prácticas de control del software, así como marcos de respuesta a incidentes para prevenir, detectar y mitigar los riesgos.

En el ámbito de la IA, salvaguardar los resultados de cualquier sistema depende de asegurar tanto la tecnología como los procesos que la regulan.

En última instancia, la gestión de los riesgos de la IA no consiste sólo en prevenir, sino en fomentar una cultura de seguridad, responsabilidad y mejora continua que permita a la IA prosperar al tiempo que minimiza los daños. Sólo abordando estos riesgos podremos construir un futuro en el que la IA sirva como una poderosa herramienta para el progreso, la innovación y el beneficio social.

Cloud Híbrida

Cloud Híbrida Ciberseguridad & NaaS

Ciberseguridad & NaaS AI & Data

AI & Data IoT y Conectividad

IoT y Conectividad Business Applications

Business Applications Intelligent Workplace

Intelligent Workplace Consultoría y Servicios Profesionales

Consultoría y Servicios Profesionales Pequeña y Mediana Empresa

Pequeña y Mediana Empresa Sanidad y Social

Sanidad y Social Industria

Industria Retail

Retail Turismo y Ocio

Turismo y Ocio Transporte y Logística

Transporte y Logística Energía y Utilities

Energía y Utilities Banca y Finanzas

Banca y Finanzas Ciudades Inteligentes

Ciudades Inteligentes Sector Público

Sector Público