.jpg)

AI & Data

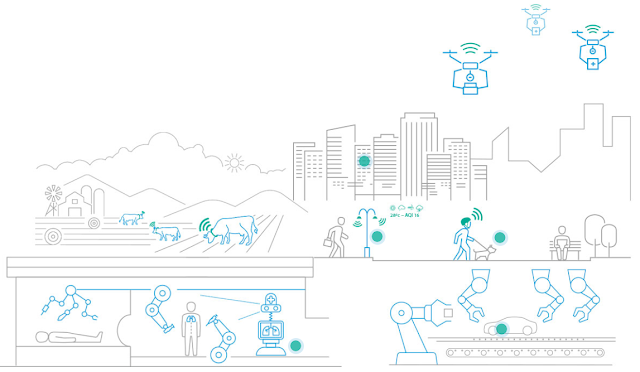

El potencial de la Inteligencia Artificial de las Cosas para transformar todo tipo de sectores

El concepto AI of Things (Inteligencia Artificial de las Cosas) que engloba las tecnologías digitales IoT, conectividad, Big Data e Inteligencia Artificial, entre otras, demuestra cada vez más su potencial para transformar todo tipo de sectores: agroalimentario, logístico, turístico, industrial… Los objetos físicos, provistos de sensores IoT y conectividad, junto con el análisis de grandes volúmenes de datos y la aplicación del aprendizaje automático y la Inteligencia Artificial permiten extraer conocimientos valiosos. También reconocer patrones, automatizar tareas, optimizar procesos y tomar decisiones basadas en datos. Esta capacidad multiplica el valor de las cosas conectadas y desbloquea nuevas oportunidades de negocio. En este post hemos reunido una selección de contenidos que exploran algunas de las tecnologías y aplicaciones de AI of Things que desarrollamos, utilizamos e implementamos en Telefónica Tech. Conectividad e IoT IA & Data Automatización, Conectividad e Inteligencia Aumentada al servicio de una reindustrialización competitiva, disruptiva y sostenible 18 de mayo de 2023 Conectividad e IoT Satélites con tecnología 5G para dar cobertura IoT en todo el planeta 10 de abril de 2023 AI of Things Estadios de fútbol inteligentes: el mayor espectáculo del mundo, aún más espectacular 25 de mayo de 2022 AI of Things Alumbrado público inteligente: oportunidades de negocio y beneficios 25 de enero de 2023 AI of Things Visualización de datos para una gestión óptima de flotas de vehículos 13 de diciembre de 2022 AI of Things Nuevas oportunidades empresariales con IoT (Internet de las Cosas) 29 de noviembre de 2022 AI of Things Cómo la digitalización permite conocer y atender con precisión las necesidades de un cultivo ecológico de cerezas 3 de octubre de 2022 AI of Things Tiendas phygital: qué son y cómo están cambiando la experiencia de compra 19 de julio de 2023 Conectividad e IoT IA & Data Digitalización industrial: revelamos las claves en Advanced Factories 2023 20 de abril de 2023 Conectividad e IoT IA & Data La evolución definitiva hacia la digitalización de la industria 22 de septiembre de 2022 AI of Things Entrega en 10 minutos: cómo la Inteligencia Artificial optimiza las rutas de reparto 26 de septiembre de 2022 AI of Things Las redes LPWA y 5G habilitan nuevas soluciones IoT 30 de noviembre de 2022 AI of Things Soluciones OEM para el coche conectado 15 de noviembre de 2022 AI & Data Edge AI: Inteligencia Artificial fuera de la nube 13 de abril de 2023 AI of Things Mantenimiento preventivo en sensores: anticipación de fallos en sensores, predicción de cambio de baterías 17 de octubre de 2022 AI of Things Soluciones de Big Data e Inteligencia Artificial para la industria del turismo 27 de septiembre de 2022 IA & Data AI of Things para una gestión eficiente y sostenible del agua 21 de agosto de 2023 IA & Data Ingredientes para las Ciudades Inteligentes del presente 16 de noviembre de 2023 Conectividad e IoT 5G: cuatro casos de uso reales y prácticos 22 de marzo de 2023 AI of Things How can we bring Internet of Things to the rural world? October 13, 2022 AI of Things Pódcast Latencia Cero: La inesperada relación entre Smart Cities y Agricultura Inteligente 5 de octubre de 2022 Imagen: rawpixel.com en Freepik.

26 de julio de 2023

AI & Data

Wifi 7: te damos las claves de la nueva generación

La conectividad wifi 7, la nueva versión del estándar de conectividad, va a llevar la velocidad de Internet a un nivel completamente nuevo. En comparación con su predecesor, wifi 6, esta nueva generación contempla mejoras en aspectos como la estabilidad, la eficiencia y la capacidad de respuesta. Pero, ¿qué efectos tendrá esto en la experiencia general del usuario? Hoy conocerás de cerca las novedades que trae la red wifi en su séptima versión (wifi 7) y los cambios que esto le depara al futuro de la conectividad. Un tráfico de datos más fluido con wifi 7 El nuevo wifi 7 permitirá una mejor experiencia de conexión, especialmente en contextos en los que es indispensable contar con una latencia óptima para manejar grandes cantidades de datos, como el streaming en 4K y 8K. A su vez, la llegada de wifi 7 es una buena noticia para los usuarios que requieren una conexión estable de cara al intercambio de datos en tiempo real, como las compañías con un alto volumen de dispositivos IoT (Internet de las Cosas). Esto es posible gracias a que el ancho de banda se duplica, pasando de 160 MHz a los 320 MHz. Por otro lado, con la duplicación MIMO (enlaces de entradas y salidas múltiples), se hace más eficiente la transmisión inalámbrica y se extiende la capacidad de acceso a flujos de servicios. Esto significa que el usuario podrá ejecutar múltiples aplicaciones al mismo tiempo con una baja incidencia de interrupción. La explicación está en una mayor capacidad de respuesta simultánea en bandas altas, incluso en áreas congestionadas. Un router de sexta generación, por ejemplo, puede conectarse a una sola banda de 2,4 GHz, 5 GHz y 6 GHz. En cambio, un router de la nueva generación admite múltiples bandas dentro de este espectro. También se espera una mejora notable en la conexión de múltiples dispositivos dentro de la misma red wifi, con lo cual habría grandes beneficios para las empresas que dependen de la interoperabilidad de equipos conectados a Internet (como los sistemas de vigilancia). Esta capacidad de conectar más dispositivos y mantener un tráfico de datos fluido también beneficia la conectividad en el hogar, mejorando la experiencia en videojuegos, streaming, manejo de plataformas online (teletrabajo), etc. Se estima que, en un hogar promedio, el nuevo wifi permitirá mantener entre 6 y 8 dispositivos conectados al mismo tiempo sin afectar la estabilidad o velocidad de transmisión. AI OF THINGS Las redes LPWA y 5G habilitan nuevas soluciones IoT 30 de noviembre de 2022 La nueva generación wifi 7 podrá alcanzar velocidades de más de 30 gigabits por segundo A grandes rasgos, se habla de una velocidad promedio cuatro veces superior a wifi 6, lo que abrirá un mundo de posibilidades a la retransmisión de contenido en 8K, los juegos multijugador en línea, las aplicaciones de realidad aumentada y otros servicios en la nube. Aunque el consenso general es que wifi 7 alcance velocidades de hasta 30 Gbps, Intel afirma que el nuevo estándar puede llegar a los 48 Gbps. Wifi 7 también será compatible con los routers wifi existentes, por lo que no hace falta preocuparse por sustituir los equipos actuales cuando se masifique el nuevo estándar. No obstante, en el futuro es posible que sea inevitable hacer la transición a un router de última generación para aumentar la cobertura wifiy mejorar la seguridad de las redes, tanto empresariales como domésticas. Se espera que la nueva generación wifi llegue al mercado a mediados de 2024, aunque el próximo año ya podríamos ver sus primeras aplicaciones. El nuevo estándar wifi 7 será más rápido que el actual, y podrá alimentar a más dispositivos simultáneamente, por lo que será clave para mejorar procesos industriales, flujos de trabajo y, desde luego, la experiencia de navegación.

7 de diciembre de 2022

AI & Data

Todo lo que debes saber sobre deep learning

Gracias al enorme desarrollo tecnológico de los últimos años, hoy existen soluciones de gran impacto para el entorno empresarial. Un claro ejemplo de ello es el deep learning, un concepto que cada vez adquiere mayor relevancia en las estrategias digitales gracias a las posibilidades que otorga. ¿Qué es deep learning? Se trata de un campo de la inteligencia artificial (IA) en el que algoritmos imitan la manera en que el cerebro humano procesa datos. Esto ocurre gracias a redes neuronales artificiales que buscan emular la manera en que el cerebro humano opera, para identificar patrones y generar predicciones a partir de grandes volúmenes de datos. Todo, sin la necesidad de supervisión, por lo que se trata de un tipo de machine learning, pero mucho más avanzado que el tradicional. Dado el potencial de esta tecnología para extraer información de valor -por ejemplo, para identificar oportunidades de negocio o mejorar procesos-, diversas industrias están invirtiendo en desarrollos relacionados con el deep learning. Se estima que este mercado pasará de 6.850 millones en 2020 a 179.960 millones en 2030, dando cuenta de la importancia que tiene para las estrategias empresariales. ¿Qué papel cumplen las redes neuronales artificiales? Como vimos anteriormente, el deep learning busca imitar el funcionamiento del cerebro humano, utilizando estructuras lógicas que se asemejan al sistema nervioso, con un sistema de “neuronas artificiales” capaz de percibir diferentes características de los objetos analizados. Para procesar la data, estas redes neuronales se organizan en capas que integran múltiples unidades de procesamiento interconectadas, las cuales trabajan simultáneamente, emulando la forma en que el cerebro procesa la información. Estas capas están organizadas de la siguiente manera: Capa de entrada: representa los campos de entrada para los datos que ingresarán al sistema. Capas ocultas: pueden ser varias. Simbolizan el puente entre la entrada y salida de la red neuronal. Los datos pasarán por todas las unidades de procesamiento que integran estas capas. Capa de salida: representa el destino final de los datos y el lugar en donde se generará el resultado del modelo. Mediante continuo entrenamiento, la red neuronal artificial irá mejorando el desempeño de sus predicciones al comparar las respuestas con los resultados esperados. Estas redes neuronales artificiales representan algoritmos capaces de reconocer patrones y distinguir, por ejemplo, imágenes o sonidos específicos en cosa de segundos. Y aunque inicialmente su capacidad predictiva será muy limitada, tras muchas repeticiones el algoritmo será capaz de replicar con exactitud el resultado conocido en función de los datos utilizados, adquiriendo mayor autonomía y precisión. Usos del deep learning Habiendo aclarado qué es deep learning y cómo funciona, veamos algunos de sus principales usos en la actualidad son: Reconocimiento de voz y traducción automática en plataformas como YouTube y Skype, o en asistentes digitales como Siri y Alexa. Reconocimiento facial en Google Fotos. Métodos antifraudes que se ocupan de analizar los detalles de las transacciones (hora en que son ejecutadas, destinatarios, montos, entre otra información de relevancia) para detectar acciones sospechosas que puedan afectar a las cuentas bancarias. En el sector agrícola, se puede apreciar en sistemas de riego inteligentes que consideran factores como el nivel de agua en el suelo o de humedad en el aire. Beneficios del aprendizaje profundo Dadas las aplicaciones que tiene, el deep learning se posiciona como una de las tecnologías de mayor impacto para el entorno empresarial, generando beneficios como: Automatización de procesos: la capacidad de trabajo autónomo del aprendizaje profundo permite que diferentes procesos se puedan automatizar, logrando mayor eficiencia y calidad. Capacidad para trabajar con datos no estructurados: el deep learning logra identificar patrones y realizar predicciones de gran manera aun cuando los datos no se encuentren organizados. Rentabilidad a largo plazo: el deep learning puede ayudar a las organizaciones a detectar oportunidades de negocio o mejoras en diversas áreas. Sistema escalable: esta tecnología trabaja sin problemas con grandes volúmenes de datos, por lo que puede adaptarse fácilmente a mayores niveles de información que vayan en sintonía con el crecimiento de una organización. El deep learning está marcando la pauta en la transformación digital de las organizaciones, impactando en áreas como flujos de trabajo, servicio al cliente y optimización de procesos. Dar el salto hacia esta tecnología es determinante para potenciar la competitividad y, con ello, fortalecer el posicionamiento de las empresas en un mercado cada vez más digitalizado.

6 de septiembre de 2022

Cloud

AI & Data

Digital twin: ¿qué es y para qué sirve?

Una de las claves del éxito empresarial es tener la capacidad de anticipar el impacto que eventuales cambios pueden tener en un producto o servicio. Eso es, básicamente, lo que permite un digital twin, un concepto de suma relevancia para organizaciones tanto privadas como públicas. Gracias a los digital twins, las empresas pueden mejorar el desempeño de productos, servicios o estrategias determinadas, anticipando resultados gracias a datos actualizados y precisos. Gemelos digitales: el espejo del mundo físico En concreto, los digital twins o gemelos digitales son representaciones virtuales que reflejan el comportamiento de un producto o servicio físico. Usualmente, este modelo se nutre de datos provistos por sensores IoT conectados a los objetos físicos, información que alimenta el modelo virtual creado para replicar y simular su conducta. Todo, con el objetivo de mejorar su rendimiento y anticipar el impacto de posibles cambios. La información obtenida es procesada a través de tecnologías como el machine learning para simular el comportamiento que presentaría un objeto al integrar nuevas funcionalidades o sufrir modificaciones en su diseño, identificando eventuales virtudes y defectos para realizar los ajustes necesarios antes de implementarse en la realidad. Los digital twins están siendo utilizados en diferentes áreas dadas las posibilidades que otorgan: Por ejemplo, en el sector salud, hoy permiten a los profesionales diseñar una representación virtual de un paciente u órgano en concreto, para estudiar los impactos de determinados procedimientos. En la industria automotriz también están marcando la pauta, siendo de gran ayuda en el diseño y construcción de diversos modelos, tal como lo hace Ford. Dado su impacto en las cadenas de producción, se estima que el mercado de los gemelos digitales presentará una tasa de crecimiento anual compuesta (CAGR) de 38% entre 2019 y 2025, año en que alcanzaría los US$ 35.8 billones, de acuerdo con Deloitte. Principales características de los gemelos digitales Para entender mejor cómo funcionan los digital twins, revisemos algunas de sus principales características: Mientras más información se recopile del producto, servicio o proceso en estudio (ciclo de vida, especificaciones de diseño, detalles de funcionamiento, etc.), el modelo de simulación será capaz de entregar predicciones más confiables. Todo, gracias a la inteligencia artificial (IA) y machine learning. Tiene un carácter predictivo, siendo ideal para anticipar fallas y, así, realizar las correcciones pertinentes para que no ocurran en la realidad. Su funcionamiento incorpora el uso de diferentes tecnologías para analizar y simular el comportamiento de los objetos, como el Internet de las Cosas (IoT), cloud computing y machine learning. Es importante aclarar que un gemelo digital no es lo mismo que un programa de simulación: mientras este último estudia elementos en particular, un digital twin opera a mayor escala -como cadenas logísticas o procesos industriales- gracias a que genera todo un entorno virtual. Ventajas de usar un gemelo digital Entre los principales beneficios que se pueden obtener del uso de los gemelos digitales, vale la pena destacar los siguientes: Mayor rendimiento. El monitoreo y simulación virtual de un proceso o sistema permite tomar decisiones y ejecutar acciones que impliquen mayor eficiencia y mejoras en su rendimiento. Mejor I+D. Utilizar gemelos digitales facilita un diseño de productos y procesos más eficaz, a raíz de la gran recolección y procesamiento de datos por medio de tecnologías como cloud computing, IoT, Big Data e IA. Anticipar posibles fallas. La capacidad predictiva de los digital twins permite reducir riesgos en el plano real. Mejor procesamiento de los productos y materias. Gracias a estas representaciones virtuales, es posible optimizar el ciclo de vida de los elementos, pudiendo ampliarlo o, incluso, potenciar las acciones de reciclaje al identificar elementos que pueden reutilizarse. AI OF THINGS La digitalización de la tecnología predictiva: gemelos digitales 10 de enero de 2022 Principales industrias que usan los digital twins De acuerdo con el Foro Económico Mundial, se espera que para el año 2025 la inversión en digital twins se potencie en áreas como: Manufactura: USD$ 6,7 mil millones. Automotriz: USD$ 5,1 mil millones. Aviación: USD$ 5,1 mil millones. Energía y servicios: USD$ 3,8 mil millones. Salud: USD$ 3,8 mil millones. Logística y comercio minorista: USD$ 2,3 mil millones. El futuro de los digital twins Las posibilidades que otorgan los digital twins son tan amplias como las necesidades de las organizaciones, y se incrementan conforme evoluciona la tecnología, especialmente en lo que a conectividad e inteligencia artificial respecta. El proyecto Hexa-X es un claro ejemplo de lo anterior, del cual forman parte grandes empresas del sector de la comunicación -como Telefónica- y reconocidos centros de investigación europeos. Esta iniciativa busca dar una visión de los futuros sistemas 6G al conectar el mundo físico con el virtual, con lo que se espera -entre otras cosas- replicar digitalmente ciudades enteras para estudiar su comportamiento. En la actualidad, los digital twins tiene un rol estratégico en los procesos organizacionales al permitir simular y predecir el comportamiento de productos, servicios o procesos físicos, siendo de gran valor para apoyar la toma de decisiones respecto a las innovaciones que están cambiando el mundo.

11 de agosto de 2022

AI & Data

Descubre lo que tienes que saber sobre 6G

Promete aterrizar en 2030 y tener pruebas piloto en 2026. Pero sobre todo, promete múltiples mejoras en términos de conectividad. Nos referimos al 6G, la sexta generación de redes móviles que ya genera expectativas dadas sus características. El nuevo estándar ofrecerá una latencia mínima, mejorando la experiencia en las transmisiones en vivo. Además, esto es clave para potenciar campos como los de la realidad extendida y la inteligencia artificial (IA), optimizando el rendimiento de los sistemas gracias a un tráfico de datos más rápido y fluido En este artículo, exploraremos las principales características y beneficios de la próxima era en conectividad móvil, y sus principales diferencias con el actual estándar. 6G: así es el futuro móvil La sexta generación de redes móviles promete mejoras en cuanto a la tasa de transmisión. Pero eso no es todo: la latencia también se verá reducida (0,1 milisegundos), lo que permitirá que, por ejemplo, las transmisiones estarán cerca de ser en tiempo real. Promete significativas ventajas para diversos sectores industriales, y potenciando el desarrollo de tecnologías como la realidad extendida, dando paso a experiencias realmente inmersivas. Se estima que el 6G puede crear experiencias que hasta hoy solo vimos en ciencia ficción, haciendo viables las interfaces sensoriales. Por ejemplo, a través de lentes inteligentes o de contacto, podremos sentir y ver como si estuviéramos en la realidad. De esta manera, el 6G permitirá mejorar la experiencia en industrias como la salud, potenciando la telemedicina gracias a la realidad extendida. Esta mayor velocidad en la transmisión de datos y la prácticamente nula latencia hará posible una mejor experiencia audiovisual y en lo que a videojuegos respecta, entre otras aplicaciones ligadas a la vida cotidiana. Así, gracias a la próxima generación en conectividad móvil será posible reforzar o mejorar procesos como: Detección de amenazas Reconocimiento facial Medición de la calidad del aire Automatización de tareas. ¿En qué se diferencia de 5G? La principal diferencia radica en que la sexta generación de conectividad móvil multiplicará hasta por 10 las tasas de transmisión de datos. Y aunque el 5G llegó para mejorar en temas como la velocidad y latencia, el 6G promete grandes mejoras en ambos aspectos: Latencia: pasará de 1 ms a 0,1 ms. Velocidad: el aumento será considerable, pasando de los 20 Gbps actuales 1 Tbps. Se espera que 6G sea 100 veces más rápido que 5G. Además, como tiene una mayor capacidad, permite que se conecten más dispositivos a un mismo router, algo que impactará tanto la experiencia en el hogar como en entornos productivos. Lo anterior se apreciará en el fortalecimiento del ecosistema IoT, facilitando el intercambio de datos prácticamente en tiempo real, agilizando las operaciones y, con ello, la toma de decisiones. Los beneficios de esta nueva generación también se relacionan con el cuidado del medioambiente, ya que esta nueva generación de conectividad móvil tiene un menor consumo de energía. Esto, pues mientras el 5G se enfocó en rendimiento, el 6G apunta a la sustentabilidad. Hacia una nueva era en conectividad móvil Se estima que en España existen más de 54 millones de conexiones móviles. Considerando que la población es de poco más de 47 millones de personas, es evidente el impacto positivo que traerá el 6G cuando aterrice en nuestro país. Por un lado, millones de personas podrán disfrutar de una conexión de alta velocidad y rendimiento, mejorando experiencias cotidianas como disfrutar de contenido online o trabajar desde casa sin problemas de navegación. Por otro, las empresas podrán potenciar sus entornos digitales, impulsando la automatización y el fortalecimiento de nuevos flujos de trabajo. Y aunque todavía nos estamos acostumbrando a la llegada del 5G, ya es posible anticipar las ventajas que se desprenden de la próxima generación de conectividad móvil.

28 de junio de 2022

AI & Data

Conoce la diferencia entre machine learning y deep learning

Durante los últimos años, la inteligencia artificial (IA) ha generado una revolución en el entorno empresarial, dando paso a soluciones enfocadas en la automatización y agilidad en los procesos. Ahora bien, ¿cuál es la diferencia entre machine learning y deep learning, dos de los principales conceptos ligados a la IA? Sin embargo, para diferenciar claramente machine learning vs deep learning, lo primero es entender en qué consisten cada una de estas ramas de la IA. ¿Qué es Machine Learning? El aprendizaje automático en la capacidad de las máquinas o equipos computaciones de aprender por sí solos a partir del análisis de datos e identificación de patrones, lo que les permite realizar predicciones de manera autónoma, es decir, sin la necesidad de la supervisión humana. Esta tecnología -parte de la IA- está presente en diversas áreas, por lo que sus aplicaciones son bastante amplias. Por ejemplo, es una herramienta de gran utilidad en el mundo del marketing, facilitando el análisis del comportamiento y necesidades de clientes para potenciar las ventas y mejorar la experiencia del cliente. Y también está presente en tu día a día, por ejemplo, cuando tu plataforma de streaming te recomienda contenidos en particular; o cuando te aparecen sugerencias de amistad en redes sociales. Es tal el impacto de esta tecnología en el contexto global, que se estima que el mercado del machine learning pasará de USD$ 8.000 millones en 2021 a USD$ 117.000 millones para 2027. ¿En qué consiste Deep Learning? Se trata de un subconjunto de machine learning que busca replicar la forma en que el cerebro humano procesa la información. Esto, mediante el uso de redes neuronales artificiales que se organizan en diferentes capas y procesan los datos, permitiendo realizar predicciones. Al igual que en el machine learning, los algoritmos que componen la red neuronal de un sistema de aprendizaje profundo pasan por un entrenamiento con grandes volúmenes de datos, lo que les permite mejorar su capacidad predictiva hasta alcanzar altos niveles de precisión. Desde luego, el aprendizaje profundo está presente en diversas industrias. Por ejemplo, el sector automotriz destina cerca de USD$ 32.000 millones en la materia para optimizar sus productos y flujos de trabajo. En lo que a salud respecta, gracias al deep learning es posible hacer diagnósticos médicos con mayor precisión y antelación, algo de gran ayuda en enfermedades de gran complejidad, como el cáncer. Dada su relevancia para en entorno empresarial, se estima que el mercado del deep learning superará los USD$ 44.000 millones para 2027. Machine Learning vs Deep Learning: ¿en qué se diferencian? Al comprender cómo funcionan estos dos campos de la inteligencia artificial (machine learning y deep learning), es posible identificar sus principales diferencias: 1. Intervención humana Si bien ambas disciplinas logran llegar a trabajar de forma autónoma, lo cierto es que el machine learning requiere de una mayor intervención humana para lograr los resultados esperados; mientras que el deep learning puede lograr la autonomía. 2. Nivel de complejidad Otra diferencia entre machine learning y deep learning se vincula con la complejidad de sus algoritmos y los recursos que requieren para funcionar. Por un lado, los sistemas de aprendizaje automático resultan más simples y pueden llegar a funcionar en equipos convencionales, a diferencia del aprendizaje profundo que requiere de software más robustos y potentes para procesar sus intrincados modelos de redes neuronales. 3. Tiempo y precisión El tiempo necesario para que una máquina logre trabajar con autonomía en la identificación de patrones y la realización de predicciones es menor en el machine learning. Sin embargo, sus resultados no llegan a tener el grado de precisión que ofrece el deep learning. 4. Características de los datos Una gran diferencia entre machine learning y deep learning es la organización de la data: Para que el aprendizaje automático otorgue su máximo potencial requiere que los datos hayan sido previamente estructurados. Por otro lado, el aprendizaje profundo puede trabajar sin inconvenientes con grandes volúmenes de datos no estructurados, siendo de gran valor cuando se trata de identificar tendencias o patrones. Tecnologías como la inteligencia artificial, machine learning o deep learning son una muestra evidente de la transformación digital que experimentan las sociedades actualmente. Si bien aún es complejo visualizar los límites de estos campos tecnológicos, lo que sí está claro es que vienen a mejorar los sistemas y herramientas que se utilizan en el presente para ir en beneficio de las personas y organizaciones.

8 de junio de 2022

AI & Data

¿Qué es y cómo funciona Machine Learning?

El machine learning es, sin duda, uno de los conceptos que está marcando pauta en lo que a desarrollo tecnológico respecta, siendo determinante para potenciar la automatización de procesos y mejorar los flujos de trabajo. De hecho, se espera que este mercado presente un CAGR (tasa de crecimiento anual compuesta) de un 38,8% entre 2022 y 2029, un dato que permite dimensionar la importancia de esta tecnología para el desarrollo empresarial. Machine Learning: potenciando la inteligencia de sistemas informáticos En otras palabras, machine learning o aprendizaje automático es una rama de la inteligencia artificial (IA) entendida como la capacidad que tiene un programa de reconocer patrones en grandes volúmenes de datos, lo que les permite realizar predicciones. De esta forma, mediante el procesamiento de la información, las máquinas pueden llegar a trabajar de forma autónoma al aprender por sí mismas, sin la necesidad de ser programadas previamente. Esto permite al programa aprender, identificar patrones y generar predicciones, gracias al entrenamiento del algoritmo a partir de una base de datos para analizar. El objetivo es que, al repetir este proceso, cada vez los algoritmos logren entregar resultados más confiables y precisos. ¿Para qué sirve Machine Learning? El también llamado aprendizaje automático ha pasado a formar parte del día a día de miles de personas y organizaciones. De hecho, puede que no lo notes, pero el machine learning está presente en instancia como: Recibir recomendaciones en plataformas como Spotify, Netflix o YouTube, sobre listas de reproducción o contenido que pueda ser del agrado de una persona en particular. Ver anuncios en redes sociales como Instagram o Facebook sobre productos o servicios que te sean de interés. Al utilizar aplicaciones como Waze para trasladarte en vehículo a algún destino en específico. Obtener mejores resultados en Google. Optimización de la gestión documental. Cuando recibes correos, Gmail filtra aquellos que representan spam. Tipos de aprendizaje automático Se pueden identificar diferentes tipos de machine learning en función de cómo aprenden las máquinas a reconocer patrones y realizar predicciones. A continuación, se mencionan los más destacados: 1. Aprendizaje supervisado Los algoritmos integran datos etiquetados que contienen información previa sobre qué es lo que se quiere que aprenda un equipo para tomar decisiones y hacer predicciones. Por ejemplo, un negocio de paraguas puede predecir su nivel de venta al haber registrado en los últimos años las ventas de cada día y el contexto en el que se realizaban (mes, temperatura, clima, entre otros). 2. Aprendizaje no supervisado La base de datos para analizar ha sido ordenada en torno a etiquetas, por lo que los algoritmos buscan reconocer patrones en esta data desorganizada para obtener nuevos conocimientos y agrupar registros por afinidad. En particular, este tipo de aprendizaje cobra mucho valor para las empresas cuando se planean campañas de marketing al servir como identificador de nichos de mercado. 3. Aprendizaje por refuerzo Bajo este método, el algoritmo aprende por experiencia en base a ejercicios de prueba y error, recompensando los aciertos y castigando los errores. El objetivo es que, al adquirir mayor práctica, los algoritmos logren predecir de forma adecuada los eventos en estudio. Principales beneficios del aprendizaje automático Son diversas las ventajas que entrega este campo de la inteligencia artificial a nivel organizacional, entre las que destacan: Predecir tendencias en el mercado a partir del comportamiento de los consumidores, optimizando estrategias de marketing o determinando el nivel de producción que demanda un bien en una temporada específica. Optimizar los procesos de segmentación de público objetivo y anuncios, al identificar los hábitos de consumo de las personas y sus preferencias. Reducir el alto número de vulneraciones de seguridad, identificando las anomalías que suelen presentarse ante ataques, por ejemplo, de malware. Esto es de suma importancia en la actualidad, considerando que durante 2021 hubo 40.000 ciberataques cada día en España. Mejorar la relación con el cliente al brindar una atención más cercana y personalizada. Un gran ejemplo de esto lo constituyen los chatbots, herramientas para automatizar la interacción con clientes que han logrado un enorme desarrollo en la actualidad. Incentivar la apuesta por la innovación y búsqueda de soluciones tecnológicas más eficaces para resolver fallas e inconvenientes en las organizaciones. El aprendizaje automático ofrece múltiples beneficios para compañías de diversos sectores, como salud, alimentación, educación, transporte y publicidad, entre otras. Por eso, se espera que siga creciendo su implementación en el ecosistema empresarial. Además, se trata de una tecnología clave para potenciar la productividad y mejorar los flujos de trabajo a nivel general, facilitando el crecimiento de las organizaciones en medio de un entorno cada vez más digital y dinámico, siendo determinante para anticiparse a las variables del mercado.

2 de junio de 2022

AI & Data

NFT y su relación con Blockchain

Los NFT se han vuelto cada vez más relevantes en el entorno digital, abarcando sectores como arte, la moda, el metaverso y los play-to-earn (juegos en los que las recompensas son activos digitales). Este escenario no sería posible sin el desarrollo de las tecnologías Blockchain, que constituyen la base de todo el entorno de las finanzas descentralizadas y de criptomonedas como Bitcoin y Ethereum. Se trata de un conjunto de tecnologías que están replanteando la forma en que desarrollan diversos procesos, desde finanzas hasta medicina, y que actualmente cobija grandes proyectos a nivel global en múltiples áreas. ¿Qué es Blockchain? Blockchain, o cadena de bloques, es una tecnología computacional que permite llevar un registro descentralizado de las operaciones digitales. Es algo así como un libro de registros público en el que queda asentado cada movimiento, sin posibilidad de alterar el historial. Su creación se le atribuye a Satoshi Nakamoto, una persona o colectivo responsable del Bitcoin y de la tecnología que lo sustenta, es decir, blockchain. Hablamos de una base de datos descentralizada, sustentada en una red de nodos que representan puntos de conexión a la red. La información es estructurada en bloques encriptados que deben validarse antes de ser incluidos en la cadena de bloques. Algunas de sus particularidades son: Los bloques validados siguen una secuencia histórica. La red no es controlada por individuos o instituciones, por el contrario, es descentralizada Una vez añadidos a la cadena de bloques, los registros no pueden ser modificados. Lo anterior se traduce en una estructura que otorga total transparencia a las operaciones, con plena independencia. Esto ha ampliado las aplicaciones del blockchain, las cuales van desde finanzas hasta registros de identidad descentralizados, entre muchas otras. Ethereum: la base de los NFT A partir del blockchain surge Ethereum, una plataforma de código abierto que permite la creación de smart contracts o contratos inteligentes, piezas de código creadas en lenguaje de programación en donde se expresarían instrucciones específicas que serían ejecutados por la máquina virtual de Ethereum. Como vimos en un artículo anterior, Ethereum es la plataforma en la que se sustentan los tokens no fungibles (NFT), activos digitales únicos e irremplazables que operan en blockchain, lo que les otorga un valor único. Lo anterior ha permitido a empresas monetizar sus operaciones digitales, así como abrir un mundo de oportunidades para artistas, ya que los NFTs pueden ser obras de arte digital, sonidos, textos o cualquier archivo respaldado por un certificado digital generado en blockchain. NFT: elementos únicos e irremplazables Un NFT solo puede ser alojado en una dirección de la red, no podrá ser duplicado y solo podrá ser transferido usando una llave privada. Puesto que las transacciones quedan registradas en la cadena de bloques, podemos acceder al registro histórico y confirmar la procedencia de las obras de arte digital del mercado. Para hacer esto, solo debemos ingresar la llave pública de la NFT en Etherscan, un explorador de blockchain de uso gratuito que permite acceder a información como direcciones de wallets, smart contracts y transacciones plasmadas en bloques. De esta manera, podemos navegar por la cadena de bloques y acceder a información de valor para comprobar, por ejemplo, la autenticidad de obras de arte digital o cualquier otro NFT. Una tecnología con diversas aplicaciones Blockchain no se limita al mundo de las criptomonedas y de los NFT, sino que se extiende a metodologías y protocolos que están siendo implementados en distintas industrias, debido a su eficiencia y transparencia. Como infraestructura de base de datos, ofrece grandes ventajas en servicios de validación, almacenamiento y seguridad tanto a entidades gubernamentales como privadas. De igual forma, gracias al Blockchain as a Service (BaaS), empresas de diversos sectores pueden aprovechar los beneficios que otorga este conjunto de tecnologías. Sin duda, la cadena de bloques está reconfigurando el mercado, y entender su funcionamiento y aplicaciones es clave para adaptarse a las nuevas tendencias y, con ello, optimizar diversos procesos.

5 de mayo de 2022

AI & Data

Wallet o monederos digitales: ¿en qué consisten?

En un mercado cada vez más digital, conceptos como criptomonedas, blockchain y economía descentralizada son parte de una nueva manera de entender las transacciones. Para comprar, vender o almacenar diversos activos digitales, necesitas una wallet y, a continuación, te contamos todo sobre esta solución. Las criptomonedas se consolidan en los mercados como los activos predilectos para acceder a servicios digitales y a mercados como el metaverso y los NFTs. Todo, con el blockchain como eje de las operaciones, garantizando la integridad de las transacciones y sentando las bases de una economía descentralizada en la que las wallets son fundamentales. ¿Qué es un monedero digital o digital wallet? Gracias a una wallet, criptomonedas, tokens y NFTs pueden ser administrados por su dueño, por lo que representan un elemento clave en la gestión de activos digitales. Con un monedero digital podemos firmar smart contracts, confirmar o denegar transacciones, hacer movimientos entre servicios de blockchain e, incluso, tomar decisiones de gobernanza en algunos proyectos de finanzas descentralizadas. ¿Cómo funcionan? Los monederos digitales habilitan determinadas operaciones gracias a dos llaves: clave pública y privada. La pública consiste en una dirección única, codificada dependiendo del entorno blockchain en el que opere la red. Esta dirección no puede ser duplicada ni modificada. Para enviarla a terceros, lo que realmente se envía es un certificado de clave pública, que permite identificar el destinatario de una transacción. En la misma línea, la clave privada hace las veces de contraseña y es la que permite validar las transacciones en la cadena de bloques. Al perder esta llave, perderíamos acceso, control y propiedad sobre los activos digitales registrados en la dirección. Tipos de wallets Como hemos señalado, para gestionar un monedero digital necesitamos clave pública y privada. Pero para entender mejor su funcionamiento, y alternativas disponibles a la hora de gestionar activos digitales, es conveniente conocer los tipos de wallet que existen: Para móviles En este tipo de wallet, criptomonedas y otros activos digitales son gestionados desde un smartphone, por lo que se trata de monederos digitales que operan como cualquier otra app. Online Como su nombre lo indica, este tipo de wallet operan en la Web, por lo que no es necesario descargar archivos para gestionar activos como criptomonedas o NFTs, solo se requieren la clave pública y privada. En este caso, la llave privada es resguardada por la plataforma, a la que accedemos por medio de los protocolos de seguridad establecidos por el sitio. De escritorio En este caso, el wallet se descarga en un computador y, como el resto de los monederos digitales, también precisa de un certificado de clave pública para direccionar transacciones, así como de la clave privada para autorizarlas. Uno de sus grandes beneficios es que no está permanentemente conectada a Internet (a diferencia de las anteriores), lo que se traduce en menos riesgos de vulneraciones de seguridad. Wallet en hardware Se trata de dispositivos físicos -como un pendrive- en los que se almacenan la información asociada a sus activos digitales. Ledger es uno de los sistemas más populares en este formato, el cual permite almacenar diversos activos digitales y gestionarlos con total seguridad. ¿Cómo se utilizan? Desde luego, cada wallet tiene características propias. Sin embargo, todas operan de la misma forma: almacenando la clave pública y privada que sustenta las transacciones en blockchain. Las funciones más comunes de un monedero digital de criptomonedas son: firmar, transferir, depositar, aprobar cambios o ajustes en nuestra cuenta. Cada interacción realizada a través de nuestro wallet se registra en la cadena de bloques, certificando la integridad del proceso. Accesibilidad a entornos financieros El uso de blockchain sigue en aumento, y diversas organizaciones en el mundo están desarrollando aplicaciones en la cadena de bloques debido a las ventajas en términos de velocidad, privacidad y seguridad que ofrecen. Por otra parte, esta tecnología sienta las bases para un entorno de finanzas descentralizadas, brindando mayor transparencia y agilidad a las operaciones gracias a soluciones como las wallets. Por eso, son esenciales para operar en el mundo de las criptomonedas y de los activos digitales en general.

4 de mayo de 2022

AI & Data

GOOD TECH TIMES: Reinventando el turismo. Claves para acelerar la recuperación.

FORMATO: Charla de 30 minutos + Q&A de 10 minutos CUÁNDO: 16 de junio, 16:00 h (CET) CÓMO: Inscripción gratuita en eventbrite SOBRE QUÉ: La digitalización es una pieza clave en el plan de modernización y competitividad del sector turístico. Tecnologías como IoT, Big Data, 5G, edge computing, la nube y la ciberseguridad son las grandes protagonistas de la transformación digital de este sector, que permitirán afrontar los retos a los que se enfrenta para reactivar la demanda y restablecer la confianza, a través de un modelo sostenible. Descubre las soluciones tecnológicas para el turismo del futuro y conoce todas las claves para acelerar su recuperación el próximo 16 de junio a las 16:00h CET de la mano de: Natalia Bayona, Director Innovation, Education and Investments - World Tourism Organization UNWTO, Gema Igual, Alcaldesa de Santander, Chris Palomino - Global IT Vice President - Meliá Hotels International y Javier Lorente, Director de Business Development e Ingeniería España - Telefónica Tech. ¡Regístrate ya! Miércoles, 16 de junio, 16:00 h CET. ¿Te lo vas a perder? ¡Inscríbete ya en este enlace! GOOD TECH TIMES Bienvenidos a esta nueva serie de webinars divulgativos en los que hablaremos de temas de interés general sobre IoT, Big Data, Inteligencia Artificial y Blockchain, entre otros. ¿Te lo vas a perder? ¡Regístrate ya!

8 de junio de 2021

AI & Data

LINKEDIN LIVE: Hacia una Agricultura más sostenible e inteligente: Vertical Farming

QUÉ: Directo en la company page de LinkedIn de AI of Things FORMATO: Charla de 30 minutos + Q&A de 10 minutos CUÁNDO: 20 de mayo, 16:00 h (CET) CÓMO: Inscripción gratuita en eventbrite SOBRE QUÉ: La agricultura de precisión nos permitió dar un primer paso hacia la gestión eficiente en la productividad, sostenibilidad y rentabilidad en la producción agrícola. Después de la pandemia, se ha hecho evidente que la independencia alimenticia, la producción sostenible y el cuidado del medio ambiente cobran aún más sentido. La agricultura 4.0 es sinónimo de explotación agrícola eficiente coexistiendo sensorización, conectividad, análisis de datos y trazabilidad, pero también cambiando la forma de cómo cultivamos físicamente. Dentro de Smart Agro en Telefónica Tech, incorporamos soluciones de Vertical Greende cultivos verticales de alta densidad basados en tecnología de aeroponia RHPA permitiendo una nueva dimensión de cultivos “indoor” digitalmente controlados y con acceso remoto. Soluciones altamente eficientes en producción agrícola sin interacción con el medio ambiente. Para entender todos los puntos de vista de los beneficios de la Agricultura 4.0, el próximo 20 de mayo contaremos con: • Paco Sánchez, Gerente de Onubafruit • Hugo Scagnetti, Fundador y CEO Vertical Green • Paz Revuelta, Product Manager en New Business en Telefonica Tech ¿Quieres volver a verlo? https://www.youtube.com/watch?v=qnVZ00wZsGU&list=PLi4tp-TF_qjMFph5Xhd-k4WR_sa_Pq8nA&index=2

18 de mayo de 2021

Conectividad e IoT

Reconocidos como uno de los Líderes por Gartner en ‘Managed IoT Connectivity Services, Worldwide’

Gartner, la firma líder y más influyente en consultoría y research tecnológico a nivel global, ha publicado recientemente una nueva edición de su “Cuadrante Mágico en Servicios de IoT Gestionados a nivel mundial”, donde Telefónica se posiciona, por séptima vez, como una de las compañías líderes en este mercado. Se trata del benchmark más importante sobre IoT a escala global, siendo una de las referencias principales en el mercado utilizada por las empresas a la hora de decidir qué compañías son las mejor posicionadas para prestarles servicios de IoT. Por ello, el aparecer como líderes nos da una excelente visibilidad y puede ayudarnos a ganar nuevos clientes. Asimismo, este informe es muy útil para comprender mejor hacía dónde está yendo el mercado IoT y cuáles son las tendencias clave que se vislumbran. El famoso gráfico del “Magic Quadrant” consta de dos ejes: El eje horizontal o X alude a la visión estratégica y mide el conocimiento que los proveedores analizados tienen acerca de cómo se puede aprovechar, a través del diseño de estrategias, el momento actual del mercado para la generación de valor. El eje vertical o Y, pone foco en las capacidades del proveedor para ejecutar con éxito su propia visión del mercado. Cada año Gartner invita a participar a multitud de potenciales proveedores de servicios IoT y solo aquellos que superan unos criterios de inclusión serán seleccionados para ser evaluados en el cuadrante. A partir de ahí se inicia proceso largo y complejo en el que Gartner examina minuciosamente la visión y la capacidad de ejecución de los diferentes candidatos en base, sobre todo, a un extenso y detallado cuestionario, una presentación, referencias de clientes aportadas y toda la información que le haya llegado directa o indirectamente de cómo ha evolucionado cada proveedor. El resultado de este análisis determina la posición de cada empresa en el cuadrante como “Leader”, “Challenger”, “Visionnaire” o “Niche” En el ámbito de los negocios tecnológicos, ambos, empresas y clientes, somos conscientes de la importancia de aparecer “arriba y a la derecha” como líderes en un cuadrante mágico de Gartner. Pero, ¿qué significa que Telefónica aparezca como uno de los líderes? Pues bien, más allá de suponer que la compañía haya alcanzado una alta puntuación en este ejercicio, los líderes ejecutan con una “visión clara sobre la dirección del mercado y desarrollan competencias para mantener su liderazgo”, según afirma Gartner. Además, son compañías apreciadas como innovadoras, son líderes de opinión, están preparadas para el futuro y, no menos importante, “dan forma al mercado, en lugar de seguirlo”. Pero no solo es Gartner quién reconoce nuestro liderazgo en IoT, ahí están también los reconocimientos de otras casas de analistas muy influyentes en IoT como IDC, GlobalData o Transforma. Estos logros suceden tras un año difícil aunque, bueno, califiquémoslo mejor como “muy retador”, por aquello de que siempre es mejor adornar los desafíos con una buena carga de optimismo. Un año cargado de incertidumbre y marcado por los efectos de una pandemia mundial cuyo impacto en todos los sectores está siendo aun de gran envergadura. Es en este contexto donde Telefónica compite en este cuadrante con un número cada vez mayor de participantes (18 vs 13 en 2014), donde no solo competimos las telcos, sino también otros “players” como operadores virtuales móviles, fabricantes de hardware o compañías puras de IoT. Sucede, además, en plena consolidación de la compañía que ha fusionado los negocios del IoT y Big Data en Telefónica Tech y que, recientemente, con el inspirador nombre de “Artificial Intelligence of Things”, es ya la unidad de negocio que basa su propuesta en la combinación natural de tecnologías basadas en Inteligencia Artificial, IoT, Big Data y Blockchain, con el objetivo de acompañar a los clientes en el viaje de su transformación digital. Muchas veces me preguntan cuál es el toque mágico de la varita para conseguir que una compañía como Telefónica sea valorada positivamente por los analistas de la industria. Mi respuesta es, simplemente, que no lo hay. Y esto lo digo porque este “mundo” no basa su ejercicio en el puro azar o casualidades. Más allá de tener una visión clara y una ejecución extraordinaria, esto va de trabajar en equipo, construyendo relaciones sólidas y de confianza con los analistas en un escenario con recorrido continuo, donde la credibilidad no surge en unos pocos meses ni en un acto transaccional ocasional. Requiere de una dedicación diaria, mucho esfuerzo y compromiso para llegar ahí “arriba a la derecha”. Bajo nuestro punto de vista, el éxito en las relaciones con los analistas dependerá por lo tanto de conocerlos y que nos conozcan bien, de saber qué es lo que hacen y qué es lo que esperan de nuestra compañía, de conocer lo que están diciendo en sus informes. También de escucharlos, entender lo que pretenden explicar, capturar toda esa información de gran valor que nos servirá para progresar y mejorar. De sentarnos junto a ellos en el momento adecuado y dejar que entren en acción los mensajes y el contenido. En Telefónica creemos en ello y contamos con el mejor equipo de expertos, convencidos de la importante labor que resulta el contar las maravillosas cosas que esta casi centenaria compañía está creando para enriquecer y hacer más fácil la vida de millones de personas. Escrito por José Luis Vázquez Marín, Telefónica Industry Analyst Office. Para mantenerte al día con el área de Internet of Things de Telefónica visita nuestra página web o síguenos en Twitter, LinkedIn y YouTube

5 de mayo de 2021

AI & Data

LinkedIn Live - Las dos caras de Blockchain: garantías adicionales y nuevos modelos de negocio

El peso creciente del mundo online en el consumo y las relaciones comerciales hacen cada día más necesario construir relaciones de confianza donde tanto los consumidores tengan absolutas garantías de calidad del producto que consumen, como las empresas puedan confiar ciegamente en los datos y la información que utilizan para tomar decisiones. Blockchain es la tecnología perfecta que permite crear esa confianza. En el directo del próximo 29 de abril, hablaremos con los representantes de dos empresas diferentes (Szentia y Castillo de Canena) que nos ayudarán a entender cómo puedes beneficiarte de esta tecnología en las operaciones y cómo adoptar Blockchain de una manera fácil y rápida con nuestro producto TrustOS, un servicio gestionado que simplifica enormemente la utilización de esta tecnología en tus sistemas de información. ¡Conoce todo sobre la solución Blockchain! Además, te invitamos a asistir al directo que haremos a través de LinkedIn el próximo 29 de abril a las 16:00 h CET, para que conozcas la solución en más detalle, así como varios casos de éxito de la mano de los responsables de producto. Regístrate aquí para poder verlo ¡Te esperamos!

23 de abril de 2021

AI & Data

GOOD TECH TIMES

El Centro Comercial del futuro: un espacio repleto de experiencias. FORMATO: Charla de 30 minutos + Q&A de 10 minutos CUÁNDO: 25 de marzo, 16:00 h (CET) CÓMO: Inscripción gratuita en eventbrite SOBRE QUÉ: El mundo del Retail vive hoy una revolución en la que la sostenibilidad y la tecnología juegan un papel fundamental para la experiencia de los clientes. En concreto, el concepto de los Centros Comerciales está evolucionando hacia una experiencia sensorial y comercial para el visitante. Un concepto que busca ofrecer al comprador diversos elementos que atraigan su atención con el fin último de que disfruten de su estancia en el Centro Comercial. En este sentido, la tecnología IoT y Big Data se convierten en necesarias para poder construir las soluciones de Smart Retail que permiten la creación de estas experiencias. Además, gracias a la tecnología se alcanza un conocimiento mayor del consumo energético de los espacios físicos y permite a los retails ahorrar y cuidar del Medio Ambiente. En este directo contaremos con dos gurús de la industria del Retail: Ian Sandford, Presidente de Eurofund David Pérez Balaguer, CEO del grupo NO-GROUP ...que, junto a Fernando Piquer, CEO de Movistar Riders y nuestra experta Paula Alamán Herbera, Industry Lead en Telefónica Tech – AI of Things, mantendrán una conversación interesante sobre el rumbo que toma la evolución de los Centros Comerciales y qué papel juega la tecnología en la transformación digital para ofrecer la mejor experiencia de cliente. GOOD TECH TIMES Bienvenidos a esta nueva serie de webinars divulgativos en los que hablaremos de temas de interés general sobre IoT, Big Data, Inteligencia Artificial y Blockchain, entre otros. ¿Te lo vas a perder? ¿Quieres volver a ver el webinar? Pincha aquí: https://www.youtube.com/watch?v=g7qavay3ers&list=PLi4tp-TF_qjOIngr_7ilEHR_XueGYuRwN&index=54

18 de marzo de 2021

AI & Data

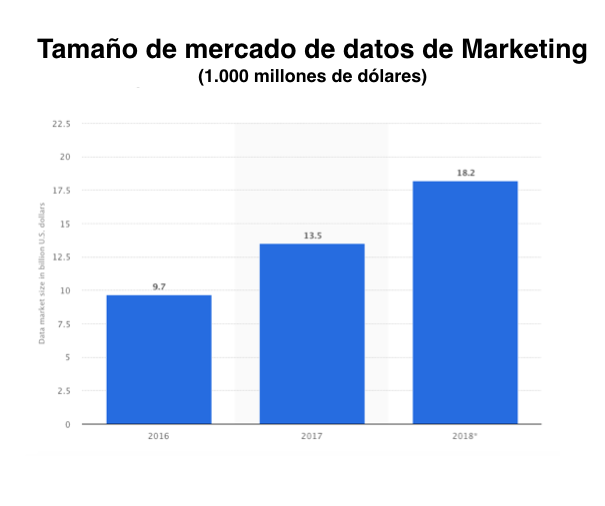

Data Driven Advertising: la solución publicitaria que habla con tus clientes

Ya es un hecho que nos encontramos ante una situación única en la historia debido a la COVID-19, pero no es ni mucho menos el primer hito al que nos hemos tenido que enfrentar. En épocas de crisis se ha demostrado que aquellas marcas y anunciantes que no dejan de invertir son los que mejor parados salen cuando los tiempos son tan inciertos. Cada vez son más los profesionales de marketing que se oponen a una desinversión publicitaria en periodos tan complicados, ya que, de darse el caso, la marca dejará de inmediato de estar presente en la mente del consumidor y tendrá que asumir las consecuencias de lo que este hecho conlleva. Por ejemplo, disminución de la intención de compra, aumento de la presencia de competidores, etc. Es el momento donde debemos estar más presentes que nunca El consumo de información y entretenimiento, además de haber alcanzado récords históricos, está cambiando – el 9’6% de los españoles ha comprado por primera vez de manera online bebidas y comida según el barómetro de Kantar -. Es crucial, debido a este nuevo ecosistema, conocer y dirigirse a una audiencia específica en función de las características y de los mensajes que quieran transmitir la marca y el anunciante. De la misma manera, creemos en la necesidad de realizar inversiones publicitarias con un objetivo y sobre todo que apunten a un segmento que encaje con la audiencia que se demanda. Es necesario comprender a los potenciales clientes, conocer sus hábitos e interpretarlos para comunicarnos con ellos a través de mensajes que encajen con sus rutinas. En Telefónica Tech estamos convencidos del gran valor de nuestros datos en el mercado de la publicidad, por eso ponemos a disposición de nuestros clientes soluciones basadas en analítica Big Data que cuentan con una amplia cantidad de información y una rigurosa recolección. Esto es crucial para cualquier profesional de marketing ya que ayuda a la optimización de sus inversiones publicitarias y de sus presupuestos en campañas. La solución abarca tres procesos que consideramos que conforman la cadena de realización de una buena campaña de publicidad, que son: la planificación, la ejecución y por último la medición. Data Driven Advertising permite a las marcas y anunciantes identificar sus segmentos objetivos e impactar a los perfiles deseados con una publicidad segmentada, proporcionando a posteriori datos agregados de conversiones de campañas a través de una solución completa e integral. Planificación La planificación es, en nuestra opinión, una de las fases más importantes de todo el proceso que supone una campaña de marketing, ya que hay que saber leer muy bien la información de la que disponemos para luego seleccionar correctamente el objetivo de la campaña, el canal de ejecución y el público al que hay que dirigir la publicidad que la marca y anunciante desea comunicar. Además, para este proceso, podemos calcular la visibilidad de los establecimientos para los principales términos de búsqueda, identificado los puntos de venta que tienen una visibilidad positiva, para de esta manera optimizar los presupuestos. En Telefónica guiamos y acompañamos a las marcas y anunciantes durante todo este proceso, mediante el análisis de toda la información disponible, agregada y anonimizada de nuestros clientes y de su movilidad, siendo capaces de identificar el target a impactar y dirigirlo hacia el objetivo de la campaña. Ejecución Una vez que tenemos claro a quién vamos a impactar pasamos a estudiar el cómo, y para ello ponemos a disposición de nuestros clientes la posibilidad de impactar a su público objetivo desde diferentes canales de ejecución como son: las redes sociales, el entorno de display programático o en las búsquedas. Asimismo, basándonos en la movilidad de los individuos ofrecemos diferentes tipos de campaña como pueden ser las campañas “drive to store” cuyo objetivo es llevar público de calidad a la tienda o campañas que llamamos “geolocated” que buscan impactar a perfiles que se mueven en una determinada ubicación. Medición Por último, la solución Data Driven Adverting ofrece una medición muy completa que permite a las marcas y anunciantes saber en todo momento los cambios de comportamiento de sus usuarios en cuanto a su movilidad y la eficiencia de las campañas publicitarias. Esta solución pone en valor uno de los activos más importantes para Telefónica y para el mundo de la publicidad, a través de unos datos determinísticos y verificados que pueden ayudar al entendimiento del comportamiento del consumidor para que este luego pueda ser impactado publicitariamente. Escrito por Sandra Alonso, Product Lead

9 de marzo de 2021

AI & Data

Planificando la ubicación de un site de retail con los datos

Una de las decisiones de negocio clave para cualquier marca es decidir dónde “establecer su tienda”. Esto implica la necesidad de conocer muy bien a los consumidores y su target, y aún más cuando una marca quiere dar el salto de un modelo de negocio totalmente online a tener un establecimiento físico. En este post, analizamos el caso de éxito de la marca de cosméticos Natura, y cómo gracias a la tecnología LUCA Store la empresa ha aumentado su presencia en Brasil. Natura Cosméticos S.A o simplemente Natura fabrica y comercializa una gran variedad de productos cosméticos para el mercado enfocado en el cuidado de la piel, belleza, perfume y cuidados capilares. La compañía da especial importancia a la innovación y sostenibilidad. En total la empresa tiene más de 3200 establecimientos a nivel internacional, además de comercializar sus productos a través de representantes. Natura es según ingresos, actualmente, la mayor compañía de cosméticos en Brasil y en julio de este año compró la marca The Body Shop de la empresa L’Oréal. En sus comienzos, Natura operaba a través de un modelo de ventas directo con sus consumidores, basado en sus representantes. Hasta que, satisfactoriamente, tomaron la decisión de abrir un establecimiento retail y quisieron identificar los lugares con mayor potencial de ventas. Este potencial de ventas se mide dependiendo del número de usuarios que pasan ese lugar y el grupo demográfico al que pertenecen. El proyecto con LUCA implica la combinacíon de VIVO Big Data, los indicadores de clientes internos de Natura y el conocimiento sobre el sector, además de la tecnología LUCA Store. La solución LUCA Store analiza millones de puntos de datos móviles con el fin de proporcionar información muy valiosa para los retailers que aportan información sobre quién, qué, cuándo, por qué y cómo actúa un cliente. El resultado de esta combinación de datos y tecnologías junto con los KPI’s de Natura es la habilidad de sugerir con mayor precisión el lugar más adecuado para abrir un establecimiento. Estas sugerencias, además, también tendrán en cuenta, incluso, qué días y a qué horas debería abrir un establecimiento al público. En el vídeo a continuación se puede ver aquí la demo de la tecnología LUCA Store: https://www.youtube.com/watch?v=pgBn4W62fzQ&feature=youtu.be La información proporcionada por LUCA Store proporcionó a LUCA información valiosa sobre más de 40 millones de personas de cinco países brasileñas. Descubre los casos de éxito destacados en todos los sectores en nuestra web

17 de febrero de 2021

AI & Data

RFID: La solución para digitalizar tu tienda

La transformación digital es un concepto que lleva muchos años en boca de mucha gente y se ha ido desarrollando en diferentes líneas de acción; ahora, en tiempos de pandemia, ha cobrado incluso más relevancia como catalizador del cambio para la evolución de las empresas. La digitalización afecta en dos vertientes, la primera es lo que vamos a llamar el “backoffice” de la empresa incluyendo los procesos internos y de gestión de forma que puedan encontrarse eficiencias, mejoras operativas, etc. La segunda vertiente de la digitalización afecta a lo que vamos a llamar el “frontoffice” de la empresa, modificando la experiencia final de sus clientes. Hoy vamos a hablar de un producto que afecta tanto al “backoffice” como al “frontoffice” de las empresas, centrándonos en las empresas del mundo del retail. Este producto es RFID for Retail. El RFID (identificación por radio frecuencia) es una tecnología que lleva tiempo acompañándonos y en los últimos años se han producido eficiencias en el precio de implementación de la tecnología consiguiendo llegar a un mayor número de empresas. ¿En qué consiste esta solución? Por si alguien no conoce la tecnología vamos a explicar de forma muy breve y sencilla en qué consiste. Por una parte, tenemos una etiqueta RFID en la que grabamos información. La etiqueta puede estar construida con diferentes materiales o formatos para, por ejemplo, hacerla resistente al agua, a bajas temperaturas, etc. El sistema cuenta con antenas para poder leer las etiquetas, las cuales se colocan estratégicamente en función del caso de uso que se quiera resolver. Y por último contamos con un SW de gestión para dar de alta o baja etiquetas, modificarlas o visualizar las lecturas. En el mundo del retail, afecta directamente a la parte de “backoffice” de las tiendas y a todo lo relativo de la cadena de suministro, stock de productos, espacio de almacenamiento o tiempos de reposición. Desde hace años los retailers más potentes han ido trabajando para evolucionar sus sistemas logísticos, fabricando y distribuyendo prácticamente bajo demanda, reduciendo o eliminando los almacenes centrales o regionales y minimizando el espacio necesario en tienda para almacenar producto; gestionando al cabo del día decenas de miles de prendas y complementos. Esta forma de trabajar es la base ideal para la implementación de un sistema de RFID, de tal manera que los productos se etiquetarían en origen en la factoría con la etiqueta RFID y se darían de alta en el sistema. En función de las necesidades se controlaría la mercancía de forma unitaria desde la salida del almacén, la carga en el medio de transporte, posibles puntos intermedios hasta su llegada al almacén final de la tienda. Control total sobre la cadena de suministro En cada punto donde se instalen las antenas lectoras se podrán obtener las mediciones en tiempo real de todos los productos que pasen por allí. Esto nos va a ofrecer un control total sobre la cadena de suministro, pudiendo reconocer puntos que no son eficientes o posibles mermas de stock antes de su llegada al almacén. Una cantidad ingente de datos que el retailer podrá usar para hacer más eficiente su cadena de suministro y procesos de carga y descarga, controlando en todo momento la integridad del producto enviado. Una vez llega a la tienda, con antenas instaladas tanto en el almacén como en la propia tienda se va a tener el control del stock de la tienda en tiempo real de todas las prendas, sabiendo qué prenda es, talla, color, etc. De esta forma, se podrán diseñar estrategias de reposición de producto basadas en datos en tiempo real. Como punto extra, cada etiqueta RFID también sirve de trigger para la alarma del establecimiento, por ejemplo, si se intenta sacar del establecimiento sin haber sido pagado. Esta función de alarma también nos va a ayudar a tener controlados los probadores, pudiendo tener antenas configuradas y definiendo una operativa que permita conocer en cada momento qué prendas están en cada probador, si alguna queda abandonada o si el cliente devuelve menos. El potencial transformador del RFID en el core de una empresa de retail es enorme Hasta ahora nos hemos centrado en hablar de la transformación sobre el “backoffice” de la empresa, pero habíamos indicado que el producto RFID for Retail tiene la capacidad de transformar también el “frontoffice”. En este caso, desde la unidad de IoT&Big Data de Telefónica Tech, hemos implementado varios casos de uso que van a generar una experiencia de cliente mejor. Contenidos audiovisuales Gracias a las soluciones de Digital Signage y Spotsign podemos tener una playlist de contenidos audiovisuales. Además, si integramos el sistema de RFID y un lector situado junto a una pantalla, el cliente puede acercar un producto y conocer contenidos informativos sobre este. Mejorar la experiencia en los probadores Los probadores también son un punto interesante para ofrecer experiencias diferentes. Las prendas están etiquetadas para que, una vez las metes en probador, una pantalla las identifique. De tal forma que el cliente tiene la posibilidad de pedir otro color, otra talla…incluso si no hay stock en ese momento, el cliente lo podrá comprar a través de la app o web y recibirlo en su casa. Cajas de autopago Para cerrar el journey dentro de la tienda, el sistema RFID permite implementar cajas de autopago sin contacto donde el cliente no tiene necesidad de sacar las prendas individualmente para su lectura, solo tiene que colocar las prendas en una zona designada y se leerán todas indicando en la pantalla las prendas que son y pudiendo pagar por diferentes medios digitales. Una vez el pago se ha realizado con éxito el sistema desalarma los productos para que el cliente pueda salir del comercio. Como hemos ido desgranando en el post, el potencial transformador del RFID es enorme, permitiendo a los retailers dar un salto en la evolución de su funcionamiento interno y además ofreciendo mejores experiencias y más seguras a sus clientes. Escrito por: Mariano Banzo – Product Manager Retail, Telefónica Tech

15 de febrero de 2021

AI & Data

Una solución para adaptar la flota de vehículos frente a la COVID-19 y la tormenta Filomena

La movilidad es un aspecto clave tanto en el día a día de las ciudades como en las situaciones excepcionales que hemos experimentado en el último año por la COVID-19 o el reciente temporal “Filomena”. En ambos escenarios hemos comprobado que saber adaptarse y anticiparse nos pueden evitar muchos problemas y que la tecnología cumple una función esencial para mejorar la prestación de servicios esenciales en las ciudades. Entonces, ¿Cómo nos adaptamos y anticipamos? Desde mi punto de vista, la respuesta es clara: transformación digital de la mano de tecnologías como IoT y Big Data. Y esto precisamente es en lo que Ferrovial Servicios llevamos trabajando desde hace años. Estas tecnologías nos permitieron ofrecer servicios eficientes durante el confinamiento general en marzo de 2020. Durante este periodo, gracias a la digitalización de nuestros procesos, nuestra actividad no paró y pudimos prestar servicios esenciales en más de 600 municipios a más de 25 millones de ciudadanos en España. También ha ocurrido algo parecido con el temporal Filomena. Gracias a la solución tecnológica 'Fleet Optimise' de gestión inteligente de flota de vehículos hemos podido continuar, a pesar de todas las adversidades, prestando servicios críticos como son la recogida de residuos y limpieza viaria. Esta tecnología nos ha permitido organizar en ciertos contratos rutas dinámicas de recogida de residuos en función de los acuerdos con los clientes y saber en qué calles teníamos que ir a recoger los residuos. La plataforma IoT de Telefónica y las capacidades de big data nos han ofrecido flexibilidad y rapidez para adaptarnos a cada situación. Y todo esto ¿Cómo lo conseguimos? Contamos con una flota de más de 4.000 vehículos sensorizados de los cuales se recoge información en tiempo real. A través de un dispositivo que se conecta a la electrónica del vehículo, conseguimos extraer este tipo de información: conocer en tiempo real dónde está cada camión, lo que está haciendo, a qué velocidad va o dónde para. Toda esta información se procesa para poder predecir qué va a pasar. De tal forma que conseguimos ofrecer a los ayuntamientos y administraciones públicas la información que nos demandan en cada momento y dar una solución en tiempo real a nuestros clientes. En definitiva, las tecnologías IoT & Big Data permiten capturar en tiempo real toda la información, procesarla y a partir de ahí tomar las mejores decisiones. ¿En qué ha beneficiado a nuestro negocio? Gracias a 'Fleet Optimise' hemos conseguido ofrecer un servicio de mayor calidad a los ciudadanos. También nos ha impactado en la eficiencia y sostenibilidad, puesto que ahora utilizamos los recursos adecuadamente de tal manera que hacemos más eficiente el proceso y reducimos desplazamientos lo que impacta en el medioambiente por la reducción de la huella de carbono. Además, podemos guiar al conductor al punto de recogida para reducir distancias a la hora de recolectar los residuos, de tal forma que impacta en el ahorro de tiempo y combustible. El poder agregar y comparar nos proporciona información clave para los planes de mejora continua de la compañía. Todo esto se traduce en una gran ayuda al conductor que al fin y al cabo es el eje del que pilota toda la flota. Y, por último, en el aumento de la seguridad en todas nuestras operaciones. Por ejemplo, en caso de accidente proporciona información para analizar mejor lo que ha ocurrido. En definitiva, conseguimos información para mejorar nuestros patrones de comportamiento. Nadie cuestiona hoy en día que las plataformas de IoT y Big Data formen parte de nuestro catálogo de servicios, igual que nadie se cuestiona que tengamos un PC o un teléfono móvil. Nuestros clientes dan por hecho que lo tenemos. Las plataformas digitales son esenciales para prestar los servicios. Escrito por Paco Gimeno, Director de Transformación Digital y Sistemas de Ferrovial Servicios.

20 de enero de 2021

AI & Data

Optimización de flotas en la era post-Covid

La llegada de la COVID-19 ha alterado el mundo tal y como lo conocíamos y está obligando a muchas empresas a evolucionar digitalmente para adaptarse a las nuevas necesidades del mercado, dónde la movilidad de sus clientes y empleados se ha visto reducida drásticamente. Esto no está haciendo más que afianzar algunas tendencias que veníamos observando en los últimos años, como puede ser la compra online con envío a domicilio o el teletrabajo, a la vez que pone de manifiesto nuevas necesidades como es el disponer de datos para adaptarnos rápidamente a acontecimientos inesperados. En esta línea, observamos que uno de los entornos dónde mayor impacto puede tener el disponer de estos datos es en la movilidad, ya que existe una necesidad creciente de controlar y gestionar de forma más eficiente los activos, las personas y por supuesto los vehículos. Un ejemplo que tenemos todos muy reciente en nuestras cabezas es la distribución de las vacunas contra la COVID-19, que requiere de un control absoluto por el alto valor de los bienes y sus difíciles condiciones de conservación. Garantizar que estas vacunas llegan a tiempo a sus destinos manteniendo en todo momento la cadena de frío es crítico para la recuperación de la sociedad actual y por ello, se hace imprescindible el uso de soluciones que nos ayuden en esta tarea. En Telefónica llevamos años ayudando a nuestros clientes con un amplio porfolio de soluciones para la gestión de sus diferentes activos móviles, y es hoy más que nunca cuando toman especial relevancia soluciones como Fleet Optimise que permite, mediante tecnologías como IOT, Big Data y la Inteligencia Artificial, gestionar su flota de vehículos de forma eficiente y ayudarles en la toma de decisiones estratégicas de negocio. Gracias a la instalación de dispositivos IoT en los vehículos podemos recoger una gran cantidad de información en tiempo real, como su posición GPS, odómetro, consumo de combustible, hábitos de conducción o averías; y volcar toda esa información en nuestras plataformas para poder digerirla y sacarle el máximo partido. Tras muchos años de experiencia, entendemos el negocio de nuestros clientes diferenciándolo en 2 planos independientes: el plano operativo y el plano estratégico: En el plano operativo les entregamos a nuestros clientes las herramientas para poder gestionar la operativa diaria de su flota: conocer dónde se encuentran sus vehículos en tiempo real, sus alertas, que trayectos han realizado o cuándo tienen que pasar una revisión. En el plano estratégico adicionalmente les damos las herramientas para entender realmente cómo funciona su flota de vehículos y tomar las decisiones adecuadas. Para ello nos apoyamos en tecnologías como el Big Data y la Inteligencia Artificial que nos permiten procesar infinidad de datos, disponer de una visión agregada de todos los vehículos e incluso desarrollar modelos predictivos, lo que supone un salto cualitativo para nuestros clientes. Volviendo al ejemplo del traslado de las vacunas, la parte operativa nos permite saber dónde se encuentra el vehículo y si existe algún problema durante el traslado como pudiera ser una avería en el camión. La parte estratégica nos permite analizar todos los trayectos de forma conjunta, entender qué incidencias son las más frecuentes, dónde ocurren y en última instancia, cómo evitarlas. Gracias a Fleet Optimise, nuestros clientes están consiguiendo: Aumentar la productividad de su flota haciendo un uso más eficiente de los vehículos Reducir los costes operativos derivados del alto gasto en combustible, mantenimientos y reparaciones Asegurar el correcto uso de sus vehículos reduciendo la siniestralidad, fraude e infracciones de sus conductores Garantizar la seguridad de sus empleados, vehículos y mercancía Además, estamos poniendo foco en 3 nuevas funcionalidades que nos van a ayudar a adaptarnos a la nueva realidad que nos estamos encontrando con la pandemia: Descarga remota de tacógrafo: Permite disponer de la información en tiempo real y así poder maximizar el uso de los vehículos pesados Apertura remota de puertas: Evita el uso de llaves, minimizando así la interacción humana y maximizando el uso de los vehículos Transición a vehículo eléctrico: Ayuda a definir la mejor estrategia para evolucionar la flota actual hacia vehículos eléctricos más eficientes y ecológicos Si bien podemos pensar en empresas de distribución y logística como los principales clientes de esta solución, la realidad nos demuestra que cualquier empresa con flota de vehículos, independientemente de su sector de actividad y del tipo de vehículo, puede beneficiarse de Fleet Optimise ya que es una solución extremo a extremo que está disponible a escala global, dónde ofrecemos todos los elementos de forma integrada (dispositivo, comunicaciones, instalación, plataforma, mantenimiento, atención al cliente y servicios de valor añadido) para que el cliente pueda centrarse exclusivamente en el core de su negocio que es la gestión de sus activos. Las circunstancias de este nuevo entorno cambiante que nos ha tocado vivir, nos exige ser capaces de adaptarnos y tomar decisiones de forma rápida para poder avanzar en un marco empresarial cada vez más exigente, y para ello, la transformación digital de la mano de la tecnología IOT y Big Data está demostrando ser clave para el éxito de nuestros clientes. Escrito por Fernando García Gómez, IoT Smart Mobility - Telefónica

11 de enero de 2021

AI & Data

Cómo transformar una compañía(XII): la transformación del talento interno